Этот репозиторий реализует тренинги по машинному обучению и лодку вывода, используя генеративный ИИ (Genai) для ответа на вопросы на основе предоставленных изображений. Предварительно обученные модели существуют для выполнения таких задач, однако они не могут адаптироваться к сценариям, специфичными для домена-поэтому нам нужно точно настроить и б) не отображать способность быть развернутыми в производственных средах.

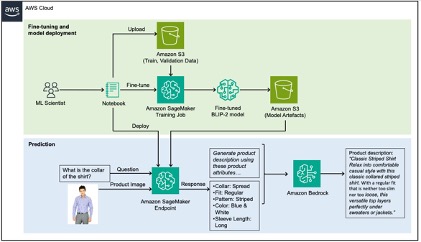

Чтобы решить эту проблему, этот пост показывает, как извлекать атрибуты продукта, специфичные для домена из изображений продукта, с помощью тонкой настройки VLM (модель зрения на зрение) в набор данных моды с использованием Amazon SageMaker, а затем используйте коренную породу Amazon для создания описаний продуктов, используя извлеченные атрибуты в качестве входных данных.

Для получения подробного прохождения этого хранилища, пожалуйста, обратитесь к нашему блоге.

Данные, используемые в этом репозитории, взяты из набора данных Fashion Fashion Kaggle, а использование, которое мы пытаемся решить, создает подписи для этих модных продуктов для веб-сайта электронной коммерции, задачи, которая исторически занимала очень много времени. Высококачественные описания продукции улучшают поисковую оптимизацию (SEO), а также повышают удовлетворенность клиентов, позволяя им принимать обоснованные решения.

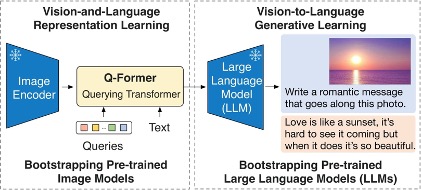

Модель, созданная в этом репозитории, представляет собой модель BLIP-2 и, более конкретно, ее вариант с использованием FLAN-T5-XL.

Следующая диаграмма иллюстрирует обзор BLIP-2:

Раствор можно разбить на две части, отмеченные зеленым и синим в ахитектуре ниже: а) тонкая настройка зеленого и б) вывод в синий цвет.

Смотрите Anploying для получения дополнительной информации.

Эта библиотека лицензирована по лицензии MIT-0. Смотрите файл лицензии.