Esse repositório implementa um regimento de treinamento e inferência de aprendizado de máquina, usando a IA generativa (GENAI) para responder a perguntas com base nas imagens fornecidas. Existem modelos pré-treinados para alcançar essas tarefas, no entanto, são a) incapazes de se adaptar aos cenários específicos de domínio-por isso precisamos ajustar eb) não exibir a capacidade de ser implantada em ambientes de produção.

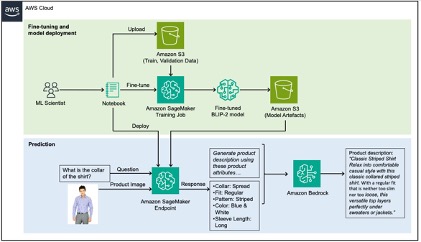

Para resolver esse problema, este post mostra como extrair atributos de produtos específicos de domínio das imagens do produto, ajustando um VLM (modelo de linguagem de visão) em um conjunto de dados de moda usando o Amazon Sagemaker e, em seguida, use a Amazon Bedrock para gerar descrições de produtos usando os atributos extraídos como entrada.

Para um passo a passo detalhado deste repositório, consulte o nosso blog Post.

Os dados usados neste repositório são retirados do conjunto de dados de imagens de moda Kaggle e a USECASE que tentamos resolver está gerando legendas para esses produtos de moda para um site de comércio eletrônico, uma tarefa que historicamente consome muito tempo. As descrições de produtos de alta qualidade melhoram a pesquisa por meio da otimização de mecanismos de pesquisa (SEO), além de aumentar a satisfação do cliente, permitindo que eles tomem decisões informadas.

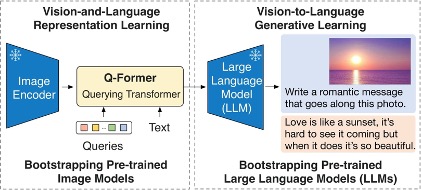

O modelo FinetUned neste repositório é o modelo BLIP-2 e, mais especificamente, uma variante dele usando o FLAN-T5-XL.

O diagrama a seguir ilustra a visão geral do BLIP-2:

A solução pode ser dividida em duas seções, marcada verde e azul na acidente abaixo: a) Ajuste fino em verde e b) inferência em azul.

Consulte contribuindo para mais informações.

Esta biblioteca está licenciada sob a licença MIT-0. Veja o arquivo de licença.