Dieses Repository implementiert ein Trainings- und Inferenzregiment für maschinelles Lernen, wobei generative KI (Genai) beantwortet werden, um Fragen basierend auf bereitgestellten Bildern zu beantworten. Vorausgebildete Modelle existieren, um solche Aufgaben zu erreichen. Sie sind jedoch a) nicht in der Lage, sich an domänenspezifische Szenarien anzupassen.

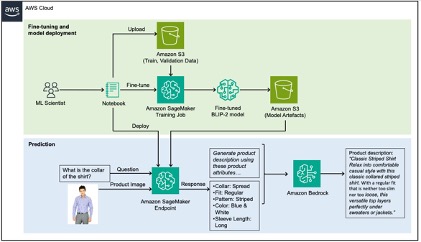

Um dieses Problem zu lösen, zeigt dieser Beitrag, wie domänenspezifische Produktattribute aus Produktbildern extrahiert werden können, indem ein VLM (Vision-Sprage-Modell) auf einem Modemodus mit Amazon-Sagemaker abtielt, und dann mithilfe von Amazon-Grundgesteln Produktbeschreibungen unter Verwendung der extrahierten Attribute als Eingabe generieren.

Eine detaillierte Vorgehensweise dieses Repositorys finden Sie in unserem Blogpost.

Die in diesem Repository verwendeten Daten stammen aus dem Datensatz von Kaggle Fashion Images und die von uns zu lösen von Usecase, die von uns zu lösen versuchen, sind Bildunterschriften für diese Modeserzeugnisse für eine E-Commerce-Website zu generieren, eine Aufgabe, die in der Vergangenheit sehr zeitaufwändig war. Hochwertige Produktbeschreibungen verbessern die Suchbarkeit durch Suchmaschinenoptimierung (SEO) und erhöhen die Kundenzufriedenheit, indem sie es ihnen ermöglichen, fundierte Entscheidungen zu treffen.

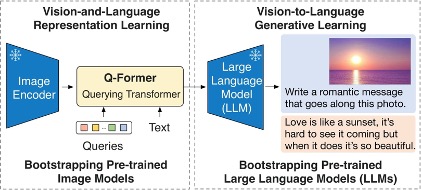

Das in diesem Repository beendete Modell ist das BLIP-2-Modell und insbesondere eine Variante davon unter Verwendung von Flan-T5-XL.

Das folgende Diagramm zeigt den Überblick über Blip-2:

Die Lösung kann in zwei Abschnitte unterteilt werden, die in der folgenden Achitecture grün und blau markiert werden: a) Feinabstimmung in grün und b) Inferenz in Blau.

Weitere Informationen finden Sie unter Beitrag.

Diese Bibliothek ist im Rahmen der MIT-0-Lizenz lizenziert. Siehe die Lizenzdatei.