このリポジトリは、生成AI(genai)を使用して、提供された画像に基づいて質問に答えるために、機械学習トレーニングと推論連隊を実装します。事前に訓練されたモデルはそのようなタスクを発生させるために存在しますが、a)ドメイン固有のシナリオに適応することはできません。したがって、なぜ微調整する必要があり、b)生産環境に展開する機能を表示しないのです。

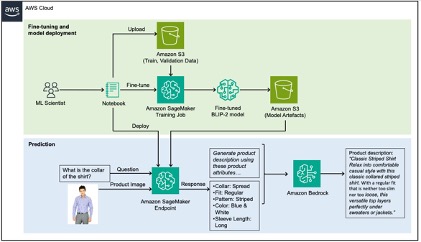

この問題を解決するために、この投稿は、Amazon Sagemakerを使用してファッションデータセットにVLM(Vision-Language Model)を微調整して、製品画像からドメイン固有の製品属性を抽出する方法を示し、Amazon Bedrockを使用して入力として抽出された属性を使用して製品の説明を生成します。

このリポジトリの詳細なウォークスルーについては、ブログ投稿を参照してください。

このリポジトリで使用されるデータは、Kaggle Fashion Images Datasetから取得されており、解決しようとするUSECASEは、eコマースWebサイトのこれらのファッション製品のキャプションを生成しています。高品質の製品の説明は、検索エンジン最適化(SEO)を通じて検索性を向上させ、情報に基づいた意思決定を可能にすることで顧客満足度を向上させます。

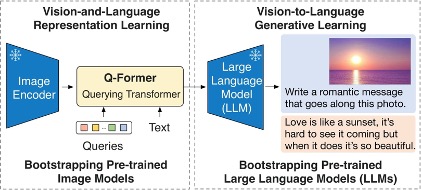

このリポジトリで微調整されたモデルは、BLIP-2モデルであり、より具体的には、Flan-T5-XLを使用したバリアントです。

次の図は、BLIP-2の概要を示しています。

解は、以下の痛みでは緑と青とマークされた2つのセクションに分解できます。a)緑色の微調整、b)青の推論。

詳細については、貢献を参照してください。

このライブラリは、MIT-0ライセンスに基づいてライセンスされています。ライセンスファイルを参照してください。