ينفذ هذا المستودع من فوج التدريب على التعلم الآلي وفوج الاستدلال ، باستخدام AI (GENAI) للإجابة على الأسئلة بناءً على الصور المقدمة. توجد نماذج مدربة مسبقًا لتحقيق مثل هذه المهام ، ومع ذلك فهي غير قادرة على التكيف مع السيناريوهات الخاصة بالمجال-وبالتالي السبب في أننا نحتاج إلى ضبط و B) لا تعرض القدرة على نشرها في بيئات الإنتاج.

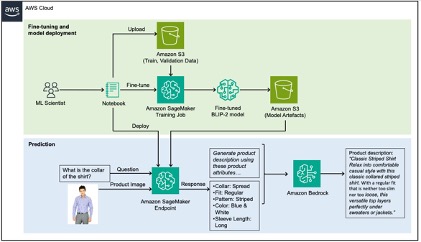

لحل هذه المشكلة ، يوضح هذا المنشور كيفية استخراج سمات المنتج الخاصة بالمجال من صور المنتج عن طريق صياغة VLM (نموذج لغة الرؤية) على مجموعة بيانات أزياء باستخدام Amazon Sagemaker ، ثم استخدم Amazon Bedrock لإنشاء أوصاف المنتج باستخدام السمات المستخرجة كمدخلات.

للحصول على تجول مفصل في هذا المستودع ، يرجى الرجوع إلى BlogPost.

البيانات المستخدمة في هذا المستودع مأخوذة من مجموعة بيانات Kaggle Fashion Images ، كما أن USECASE التي نحاول حلها هي توليد التسميات التوضيحية لمنتجات الأزياء هذه لموقع التجارة الإلكترونية ، وهي مهمة تستغرق وقتًا طويلاً للغاية. تعمل أوصاف المنتج عالية الجودة على تحسين قابلية البحث من خلال تحسين محرك البحث (SEO) ، بالإضافة إلى زيادة رضا العملاء من خلال السماح لهم باتخاذ قرارات مستنيرة.

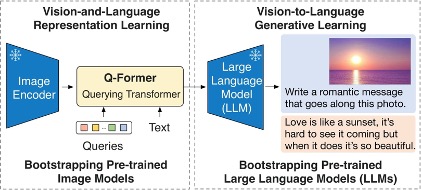

النموذج الذي تم تحريكه في هذا المستودع هو نموذج BLIP-2 وبشكل أكثر تحديداً ، وهو متغير منه باستخدام Flan-T5-XL.

يوضح الرسم البياني التالي نظرة عامة على BLIP-2:

يمكن تقسيم الحل إلى قسمين ، باللون الأخضر والأزرق في البنية أدناه: أ) ضبط الأخضر و B) الاستدلال باللون الأزرق.

انظر المساهمة لمزيد من المعلومات.

هذه المكتبة مرخصة بموجب ترخيص MIT-0. انظر ملف الترخيص.