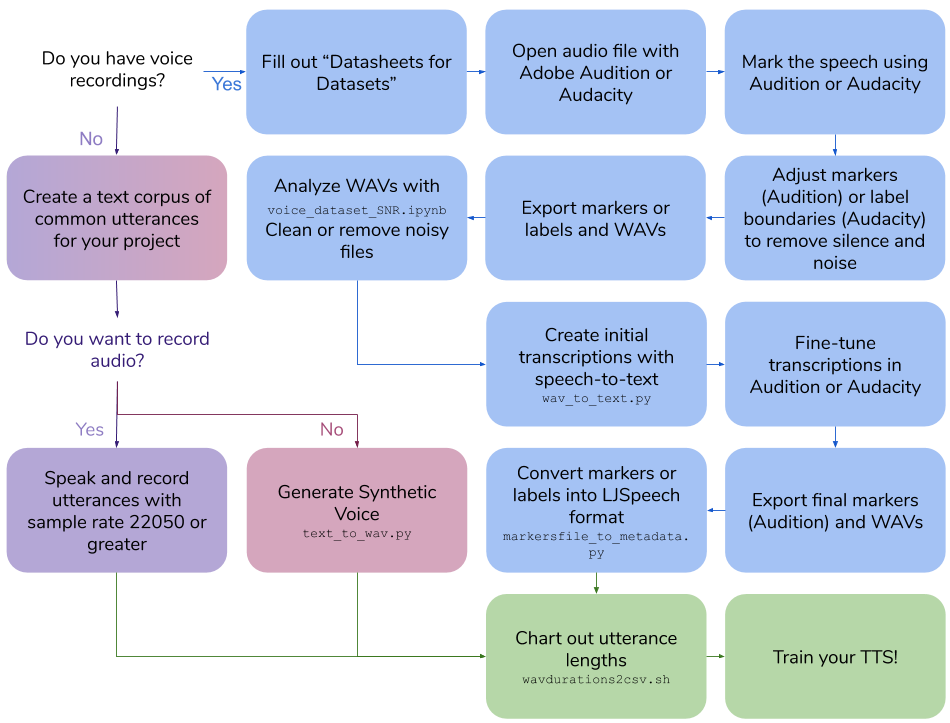

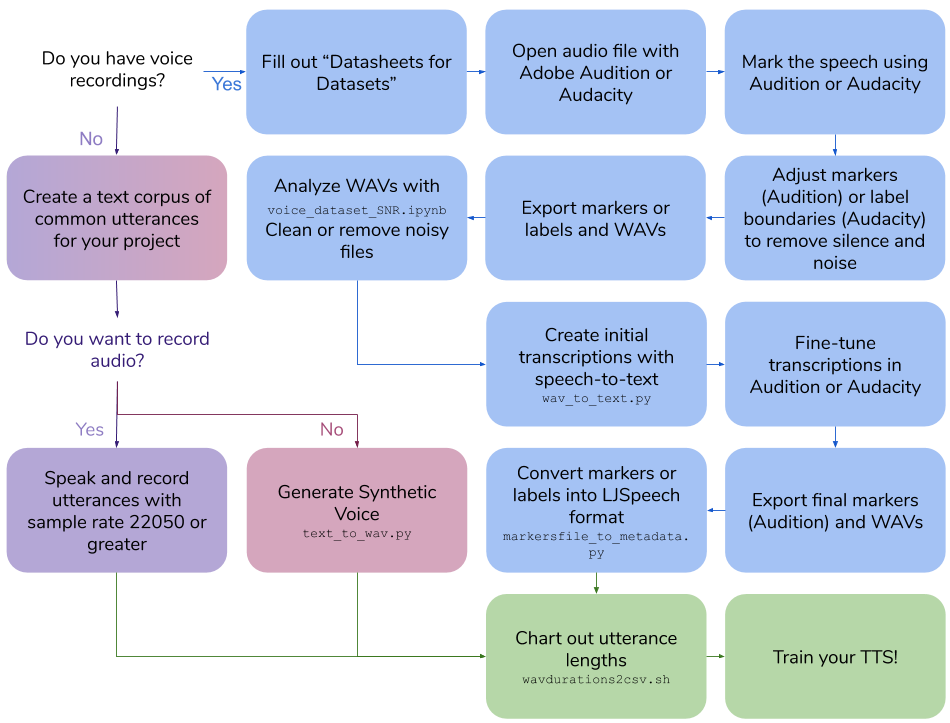

Criação do conjunto de dados de voz

Esse repositório descreve as etapas e scripts necessários para criar seu próprio conjunto de dados de texto para fala para treinar um modelo de voz. A saída final está no formato LJSpeech.

Índice

- Crie suas próprias gravações de voz

- Crie um conjunto de dados de voz sintético

- Crie transcrições para gravações de voz existentes

- Outros utilitários

Crie suas próprias gravações de voz

Crie suas próprias gravações de voz

Requisitos

- Software de gravação de voz

- Microfone montado na cabeça omni-direcional

- Cartão de áudio de boa qualidade

Crie um corpus de texto de frases

- Crie frases que serão cerca de 3 a 10 segundos quando faladas

- Use o formato LJSpeech

- "|" Valores separados, ID do arquivo WAV e depois do texto da frase

-

100|this is an example sentence

Fale e gravar frases

- Fale cada frase como escrito

- A taxa de amostra deve ser 22050 ou mais

Comprimentos de frase

Execute scripts/wavdurations2csv.sh para traçar o comprimento da frase e verificar se você tem uma boa distribuição de comprimentos de arquivo WAV.

Crie um conjunto de dados de voz sintético

Crie um conjunto de dados de voz sintético

Requisitos

- Google Cloud Platform Compute Engine Instância

-

Cloud API access scopes Selecione Allow full access to all Cloud APIs

- CONDA

Instalação

Crie o ambiente do CONDA na instância do GCP

conda create -n tts python=3.7

conda activate tts

pip install google-cloud-texttospeech==2.1.0 tqdm pandas

Crie um corpus de texto de frases

- Crie frases que serão cerca de 3 a 10 segundos quando faladas

- Use o formato LJSpeech

- "|" Valores separados, ID do arquivo WAV e depois do texto da frase

-

100|this is an example sentence

Gerar conjunto de dados de voz sintética

-

python text_to_wav.py tts_generate

Comprimentos de frase

Execute scripts/wavdurations2csv.sh para traçar o comprimento da frase e verificar se você tem uma boa distribuição de comprimentos de arquivo WAV.

Crie transcrições para gravações de voz existentes

Crie transcrições para gravações de voz existentes

Requisitos

- Audição ou audácia da Adobe

- Google Cloud Platform Compute Engine Instância

-

Cloud API access scopes Selecione Allow full access to all Cloud APIs

- CONDA

Instalação

Crie o ambiente do CONDA na instância do GCP

conda create -n stt python=3.7

conda activate stt

pip install google-cloud-speech tqdm pandas

Preencha uma folha de dados para o conjunto de dados de voz

- Revise as folhas de dados para conjuntos de dados de Gebru et al.: Https://arxiv.org/pdf/1803.09010.pdf

- Markdown Datheet: https://github.com/jrmeyer/markdown-datheet-for-datasets/blob/master/dataheet.md

Marque o discurso

Na Adobe Audition , Abra o arquivo de áudio:

- Selecione

Diagnostics -> Mark Audio - Selecione a

Mark the Speech - Clique em

Scan - Clique em

Find Levels - Clique em

Scan novamente - Clique em

Mark All - Ajuste o db de sinal de áudio e silêncio e o comprimento até os clipes estarem entre 3-10 segundos

Ou, em Audacity , abra o arquivo de áudio:

- Selecione

Analyze -> Sound Finder - Ajuste o db de sinal de áudio e silêncio e o comprimento até os clipes estarem entre 3-10 segundos

Ajustar os marcadores ou os limites de etiqueta

Na audição :

- Guia

Markers abertos - Ajuste os marcadores, removendo o silêncio e o ruído para ganhar o comprimento do clipe entre 3 a 10 segundos

Na audição :

- Ajuste os limites da etiqueta, removendo o silêncio e o ruído para ganhar o comprimento do clipe entre 3 a 10 segundos de duração

Marcadores de exportação/etiquetas e ondas

Na audição :

- Selecione todos os marcadores na lista

- Selecione

Export Selected Markers to CSV e salvar como marcadores.csv - Selecione

Preferences -> Media & Disk Cache e Descondecer Save Peak Files - Selecione

Export Audio of Selected Range Markers com as seguintes opções:- Verifique

Use marker names in filenames - Atualizar formato para

WAV PCM - Atualização do tipo de amostra

22050 Hz Mono, 16-bit - Use a pasta

wavs_export

Ou, em audácia :

- Selecione

Export multiple...- Formato: WAV

- Opções: PCM assinado de 16 bits

- Arquivos divididos com base em rótulos

- Nome Arquivos usando o nome da etiqueta/faixa

- Use a pasta

wavs_export

- Selecione

Export labels para Label Track.txt

Analise o WAVs com a proporção de sinal / ruído colab

- Execute colabs/voz_dataset_snr.ipynb

- Limpe ou remova arquivos barulhentos

Crie transcrições iniciais com STT

Para audição , usando os Markers.csv exportados.csv e a pasta WAVS Run:

cd scripts

python wav_to_text.py audition

O script gera um novo arquivo, Markers_STT.csv .

Para Audacity , usando o Label Track.txt e Wavs Pasta Run:

cd scripts

python wav_to_text.py audacity

O script gera um novo arquivo, Label Track STT.csv .

Transcrições de ajuste fino

Para audição :

- Exclua todos os marcadores

- Selecione

Import Markers from File e selecione Arquivo com STT Transcrições: Markers_Stt.csv - Ajuste o campo de descrição em marcadores para corresponder exatamente às palavras faladas

Para Audacity :

- Open

Label Track STT.txt Em um editor de texto. - Tune o campo dos rótulos no arquivo de texto para corresponder exatamente às palavras faladas

Marcadores de exportação (somente audição) e ondas

Para audição :

- Selecione todos os marcadores na lista

- Selecione

Export Selected Markers to CSV e salvar como marcadores.csv - Selecione

Export Audio of Selected Range Markers com as seguintes opções:- Verifique

Use marker names in filenames - Atualizar formato para

WAV PCM - Atualização do tipo de amostra

22050 Hz Mono, 16-bit - Use a pasta

wavs_export

Para Audacity :

- Selecione

Export multiple...- Formato: WAV

- Opções: PCM assinado de 16 bits

- Arquivos divididos com base em rótulos

- Nome Arquivos usando o nome da etiqueta/faixa

- Use a pasta

wavs_export

Converter marcadores (audição) ou etiquetas (audácia) em formato LJSpeech

Usando os Markers.csv exportados.csv (audição) ou Label Track STT.txt (audacity) e wavs em wavs_export, scripts/markersfile_to_metadata.py criará um metadado.csv e a pasta de ondas para treinar seu modelo TTS:

Para audição :

python markersfile_to_metadata.py audition

Para Audacity :

python markersfile_to_metadata.py audacity

Comprimentos de frase

Execute scripts/wavdurations2csv.sh para traçar o comprimento da frase e verificar se você tem uma boa distribuição de comprimentos de arquivo WAV.

Outros utilitários

Arquivo wav upsample

ffmpeg: Resampado:

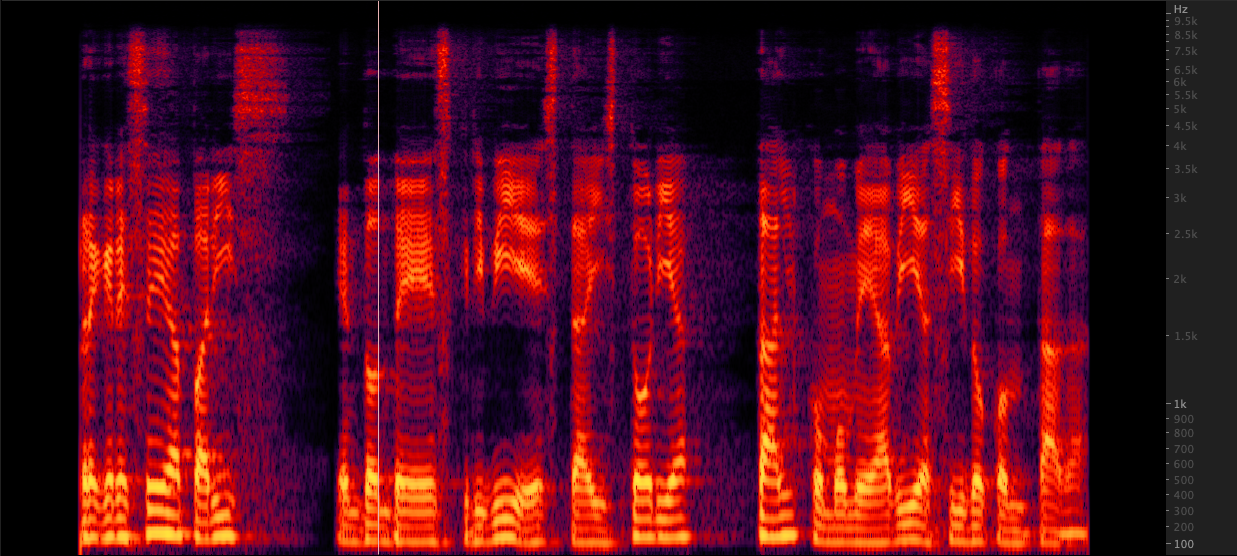

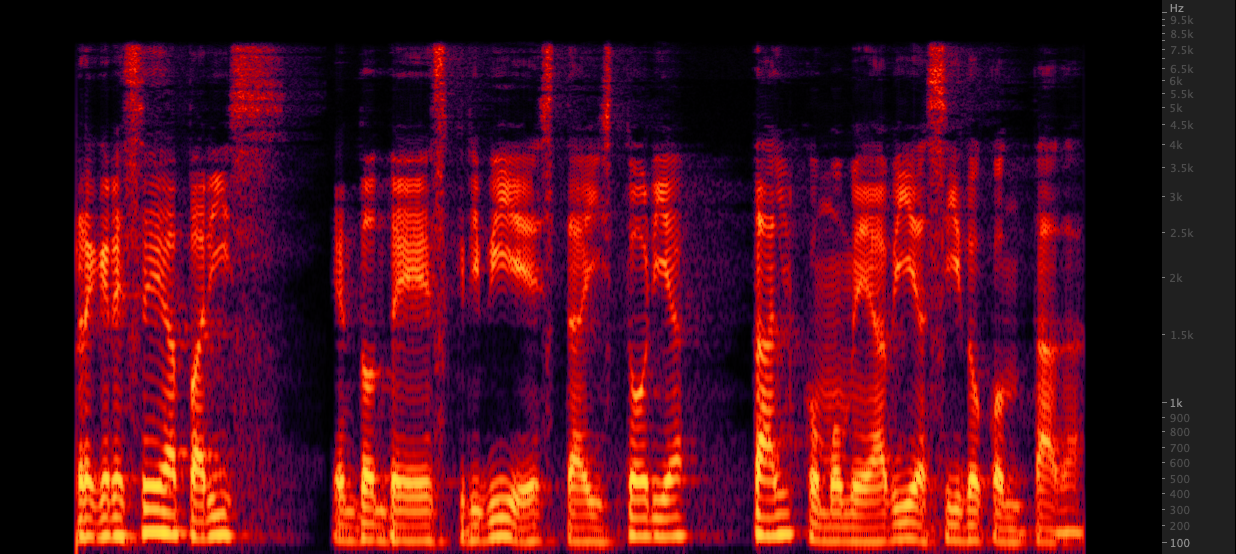

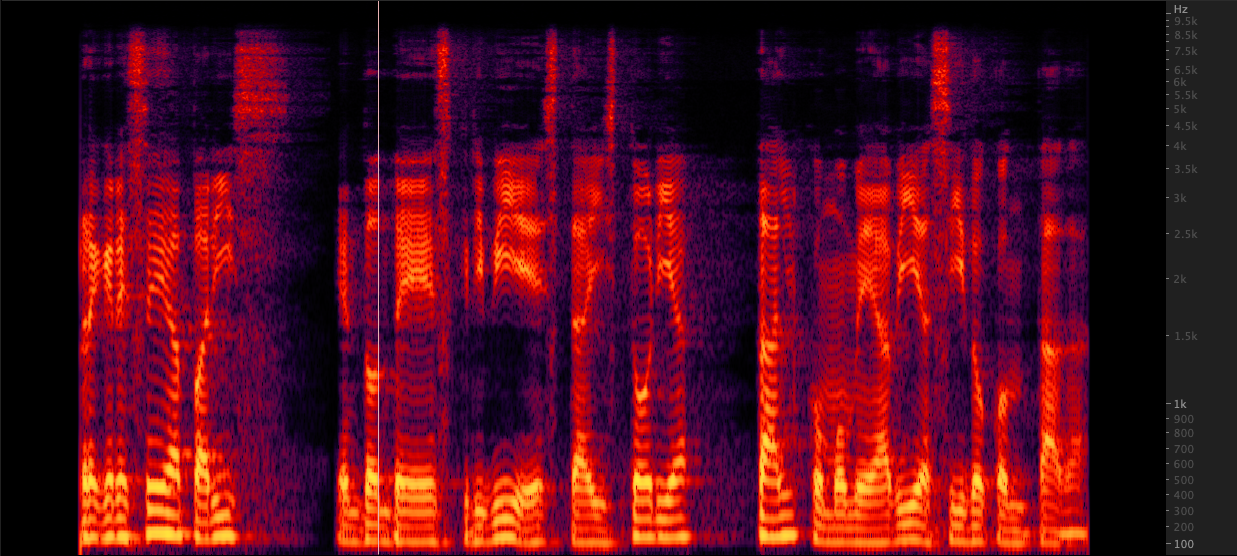

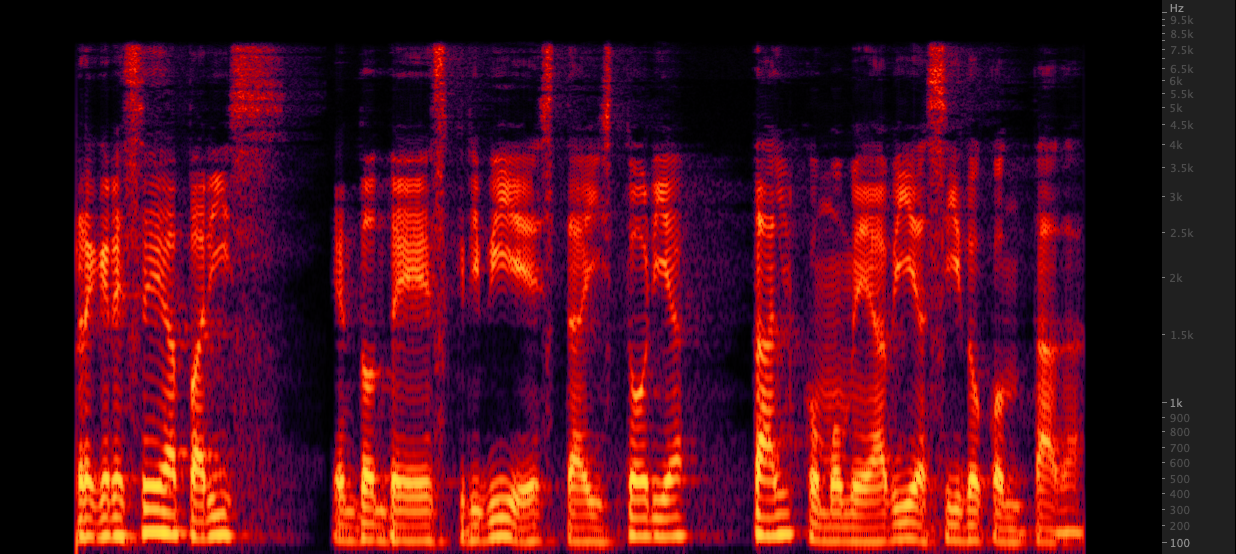

Resampado: Testamos três métodos para aumentar os arquivos WAV de 16.000 a 22.050 Hz. Depois de revisar os espectrogramas, selecionamos o FFMPEG para o upsampling, pois inclui outros 2 kHz de informações de ponta quando comparado ao reperdício. scripts/resamplewav.sh

Testamos três métodos para aumentar os arquivos WAV de 16.000 a 22.050 Hz. Depois de revisar os espectrogramas, selecionamos o FFMPEG para o upsampling, pois inclui outros 2 kHz de informações de ponta quando comparado ao reperdício. scripts/resamplewav.sh

Referências

- Mozilla TTS: https://github.com/mozilla/tts

- O alinhamento de automação, inclui áudio do segmento no silêncio, API de fala do Google e alinhamento de reconhecimento: https://github.com/carpedm20/multi-speaker-tacotron-tensorflow#2-2-generate-korean-datasets

- Pré -treinamento em grandes corpus sintéticos e ajustes finos em específicos https://twitter.com/garygarywang

- Falhas de dados para conjuntos de dados https://arxiv.org/abs/1803.09010

Crie suas próprias gravações de voz

Crie suas próprias gravações de voz Crie um conjunto de dados de voz sintético

Crie um conjunto de dados de voz sintético Crie transcrições para gravações de voz existentes

Crie transcrições para gravações de voz existentes Resampado:

Resampado: Testamos três métodos para aumentar os arquivos WAV de 16.000 a 22.050 Hz. Depois de revisar os espectrogramas, selecionamos o FFMPEG para o upsampling, pois inclui outros 2 kHz de informações de ponta quando comparado ao reperdício. scripts/resamplewav.sh

Testamos três métodos para aumentar os arquivos WAV de 16.000 a 22.050 Hz. Depois de revisar os espectrogramas, selecionamos o FFMPEG para o upsampling, pois inclui outros 2 kHz de informações de ponta quando comparado ao reperdício. scripts/resamplewav.sh