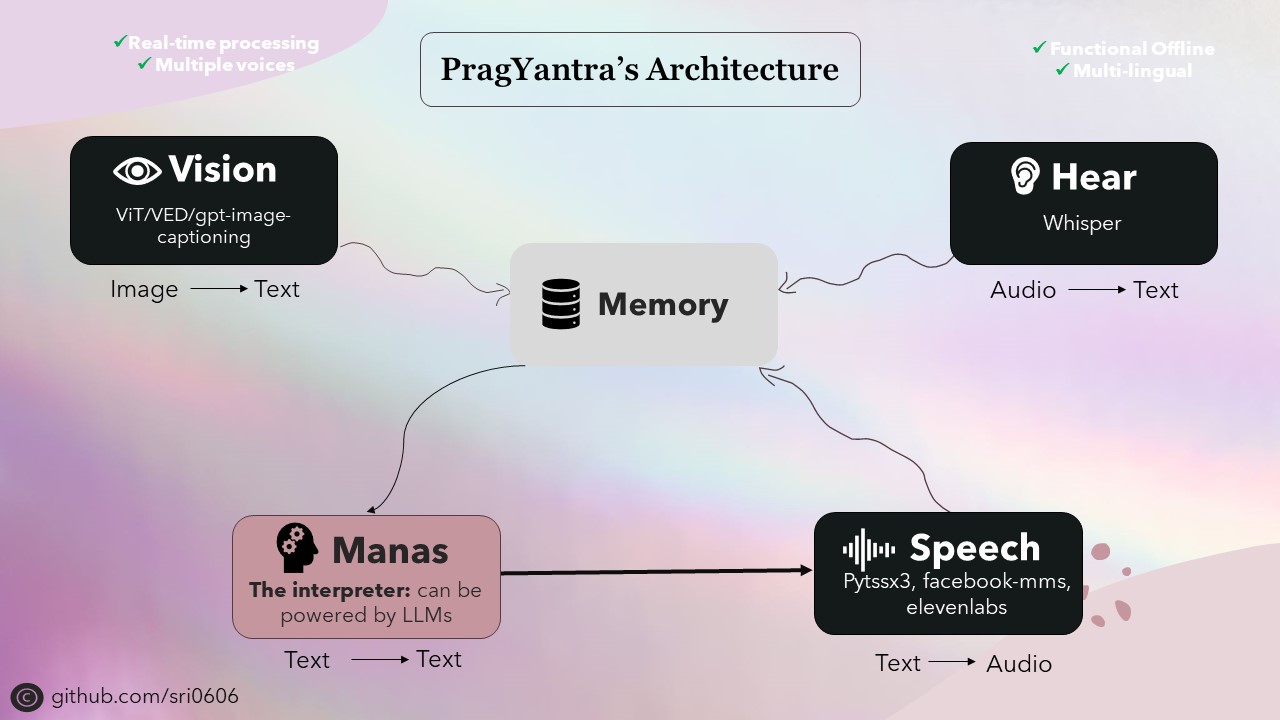

O Pragyantra é um projeto de software simples projetado para simular um robô humanóide com funcionalidades de visão, audição, fala e memória. Este projeto tem como objetivo criar uma plataforma flexível para experimentar a inteligência artificial e a interação humana-máquina. A partir de agora, é mais como um LLM, mas com recursos estendidos, permitindo que ele veja, ouça e se envolva em comunicação verbal.

Eu priorizei o Pragyantra para ter recursos offline, além de integrar funcionalidades on -line. Para conseguir isso, todos os componentes do projeto foram projetados para ter recursos offline, com funcionalidades on -line disponíveis como recursos opcionais. Embora o uso do modo offline possa exigir um dispositivo mais forte para inferência mais rápida, o projeto é totalmente funcional e tem um desempenho admirável nessas condições.

A espinha dorsal do Pragyantra consiste em vários modelos de código aberto para tarefas como conversão de texto para fala, fala para texto, texto em texto e conversão de imagem para texto. Esses modelos servem como os blocos de construção nos quais a arquitetura de Pragyantra é construída, com recursos adicionais e simultaneidade perfeitamente integrados para melhorar o desempenho geral e a experiência do usuário.

Pragyantra, derivado do sânscrito, é uma fusão de duas palavras: "prag" que significa inteligente ou sábia, e "yantra" referindo -se à máquina ou robô. Então, reunidos, o Pragyantra incorpora o conceito de uma máquina inteligente, refletindo o objetivo do projeto de criar uma plataforma flexível para experimentar a IA e a interação humana-máquina.

Para configurar o projeto, siga estas etapas:

Clone o repositório:

git clone https://github.com/sri0606/pragyantra.git

Navegue até o diretório do projeto:

cd pragyantra

Execute o script de configuração:

python setup.py

OU

chmod +x setup.sh

./setup.sh

bash setup.sh

O script de configuração instalará as dependências, baixará os modelos necessários e criará os diretórios necessários.

Para obter ajuda, execute o seguinte comando:

python main.py --help

Exemplo de comandos:

Modo offline

python main.py --interpreter_model llama3_8B --offline_mode --speaker_model pyttsx3Modo online

python main.py --interpreter_model llama3-70B-8192 --speaker_model pyttsx3

or

python main.py --interpreter_model mixtral-8x7b-32768 --speaker_model 11labs @misc {nlp_connect_2022,

author = { {NLP Connect} },

title = { vit-gpt2-image-captioning (Revision 0e334c7) },

year = 2022,

url = { https://huggingface.co/nlpconnect/vit-gpt2-image-captioning },

doi = { 10.57967/hf/0222 },

publisher = { Hugging Face }

}

@article{pratap2023mms,

title={Scaling Speech Technology to 1,000+ Languages},

author={Vineel Pratap and Andros Tjandra and Bowen Shi and Paden Tomasello and Arun Babu and Sayani Kundu and Ali Elkahky and Zhaoheng Ni and Apoorv Vyas and Maryam Fazel-Zarandi and Alexei Baevski and Yossi Adi and Xiaohui Zhang and Wei-Ning Hsu and Alexis Conneau and Michael Auli},

journal={arXiv},

year={2023}

}

@misc{li2021trocr,

title={TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models},

author={Minghao Li and Tengchao Lv and Lei Cui and Yijuan Lu and Dinei Florencio and Cha Zhang and Zhoujun Li and Furu Wei},

year={2021},

eprint={2109.10282},

archivePrefix={arXiv},

primaryClass={cs.CL}

}