Pragyantra는 비전, 청각, 언어 및 기억 기능으로 휴머노이드 로봇을 시뮬레이션하도록 설계된 간단한 소프트웨어 프로젝트입니다. 이 프로젝트는 인공 지능과 인간-기계 상호 작용을 실험 할 수있는 유연한 플랫폼을 만드는 것을 목표로합니다. 현재로서는 LLM과 비슷하지만 확장 된 기능을 갖추어 구두 의사 소통을보고 듣고 참여할 수 있습니다.

Pragyantra는 온라인 기능을 통합하면서 오프라인 기능을 갖도록 우선 순위를 정했습니다. 이를 달성하기 위해 프로젝트의 모든 구성 요소는 온라인 기능을 선택적 기능으로 사용할 수 있도록 오프라인 기능을 갖도록 설계되었습니다. 오프라인 모드를 사용하려면 더 빠른 추론을 위해 더 강력한 장치가 필요할 수 있지만, 프로젝트는 완전히 작동하며 이러한 조건에서 훌륭하게 수행됩니다.

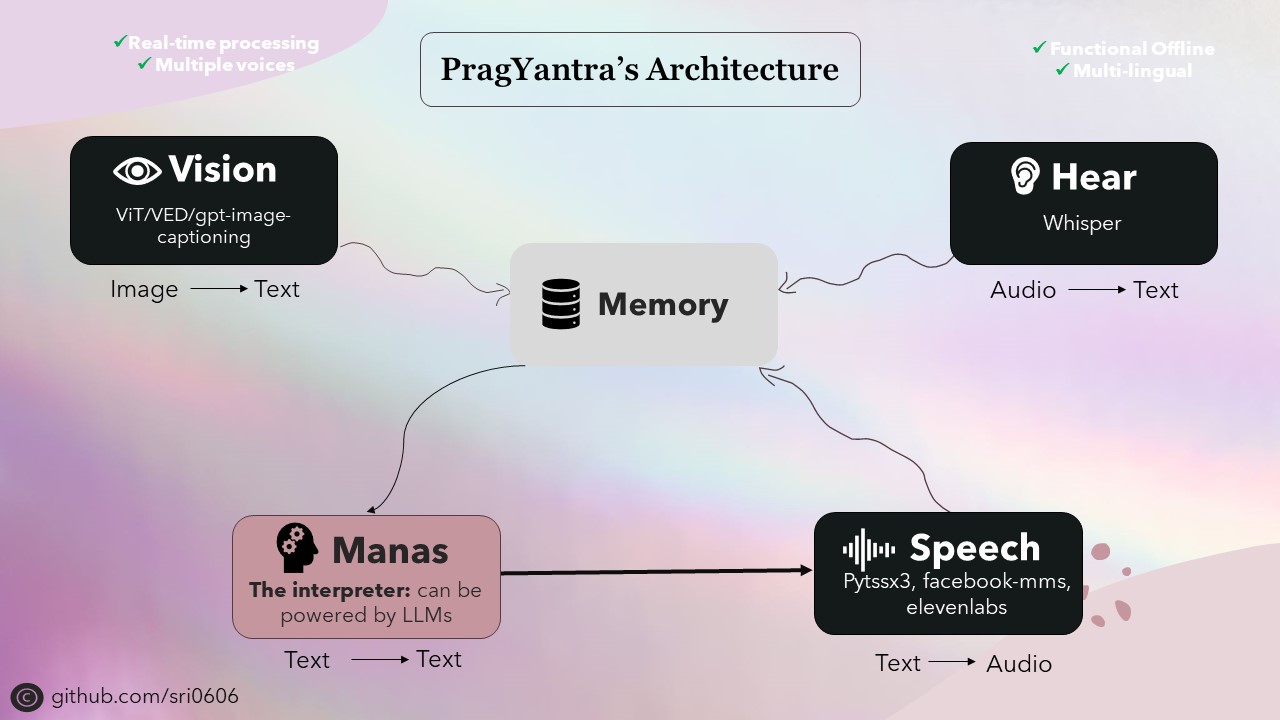

Pragyantra의 중추는 텍스트 음성 연설, 음성-텍스트, 텍스트-텍스트 및 이미지-텍스트 변환과 같은 작업에 대한 다양한 오픈 소스 모델로 구성됩니다. 이 모델은 Pragyantra의 아키텍처가 구축되는 빌딩 블록 역할을하며 추가 기능과 동시성은 전반적인 성능 및 사용자 경험을 향상시킵니다.

산스크리트어에서 파생 된 Pragyantra는 두 단어의 융합입니다. "Prag"는 지능적이거나 현명한 것을 의미하며 기계 나 로봇을 언급하는 "Yantra". 따라서 Pragyantra는 지능형 기계의 개념을 구현하여 AI 및 인간-기계 상호 작용을 실험 할 수있는 유연한 플랫폼을 만드는 프로젝트의 목표를 반영합니다.

프로젝트를 설정하려면 다음 단계를 따르십시오.

저장소 복제 :

git clone https://github.com/sri0606/pragyantra.git

프로젝트 디렉토리로 이동하십시오.

cd pragyantra

설정 스크립트 실행 :

python setup.py

또는

chmod +x setup.sh

./setup.sh

bash setup.sh

설정 스크립트는 종속성을 설치하고 필요한 모델을 다운로드하며 필요한 디렉토리를 만듭니다.

도움을 받으려면 다음 명령을 실행하십시오.

python main.py --help

예제 명령 :

오프라인 모드

python main.py --interpreter_model llama3_8B --offline_mode --speaker_model pyttsx3온라인 모드

python main.py --interpreter_model llama3-70B-8192 --speaker_model pyttsx3

or

python main.py --interpreter_model mixtral-8x7b-32768 --speaker_model 11labs @misc {nlp_connect_2022,

author = { {NLP Connect} },

title = { vit-gpt2-image-captioning (Revision 0e334c7) },

year = 2022,

url = { https://huggingface.co/nlpconnect/vit-gpt2-image-captioning },

doi = { 10.57967/hf/0222 },

publisher = { Hugging Face }

}

@article{pratap2023mms,

title={Scaling Speech Technology to 1,000+ Languages},

author={Vineel Pratap and Andros Tjandra and Bowen Shi and Paden Tomasello and Arun Babu and Sayani Kundu and Ali Elkahky and Zhaoheng Ni and Apoorv Vyas and Maryam Fazel-Zarandi and Alexei Baevski and Yossi Adi and Xiaohui Zhang and Wei-Ning Hsu and Alexis Conneau and Michael Auli},

journal={arXiv},

year={2023}

}

@misc{li2021trocr,

title={TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models},

author={Minghao Li and Tengchao Lv and Lei Cui and Yijuan Lu and Dinei Florencio and Cha Zhang and Zhoujun Li and Furu Wei},

year={2021},

eprint={2109.10282},

archivePrefix={arXiv},

primaryClass={cs.CL}

}