Pragyantra هو مشروع برامج بسيط مصمم لمحاكاة روبوت بشري مع وظائف الرؤية والسمع والكلام والذاكرة. يهدف هذا المشروع إلى إنشاء منصة مرنة لتجربة الذكاء الاصطناعي والتفاعل بين الإنسان والآلة. اعتبارًا من الآن ، يشبه LLM ، ولكن مع إمكانيات ممتدة ، مما يتيح لها رؤية التواصل اللفظي والاستماع إليه والمشاركة فيه.

لقد أعطت الأولوية لـ Pragyantra لقدرات غير متصلة بالإنترنت مع دمج الوظائف عبر الإنترنت أيضًا. لتحقيق ذلك ، تم تصميم جميع مكونات المشروع للحصول على إمكانات غير متصلة بالإنترنت ، مع وجود وظائف عبر الإنترنت متاحة كميزات اختيارية. في حين أن استخدام الوضع غير المتصل قد يتطلب جهازًا أقوى للاستدلال بشكل أسرع ، فإن المشروع يعمل بكامل طاقته ويؤدي بشكل مثير للإعجاب في ظل هذه الظروف.

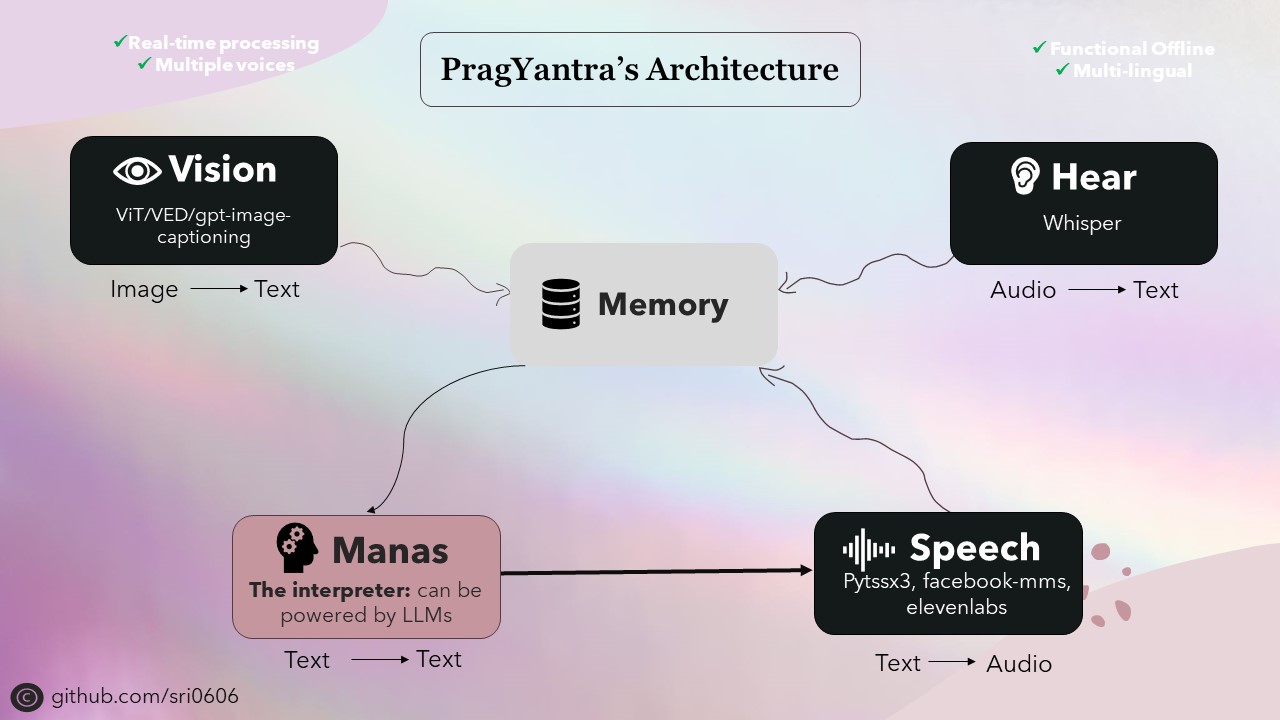

يتكون العمود الفقري لـ Pragyantra من العديد من النماذج المفتوحة للمصادف للمهام مثل تحويل النص إلى الكلام ، والخطاب إلى النص ، ونص من النص ، وتحويل صورة إلى نص. تعمل هذه النماذج كبنات بناء تم بناء بنية Pragyantra عليها ، مع إمكانات إضافية ودمج التزامن بسلاسة لتعزيز الأداء الكلي وتجربة المستخدم.

Pragyantra ، المشتقة من السنسكريتية ، هو اندماج كلمتين: "prag" تعني ذكيًا أو حكيمًا ، و "يانترا" في إشارة إلى الجهاز أو الروبوت. لذلك ، تجسد Pragyantra معًا مفهوم آلة ذكية ، مما يعكس هدف المشروع المتمثل في إنشاء منصة مرنة لتجربة التفاعل بين الذكاء الاصطناعي والآلة البشرية.

لإعداد المشروع ، اتبع هذه الخطوات:

استنساخ المستودع:

git clone https://github.com/sri0606/pragyantra.git

انتقل إلى دليل المشروع:

cd pragyantra

قم بتشغيل البرنامج النصي الإعداد:

python setup.py

أو

chmod +x setup.sh

./setup.sh

bash setup.sh

سيقوم البرنامج النصي الإعداد بتثبيت التبعيات وتنزيل النماذج المطلوبة وإنشاء الدلائل اللازمة.

للمساعدة ، قم بتشغيل الأمر التالي:

python main.py --help

أوامر مثال:

وضع عدم الاتصال

python main.py --interpreter_model llama3_8B --offline_mode --speaker_model pyttsx3الوضع عبر الإنترنت

python main.py --interpreter_model llama3-70B-8192 --speaker_model pyttsx3

or

python main.py --interpreter_model mixtral-8x7b-32768 --speaker_model 11labs @misc {nlp_connect_2022,

author = { {NLP Connect} },

title = { vit-gpt2-image-captioning (Revision 0e334c7) },

year = 2022,

url = { https://huggingface.co/nlpconnect/vit-gpt2-image-captioning },

doi = { 10.57967/hf/0222 },

publisher = { Hugging Face }

}

@article{pratap2023mms,

title={Scaling Speech Technology to 1,000+ Languages},

author={Vineel Pratap and Andros Tjandra and Bowen Shi and Paden Tomasello and Arun Babu and Sayani Kundu and Ali Elkahky and Zhaoheng Ni and Apoorv Vyas and Maryam Fazel-Zarandi and Alexei Baevski and Yossi Adi and Xiaohui Zhang and Wei-Ning Hsu and Alexis Conneau and Michael Auli},

journal={arXiv},

year={2023}

}

@misc{li2021trocr,

title={TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models},

author={Minghao Li and Tengchao Lv and Lei Cui and Yijuan Lu and Dinei Florencio and Cha Zhang and Zhoujun Li and Furu Wei},

year={2021},

eprint={2109.10282},

archivePrefix={arXiv},

primaryClass={cs.CL}

}