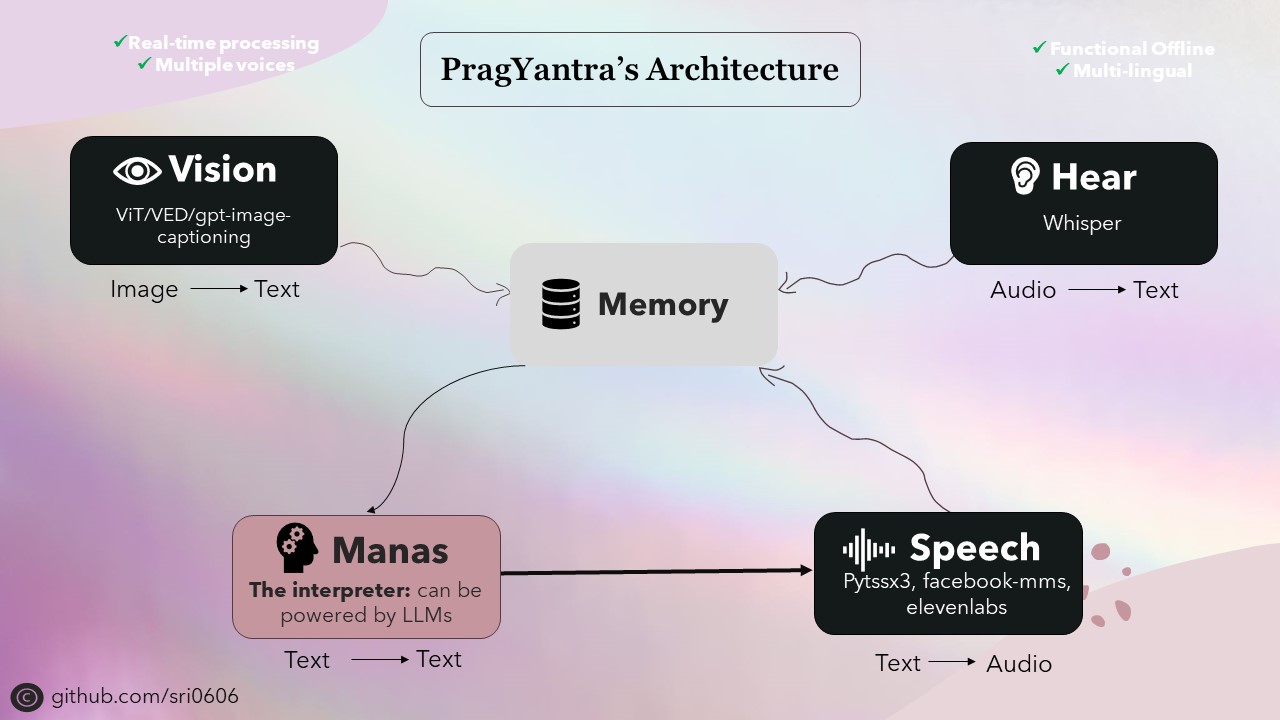

Pragyantraは、ビジョン、聴覚、音声、および記憶機能を備えたヒューマノイドロボットをシミュレートするために設計されたシンプルなソフトウェアプロジェクトです。このプロジェクトの目的は、人工知能と人間の相互作用を実験するための柔軟なプラットフォームを作成することです。現在のところ、それはLLMに似ていますが、拡張機能を備えており、口頭でのコミュニケーションを見て、聞く、関与することができます。

オンライン機能を統合しながら、オフライン機能を持つようにPragyantraに優先順位を付けました。これを達成するために、プロジェクトのすべてのコンポーネントは、オフライン機能をオプションの機能として利用できるように設計されています。オフラインモードを使用すると、より速い推論のためにより強力なデバイスが必要になる場合がありますが、プロジェクトは完全に機能し、これらの条件下で見事に実行されます。

Pragyantraのバックボーンは、テキストからスピーチ、音声からテキスト、テキストからテキスト、画像間変換などのタスクのさまざまなオープンソースモデルで構成されています。これらのモデルは、Pragyantraのアーキテクチャが構築されるビルディングブロックとして機能し、追加の機能と並行性がシームレスに統合され、全体的なパフォーマンスとユーザーエクスペリエンスが向上します。

Sanskritに由来するPragyantraは、2つの単語の融合です。「Prag」はインテリジェントまたは賢明を意味し、「Yantra」は機械またはロボットを指す。したがって、Pragyantraは、AIとHuman-Machineの相互作用を実験するための柔軟なプラットフォームを作成するというプロジェクトの目標を反映して、インテリジェントマシンの概念を具体化します。

プロジェクトをセットアップするには、次の手順に従ってください。

リポジトリをクローンします:

git clone https://github.com/sri0606/pragyantra.git

プロジェクトディレクトリに移動します。

cd pragyantra

セットアップスクリプトを実行します。

python setup.py

または

chmod +x setup.sh

./setup.sh

bash setup.sh

セットアップスクリプトは、依存関係をインストールし、必要なモデルをダウンロードし、必要なディレクトリを作成します。

ヘルプのために、次のコマンドを実行します。

python main.py --help

コマンドの例:

オフラインモード

python main.py --interpreter_model llama3_8B --offline_mode --speaker_model pyttsx3オンラインモード

python main.py --interpreter_model llama3-70B-8192 --speaker_model pyttsx3

or

python main.py --interpreter_model mixtral-8x7b-32768 --speaker_model 11labs @misc {nlp_connect_2022,

author = { {NLP Connect} },

title = { vit-gpt2-image-captioning (Revision 0e334c7) },

year = 2022,

url = { https://huggingface.co/nlpconnect/vit-gpt2-image-captioning },

doi = { 10.57967/hf/0222 },

publisher = { Hugging Face }

}

@article{pratap2023mms,

title={Scaling Speech Technology to 1,000+ Languages},

author={Vineel Pratap and Andros Tjandra and Bowen Shi and Paden Tomasello and Arun Babu and Sayani Kundu and Ali Elkahky and Zhaoheng Ni and Apoorv Vyas and Maryam Fazel-Zarandi and Alexei Baevski and Yossi Adi and Xiaohui Zhang and Wei-Ning Hsu and Alexis Conneau and Michael Auli},

journal={arXiv},

year={2023}

}

@misc{li2021trocr,

title={TrOCR: Transformer-based Optical Character Recognition with Pre-trained Models},

author={Minghao Li and Tengchao Lv and Lei Cui and Yijuan Lu and Dinei Florencio and Cha Zhang and Zhoujun Li and Furu Wei},

year={2021},

eprint={2109.10282},

archivePrefix={arXiv},

primaryClass={cs.CL}

}