AdaSpeech

1.0.0

adaspeech의 비공식 pytorch 구현.

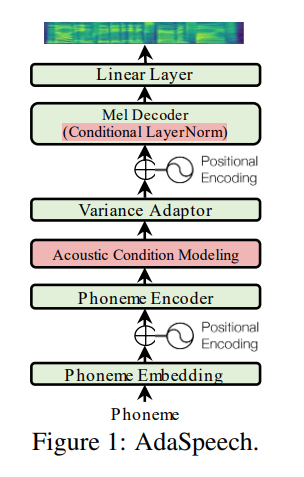

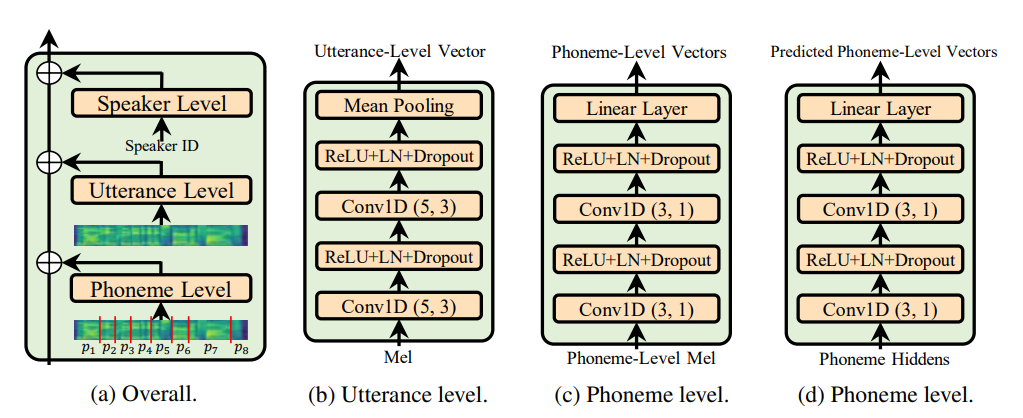

Utterance level encoder 와 Phoneme level encoder 만 사용하지 않으며 조건 층 표준 (Adaspeech 종이의 영혼)이 Adaspeech의 적응 특성을 제한하지만 내 초점은 적응보다는 FastSpeech 2 음향 일반화를 향상시키는 것입니다.

@misc { chen2021adaspeech ,

title = { AdaSpeech: Adaptive Text to Speech for Custom Voice } ,

author = { Mingjian Chen and Xu Tan and Bohan Li and Yanqing Liu and Tao Qin and Sheng Zhao and Tie-Yan Liu } ,

year = { 2021 } ,

eprint = { 2103.00993 } ,

archivePrefix = { arXiv } ,

primaryClass = { eess.AS }

} Python 3.6.2 로 작성된 모든 코드.

Pytorch를 설치하기 전에 다음 명령을 실행하여 Cuda 버전을 확인하십시오 :

nvcc --version

pip install torch torchvision

이 repo에서 나는 이전 버전의 Pytorch에 존재하지 않는 torch.bucketize 기능에 Pytorch 1.6.0을 사용했습니다.

pip install -r requirements.txt

tensorboard version 1.14.0 지원되는 tensorflow (1.14.0) 사용하여 Seperatly filelists 폴더에는 MFA (Motreal Force Aligner) 가공 된 LJSpeech 데이터 세트 파일이 포함되어 있으므로 LJSpeech DataSet의 오디오 (추출 기간 동안)와 텍스트를 정렬 할 필요가 없습니다. 다른 데이터 세트는 여기에서 지침을 따르십시오. 다음 명령을 따르는 다른 사전 처리 실행 :

python nvidia_preprocessing.py -d path_of_wavs

F0의 최소와 최대 및 에너지를 찾기 위해

python compute_statistics.py

최소 및 최대 F0 및 Energy의 hparams.py 에서 다음을 업데이트하십시오.

p_min = Min F0/pitch

p_max = Max F0

e_min = Min energy

e_max = Max energy

python train_fastspeech.py --outdir etc -c configs/default.yaml -n "name"