프로젝트 개요

Entity + Opinion (Aspect) 실제 주석이 달린 레이블에 대한 평가와 함께 고객 서비스 검토에서 추출.

데이터 세트 :

- 설명 : Yelp 고객 서비스 레스토랑 리뷰

- 이름 :

train.csv - 내용 : CSV 파일에는 두 개의 열이 포함되어 있습니다 (검토, 감정/의견/종자 레이블)

- 참고 : 원시 리뷰 만 분석했습니다. 코드의 목적은이를 추출하는 개선 된 방법을 찾는 것이었기 때문에 감정/의견 레이블이 무시되었습니다.

- 참고 : 이 파일은 EDA 목적으로 만 사용되었습니다.

진정한 레이블

- 데이터 세트는 실제 레이블을 생성하기 위해 인간의 주석을 겪지 않았습니다.

- True-VS-Pred 레이블의 POC 비교를 위해

sample_review.csv 파일 (단일 주석 검토 포함)이 작성되었습니다.

프로젝트 부품 :

1 부 -EDA

파트 II- 엔티티 의견 튜플 추출

이 모듈은 엔터티 (예 : '다소 맛있는')에 관한 검토 자의 의견과 함께 검토 된 엔티티 (예 : 'Food')를 추출하는 것과 관련이 있습니다.

파트 III- 평가

이 모듈은 지상 진실 주석에 대한 엔티티-오피니언 튜플 추출의 평가와 관련이 있습니다.

EDA : 초기 및 일반 통찰력

- 검토 수 : 1121

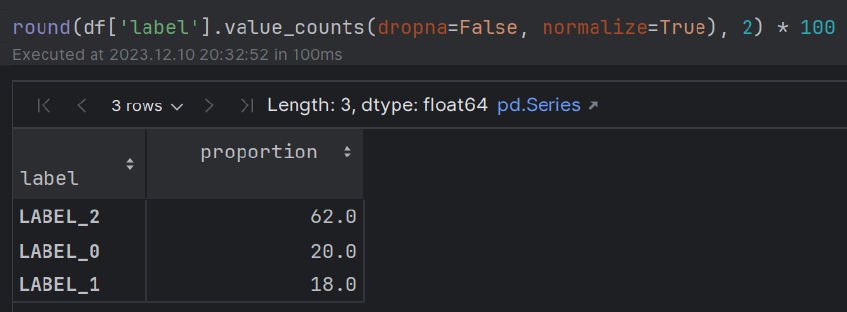

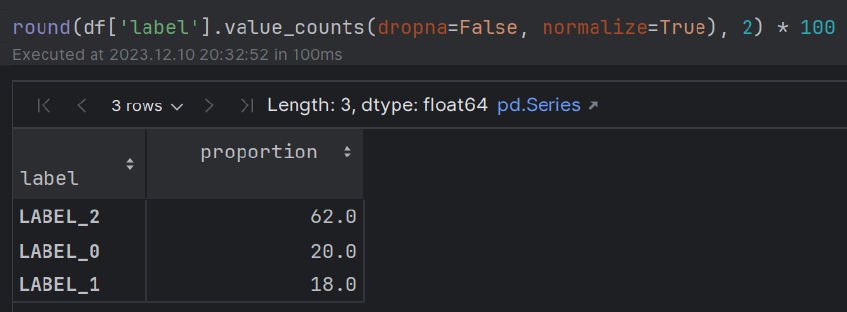

- 감정 : ~ 60% (POS); ~ 20% (중립); ~ 20% (부정) 대부분의 사람들은 식사 경험에 관한 긍정적 인 감정을 보여줍니다.

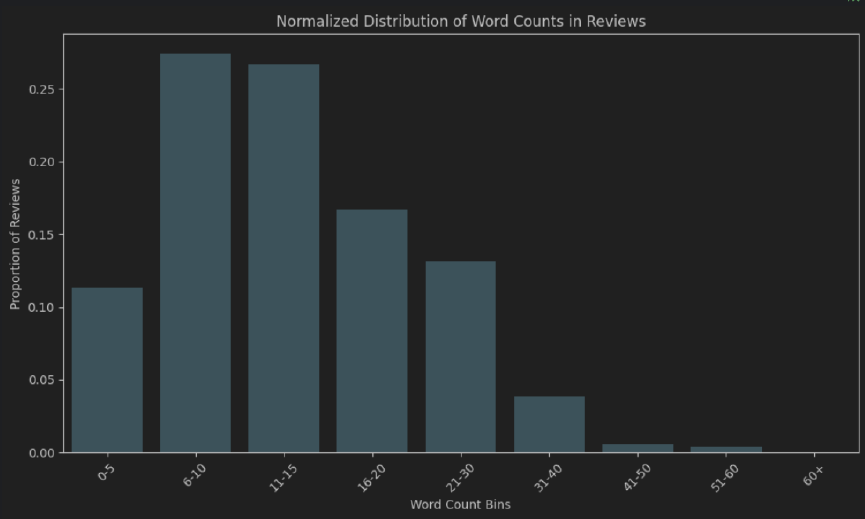

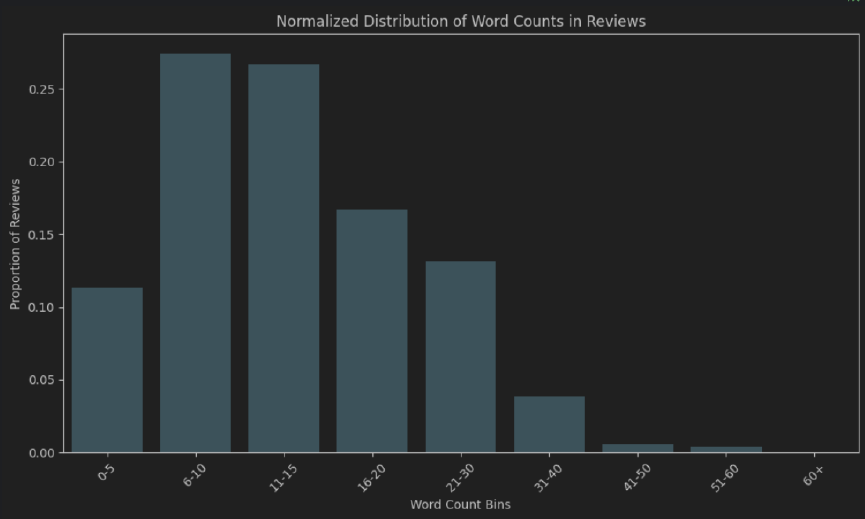

- 단어 길이 : 약. 리뷰의 50%는 길이가 6-15입니다. 대부분의 사람들은 "매우 철저한"리뷰를 작성하는 데 시간이 걸리지 않습니다.

- 확장 된 EDA- 통찰력을 얻는 데 사용할 수있는 추가 NLP 기술 : Q & A 모델, WordCloud, N -Gram 주파수 수 (스톱워드 제거 후), 퍼지 매칭, 정확한/부분 일치 (스톱워드, 형태 학적 접두사 및 접미사), 클러스터링 알고리즘 (Lexicosyntactic, Sement, Sated, Saterity, Polased, Sated, Sated) 음식/음료, 식사 유형 (아침 식사, 점심, 저녁), 이진 POS 기반 토큰 (형용사 vs 휴식), 부사 강화제 분석, 구문 의존성 분석, 구두점 분포 (유형, 이진, 감정과의 조합)의 구별.

암호

- EDA-

EDA.ipynb 파일을 참조하십시오 - 엔티티 의견 추출 + True-VS-Pred Eval. - 프로젝트 (

.py 모듈)

지침

main.py 모듈을 실행하십시오

참고 :

- OpenAI API 키를 저장할

.env 파일을 작성하십시오. - 다음 형식을 사용하십시오 :

OPENAI_API_KEY = "your_openai_api_key"

구현 및 대안 :

에다

단순한 접근 방식 (빠른, 데이터의 초기 거시적보기 만 제공)

- 전체 검토 길이를 측정하기 위해 단어 수 분포 (절대 및 정규화).

- Word Cloud

더 심층적 인 이해

Lexicosyntactic에서 Semantics-Pragmatics 인터페이스 접근법으로 이동합니다

엔티티-오피니언 추출

- NER 모델은 모든 영역 (예 : 식당 리뷰)에서 가능한 엔티티의 전체 스펙트럼을 반영하지 않는 훈련 된 실체 세트에 국한됩니다. 그들은 지루한 주석, 검토 및 훈련 과정이 필요합니다.

- Q & A 모델은 주로 특정 질문 및 데이터 세트에 대해 교육을 받고 LLM보다 유형 I 및 II 오류가 더 많을 수 있습니다.

프롬프트 엔지니어링

다음에 중점을 두었습니다.

- 간이 침대 (사슬)

- 소수의 학습

- 시스템/사용자/보조 역할 구별

- 모델을 안심시킵니다

평가 접근법 : 지상 진실 주석에 대한 LLM 추출

코사인 유사성을 사용하여 시맨틱 텍스트 유사성을 측정하기위한 Bert 문장 변환기.

진정한 VS 예측 엔티티와 의견 (측면)의 다양한 언어 적 변형을 테스트 한 후 모델의 프로덕션에 대한 예측을 수용하기 위해 0.85의 임계 값이 설정되었습니다.

평가 대안

규칙 기반 솔루션과 함께 문장 변환 자

결과의 유효성을 강화하기 위해 정교한 접근 방식 (문장 변환 자와 같은)을 전통적인 규칙 기반 접근 방식과 결합합니다.

예를 들어, 구문 의존성 구문 분석과 결합 된 변압기 기반 솔루션, POS 및 NER (언어 기능)은“식당”과“식당”이 위의“맛있는”및“다소 맛있는”예제와 반대되는 것과 동일하게 (결정자와 함께) 동일하게 간주되는지 확인하는 데 도움이 될 수 있습니다.

전통적인 분류 지표 (리콜, 정밀, F1- 점수, 정확도)

보다 전통적인 분류 메트릭 (리콜, 정밀, F1- 점수, 정확도) 은이 경우 관련성이 떨어집니다.

혼란 매트릭스 구성 요소의 많은 부분은 전체 검토에서 한 단어/문구의 이진 분류 작업과 관련이 없습니다 (한 번 엔터티 인식 및 한 번). 이로 인해 이러한 메트릭 중 일부를 계산할 수 없습니다.

또한, 이러한 메트릭은 형용사/명사 수정 자 및 부사 강화제의 포함/제거에 의해 영향을받는 미세한 의미를 완전히 포착하지 못한다. 예를 들어, "맛있는"대 "다소 맛있는"것입니다.

또한, 이는 리콜, 정밀, F1 스코어 및 정확도를 사용할 때 이와 같은 부분 일치를 무시할 것인지에 대한 의문을 제기합니다.

전통적인 N- 그램 기반 메트릭 (Lexicosyntactic 유사성)

그러나 기준을 설정하는 데 전통적인 N- 그램 기반 메트릭이 사용될 수 있다고 생각합니다.

- 블루 (정밀 초점)

- Rouge (리콜 중심)

- Meteor (단어 순서 및 문구 차이에 대한 처벌과 함께 고조파 정밀 평균을 계산하고 리콜)

생산의 솔루션 생존력

더 철저한 테스트가 필요하지만, 비교적 엄격한 임계 값 (대부분 형용사/명사 수정 자 및 사상 복잡한 강제 자의 존재/부재를 고려해야하는)과 함께 Bert 문장 변환기 임베딩 사이의 의미 론적 텍스트 유사성을 측정하는 데 사용되는 코사인 유사성 접근법은 생산 환경에서 작동 할 수 있습니다.

대기 시간, 계산 시간, 서버에서 무거운 모델 호스팅 및 추가 비용과 같은 생산 환경에 대한 추가 고려 사항도 있습니다.