Projektübersicht

Entity + Opinion (Aspekt) Extraktion aus Kundendienstüberprüfungen sowie eine Bewertung gegen echte kommentierte Etiketten.

Datensatz:

- Beschreibung: Yelp Customer Service Restaurant Bewertungen

- Name:

train.csv - Inhalt: Die CSV -Datei enthält zwei Spalten (Review, Sentiment/Opinion/Aspekt -Etikett)

- HINWEIS: Nur die RAW -Bewertungen wurden analysiert. Das Gefühl/Meinungskenner wurde nicht berücksichtigt, da der Zweck des Kodex darin bestand, verbesserte Wege zu finden, es zu extrahieren.

- Hinweis: Diese Datei wurde nur für EDA -Zwecke verwendet.

Wahre Etiketten

- Der Datensatz hat keine menschliche Annotation zur Generierung echter Beschriftungen unterzogen.

- Eine

sample_review.csv Datei (mit einer einzigen kommentierten Überprüfung enthält) wurde für einen POC-Vergleich von true-vs-geprezierten Labels erstellt.

Projektteile:

Teil I - Eda

Teil II - Entitätsmeinung Tupelextraktion

Dieses Modul befasst sich mit der Extraktion des Unternehmens (z. B. "Food") zusammen mit der Meinung des Rezensenten über die Entität (z. B. "etwas lecker").

Teil III - Bewertung

Dieses Modul befasst sich mit der Bewertung der Entitäts-Opinion-Tupel-Extraktion gegen die Annotationen der Grundwahrheit.

EDA: Erste und allgemeine Erkenntnisse

- Num der Überprüfung: 1121

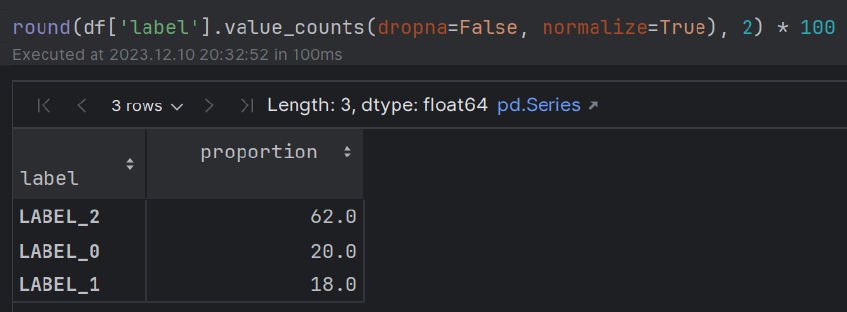

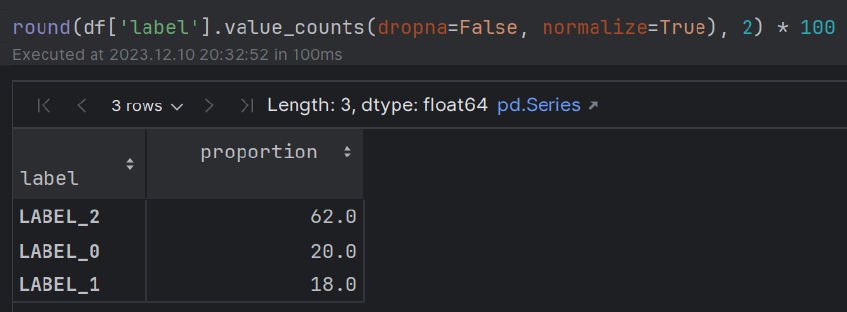

- Stimmung: ~ 60% (POS); ~ 20% (neutral); ~ 20% (NEG) Die meisten Menschen zeigen positive Emotionen in Bezug auf ihr Essenserlebnis.

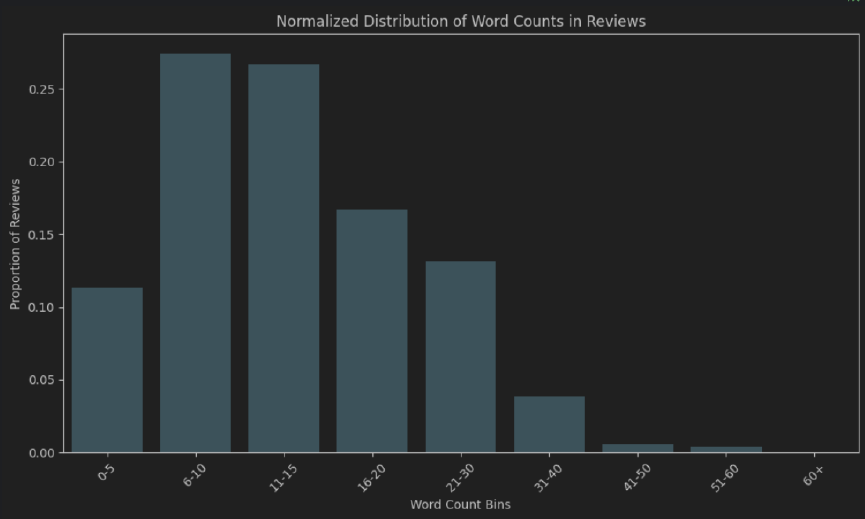

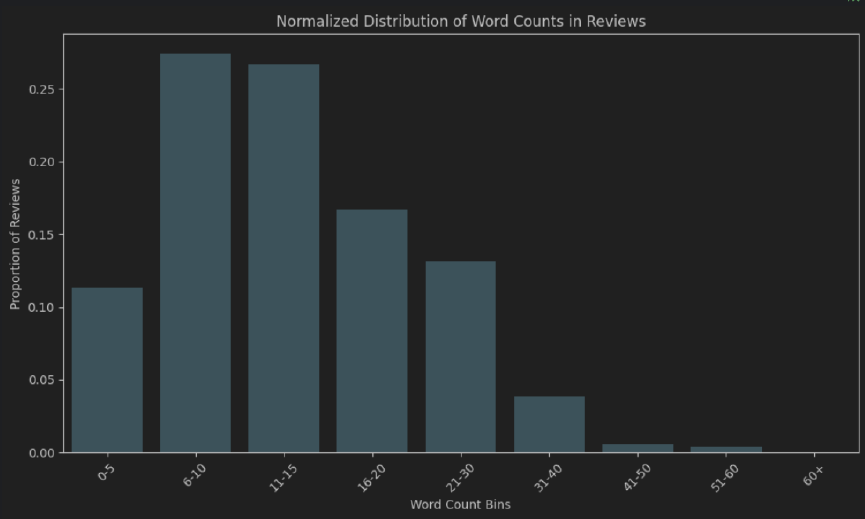

- Wortlänge: ca. 50% der Bewertungen sind 6-15 Token lang. Die meisten Menschen nehmen sich nicht die Zeit, um eine „sehr gründliche“ Bewertung zu schreiben.

- Extended EDA - Additional NLP techniques that can be used for gaining insights: Q&A model, WordCloud, N-gram frequency count (after stopwords removal), fuzzy matching, exact/partial matching (stopwords, morphological prefixes and suffixes), clustering algorithms (lexicosyntactic, semantic), sentiment, polarity, aspect and sentiment combined, NER, distinction In Lebensmittel/Getränke, Unterscheidung in Arten von Mahlzeiten (Frühstück, Mittagessen, Abendessen), Binär-POS-basierte Unterscheidung von Token (Adjektive gegen Ruhe), Adverbiale Analyse intensivierter, syntaktische Abhängigkeitsanalyse, Verteilung von Punkten (Arten, binär, Kombination mit Stimmung).

Code

- EDA - Siehe

EDA.ipynb -Datei - Entität Meinungsextraktion + true-vs-vorgegebene Bewertung. - Projekt (

.py -Module)

Anweisungen

Führen Sie das main.py -Modul aus

Anmerkungen:

- Stellen Sie sicher, dass Sie eine

.env -Datei zum Speichern Ihres OpenAI -API -Schlüssels erstellen. - Verwenden Sie das folgende Format:

OPENAI_API_KEY = "your_openai_api_key"

Implementierung und Alternativen:

Eda

Einfachistische Ansätze (schnell, lediglich eine anfängliche Makroansicht der Daten)

- Verteilung der Wortzahl (sowohl absolut als auch normalisiert) zur Messung der Gesamtlänge der Überprüfungen.

- Wortwolke

Ein detaillierteres Verständnis

Übergang von Lexikosyntaktisch zu einem Semantics-Pragmatics-Schnittstellenansatz

- Themenmodellierung mit Bertopic

Entitäts-Opinion-Extraktion

- NER -Modelle beschränken sich auf eine Reihe von geschulten Einheiten, die das gesamte Spektrum möglicher Einheiten in allen Bereichen nicht widerspiegeln (z. B. Restaurantbewertungen). Sie erfordern einen mühsamen Prozess der Anmerkungen, der Überprüfung und Schulung.

- Q & A -Modelle werden hauptsächlich auf einer bestimmten Reihe von Fragen und Datensätzen geschult und können mehr Fehler vom Typ I und II als LLMs haben.

Schnelltechnik

Der Schwerpunkt wurde auf Folgendes gelegt:

- Kinderbett (Gedankenkette)

- Wenige Schüsse Lernen

- System-/Benutzer-/Assistenz -Rolle Unterscheidung

- Das Modell beruhigen

Bewertungsansatz: LLM -Extraktion gegen die Annotationen der Bodenwahrheit

Bert-Satztransformer zur Messung der semantischen textuellen Ähnlichkeit mithilfe der Kosinusähnlichkeit.

Nach dem Testen verschiedener sprachlicher Variationen von echten VS-vorgesehenen Unternehmen und Meinungen (Aspekten) wurde ein Schwellenwert von 0,85 für die Annahme der Vorhersage des Modells in die Produktion eingestellt.

Bewertungsalternativen

Satztransformatoren neben regelbasierten Lösungen

Kombinieren Sie ausgefeilte Ansätze (wie Satztransformer) mit traditionellen, regelbasierten Ansätzen, um die Gültigkeit der Ergebnisse zu stärken.

Zum Beispiel könnten transformatorbasierte Lösungen in Kombination mit syntaktischer Abhängigkeitsanalyse, POS und NER (Sprachfunktionen) dazu beitragen, sicherzustellen, dass „Restaurant“ und „das Restaurant“ als das gleiche (mit/aus dem Bestimmer) im Gegensatz zu „The Lasty“ und „etwas leckeres“ Beispiel von oben angesehen werden.

Traditionelle Klassifizierungsmetriken (Rückruf, Präzision, F1-Score, Genauigkeit)

In diesem Fall sind traditionellere Klassifizierungsmetriken (Rückruf, Präzision, F1-Score, Genauigkeit) weniger relevant.

Viele der Verwirrungsmatrixkomponenten sind in einer binären Klassifizierungsaufgabe von nur einem Wort/einer Phrase aus einer ganzen Übersicht irrelevant (einmal zur Erkennung von Entität und einmal für Aspekt). Dies macht es unmöglich, einige dieser Metriken zu berechnen.

Darüber hinaus können diese Metriken die winzige Semantik nicht vollständig erfassen, die durch die Einbeziehung/Entfernung von Adjektiv-/Substantivmodifikatoren und Adverbialstärkern beeinflusst wird. Nehmen Sie zum Beispiel „lecker“ gegen „etwas lecker“.

Darüber hinaus wirft die Frage auf, ob dies bei der Verwendung von Abrechnung, Präzision, F1-Score und Genauigkeit zu berücksichtigen ist, als wenn sie diese ignorieren.

Traditionelle Metriken auf n-Gramm-Basis (Lexikosyntaktische Ähnlichkeit)

Ich glaube jedoch, dass traditionelle Kennzahlen auf N-Grammbasis für die Einrichtung einer Grundlinie eingesetzt werden könnten:

- Bleu (präzisionsfokussierte)

- Rouge (Rückrufausschusser)

- Meteor (berechnet den harmonischen Mittelwert von Präzision und Rückruf neben Strafen für Wortreihenfolge und Phrasenunterschiede)

Lebensfähigkeit der Lösung bei der Produktion

Obwohl es eine gründlichere Prüfung erfordert, wird der Ansatz der Cosinus-Ähnlichkeit zur Messung der semantischen textuellen Ähnlichkeit zwischen Bert-Satztransformern zusammen mit einem relativ strengen Schwellenwert (die das Vorhandensein/Fehlen von Adjektiv-/Substantivmodifikatoren und Adverbialstärkern berücksichtigen) und könnte in einer Produktionsumgebung berücksichtigt werden.

Es gibt auch zusätzliche Überlegungen zu einer Produktionsumgebung, wie Latenz, Berechnungszeit, hohe Modelle auf Servern und zusätzliche Kosten.