순수한 C/C ++에서 MINIGPT4의 추론.

minigpt4.cpp 의 주요 목표는 GGML 라이브러리를 사용하여 4 비트 양자화를 사용하여 Minigpt4를 실행하는 것입니다.

요구 사항 : git

git clone --recursive https://github.com/Maknee/minigpt4.cpp

cd minigpt4.cpp 릴리스로 이동하여 minigpt4 라이브러리 파일을 리포지토리 디렉토리로 추출하십시오.

요구 사항 : CMake, Visual Studio 및 Git

cmake .

cmake --build . --config Release

binReleaseminigpt4.dll 생성해야합니다

요구 사항 : Cmake (Ubuntu : sudo apt install cmake )

cmake .

cmake --build . --config Release minigpt4.so 생성해야합니다

요구 사항 : CMAKE (MACOS : brew install cmake )

cmake .

cmake --build . --config Release minigpt4.dylib 생성해야합니다

참고 : OPENCV (라이브러리 자체 내에서로드 및 전처리 이미지와 같은 기능을 허용하는 경우)로 빌드 한 경우 CMakeLists.txt 에서 MINIGPT4_BUILD_WITH_OPENCV ON 하거나 CMAKE CLI의 매개 변수로 -DMINIGPT4_BUILD_WITH_OPENCV=ON 구성하십시오.

미리 정량화 된 모델은 포옹 ~ 7b 또는 13b에서 사용할 수 있습니다.

신뢰할 수있는 결과에 권장되지만 느린 추론 속도 : MINIGPT4-13B-F16.BIN

요구 사항 : Python 3.x 및 Pytorch.

Minigpt-4 저장소를 복제하고 설정을 수행하십시오

cd minigpt4

git clone https://github.com/Vision-CAIR/MiniGPT-4.git

cd MiniGPT-4

conda env create -f environment.yml

conda activate minigpt4 Checkpoint Aligned with Vicuna 7B 또는 Checkpoint Aligned with Vicuna 13B 정렬 된 체크 포인트 아래의 미니 시프트 -4 저장소에서 사전 처리 된 체크 포인트를 다운로드하거나 7B 또는 13B의 HuggingFace 링크에서 다운로드하십시오.

모델 가중치를 GGML 형식으로 변환하십시오

7B 모델

cd minigpt4

python convert.py C:pretrained_minigpt4_7b.pth --ftype=f16

13B 모델

cd minigpt4

python convert.py C:pretrained_minigpt4.pth --ftype=f16

7B 모델

python convert.py ~ /Downloads/pretrained_minigpt4_7b.pth --outtype f1613B 모델

python convert.py ~ /Downloads/pretrained_minigpt4.pth --outtype f16 minigpt4-7B-f16.bin 또는 minigpt4-13B-f16.bin 을 생성해야합니다

미리 정량화 된 모델은 포옹 얼굴에서 사용할 수 있습니다

신뢰할 수있는 결과 및 괜찮은 추론 속도에 권장 : GGML-VICUNA-13B-V0-Q5_K.BIN

요구 사항 : Python 3.x 및 Pytorch.

Minigpt4의 안내서를 따라 Vicuna-V0 모델을 얻으십시오.

그런 다음 클론 llama.cpp

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

cmake .

cmake --build . --config Release모델을 GGML로 변환하십시오

python convert.py < path-to-model >모델을 정량화하십시오

python quanitize < path-to-model > < output-model > Q4_1 minigpt4-13B-f16.bin 및 ggml-vicuna-13B-v0-q5_k.bin 각 모델로 대체하여 Minigpt4가 작동하는지 테스트하십시오.

cd minigpt4

python minigpt4_library.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.binWebUI의 요구 사항을 설치하십시오

pip install -r requirements.txt 그런 다음 webui를 실행하여 minigpt4-13B-f16.bin 및 ggml-vicuna-13B-v0-q5_k.bin 각 모델로 대체하십시오.

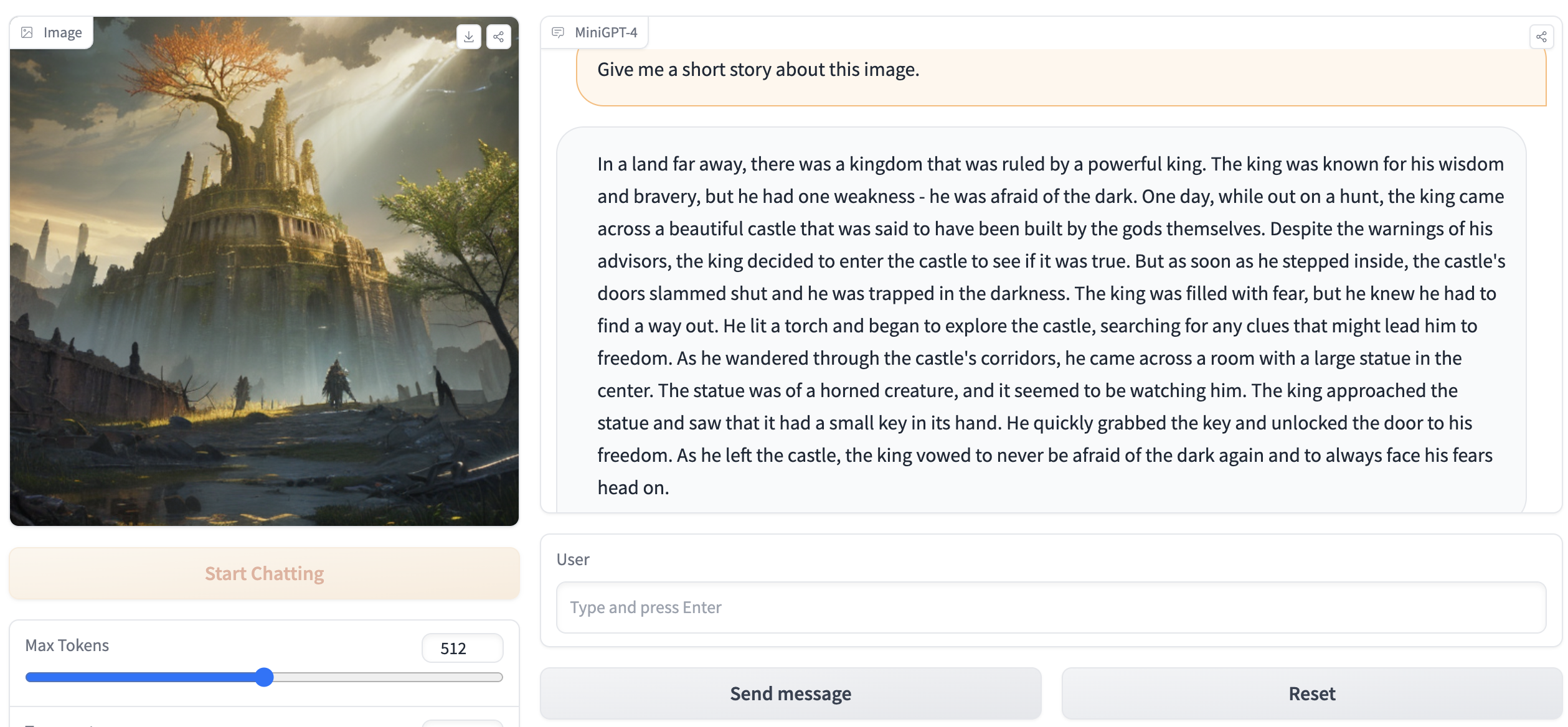

python webui.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.bin출력은 다음과 같은 것을 포함해야합니다.

Running on local URL: http://127.0.0.1:7860

To create a public link, set ` share=True ` in `launch () ` . 브라우저에서 http://127.0.0.1:7860 으로 이동하면 WebUI와 상호 작용할 수 있어야합니다.