استنتاج minigpt4 في C/C ++ النقي.

الهدف الرئيسي من minigpt4.cpp هو تشغيل minigpt4 باستخدام قياس كمي 4 بت باستخدام مكتبة GGML.

المتطلبات : git

git clone --recursive https://github.com/Maknee/minigpt4.cpp

cd minigpt4.cpp انتقل إلى الإصدارات واستخراج ملف مكتبة minigpt4 في دليل المستودع.

المتطلبات : Cmake ، Visual Studio و Git

cmake .

cmake --build . --config Release

binReleaseminigpt4.dll يجب إنشاء

المتطلبات : Cmake (Ubuntu: sudo apt install cmake )

cmake .

cmake --build . --config Release minigpt4.so يجب إنشاء

المتطلبات : cmake (MacOS: brew install cmake )

cmake .

cmake --build . --config Release minigpt4.dylib يجب إنشاء

ملاحظة: إذا قمت ببناء مع OpenCV (مما يسمح بميزات مثل التحميل والمعالجة المسبقة داخل المكتبة نفسها) ، قم بتعيين MINIGPT4_BUILD_WITH_OPENCV إلى ON CMakeLists.txt أو بناء مع -DMINIGPT4_BUILD_WITH_OPENCV=ON معلمة مع cmake cli.

تتوفر النماذج المسبقة مسبقًا على وجه المعانقة ~ 7b أو 13b.

موصى به للحصول على نتائج موثوقة ، ولكن سرعة الاستدلال البطيئة: minigpt4-13b-F16.bin

المتطلبات : Python 3.x و Pytorch.

استنساخ مستودع Minigpt-4 وأداء الإعداد

cd minigpt4

git clone https://github.com/Vision-CAIR/MiniGPT-4.git

cd MiniGPT-4

conda env create -f environment.yml

conda activate minigpt4 قم بتنزيل نقطة التفتيش المسبق في مستودع Minigpt-4 ضمن Checkpoint Aligned with Vicuna 7B أو Checkpoint Aligned with Vicuna 13B أو قم بتنزيلها من Luggingface Link لـ 7b أو 13b

تحويل الأوزان النموذج إلى تنسيق GGML

نموذج 7B

cd minigpt4

python convert.py C:pretrained_minigpt4_7b.pth --ftype=f16

نموذج 13B

cd minigpt4

python convert.py C:pretrained_minigpt4.pth --ftype=f16

نموذج 7B

python convert.py ~ /Downloads/pretrained_minigpt4_7b.pth --outtype f16نموذج 13B

python convert.py ~ /Downloads/pretrained_minigpt4.pth --outtype f16 minigpt4-7B-f16.bin أو minigpt4-13B-f16.bin يجب إنشاء

تتوفر النماذج المسبقة مسبقًا على وجه المعانقة

موصى به للحصول على نتائج موثوقة وسرعة الاستدلال اللائقة: GGML-VICUNA-13B-V0-Q5_K.BIN

المتطلبات : Python 3.x و Pytorch.

اتبع الدليل من minigpt4 للحصول على نموذج Vicuna-V0.

ثم ، clone llama.cpp

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

cmake .

cmake --build . --config Releaseتحويل النموذج إلى GGML

python convert.py < path-to-model >كمية النموذج

python quanitize < path-to-model > < output-model > Q4_1 اختبار إذا كان Minigpt4 يعمل عن طريق الاتصال بما يلي ، واستبدال minigpt4-13B-f16.bin و ggml-vicuna-13B-v0-q5_k.bin مع النماذج الخاصة بك

cd minigpt4

python minigpt4_library.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.binتثبيت متطلبات webui

pip install -r requirements.txt بعد ذلك ، قم بتشغيل webui ، واستبدال minigpt4-13B-f16.bin و ggml-vicuna-13B-v0-q5_k.bin مع النماذج الخاصة بك

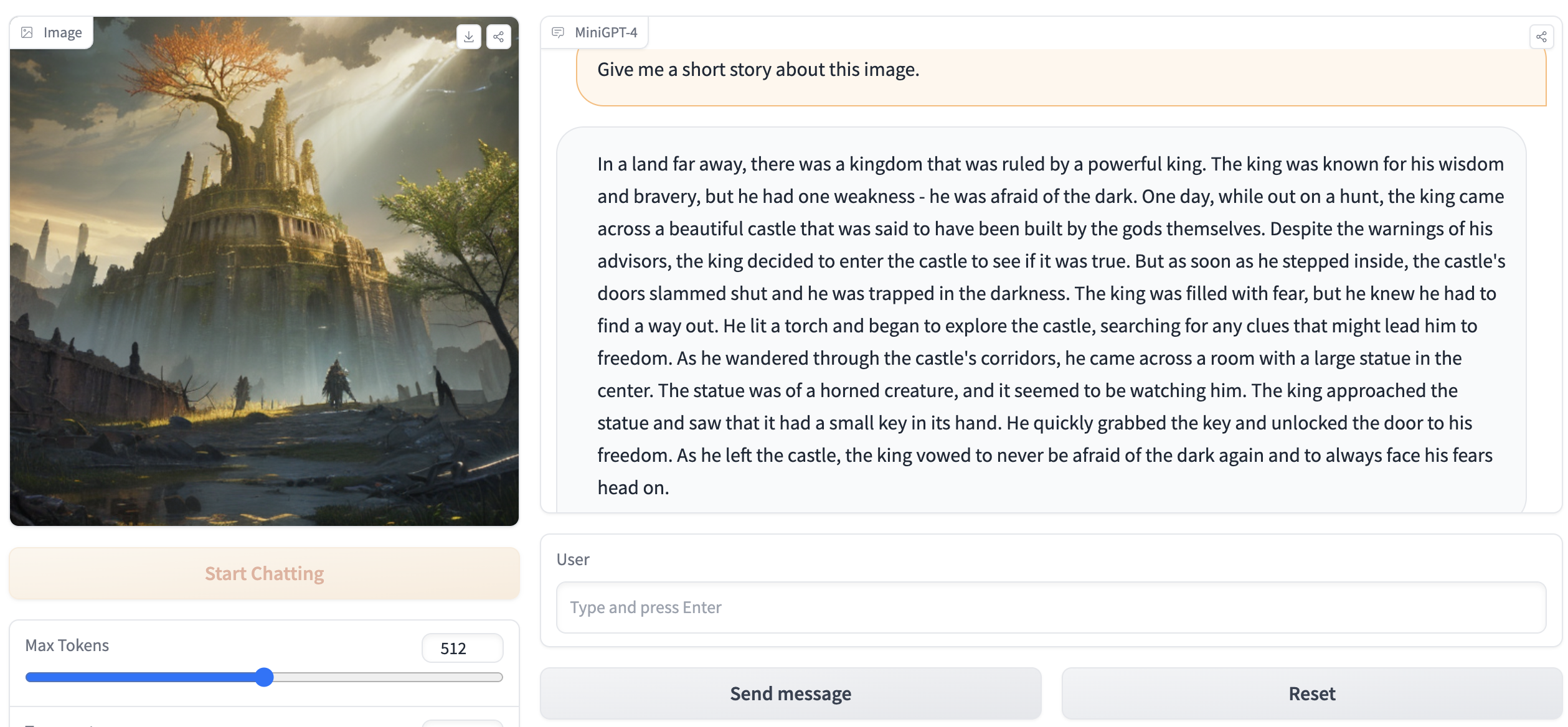

python webui.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.binيجب أن يحتوي الإخراج على شيء مثل ما يلي:

Running on local URL: http://127.0.0.1:7860

To create a public link, set ` share=True ` in `launch () ` . انتقل إلى http://127.0.0.1:7860 في متصفحك ويجب أن تكون قادرًا على التفاعل مع webui.