Kesimpulan Minigpt4 dalam C/C ++ murni.

Tujuan utama minigpt4.cpp adalah menjalankan minigpt4 menggunakan kuantisasi 4-bit dengan menggunakan pustaka GGML.

Persyaratan : git

git clone --recursive https://github.com/Maknee/minigpt4.cpp

cd minigpt4.cpp Buka rilis dan ekstrak file pustaka minigpt4 ke direktori repositori.

Persyaratan : CMake, Visual Studio dan Git

cmake .

cmake --build . --config Release

binReleaseminigpt4.dll harus dihasilkan

Persyaratan : cmake (ubuntu: sudo apt install cmake )

cmake .

cmake --build . --config Release minigpt4.so harus dihasilkan

Persyaratan : CMake (MacOS: brew install cmake )

cmake .

cmake --build . --config Release minigpt4.dylib harus dihasilkan

Catatan: Jika Anda membangun dengan OpenCV (memungkinkan fitur seperti memuat dan ON gambar di dalam pustaka itu sendiri), atur MINIGPT4_BUILD_WITH_OPENCV ke di CMakeLists.txt atau dibangun dengan -DMINIGPT4_BUILD_WITH_OPENCV=ON sebagai parameter ke cmake cli.

Model pra-kuantisasi tersedia pada wajah pelukan ~ 7b atau 13b.

Direkomendasikan untuk hasil yang dapat diandalkan, tetapi kecepatan inferensi yang lambat: minigpt4-13b-f16.bin

Persyaratan : Python 3.x dan Pytorch.

Klon Repositori Minigpt-4 dan lakukan pengaturan

cd minigpt4

git clone https://github.com/Vision-CAIR/MiniGPT-4.git

cd MiniGPT-4

conda env create -f environment.yml

conda activate minigpt4 Unduh pos pemeriksaan pretrained di repositori minigpt-4 di bawah Checkpoint Aligned with Vicuna 7B atau Checkpoint Aligned with Vicuna 13B atau unduh dari tautan huggingface untuk 7b atau 13b

Konversi bobot model menjadi format GGML

Model 7b

cd minigpt4

python convert.py C:pretrained_minigpt4_7b.pth --ftype=f16

Model 13B

cd minigpt4

python convert.py C:pretrained_minigpt4.pth --ftype=f16

Model 7b

python convert.py ~ /Downloads/pretrained_minigpt4_7b.pth --outtype f16Model 13B

python convert.py ~ /Downloads/pretrained_minigpt4.pth --outtype f16 minigpt4-7B-f16.bin atau minigpt4-13B-f16.bin harus dihasilkan

Model pra-kuantisasi tersedia untuk memeluk wajah

Direkomendasikan untuk hasil yang dapat diandalkan dan kecepatan inferensi yang layak: GGML-VICUNA-13B-V0-Q5_K.BIN

Persyaratan : Python 3.x dan Pytorch.

Ikuti panduan dari Minigpt4 untuk mendapatkan model Vicuna-V0.

Kemudian, klon llama.cpp

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

cmake .

cmake --build . --config ReleaseKonversi model ke GGML

python convert.py < path-to-model >Menghitung model

python quanitize < path-to-model > < output-model > Q4_1 Uji apakah minigpt4 berfungsi dengan menelepon yang berikut, mengganti minigpt4-13B-f16.bin dan ggml-vicuna-13B-v0-q5_k.bin dengan model masing-masing

cd minigpt4

python minigpt4_library.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.binInstal persyaratan untuk webui

pip install -r requirements.txt Kemudian, jalankan WebUI, mengganti minigpt4-13B-f16.bin dan ggml-vicuna-13B-v0-q5_k.bin dengan model masing-masing

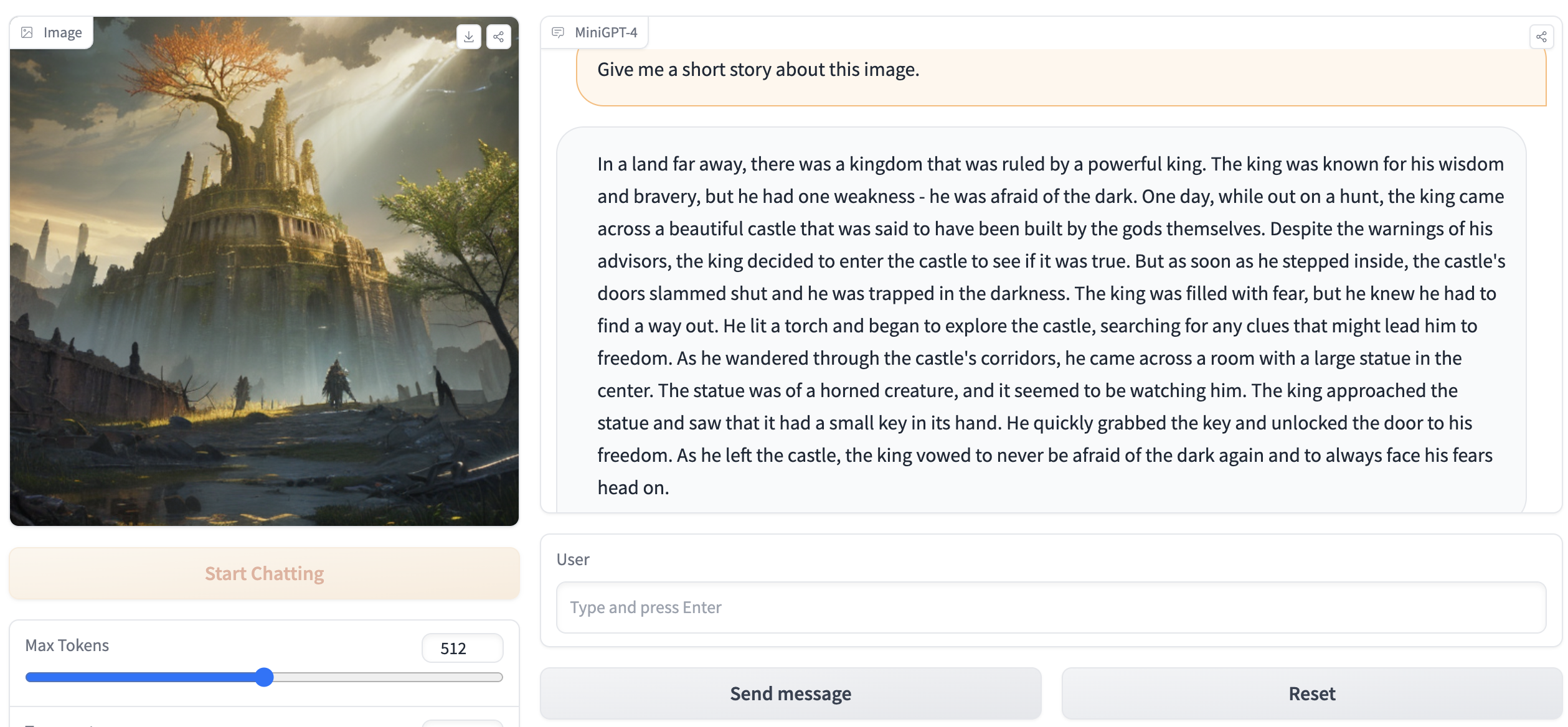

python webui.py minigpt4-13B-f16.bin ggml-vicuna-13B-v0-q5_k.binOutput harus berisi sesuatu seperti berikut:

Running on local URL: http://127.0.0.1:7860

To create a public link, set ` share=True ` in `launch () ` . Buka http://127.0.0.1:7860 di browser Anda dan Anda harus dapat berinteraksi dengan webui.