Gollama는 Ollama 모델 관리를위한 MacOS / Linux 도구입니다.

Ollama 모델을 목록, 검사, 삭제, 복사 및 추진하고 선택적으로 LM Studio*에 연결하기위한 TUI (텍스트 사용자 인터페이스)를 제공합니다.

응용 프로그램을 통해 사용자는 대화식으로 모델, 정렬, 필터, 편집, 실행, 언로드 및 핫키를 사용하여 작업을 수행 할 수 있습니다.

이 프로젝트는 Llamalink 프로젝트의 재 작성로 시작했지만 더 많은 기능을 포함시키기 위해 확장하고보다 사용자 친화적으로 만들기로 결정했습니다.

활발한 개발 중이므로 버그와 누락 된 기능이 있지만 특히 오래된 모델을 정리하는 데 매일 모델을 관리하는 데 유용합니다.

또한 LLM에 대한 포맷 된 디렉토리/코드 리포지션 전달에 대한 insest를 참조하십시오.

Gollama Intro ( "Podcast"에피소드) :

go install github.com/sammcj/gollama@HEAD업데이트가 쉽지 않지만 다음 명령을 사용할 수 있으므로이 방법을 권장하지 않습니다.

curl -sL https://raw.githubusercontent.com/sammcj/gollama/refs/heads/main/scripts/install.sh | bash릴리스 페이지에서 가장 최근의 릴리스를 다운로드하고 경로의 디렉토리로 바이너리를 추출하십시오.

예 : zip -d gollama*.zip -d gollama && mv gollama /usr/local/bin

gollama 응용 프로그램을 실행하려면 다음 명령을 사용하십시오.

gollama 팁 : 나는 빠른 액세스를 위해 gollama를 g to g 로 좋아합니다.

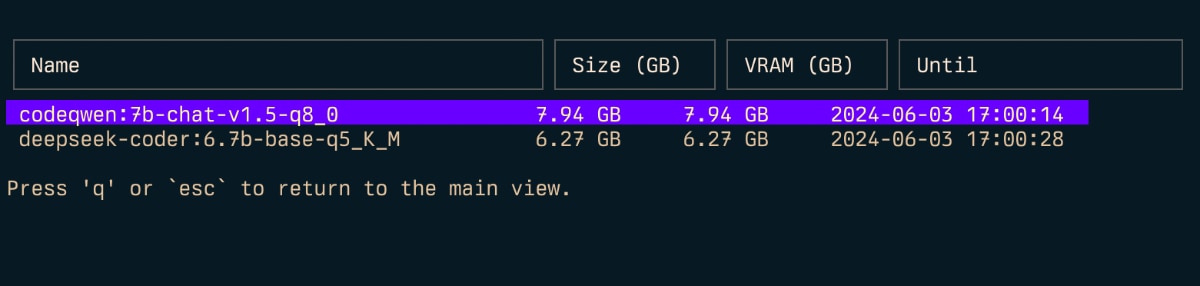

echo " alias g=gollama " >> ~ /.zshrcSpace : 선택하십시오Enter : 실행 모델 (Ollama Run)i : 모델 검사t : TOP (실행 모델 쇼)D : 모델 삭제e : 모델 편집c : 복사 모델U : 모든 모델을 언로드하십시오p : 기존 모델을 새롭게 당깁니다g : 새 모델을 당기십시오P : 푸시 모델n : 이름으로 정렬하십시오s : 크기별로 정렬하십시오m : 수정별로 정렬하십시오k : 양자화별로 정렬하십시오f : 가족별로 정렬하십시오l : LM Studio에 링크 모델L : 모든 모델을 LM 스튜디오에 연결하십시오r : 모델 이름 바꾸기 (진행중인 작업)q : 종료 상단 ( t )

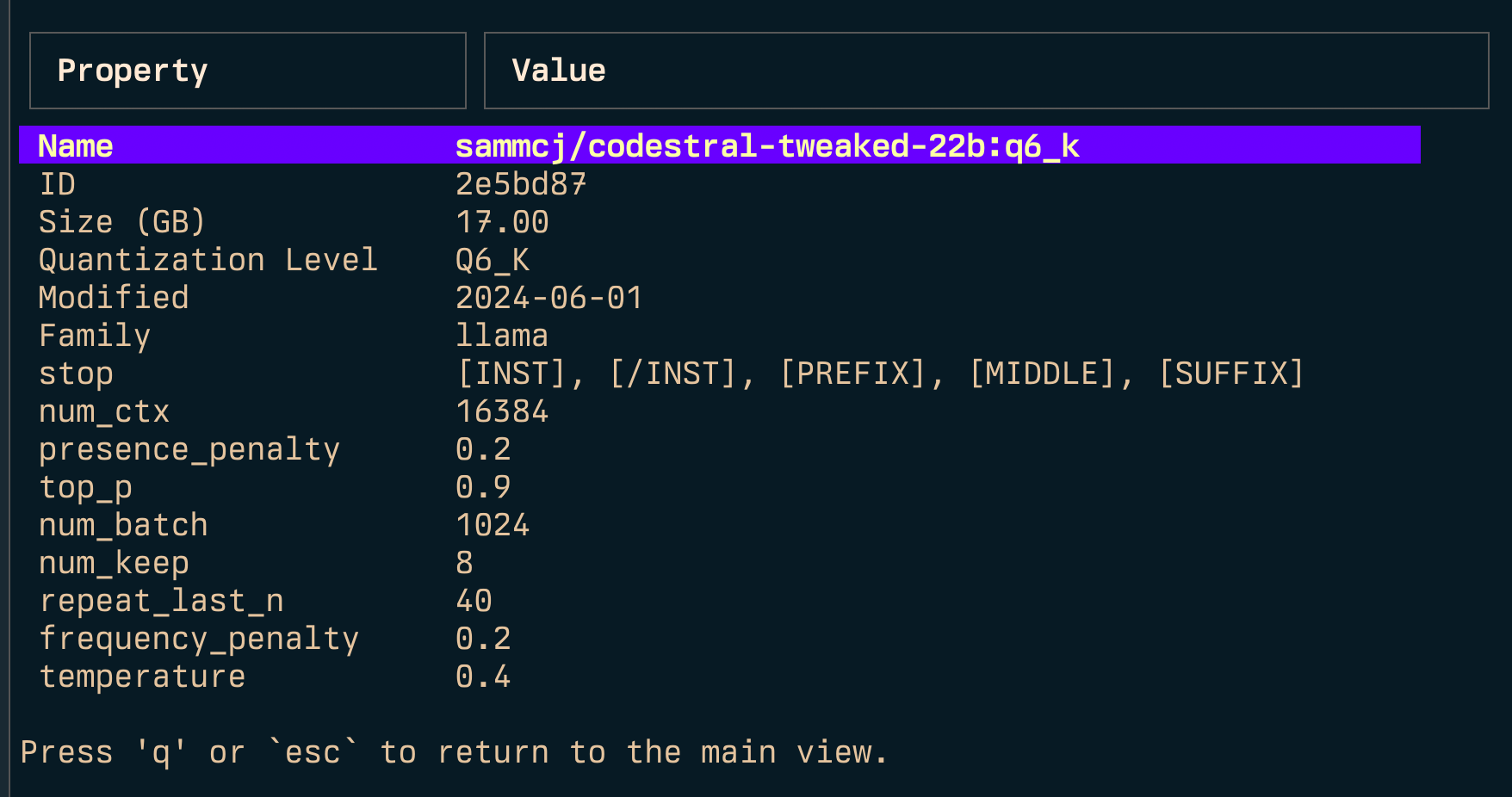

검사 ( i )

링크 ( l ) 및 링크 all ( L )

참고 : Windows를 실행하는 경우 관리자 권한이 필요합니다.

-l : 사용 가능한 모든 Ollama 모델을 나열하고 종료하십시오-L : 사용 가능한 모든 Ollama 모델을 LM Studio 및 Exit에 연결하십시오.-s <search term> : 이름 별 모델 검색'term1|term2' )라는 용어와 일치하는 모델을 반환합니다.'term1&term2' )는 두 용어와 일치하는 모델을 반환합니다.-e <model> : 모델의 modelfile 편집-ollama-dir : Custom Ollama 모델 디렉토리-lm-dir : Custom LM Studio Models 디렉토리-cleanup : 모든 Symlinked 모델과 빈 디렉토리 및 종료 제거-no-cleanup : 깨진 심볼 링크를 정리하지 마십시오-u : 실행중인 모든 모델을 언로드하십시오-v : 버전을 인쇄하고 종료하십시오-h , 또는 --host : Ollama API의 호스트를 지정합니다.-H : -h http://localhost:11434 에 대한 바로 가기--vram : 모델의 VRAM 사용량을 추정합니다. 수락 :llama3.1:8b-instruct-q6_K , qwen2:14b-q4_0 )NousResearch/Hermes-2-Theta-Llama-3-8B )--fits : 컨텍스트 계산을위한 GB의 사용 가능한 메모리 (예 : 6GB의 경우 6 )--vram-to-nth 또는 --context : 분석 할 최대 컨텍스트 길이 (예 : 32k 또는 128k )--quant : 정량화 수준의 재정의 (예 : Q4_0 , Q5_K_M ) Gollama는 Tui없이 모델을 나열하기 위해 -l 로 호출 할 수 있습니다.

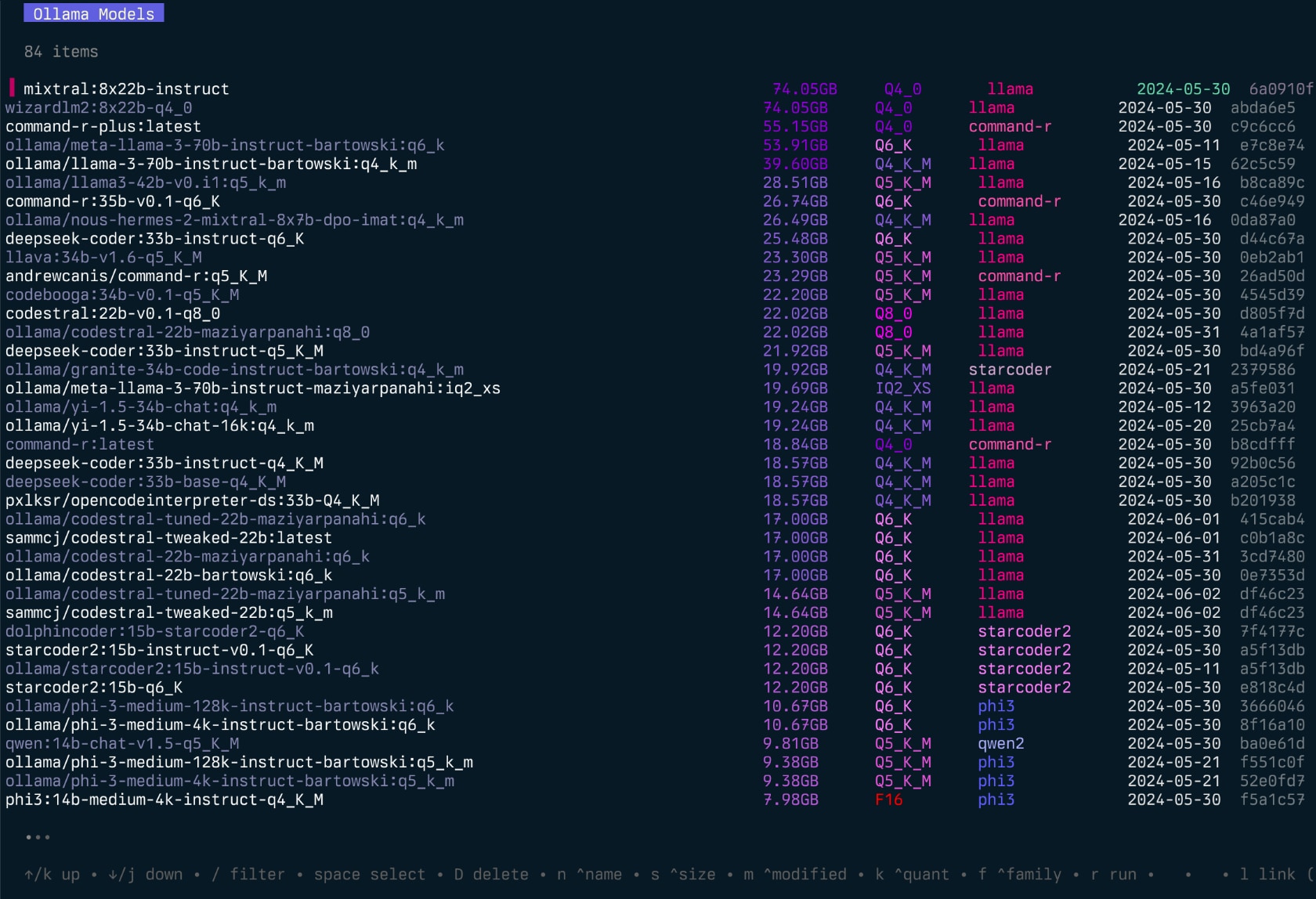

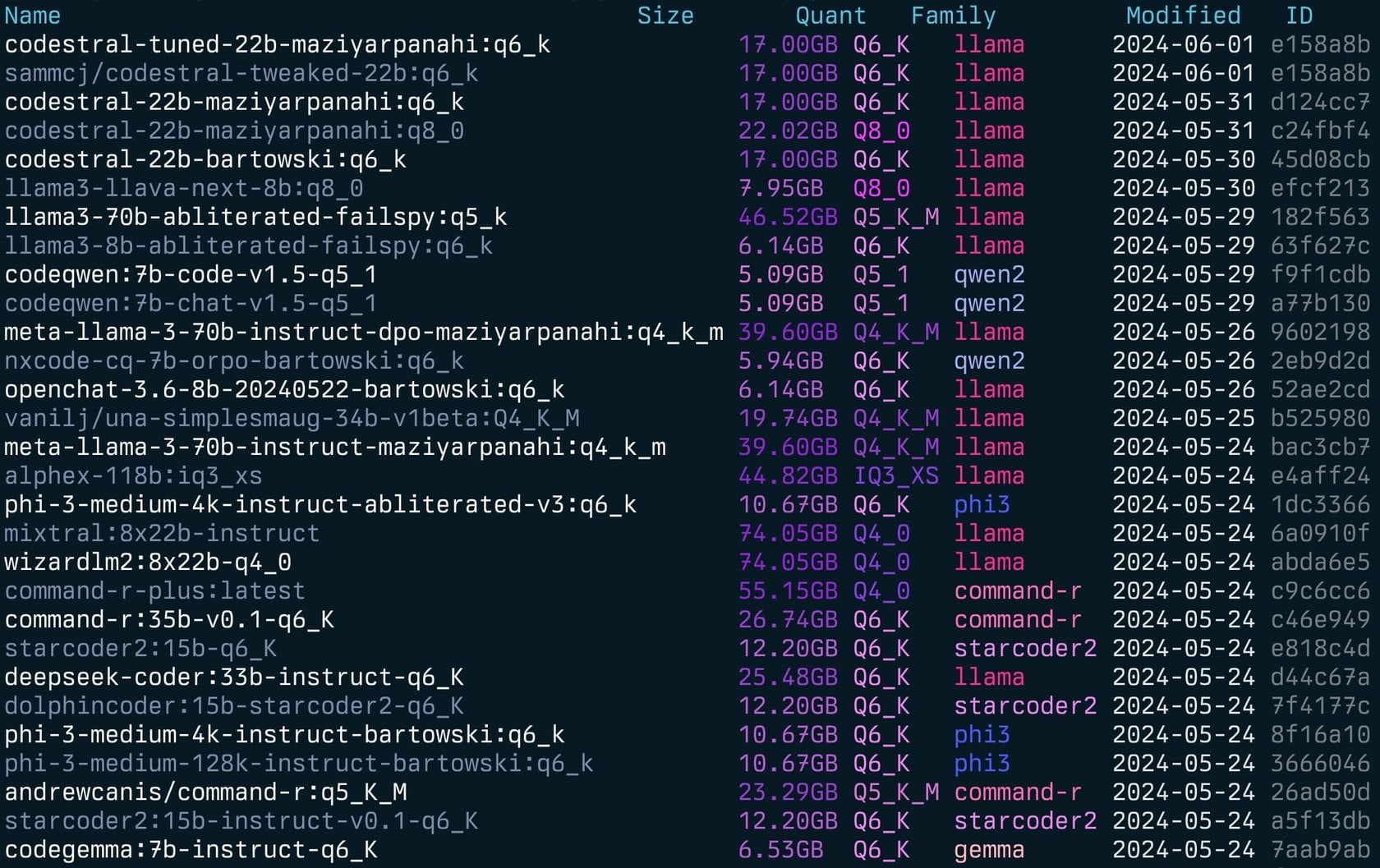

gollama -l 목록 ( gollama -l ) :

Gollama는 -e 로 호출하여 모델의 modelfile을 편집 할 수 있습니다.

gollama -e my-model Gollama는 이름으로 모델을 검색하기 위해 -s 와 함께 호출 할 수 있습니다.

gollama -s my-model # returns models that contain 'my-model'

gollama -s ' my-model|my-other-model ' # returns models that contain either 'my-model' or 'my-other-model'

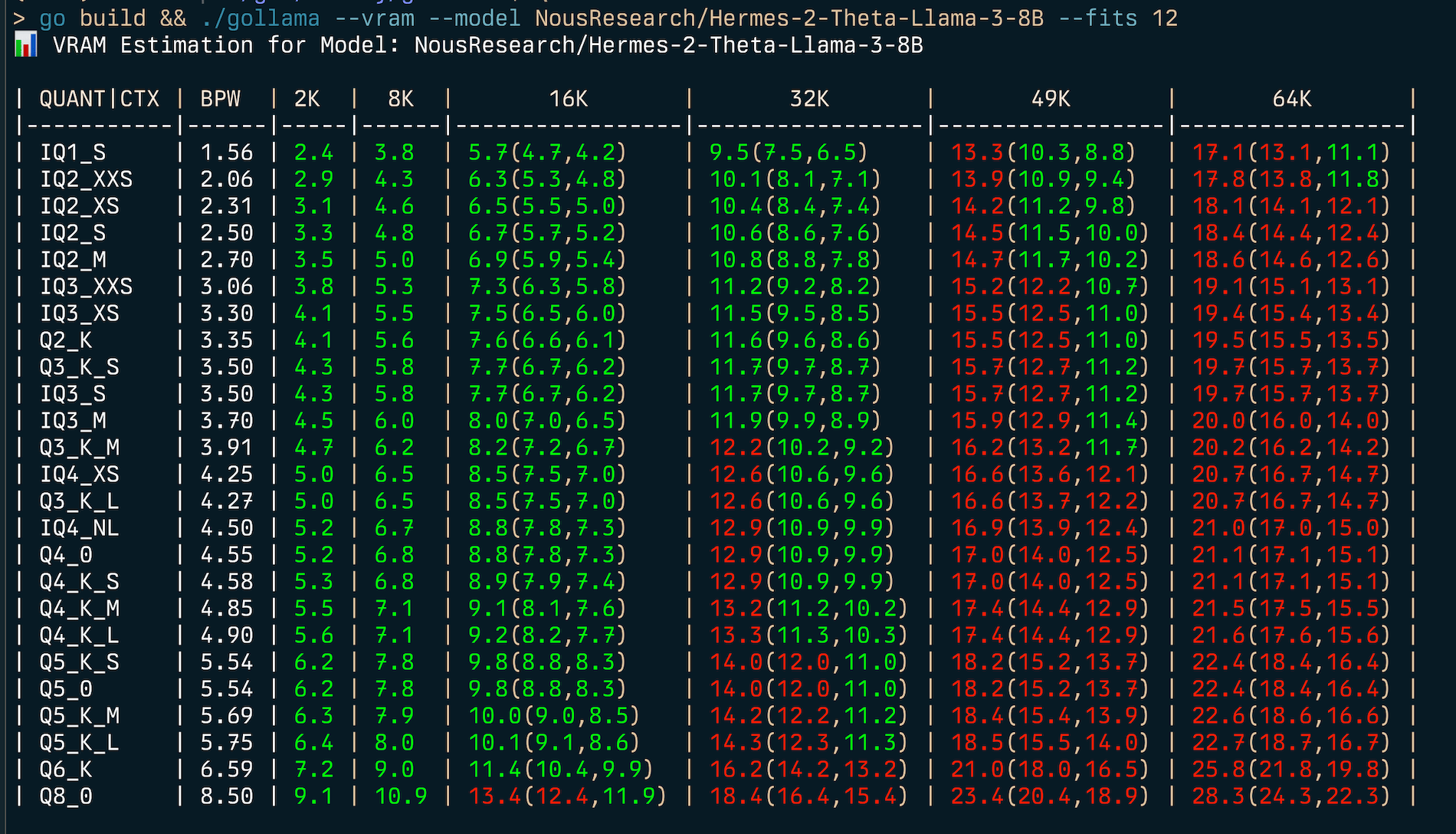

gollama -s ' my-model&instruct ' # returns models that contain both 'my-model' and 'instruct' Gollama에는 포괄적 인 VRAM 추정 기능이 포함되어 있습니다.

my-model:mytag ) 또는 Huggingface Model ID (예 : author/name )의 VRAM 사용량 계산

(v) RAM 사용을 추정하려면 :

gollama --vram llama3.1:8b-instruct-q6_K

VRAM Estimation for Model: llama3.1:8b-instruct-q6_K

| QUANT | CTX | BPW | 2K | 8K | 16K | 32K | 49K | 64K |

| ------- | ---- | --- | --- | --------------- | --------------- | --------------- | --------------- |

| IQ1_S | 1.56 | 2.2 | 2.8 | 3.7(3.7,3.7) | 5.5(5.5,5.5) | 7.3(7.3,7.3) | 9.1(9.1,9.1) |

| IQ2_XXS | 2.06 | 2.6 | 3.3 | 4.3(4.3,4.3) | 6.1(6.1,6.1) | 7.9(7.9,7.9) | 9.8(9.8,9.8) |

| IQ2_XS | 2.31 | 2.9 | 3.6 | 4.5(4.5,4.5) | 6.4(6.4,6.4) | 8.2(8.2,8.2) | 10.1(10.1,10.1) |

| IQ2_S | 2.50 | 3.1 | 3.8 | 4.7(4.7,4.7) | 6.6(6.6,6.6) | 8.5(8.5,8.5) | 10.4(10.4,10.4) |

| IQ2_M | 2.70 | 3.2 | 4.0 | 4.9(4.9,4.9) | 6.8(6.8,6.8) | 8.7(8.7,8.7) | 10.6(10.6,10.6) |

| IQ3_XXS | 3.06 | 3.6 | 4.3 | 5.3(5.3,5.3) | 7.2(7.2,7.2) | 9.2(9.2,9.2) | 11.1(11.1,11.1) |

| IQ3_XS | 3.30 | 3.8 | 4.5 | 5.5(5.5,5.5) | 7.5(7.5,7.5) | 9.5(9.5,9.5) | 11.4(11.4,11.4) |

| Q2_K | 3.35 | 3.9 | 4.6 | 5.6(5.6,5.6) | 7.6(7.6,7.6) | 9.5(9.5,9.5) | 11.5(11.5,11.5) |

| Q3_K_S | 3.50 | 4.0 | 4.8 | 5.7(5.7,5.7) | 7.7(7.7,7.7) | 9.7(9.7,9.7) | 11.7(11.7,11.7) |

| IQ3_S | 3.50 | 4.0 | 4.8 | 5.7(5.7,5.7) | 7.7(7.7,7.7) | 9.7(9.7,9.7) | 11.7(11.7,11.7) |

| IQ3_M | 3.70 | 4.2 | 5.0 | 6.0(6.0,6.0) | 8.0(8.0,8.0) | 9.9(9.9,9.9) | 12.0(12.0,12.0) |

| Q3_K_M | 3.91 | 4.4 | 5.2 | 6.2(6.2,6.2) | 8.2(8.2,8.2) | 10.2(10.2,10.2) | 12.2(12.2,12.2) |

| IQ4_XS | 4.25 | 4.7 | 5.5 | 6.5(6.5,6.5) | 8.6(8.6,8.6) | 10.6(10.6,10.6) | 12.7(12.7,12.7) |

| Q3_K_L | 4.27 | 4.7 | 5.5 | 6.5(6.5,6.5) | 8.6(8.6,8.6) | 10.7(10.7,10.7) | 12.7(12.7,12.7) |

| IQ4_NL | 4.50 | 5.0 | 5.7 | 6.8(6.8,6.8) | 8.9(8.9,8.9) | 10.9(10.9,10.9) | 13.0(13.0,13.0) |

| Q4_0 | 4.55 | 5.0 | 5.8 | 6.8(6.8,6.8) | 8.9(8.9,8.9) | 11.0(11.0,11.0) | 13.1(13.1,13.1) |

| Q4_K_S | 4.58 | 5.0 | 5.8 | 6.9(6.9,6.9) | 8.9(8.9,8.9) | 11.0(11.0,11.0) | 13.1(13.1,13.1) |

| Q4_K_M | 4.85 | 5.3 | 6.1 | 7.1(7.1,7.1) | 9.2(9.2,9.2) | 11.4(11.4,11.4) | 13.5(13.5,13.5) |

| Q4_K_L | 4.90 | 5.3 | 6.1 | 7.2(7.2,7.2) | 9.3(9.3,9.3) | 11.4(11.4,11.4) | 13.6(13.6,13.6) |

| Q5_K_S | 5.54 | 5.9 | 6.8 | 7.8(7.8,7.8) | 10.0(10.0,10.0) | 12.2(12.2,12.2) | 14.4(14.4,14.4) |

| Q5_0 | 5.54 | 5.9 | 6.8 | 7.8(7.8,7.8) | 10.0(10.0,10.0) | 12.2(12.2,12.2) | 14.4(14.4,14.4) |

| Q5_K_M | 5.69 | 6.1 | 6.9 | 8.0(8.0,8.0) | 10.2(10.2,10.2) | 12.4(12.4,12.4) | 14.6(14.6,14.6) |

| Q5_K_L | 5.75 | 6.1 | 7.0 | 8.1(8.1,8.1) | 10.3(10.3,10.3) | 12.5(12.5,12.5) | 14.7(14.7,14.7) |

| Q6_K | 6.59 | 7.0 | 8.0 | 9.4(9.4,9.4) | 12.2(12.2,12.2) | 15.0(15.0,15.0) | 17.8(17.8,17.8) |

| Q8_0 | 8.50 | 8.8 | 9.9 | 11.4(11.4,11.4) | 14.4(14.4,14.4) | 17.4(17.4,17.4) | 20.3(20.3,20.3) | 주어진 메모리 제약 조건 (예 : 6GB)에 대한 최상의 양자화 유형을 찾으려면 --fits <number of GB> :

gollama --vram NousResearch/Hermes-2-Theta-Llama-3-8B --fits 6

VRAM Estimation for Model: NousResearch/Hermes-2-Theta-Llama-3-8B

| QUANT/CTX | BPW | 2K | 8K | 16K | 32K | 49K | 64K |

| --------- | ---- | --- | --- | ------------ | ------------- | -------------- | --------------- |

| IQ1_S | 1.56 | 2.4 | 3.8 | 5.7(4.7,4.2) | 9.5(7.5,6.5) | 13.3(10.3,8.8) | 17.1(13.1,11.1) |

| IQ2_XXS | 2.06 | 2.9 | 4.3 | 6.3(5.3,4.8) | 10.1(8.1,7.1) | 13.9(10.9,9.4) | 17.8(13.8,11.8) |

...여기에는 다양한 양자화 유형 및 컨텍스트 크기에 대한 VRAM 사용을 보여주는 테이블이 표시됩니다.

VRAM 추정기는 다음과 같이 작동합니다.

참고 : 추정기는 가능한 경우 Cuda VRAM을 사용하려고 시도합니다. 그렇지 않으면 계산을 위해 System RAM으로 돌아갑니다.

Gollama는 ~/.config/gollama/config.json 에 위치한 JSON 구성 파일을 사용합니다. 구성 파일에는 정렬, 열, API 키, 로그 레벨 등을위한 옵션이 포함되어 있습니다.

예제 구성 :

{

"default_sort" : " modified " ,

"columns" : [

" Name " ,

" Size " ,

" Quant " ,

" Family " ,

" Modified " ,

" ID "

],

"ollama_api_key" : " " ,

"ollama_api_url" : " http://localhost:11434 " ,

"lm_studio_file_paths" : " " ,

"log_level" : " info " ,

"log_file_path" : " /Users/username/.config/gollama/gollama.log " ,

"sort_order" : " Size " ,

"strip_string" : " my-private-registry.internal/ " ,

"editor" : " " ,

"docker_container" : " "

}strip_string TUI에 표시 될 때 모델 이름에서 접두사를 제거하는 데 사용될 수 있습니다. 디스플레이 목적으로 제거하려는 개인 레지스트리와 같은 일반적인 접두사가있는 경우 유용 할 수 있습니다.docker_container 실험 - 세트하면 Gollama는 지정된 컨테이너 내에서 실행 작업을 수행하려고 시도합니다.editor - 실험 - 세트 인 경우 Gollama는이 편집기를 사용하여 편집을 위해 modelfile을 엽니 다. 저장소 복제 :

git clone https://github.com/sammcj/gollama.git

cd gollama짓다:

go get

make build달리다:

./gollama 로그는 기본적으로 $HOME/.config/gollama/gollama.log 에 저장된 gollama.log 에서 찾을 수 있습니다. 로그 레벨은 구성 파일로 설정할 수 있습니다.

기부금을 환영합니다! 저장소를 포크하고 변경 사항으로 풀 요청을 작성하십시오.

샘 | 호세 알 마라즈 | 호세 로베르토 알마 라즈 | Oleksii filonenko | 사우스 늑대 | Anrgct |

Matt Williams, Fahd Mirza 및 AI Code King과 같은 사람들 에게이 기회를 제공하고 피드백을 제공해 주셔서 감사합니다.

저작권 © 2024 Sam McLeod

이 프로젝트는 MIT 라이센스에 따라 라이센스가 부여됩니다. 자세한 내용은 라이센스 파일을 참조하십시오.

<script src = "http://api.html5media.info/1.1.8/html5media.min.js"> </script>