Gollama adalah alat MacOS / Linux untuk mengelola model Ollama.

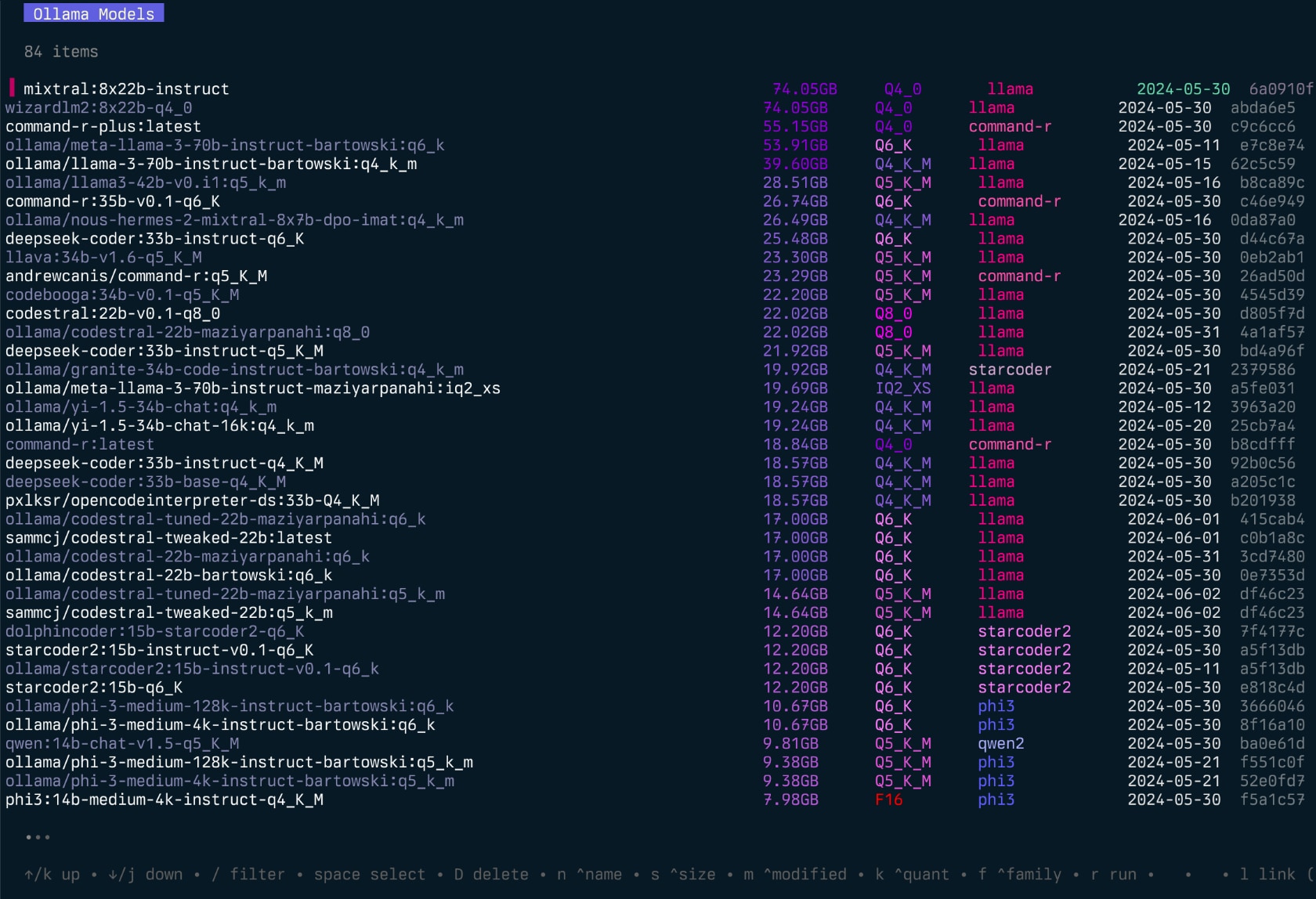

Ini menyediakan TUI (antarmuka pengguna teks) untuk mendaftar, memeriksa, menghapus, menyalin, dan mendorong model ollama serta secara opsional menghubungkannya ke LM Studio*.

Aplikasi ini memungkinkan pengguna untuk secara interaktif memilih model, menyortir, memfilter, mengedit, menjalankan, membongkar, dan melakukan tindakan pada mereka menggunakan hotkeys.

Proyek ini dimulai sebagai penulisan ulang proyek Llamalink saya, tetapi saya memutuskan untuk memperluasnya untuk memasukkan lebih banyak fitur dan membuatnya lebih ramah pengguna.

Ini dalam pengembangan aktif, jadi ada beberapa bug dan fitur yang hilang, namun saya merasa berguna untuk mengelola model saya setiap hari, terutama untuk membersihkan model lama.

Lihat juga - Ingest untuk melewati direktori/repo kode ke penurunan harga yang diformat untuk LLMS.

Gollama Intro (episode "Podcast"):

go install github.com/sammcj/gollama@HEADSaya tidak merekomendasikan metode ini karena tidak mudah diperbarui, tetapi Anda dapat menggunakan perintah berikut:

curl -sL https://raw.githubusercontent.com/sammcj/gollama/refs/heads/main/scripts/install.sh | bashUnduh rilis terbaru dari halaman rilis dan ekstrak biner ke direktori di jalur Anda.

misalnya zip -d gollama*.zip -d gollama && mv gollama /usr/local/bin

Untuk menjalankan aplikasi gollama , gunakan perintah berikut:

gollama Kiat : Saya suka alias Gollama ke g untuk akses cepat:

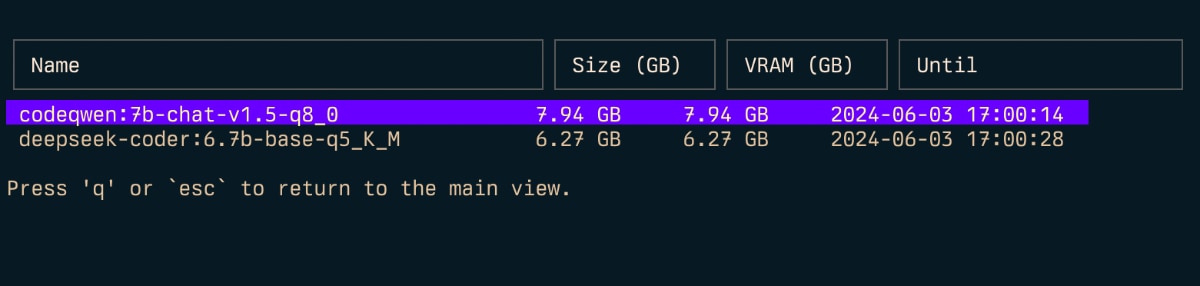

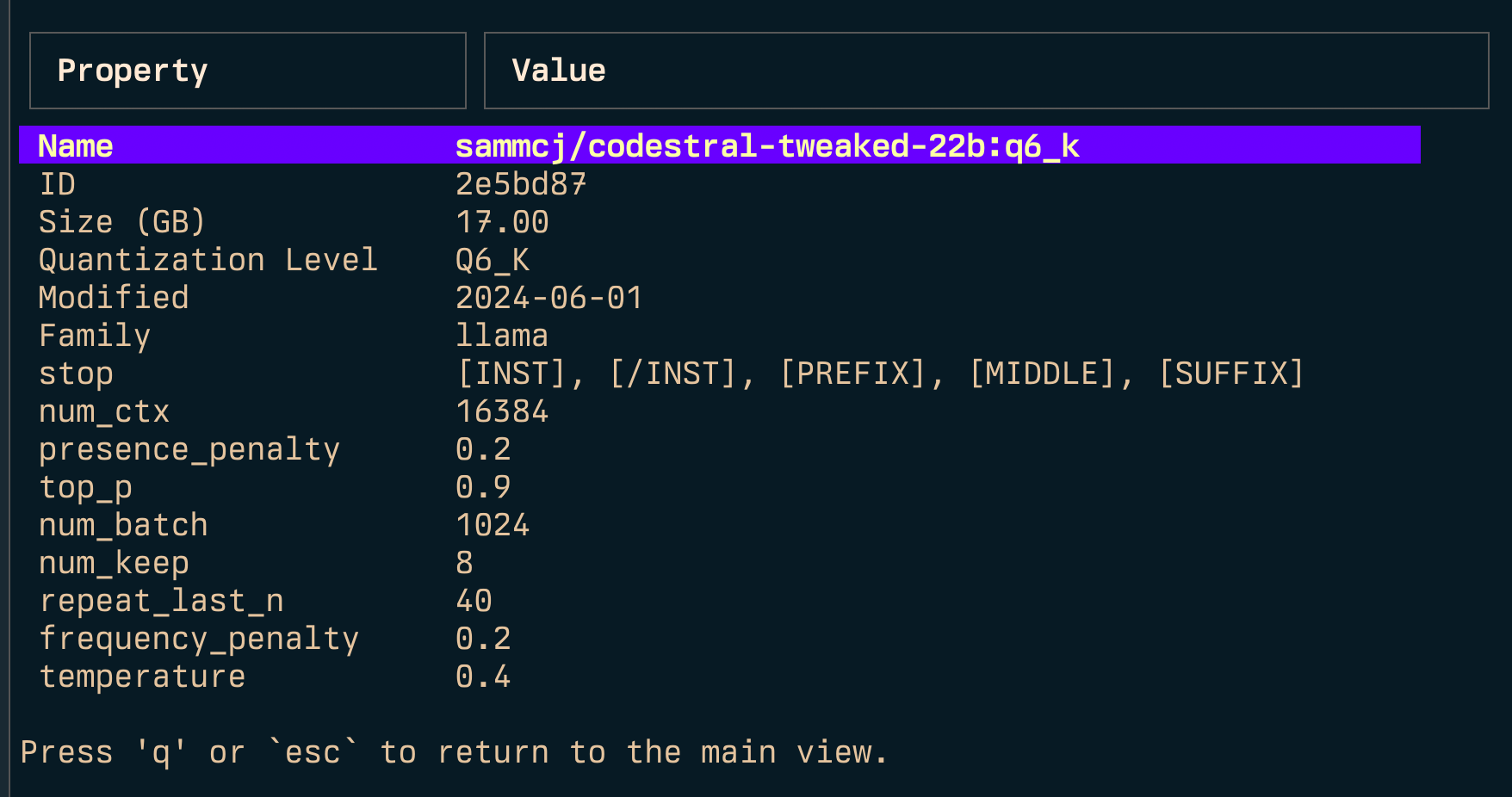

echo " alias g=gollama " >> ~ /.zshrcSpace : PilihEnter : Run Model (Ollama Run)i : Model Periksat : Top (Tampilkan Model Berjalan)D : Hapus modele : Edit Model Baruc : Salin ModelU : Bongkar semua modelp : Tarik model baru yang adag : Tarik (dapatkan) model baru baruP : Model Pushn : urutkan berdasarkan namas : urutkan berdasarkan ukuranm : urutkan dengan dimodifikasik : Urutkan berdasarkan kuantisasif : Sortir berdasarkan keluargal : Model tautan ke LM StudioL : Tautan semua model ke LM Studior : Ganti nama model (pekerjaan sedang berlangsung)q : Berhenti Atas ( t )

Periksa ( i )

Tautan ( l ) dan tautan semua ( L )

Catatan: Membutuhkan hak istimewa admin jika Anda menjalankan Windows.

-l : Daftar semua model ollama yang tersedia dan keluar-L : Tautan semua model Ollama yang tersedia ke LM Studio dan Exit-s <search term> : Cari model berdasarkan nama'term1|term2' ) mengembalikan model yang cocok dengan istilah mana pun'term1&term2' ) mengembalikan model yang cocok dengan kedua istilah-e <model> : Edit Modelfile untuk Model-ollama-dir : direktori model ollama khusus-lm-dir : Direktori Model LM Studio Kustom-cleanup : Hapus semua model symlink dan direktori kosong dan keluar-no-cleanup : jangan membersihkan symlink yang rusak-u : Bongkar semua model yang berjalan-v : Cetak versi dan keluar-h , atau --host : Tentukan host untuk API Ollama-H : Pintasan untuk -h http://localhost:11434 (terhubung ke ollama local ollama) baru--vram : Perkirakan penggunaan VRAM untuk suatu model. Menerima:qwen2:14b-q4_0 mis llama3.1:8b-instruct-q6_KNousResearch/Hermes-2-Theta-Llama-3-8B )--fits : Memori yang tersedia dalam GB untuk perhitungan konteks (misalnya 6 untuk 6GB)--vram-to-nth atau --context : Panjang konteks maksimum untuk dianalisis (mis. 32k atau 128k )--quant : Override Quantisation Level (misalnya Q4_0 , Q5_K_M ) Gollama juga dapat dipanggil dengan -l untuk mendaftar model tanpa TUI.

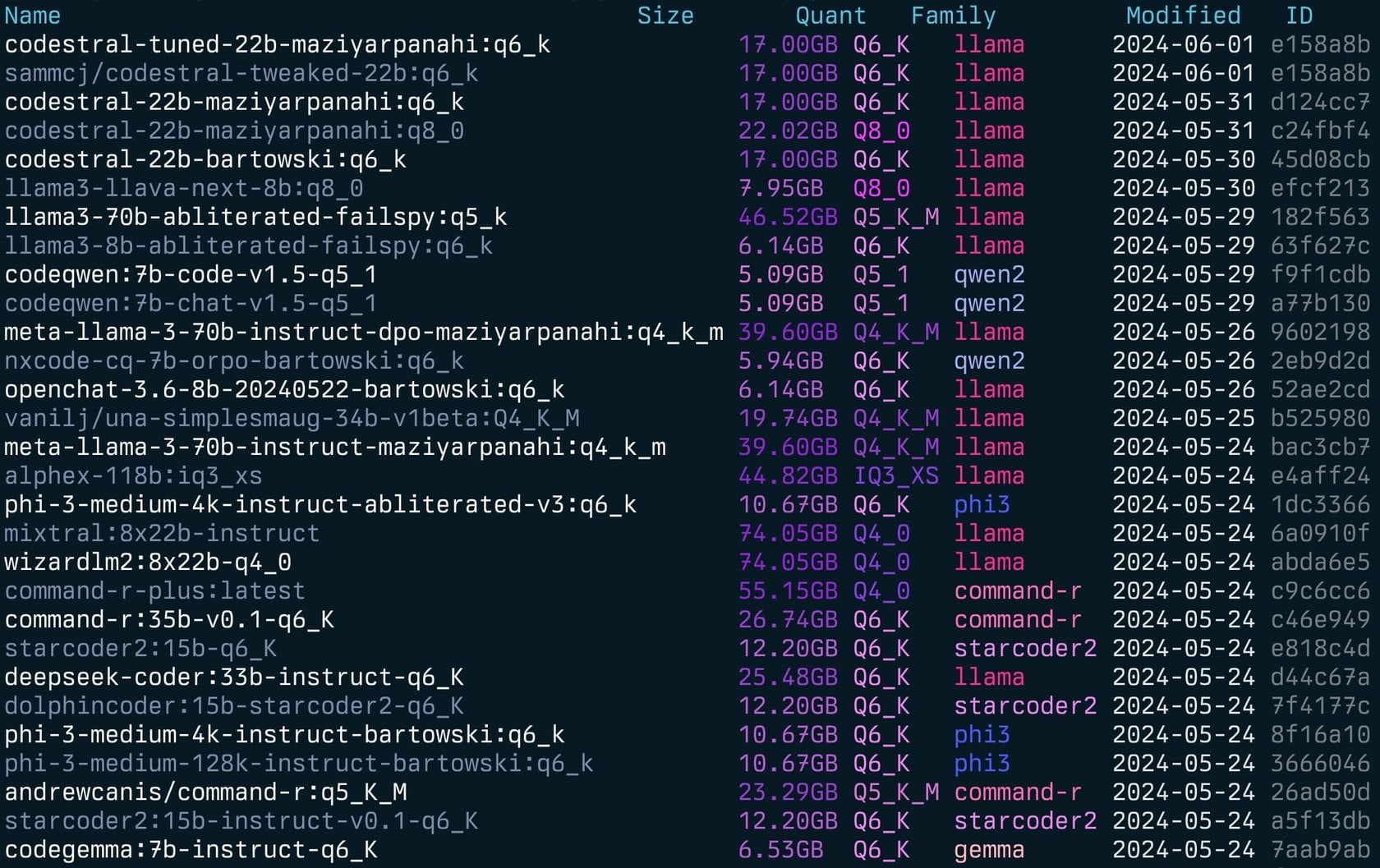

gollama -l Daftar ( gollama -l ):

Gollama dapat dipanggil dengan -e untuk mengedit modelfil untuk model.

gollama -e my-model Gollama dapat dipanggil dengan -s untuk mencari model dengan nama.

gollama -s my-model # returns models that contain 'my-model'

gollama -s ' my-model|my-other-model ' # returns models that contain either 'my-model' or 'my-other-model'

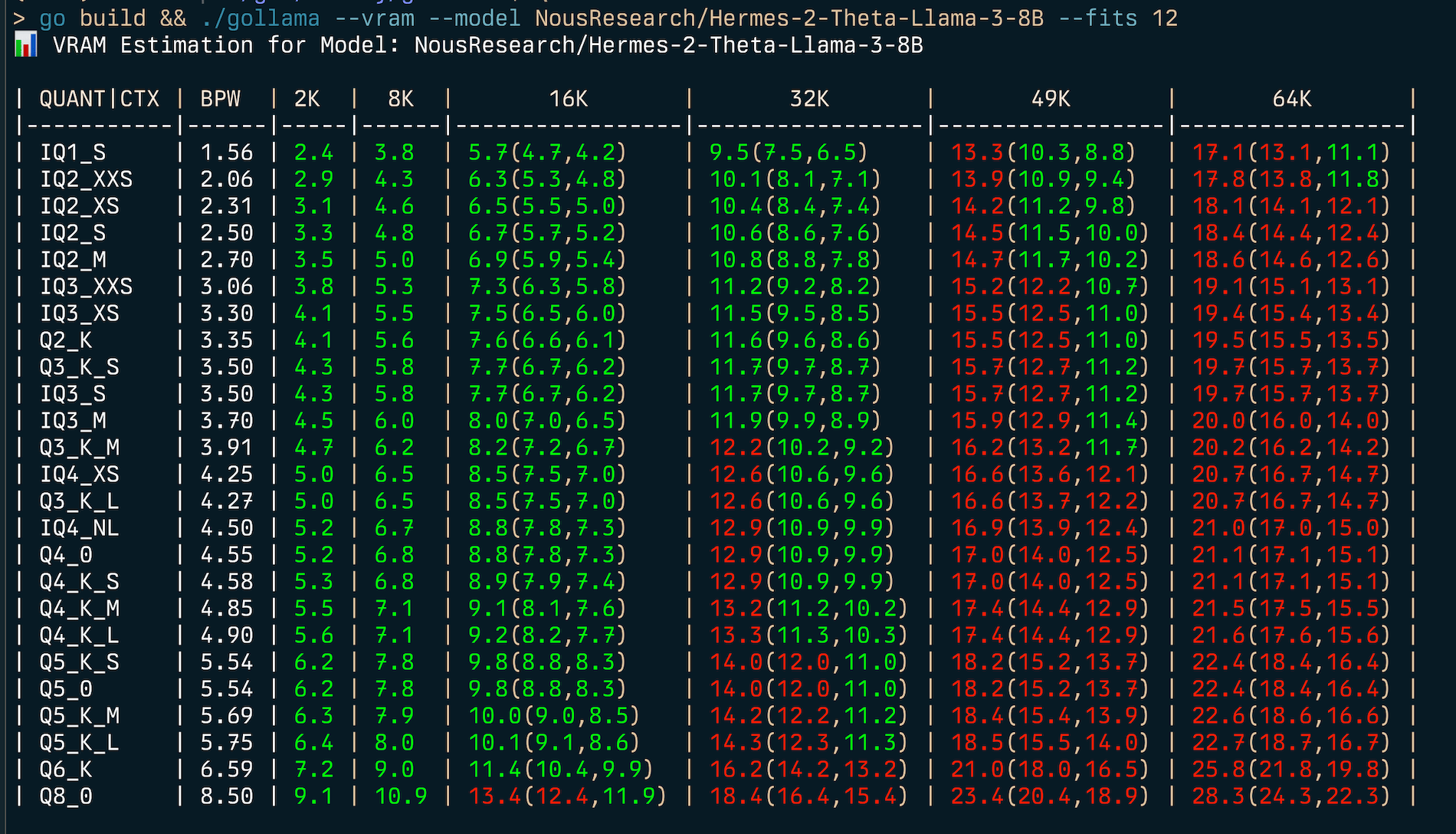

gollama -s ' my-model&instruct ' # returns models that contain both 'my-model' and 'instruct' Gollama termasuk fitur estimasi VRAM yang komprehensif:

my-model:mytag ), atau ID Model Huggingface (misalnya author/name )

Untuk memperkirakan penggunaan RAM (v):

gollama --vram llama3.1:8b-instruct-q6_K

VRAM Estimation for Model: llama3.1:8b-instruct-q6_K

| QUANT | CTX | BPW | 2K | 8K | 16K | 32K | 49K | 64K |

| ------- | ---- | --- | --- | --------------- | --------------- | --------------- | --------------- |

| IQ1_S | 1.56 | 2.2 | 2.8 | 3.7(3.7,3.7) | 5.5(5.5,5.5) | 7.3(7.3,7.3) | 9.1(9.1,9.1) |

| IQ2_XXS | 2.06 | 2.6 | 3.3 | 4.3(4.3,4.3) | 6.1(6.1,6.1) | 7.9(7.9,7.9) | 9.8(9.8,9.8) |

| IQ2_XS | 2.31 | 2.9 | 3.6 | 4.5(4.5,4.5) | 6.4(6.4,6.4) | 8.2(8.2,8.2) | 10.1(10.1,10.1) |

| IQ2_S | 2.50 | 3.1 | 3.8 | 4.7(4.7,4.7) | 6.6(6.6,6.6) | 8.5(8.5,8.5) | 10.4(10.4,10.4) |

| IQ2_M | 2.70 | 3.2 | 4.0 | 4.9(4.9,4.9) | 6.8(6.8,6.8) | 8.7(8.7,8.7) | 10.6(10.6,10.6) |

| IQ3_XXS | 3.06 | 3.6 | 4.3 | 5.3(5.3,5.3) | 7.2(7.2,7.2) | 9.2(9.2,9.2) | 11.1(11.1,11.1) |

| IQ3_XS | 3.30 | 3.8 | 4.5 | 5.5(5.5,5.5) | 7.5(7.5,7.5) | 9.5(9.5,9.5) | 11.4(11.4,11.4) |

| Q2_K | 3.35 | 3.9 | 4.6 | 5.6(5.6,5.6) | 7.6(7.6,7.6) | 9.5(9.5,9.5) | 11.5(11.5,11.5) |

| Q3_K_S | 3.50 | 4.0 | 4.8 | 5.7(5.7,5.7) | 7.7(7.7,7.7) | 9.7(9.7,9.7) | 11.7(11.7,11.7) |

| IQ3_S | 3.50 | 4.0 | 4.8 | 5.7(5.7,5.7) | 7.7(7.7,7.7) | 9.7(9.7,9.7) | 11.7(11.7,11.7) |

| IQ3_M | 3.70 | 4.2 | 5.0 | 6.0(6.0,6.0) | 8.0(8.0,8.0) | 9.9(9.9,9.9) | 12.0(12.0,12.0) |

| Q3_K_M | 3.91 | 4.4 | 5.2 | 6.2(6.2,6.2) | 8.2(8.2,8.2) | 10.2(10.2,10.2) | 12.2(12.2,12.2) |

| IQ4_XS | 4.25 | 4.7 | 5.5 | 6.5(6.5,6.5) | 8.6(8.6,8.6) | 10.6(10.6,10.6) | 12.7(12.7,12.7) |

| Q3_K_L | 4.27 | 4.7 | 5.5 | 6.5(6.5,6.5) | 8.6(8.6,8.6) | 10.7(10.7,10.7) | 12.7(12.7,12.7) |

| IQ4_NL | 4.50 | 5.0 | 5.7 | 6.8(6.8,6.8) | 8.9(8.9,8.9) | 10.9(10.9,10.9) | 13.0(13.0,13.0) |

| Q4_0 | 4.55 | 5.0 | 5.8 | 6.8(6.8,6.8) | 8.9(8.9,8.9) | 11.0(11.0,11.0) | 13.1(13.1,13.1) |

| Q4_K_S | 4.58 | 5.0 | 5.8 | 6.9(6.9,6.9) | 8.9(8.9,8.9) | 11.0(11.0,11.0) | 13.1(13.1,13.1) |

| Q4_K_M | 4.85 | 5.3 | 6.1 | 7.1(7.1,7.1) | 9.2(9.2,9.2) | 11.4(11.4,11.4) | 13.5(13.5,13.5) |

| Q4_K_L | 4.90 | 5.3 | 6.1 | 7.2(7.2,7.2) | 9.3(9.3,9.3) | 11.4(11.4,11.4) | 13.6(13.6,13.6) |

| Q5_K_S | 5.54 | 5.9 | 6.8 | 7.8(7.8,7.8) | 10.0(10.0,10.0) | 12.2(12.2,12.2) | 14.4(14.4,14.4) |

| Q5_0 | 5.54 | 5.9 | 6.8 | 7.8(7.8,7.8) | 10.0(10.0,10.0) | 12.2(12.2,12.2) | 14.4(14.4,14.4) |

| Q5_K_M | 5.69 | 6.1 | 6.9 | 8.0(8.0,8.0) | 10.2(10.2,10.2) | 12.4(12.4,12.4) | 14.6(14.6,14.6) |

| Q5_K_L | 5.75 | 6.1 | 7.0 | 8.1(8.1,8.1) | 10.3(10.3,10.3) | 12.5(12.5,12.5) | 14.7(14.7,14.7) |

| Q6_K | 6.59 | 7.0 | 8.0 | 9.4(9.4,9.4) | 12.2(12.2,12.2) | 15.0(15.0,15.0) | 17.8(17.8,17.8) |

| Q8_0 | 8.50 | 8.8 | 9.9 | 11.4(11.4,11.4) | 14.4(14.4,14.4) | 17.4(17.4,17.4) | 20.3(20.3,20.3) | Untuk menemukan tipe kuantisasi terbaik untuk kendala memori yang diberikan (misalnya 6GB) Anda dapat memberikan --fits <number of GB> :

gollama --vram NousResearch/Hermes-2-Theta-Llama-3-8B --fits 6

VRAM Estimation for Model: NousResearch/Hermes-2-Theta-Llama-3-8B

| QUANT/CTX | BPW | 2K | 8K | 16K | 32K | 49K | 64K |

| --------- | ---- | --- | --- | ------------ | ------------- | -------------- | --------------- |

| IQ1_S | 1.56 | 2.4 | 3.8 | 5.7(4.7,4.2) | 9.5(7.5,6.5) | 13.3(10.3,8.8) | 17.1(13.1,11.1) |

| IQ2_XXS | 2.06 | 2.9 | 4.3 | 6.3(5.3,4.8) | 10.1(8.1,7.1) | 13.9(10.9,9.4) | 17.8(13.8,11.8) |

...Ini akan menampilkan tabel yang menunjukkan penggunaan VRAM untuk berbagai jenis kuantisasi dan ukuran konteks.

Estimator VRAM bekerja dengan:

CATATAN: Estimator akan mencoba menggunakan CUDA VRAM jika tersedia, jika tidak, ia akan kembali ke RAM sistem untuk perhitungan.

Gollama menggunakan file konfigurasi JSON yang terletak di ~/.config/gollama/config.json . File konfigurasi mencakup opsi untuk penyortiran, kolom, tombol API, level log dll ...

Contoh konfigurasi:

{

"default_sort" : " modified " ,

"columns" : [

" Name " ,

" Size " ,

" Quant " ,

" Family " ,

" Modified " ,

" ID "

],

"ollama_api_key" : " " ,

"ollama_api_url" : " http://localhost:11434 " ,

"lm_studio_file_paths" : " " ,

"log_level" : " info " ,

"log_file_path" : " /Users/username/.config/gollama/gollama.log " ,

"sort_order" : " Size " ,

"strip_string" : " my-private-registry.internal/ " ,

"editor" : " " ,

"docker_container" : " "

}strip_string dapat digunakan untuk menghapus awalan dari nama model karena ditampilkan di TUI. Ini bisa bermanfaat jika Anda memiliki awalan umum seperti registri pribadi yang ingin Anda hapus untuk tujuan tampilan.docker_container - Eksperimental - Jika Set, Gollama akan berusaha melakukan operasi yang dijalankan di dalam wadah yang ditentukan.editor - Eksperimental - Jika Set, Gollama akan menggunakan editor ini untuk membuka Modelfile untuk diedit. Klon Repositori:

git clone https://github.com/sammcj/gollama.git

cd gollamaMembangun:

go get

make buildBerlari:

./gollama Log dapat ditemukan di gollama.log yang disimpan dalam $HOME/.config/gollama/gollama.log secara default. Level log dapat diatur dalam file konfigurasi.

Kontribusi dipersilakan! Harap bayar repositori dan buat permintaan tarik dengan perubahan Anda.

Sam | Jose Almaraz | Jose Roberto Almaraz | OLEKSII Filonenko | Southwolf | anrgct |

Terima kasih kepada orang -orang seperti Matt Williams, Fahd Mirza dan AI Code King karena telah mencobanya dan memberikan umpan balik.

Hak Cipta © 2024 Sam McLeod

Proyek ini dilisensikan di bawah lisensi MIT. Lihat file lisensi untuk detailnya.

<skrip src = "http://api.html5media.info/1.1.8/html5media.min.js"> </script>