ライブラリ|論文|スラック

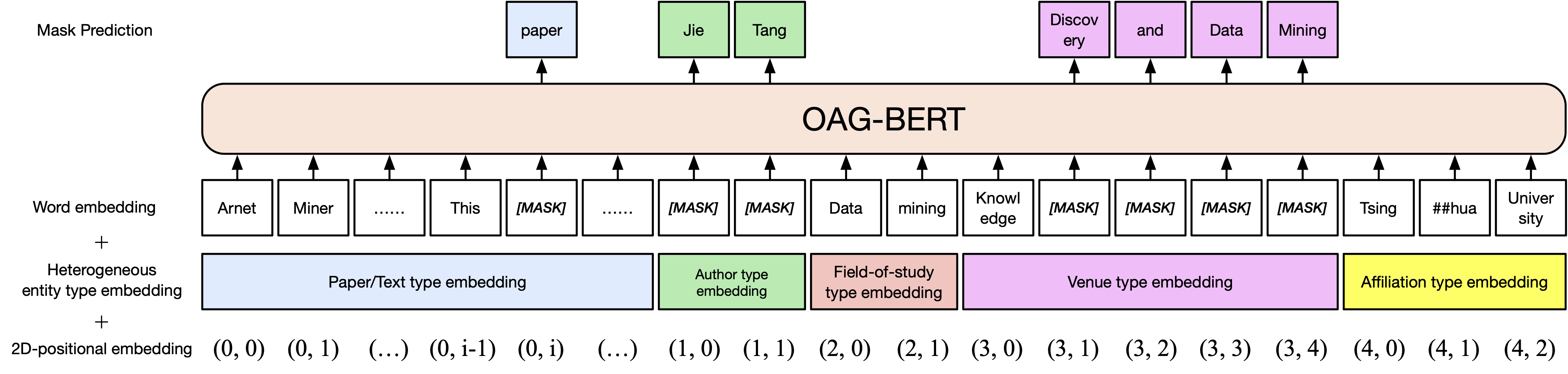

OAG-BERTの2つのバージョンをCOGDLパッケージでリリースしました(以前のTsinghua Cloud Diskダウンロードの有効期限が経過したため、ModelScopeからモデルを手動でダウンロードしてください)。 OAG-Bertは、学術的なテキストを理解するだけでなく、OAGの異質なエンティティの知識を理解するだけでなく、異種のエンティティが熟成した学問的言語モデルです。コメントやリクエストについては、SlackまたはGoogleグループに参加してください!私たちの論文はこちらです。

基本バージョンoag-bert。 Scibertと同様に、紙のタイトル、要約、ボディを含む、オープンアカデミックグラフのアカデミックテキストコーパス上のBertモデルを事前に引き出します。

Oag-Bertの使用は、通常のScibertまたはBertと同じです。たとえば、次のコードを使用して2つのテキストシーケンスをエンコードして出力を取得できます。

from cogdl . oag import oagbert

tokenizer , bert_model = oagbert ()

sequence = [ "CogDL is developed by KEG, Tsinghua." , "OAGBert is developed by KEG, Tsinghua." ]

tokens = tokenizer ( sequence , return_tensors = "pt" , padding = True )

outputs = bert_model ( ** tokens )バニラオアグバートの拡張。 AuthorsやStudyの分野などのオープンアカデミックグラフに豊富なエンティティ情報を組み込みます。したがって、OAG-Bert v2でさまざまなタイプのエンティティをエンコードできます。たとえば、Bertの論文をエンコードするには、次のコードを使用できます

from cogdl . oag import oagbert

import torch

tokenizer , model = oagbert ( "oagbert-v2" )

title = 'BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding'

abstract = 'We introduce a new language representation model called BERT, which stands for Bidirectional Encoder Representations from Transformers. Unlike recent language representation...'

authors = [ 'Jacob Devlin' , 'Ming-Wei Chang' , 'Kenton Lee' , 'Kristina Toutanova' ]

venue = 'north american chapter of the association for computational linguistics'

affiliations = [ 'Google' ]

concepts = [ 'language model' , 'natural language inference' , 'question answering' ]

# build model inputs

input_ids , input_masks , token_type_ids , masked_lm_labels , position_ids , position_ids_second , masked_positions , num_spans = model . build_inputs (

title = title , abstract = abstract , venue = venue , authors = authors , concepts = concepts , affiliations = affiliations

)

# run forward

sequence_output , pooled_output = model . bert . forward (

input_ids = torch . LongTensor ( input_ids ). unsqueeze ( 0 ),

token_type_ids = torch . LongTensor ( token_type_ids ). unsqueeze ( 0 ),

attention_mask = torch . LongTensor ( input_masks ). unsqueeze ( 0 ),

output_all_encoded_layers = False ,

checkpoint_activations = False ,

position_ids = torch . LongTensor ( position_ids ). unsqueeze ( 0 ),

position_ids_second = torch . LongTensor ( position_ids_second ). unsqueeze ( 0 )

)統合された関数を使用して、 decode_beamsearchを使用して既存のコンテキストに基づいてエンティティを生成するなど、OAG-Bert V2を直接使用することもできます。たとえば、Bert Paperの2つのトークンを使用して概念を生成するには、次のコードを実行します

model . eval ()

candidates = model . decode_beamsearch (

title = title ,

abstract = abstract ,

venue = venue ,

authors = authors ,

affiliations = affiliations ,

decode_span_type = 'FOS' ,

decode_span_length = 2 ,

beam_width = 8 ,

force_forward = False

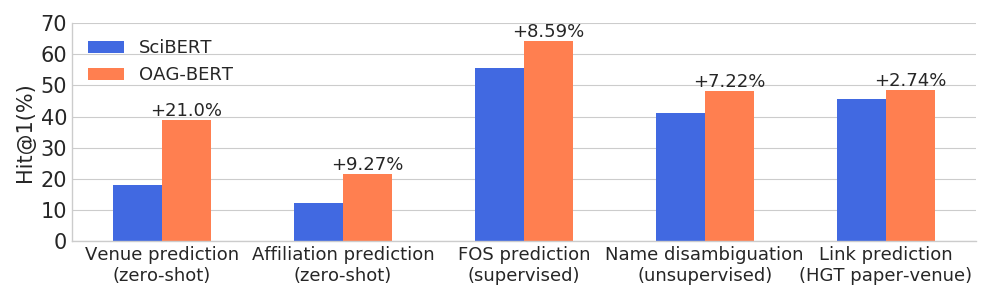

)OAG-BERTは、通常のNLPタスクでパフォーマンスを維持しながら、幅広いエンティティを意識したタスクで他の学術言語モデルを上回ります。

また、ユーザー向けに別の2つのV2バージョンをリリースします。

1つは、他の情報に基づいてテキストを生成するために使用できる世代ベースのバージョンです。たとえば、次のコードを使用して、要約を使用して用紙タイトルを自動的に生成します。

from cogdl . oag import oagbert

tokenizer , model = oagbert ( 'oagbert-v2-lm' )

model . eval ()

for seq , prob in model . generate_title ( abstract = "To enrich language models with domain knowledge is crucial but difficult. Based on the world's largest public academic graph Open Academic Graph (OAG), we pre-train an academic language model, namely OAG-BERT, which integrates massive heterogeneous entities including paper, author, concept, venue, and affiliation. To better endow OAG-BERT with the ability to capture entity information, we develop novel pre-training strategies including heterogeneous entity type embedding, entity-aware 2D positional encoding, and span-aware entity masking. For zero-shot inference, we design a special decoding strategy to allow OAG-BERT to generate entity names from scratch. We evaluate the OAG-BERT on various downstream academic tasks, including NLP benchmarks, zero-shot entity inference, heterogeneous graph link prediction, and author name disambiguation. Results demonstrate the effectiveness of the proposed pre-training approach to both comprehending academic texts and modeling knowledge from heterogeneous entities. OAG-BERT has been deployed to multiple real-world applications, such as reviewer recommendations for NSFC (National Nature Science Foundation of China) and paper tagging in the AMiner system. It is also available to the public through the CogDL package." ):

print ( 'Title: %s' % seq )

print ( 'Perplexity: %.4f' % prob )

# One of our generations: "pre-training oag-bert: an academic language model for enriching academic texts with domain knowledge"それに加えて、OAG-BERTを微調整して、名前の分解タスクに基づいて紙の類似性を計算します。以下のコードは、Sente-Oagbertを使用して紙の類似性を計算する例を示しています。

import os

from cogdl . oag import oagbert

import torch

import torch . nn . functional as F

import numpy as np

# load time

tokenizer , model = oagbert ( "oagbert-v2-sim" )

model . eval ()

# Paper 1

title = 'BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding'

abstract = 'We introduce a new language representation model called BERT, which stands for Bidirectional Encoder Representations from Transformers. Unlike recent language representation...'

authors = [ 'Jacob Devlin' , 'Ming-Wei Chang' , 'Kenton Lee' , 'Kristina Toutanova' ]

venue = 'north american chapter of the association for computational linguistics'

affiliations = [ 'Google' ]

concepts = [ 'language model' , 'natural language inference' , 'question answering' ]

# encode first paper

input_ids , input_masks , token_type_ids , masked_lm_labels , position_ids , position_ids_second , masked_positions , num_spans = model . build_inputs (

title = title , abstract = abstract , venue = venue , authors = authors , concepts = concepts , affiliations = affiliations

)

_ , paper_embed_1 = model . bert . forward (

input_ids = torch . LongTensor ( input_ids ). unsqueeze ( 0 ),

token_type_ids = torch . LongTensor ( token_type_ids ). unsqueeze ( 0 ),

attention_mask = torch . LongTensor ( input_masks ). unsqueeze ( 0 ),

output_all_encoded_layers = False ,

checkpoint_activations = False ,

position_ids = torch . LongTensor ( position_ids ). unsqueeze ( 0 ),

position_ids_second = torch . LongTensor ( position_ids_second ). unsqueeze ( 0 )

)

# Positive Paper 2

title = 'Attention Is All You Need'

abstract = 'We propose a new simple network architecture, the Transformer, based solely on attention mechanisms, dispensing with recurrence and convolutions entirely...'

authors = [ 'Ashish Vaswani' , 'Noam Shazeer' , 'Niki Parmar' , 'Jakob Uszkoreit' ]

venue = 'neural information processing systems'

affiliations = [ 'Google' ]

concepts = [ 'machine translation' , 'computation and language' , 'language model' ]

input_ids , input_masks , token_type_ids , masked_lm_labels , position_ids , position_ids_second , masked_positions , num_spans = model . build_inputs (

title = title , abstract = abstract , venue = venue , authors = authors , concepts = concepts , affiliations = affiliations

)

# encode second paper

_ , paper_embed_2 = model . bert . forward (

input_ids = torch . LongTensor ( input_ids ). unsqueeze ( 0 ),

token_type_ids = torch . LongTensor ( token_type_ids ). unsqueeze ( 0 ),

attention_mask = torch . LongTensor ( input_masks ). unsqueeze ( 0 ),

output_all_encoded_layers = False ,

checkpoint_activations = False ,

position_ids = torch . LongTensor ( position_ids ). unsqueeze ( 0 ),

position_ids_second = torch . LongTensor ( position_ids_second ). unsqueeze ( 0 )

)

# Negative Paper 3

title = "Traceability and international comparison of ultraviolet irradiance"

abstract = "NIM took part in the CIPM Key Comparison of ″Spectral Irradiance 250 to 2500 nm″. In UV and NIR wavelength, the international comparison results showed that the consistency between Chinese value and the international reference one"

authors = [ 'Jing Yu' , 'Bo Huang' , 'Jia-Lin Yu' , 'Yan-Dong Lin' , 'Cai-Hong Dai' ]

veune = 'Jiliang Xuebao/Acta Metrologica Sinica'

affiliations = [ 'Department of Electronic Engineering' ]

concept = [ 'Optical Division' ]

input_ids , input_masks , token_type_ids , masked_lm_labels , position_ids , position_ids_second , masked_positions , num_spans = model . build_inputs (

title = title , abstract = abstract , venue = venue , authors = authors , concepts = concepts , affiliations = affiliations

)

# encode thrid paper

_ , paper_embed_3 = model . bert . forward (

input_ids = torch . LongTensor ( input_ids ). unsqueeze ( 0 ),

token_type_ids = torch . LongTensor ( token_type_ids ). unsqueeze ( 0 ),

attention_mask = torch . LongTensor ( input_masks ). unsqueeze ( 0 ),

output_all_encoded_layers = False ,

checkpoint_activations = False ,

position_ids = torch . LongTensor ( position_ids ). unsqueeze ( 0 ),

position_ids_second = torch . LongTensor ( position_ids_second ). unsqueeze ( 0 )

)

# calulate text similarity

# normalize

paper_embed_1 = F . normalize ( paper_embed_1 , p = 2 , dim = 1 )

paper_embed_2 = F . normalize ( paper_embed_2 , p = 2 , dim = 1 )

paper_embed_3 = F . normalize ( paper_embed_3 , p = 2 , dim = 1 )

# cosine sim.

sim12 = torch . mm ( paper_embed_1 , paper_embed_2 . transpose ( 0 , 1 ))

sim13 = torch . mm ( paper_embed_1 , paper_embed_3 . transpose ( 0 , 1 ))

print ( sim12 , sim13 )この微調整は、曖昧さを解明するタスクという名前で行われました。同じ著者によって書かれた論文は正のペアとして扱われ、残りは陰性ペアとして扱われます。 0.4mの正のペアと1.6mの負のペアをサンプリングし、制約学習を使用してOAG-Bertを微調整します(バージョン2)。 50%のインスタンスでは、ペーパータイトルのみを使用しますが、他の50%はすべての不均一な情報を使用します。より高い値がより良い結果を示す平均相互ランクを使用してパフォーマンスを評価します。テストセットのパフォーマンスを以下に示します。

| oagbert-v2 | oagbert-v2-sim | |

|---|---|---|

| タイトル | 0.349 | 0.725 |

| タイトル+要約+著者+aff+会場 | 0.355 | 0.789 |

詳細については、cogdlの例/oagbert_metainfo.pyを参照してください。

また、中国のオアグバートを使用するよう訓練しました。このモデルは、タイトル、抽象、著者、所属、会場、キーワード、資金を含む44mの中国の紙メタデータを含むコーパスで事前に訓練されました。新しいエンティティファンドは、英語版で使用されるエンティティを超えて拡張されています。それに加えて、中国のオアグバートは、文章トークネイザーで訓練されています。これらは、英語のオアグバートと中国のオアグバートの2つの大きな違いです。

オリジナルの中国のoagbertと文のoagbertを使用する例は、例/oagbert/oagbert_metainfo_zh.pyおよび例/oagbert/oagbert_metainfo_zh_sim.pyにあります。英語の文と同様に、中国の文は、類似性を埋め込む紙の埋め込みを計算するための名前の曖昧性除去タスクで微調整されています。パフォーマンスは以下のように表示されます。ダウンストリームタスクに微調整に十分なデータがない場合は、このバージョンを直接使用することをお勧めします。

| oagbert-v2-zh | oagbert-v2-zh-sim | |

|---|---|---|

| タイトル | 0.337 | 0.619 |

| タイトル+要約 | 0.314 | 0.682 |

あなたがそれが役に立つと思うなら、あなたの仕事で私たちを引用してください:

@article{xiao2021oag,

title={OAG-BERT: Pre-train Heterogeneous Entity-augmented Academic Language Model},

author={Liu, Xiao and Yin, Da and Zhang, Xingjian and Su, Kai and Wu, Kan and Yang, Hongxia and Tang, Jie},

journal={arXiv preprint arXiv:2103.02410},

year={2021}

}

@inproceedings{zhang2019oag,

title={OAG: Toward Linking Large-scale Heterogeneous Entity Graphs.},

author={Zhang, Fanjin and Liu, Xiao and Tang, Jie and Dong, Yuxiao and Yao, Peiran and Zhang, Jie and Gu, Xiaotao and Wang, Yan and Shao, Bin and Li, Rui and Wang, Kuansan},

booktitle={Proceedings of the 25th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD’19)},

year={2019}

}

@article{chen2020conna,

title={CONNA: Addressing Name Disambiguation on The Fly},

author={Chen, Bo and Zhang, Jing and Tang, Jie and Cai, Lingfan and Wang, Zhaoyu and Zhao, Shu and Chen, Hong and Li, Cuiping},

journal={IEEE Transactions on Knowledge and Data Engineering},

year={2020},

publisher={IEEE}

}