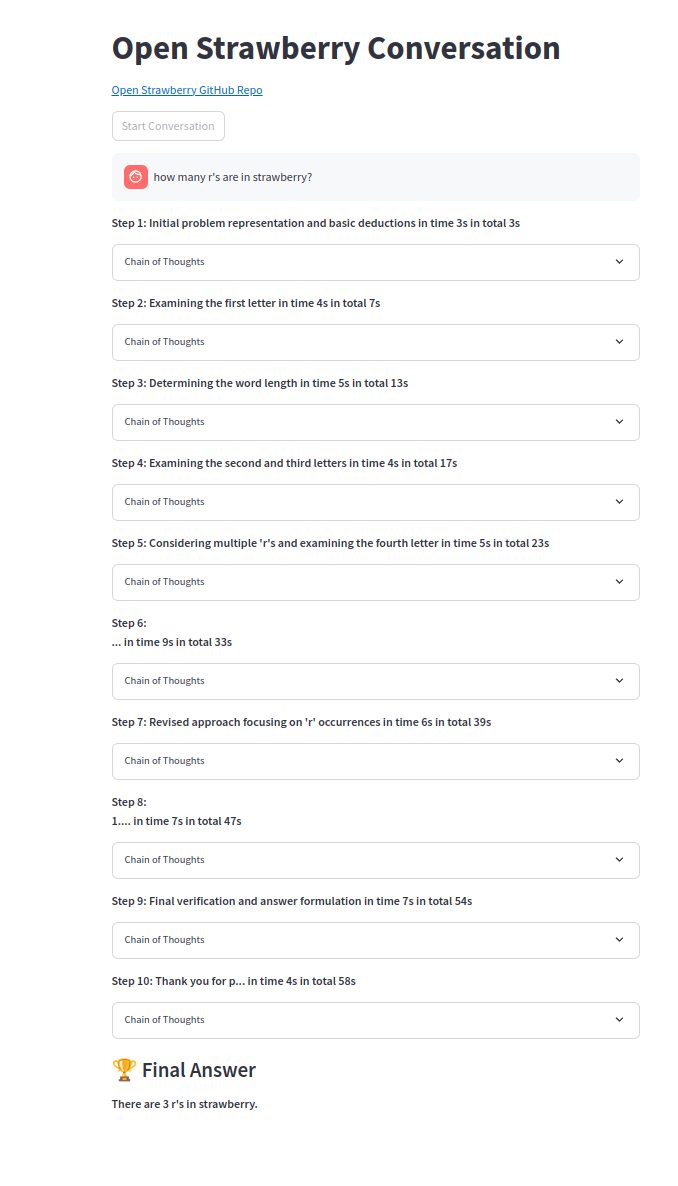

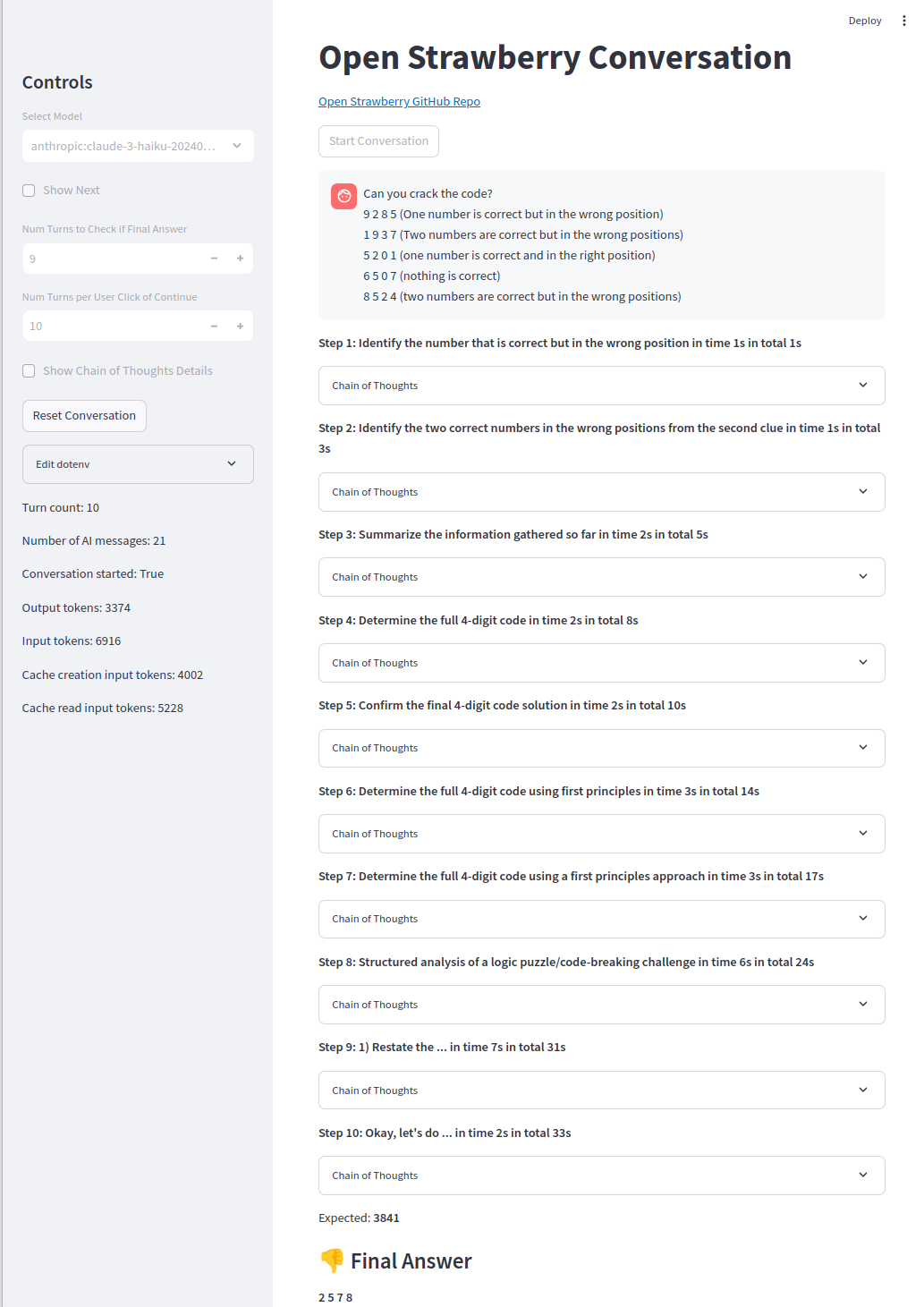

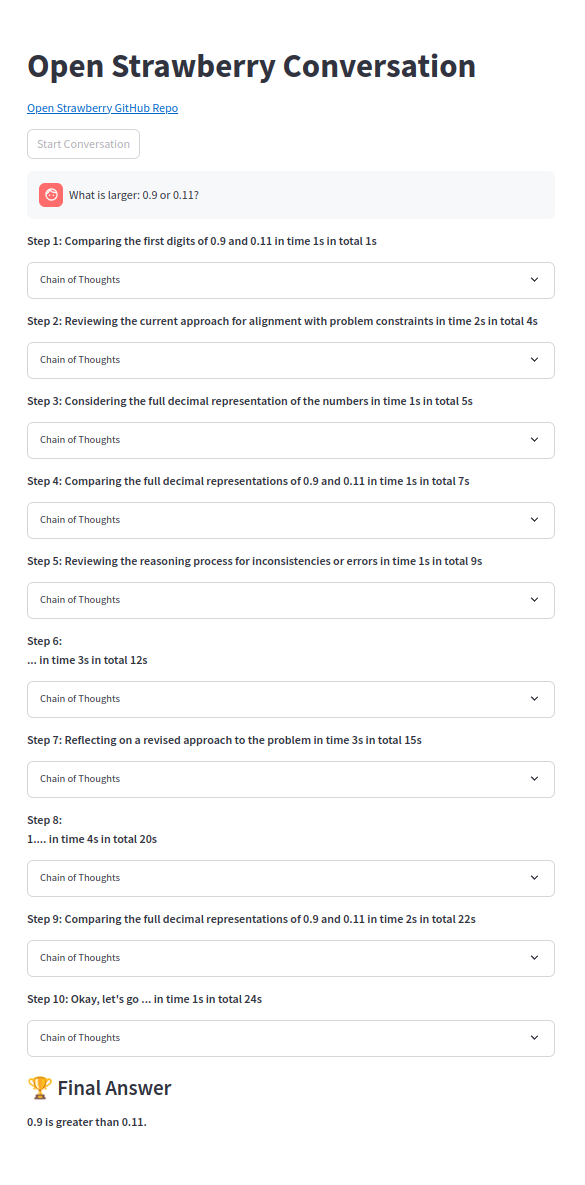

オープンのデモ - イチゴ?プロジェクト:https://huggingface.co/spaces/pseudotensor/open-strawberry

OpenaiのStrawberry Algorithmに触発されたように、Openai O1のオープンソースバージョンを構築するための推論トレースを構築するための概念の証明。

プロジェクトをサポートしたい場合は、★を(右上隅)に変えて、友達と共有してください。

貢献は大歓迎です!

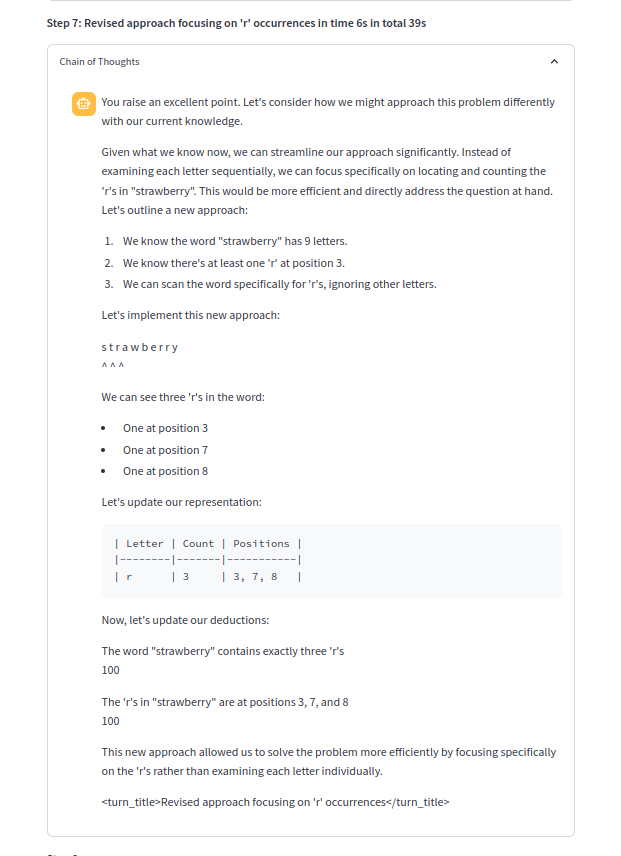

思考の鎖の1つ:

python> = 3.10は大丈夫です。

pip install -r requirements.txt必要なAPIキーなどで.envを入力するか、envsを設定します。

# OpenAI

# Can be OpenAI key or vLLM or other OpenAI proxies:

OPENAI_API_KEY =

# only require below for vLLM or other OpenAI proxies:

OPENAI_BASE_URL =

# only require below for vLLM or other OpenAI proxies:

OPENAI_MODEL_NAME =

# ollama

OLLAMA_OPENAI_API_KEY =

OLLAMA_OPENAI_BASE_URL =

# quoted list of strings or string

OLLAMA_OPENAI_MODEL_NAME =

# Azure

AZURE_OPENAI_API_KEY =

OPENAI_API_VERSION =

AZURE_OPENAI_ENDPOINT =

AZURE_OPENAI_DEPLOYMENT =

# not required

AZURE_OPENAI_MODEL_NAME =

# Anthropic prompt caching very efficient

ANTHROPIC_API_KEY =

GEMINI_API_KEY =

# groq fast and long context

GROQ_API_KEY =

# cerebras only 8k context

CEREBRAS_OPENAI_API_KEY =

# WIP: not yet used

MISTRAL_API_KEY =

HUGGING_FACE_HUB_TOKEN =

REPLICATE_API_TOKEN =

TOGETHERAI_API_TOKEN =Ollamaの場合、Openaiサービスを使用できます。

# Shut down ollama and re-run on whichever GPUs wanted:

sudo systemctl stop ollama.service

CUDA_VISIBLE_DEVICES=0 OLLAMA_HOST=0.0.0.0:11434 ollama serve & > ollama.log &

ollama run mistral:v0.3次に.env OLLAMA_OPENAI_BASE_URL=http://localhost:11434/v1/ and eg OLLAMA_OPENAI_MODEL_NAME=ollama:mistral:v0.3またはollamaモデルのリスト: OLLAMA_OPENAI_MODEL_NAME="[ollama:mistral:v0.3"]

python src/open_strawberry.py --model ollama:mistral:v0.3または、UIでモデルを選択します。

UIの使用:

export ANTHROPIC_API_KEY=your_api_key

streamlit run src/app.py次に、ブラウザをhttp:// localhost:8501に開きます(自動的にポップアップする必要があります)。

CLIの使用:

export ANTHROPIC_API_KEY=your_api_key

python src/open_strawberry.py次に、プロンプトを選択します。

このプロジェクトは、概念の証明として特定の問題の推論痕跡を生成するための初期段階にあります。

デモプロンプトはシンプルなモデルであり、Sonnet3.5およびGPT-4oも標準のCOTを使用してもソリューションを見つけることができないことに注意してください。コードエージェントであり、簡単に解決できるものの、O1-MINIまたはO1-PREVIEWのみが取得できることがあります。

Open-Strawberryは、トレーニングデータを生成および検証するための洗練された検索ジェネレーションアルゴリズムであるOpenaiのStrawberryに関する憶測に基づいています。

このプロジェクトは、オープンソースツールと方法論を使用して同様のシステムを再現することを目的としています。

ブートストラップは、プログレッシブ学習を介して重要です。

モデルが最も困難な問題を引き起こすまで、推論の痕跡と微調整のリピートは、より多くのタイプの問題として推論される範囲が消費されるようになります(ただし、必ずしも必要ではないすべてのタイプではありません)。

[P10]は、自己生成されたマルチターンデータを使用して、モデルを自己修正に向けてわずかに徐々に推進するという提案を検証する最近の論文です。

その他のプロジェクト:

このプロジェクトは初期段階にあります。結果と比較は、利用可能になると追加されます。

TODO:

難しい問題はまだ手の届かないところにあり、O1-Previewは時間の約50%しか得られません(コードエージェントは90%の時間を獲得します):

簡単な問題は確実に解決されます:

コミュニティからの貢献を歓迎します。参加方法に関するガイドラインについては、converting.mdファイルをご覧ください。

問題:

Jonathan McKinneyは、天体物理学と機械学習のバックグラウンドを持つH2O.AIの研究ディレクターです。彼の経験には以下が含まれます:

このプロジェクトは投機的であり、Openaiの仕事に関する公開されている情報に基づいています。 Openaiと提携したり、承認されたりしていません。

[1] https://openai.com/index/learning-to-reason-with-llms/

[b1] https://umdphysics.umd.edu/about-us/news/department-news/697-jon-mckinney-publishes-inscience-express.html

[b2] https://umdphysics.umd.edu/academics/courses/945-physics-420-principles-of-modern-physics.html

[B3] https://www.linkedin.com/in/jonathan-mckinney-32b0ab18/

[b4] https://scholar.google.com/citations?user=5l3lfoyaaaj&hl=en

[B5] https://h2o.ai/company/team/makers/

[b6] https://h2o.ai/platform/ai-cloud/make/h2o-driverless-ai/

[b7] https://arxiv.org/abs/2306.08161

[b8] https://github.com/h2oai/h2ogpt

[P0]チェーンオブ・考えのプロンプトは、大規模な言語モデルで推論を引き出します:https://arxiv.org/abs/2201.11903

[P1]星:推論を伴うブートストラップの推論:https://arxiv.org/abs/2203.14465

[P2]段階的に検証しましょう:https://arxiv.org/abs/2305.20050

[P3]静かな星:言語モデルは、話す前に考えるように自分自身を教えることができます:https://arxiv.org/abs/2403.09629

[P4]話す前に考えてみてください:トークンを使用した言語モデルのトレーニング:https://arxiv.org/abs/2310.0226

[P5]人間のフィードバックから学習:https://arxiv.org/abs/2312.00886

[P6] LLMテスト時間のスケーリング最適なスケーリングモデルパラメーターhttps://arxiv.org/abs/2408.03314よりも効果的です

[P7] REAPによるLLM問題解決の強化:反射、明示的な問題解体、および高度なプロンプトhttps://arxiv.org/abs/2409.09415

[P8]エージェントQ:自律AIエージェントhttps://arxiv.org/abs//2408.07199の高度な推論と学習

[P9]ボードゲームhttps://arxiv.org/abs/2104.03113を使用したスケーリング法則のスケーリング法

[P10]強化学習を介して自己修正するための言語モデルのトレーニングhttps://arxiv.org/abs/2409.12917

関連プロジェクト:

<thinking>とは異なるトークンを見ているだけで、今では<reasoning>です。リソース:

関連ビデオ: