هل تريد الحصول على نموذج أفضل بميزانيات محدودة؟ أنت في المكان المناسب

pip install text-denoising

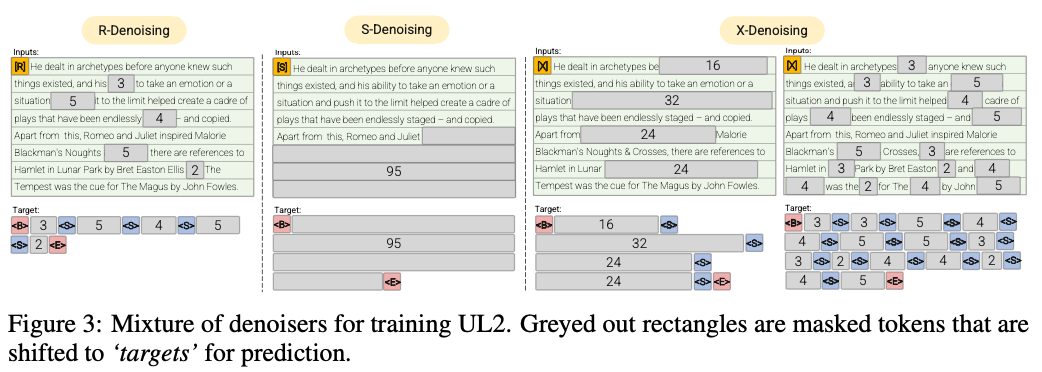

r-denoiser (μ = 3 ، r = 0.15 ، n) ∪ (μ = 8 ، r = 0.15 ، n)

تقليل القوى المعتاد هو فساد الممتدة القياسية التي تم تقديمها في Raffel et al. (2019) يستخدم مجموعة من 2 إلى 5 رموز كطول الممتدة ، والذي يخفف حوالي 15 ٪ من الرموز المميزة للمدخلات

S-Denoiser (μ = l/4 ، r = 0.25،1)

حالة محددة من تقليل النقل حيث نلاحظ ترتيبًا متسلسلًا صارمًا عند تأطير مهمة المدخلات إلى الهدف ، أي نمذجة لغة البادئة

x-denoiser (μ = 3 ، r = 0.5 ، n) ∪ (μ = 8 ، r = 0.5 ، n) ∪ (μ = 64 ، r = 0.15 ، n) ∪ (μ = 64 ، r = 0.5 ، n)

نسخة متطرفة من تقليل النموذج حيث يجب أن يستعيد النموذج جزءًا كبيرًا من المدخلات ، بالنظر إلى جزء صغير إلى معتدل منه. هذا يحاكي الموقف الذي يحتاج فيه النموذج إلى توليد هدف طويل من الذاكرة بمعلومات محدودة نسبيًا. للقيام بذلك ، نختار تضمين أمثلة مع تقليل العدوانية حيث يتم ملث حوالي 50 ٪ من تسلسل الإدخال

2022 أوراق: تجاوز قوانين التحجيم مع حساب إضافي 0.1 ٪

نعرض معدل توفير بحسابي حوالي 2x

تقليل المنتظم حيث يتم أخذ عينات من الضوضاء كمتوفرات ، يتم استبدالها برموز الحارس. هذه هي أيضًا مهمة الفساد القياسية المستخدمة في Raffel et al. (2019). عادة ما يتم أخذ عينات من الفترات بشكل موحد بمتوسط 3 ومعدل الفساد 15 ٪.

تقليل القشرة الشديدة حيث يتم زيادة الضوضاء إلى كميات "متطرفة" نسبيًا إما في نسبة ضخمة من النص الأصلي أو أن تكون طويلة جدًا في الطبيعة. عادة ما يتم أخذ عينات من الفترات بشكل موحد بطول متوسط 32 أو معدل فساد يصل إلى 50 ٪.

تقليل التسلسل حيث يتم أخذ عينات من الضوضاء دائمًا من بداية النص إلى نقطة تم أخذ عينات منها بشكل عشوائي في النص. يُعرف هذا أيضًا باسم هدف prefixlm (لا ينبغي الخلط بينه وبين الهندسة المعمارية).

سوف يهدف هذا الريبو إلى مرافقة هذه المهمة بدلاً من ذلك ، UL2 معقد للغاية بالنسبة لوقتي

بنسبة 50 ٪ prefixlm ، الفساد الطويل 25 ٪ (المتطرف) ، و 25 ٪ من الفساد العادي

قم بتشغيل MT5 Encoder PretReing على 3090 على ملفات Pythia json.zst

pip install text-denoising

python examples/pretrain_example.py

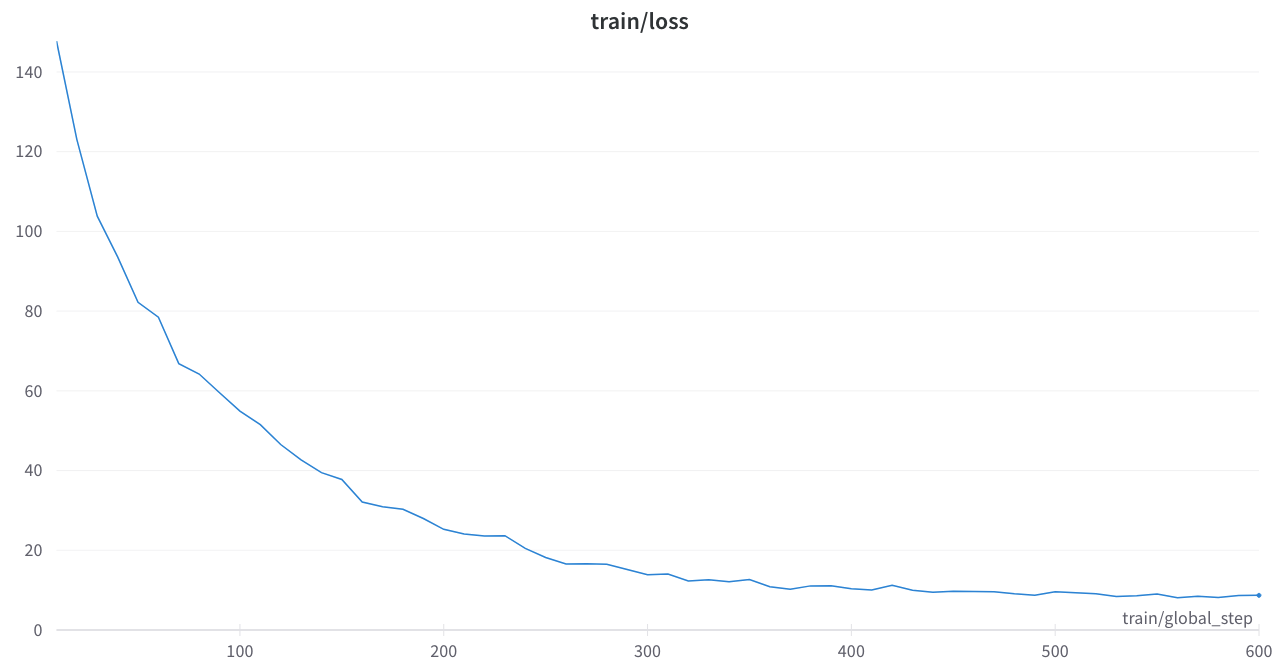

كانت فقدان التدريب مستقرًا ولا طفرات غريبة

أوراق أساسية

تجاوز قوانين التحجيم مع حساب إضافي 0.1 ٪

موحد نماذج تعلم اللغة

أدوات إخفاء الضوضاء T5 في محولات Luggingface أو رمز Python

أوسلو: معقود للغاية ، بعض الوثائق المرتبة والوثائق ، ستكون هذه أداة مفيدة للغاية

T5_pretraining.py

مستوحى بشدة من هذا القسم

Amazon Science: Label Aware Presrain في Python

FairSeq: span_mask_tokens_dataset.py