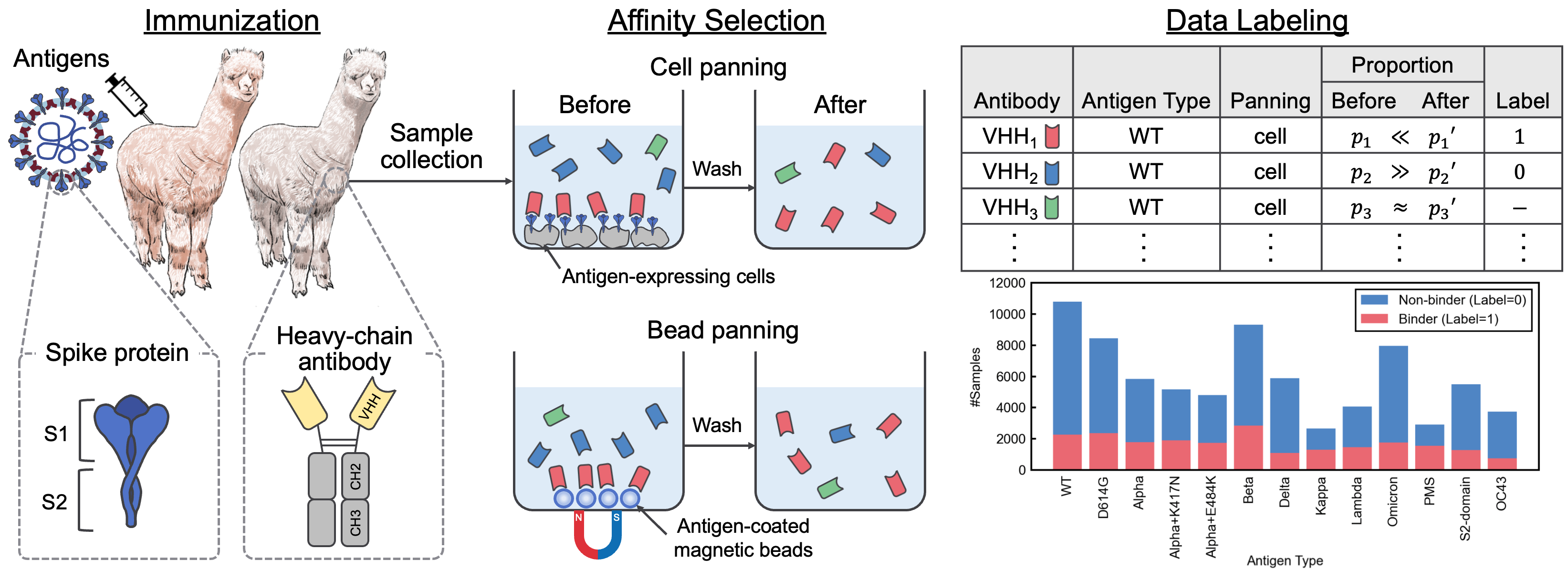

يحتوي هذا المستودع على المادة التكميلية المصاحبة للورقة "مجموعة بيانات التفاعل SARS-COV-2 ومجموعة تسلسل VHH لنماذج لغة الأجسام المضادة." في هذه الورقة ، قدمنا Avida-SARS-Cov-2 ، وهي مجموعة بيانات تحمل علامة من تفاعلات SARS-COV-2-VHH ، و VHHCORPUS-2M ، والتي تحتوي على أكثر من مليوني تسلسل VHH ، مما يوفر مجموعات بيانات جديدة لتقييم وتدريب نماذج لغة الأجسام المضادة المسبقة. تتوفر مجموعات البيانات على https://datasets.cognanous.com بموجب ترخيص CC BY-NC 4.0.

للبدء ، استنساخ هذا المستودع وتشغيل الأمر التالي لإنشاء بيئة افتراضية.

python -m venv ./venv

source ./venv/bin/activate

pip install -r requirements.txt| مجموعة البيانات | الروابط |

|---|---|

| vhhcorpus-2m | معانقة صفحة مشروع محور الوجه |

| Avida-Sars-Cov-2 | معانقة صفحة مشروع محور الوجه |

يمكن العثور على رمز تحويل البيانات RAW (ملف FastQ) الذي تم الحصول عليه من تسلسل الجيل التالي (NGS) إلى مجموعة البيانات المسمى ، Avida-SARS-2 ، تحت ./dataset . أصدرنا ملفات FastQ لنوع المستضد "OC43" هنا بحيث يمكن إعادة إنتاج معالجة البيانات.

أولاً ، تحتاج إلى إنشاء صورة Docker.

docker build -t vhh_constructor:latest ./dataset/vhh_constructor بعد وضع ملفات FastQ ضمن dataset/raw/fastq ، قم بتنفيذ الأمر التالي لإخراج ملف CSV المسمى.

bash ./dataset/preprocess.shVhhbert هو نموذج مقرها روبرتا تم تدريبه مسبقًا على ملايين تسلسل VHH في VHHCorpus-2M. يمكن تدريب Vhhbert مسبقًا بالأوامر التالية.

python benchmarks/pretrain.py --vocab-file " benchmarks/data/vocab_vhhbert.txt "

--epochs 20

--batch-size 128

--save-dir " outputs "الحجج:

| دعوى | مطلوب | تقصير | وصف |

|---|---|---|---|

| -ملف فوكاب | نعم | مسار ملف المفردات | |

| -epochs | لا | 20 | عدد الحقبة |

| -حجم دفعة | لا | 128 | حجم مكزرات صغيرة |

| -صيد | لا | 123 | بذرة عشوائية |

| -Save-dir | لا | ./أنقذ | مسار دليل حفظ |

يتوفر VHHBERT المدربين مسبقًا ، الذي تم إصداره بموجب ترخيص MIT ، على مركز Hugging Face.

لتقييم أداء نماذج اللغة المختلفة التي تم تدريبها مسبقًا لاكتشاف الأجسام المضادة ، حددنا مهمة تصنيف ثنائية للتنبؤ بربط أو عدم ربط الأجسام المضادة غير المعروفة إلى 13 مستضد باستخدام Avida-SARS-2. لمزيد من المعلومات حول مهمة القياس ، راجع الورقة.

يمكن تنفيذ صقل نماذج اللغة باستخدام الأمر التالي.

python benchmarks/finetune.py --palm-type " VHHBERT "

--epochs 30

--batch-size 32

--save-dir " outputs " يجب أن يكون palm-type أحد ما يلي:

VHHBERTVHHBERT-w/o-PTAbLangAntiBERTa2AntiBERTa2-CSSPIgBertProtBertESM-2-150MESM-2-650Mالحجج:

| دعوى | مطلوب | تقصير | وصف |

|---|---|---|---|

| -نوع بلم | لا | Vhhbert | اسم النموذج |

| -embeddings-file | لا | ./benchmarks/data/antigen_embeddings.pkl | مسار ملفات التضمينات للمستضدات |

| -epochs | لا | 20 | عدد الحقبة |

| -حجم دفعة | لا | 128 | حجم مكزرات صغيرة |

| -صيد | لا | 123 | بذرة عشوائية |

| -Save-dir | لا | ./أنقذ | مسار دليل حفظ |

إذا كنت تستخدم Avida-Sars-Cov-2 أو Vhhcorpus-2M أو Vhhbert في بحثك ، فيرجى استخدام الاقتباس التالي.

@inproceedings { tsuruta2024sars ,

title = { A {SARS}-{C}o{V}-2 Interaction Dataset and {VHH} Sequence Corpus for Antibody Language Models } ,

author = { Hirofumi Tsuruta and Hiroyuki Yamazaki and Ryota Maeda and Ryotaro Tamura and Akihiro Imura } ,

booktitle = { Advances in Neural Information Processing Systems 37 } ,

year = { 2024 }

}