رابيول أوال ، لو تشانغ وإيشواريا أغراوال

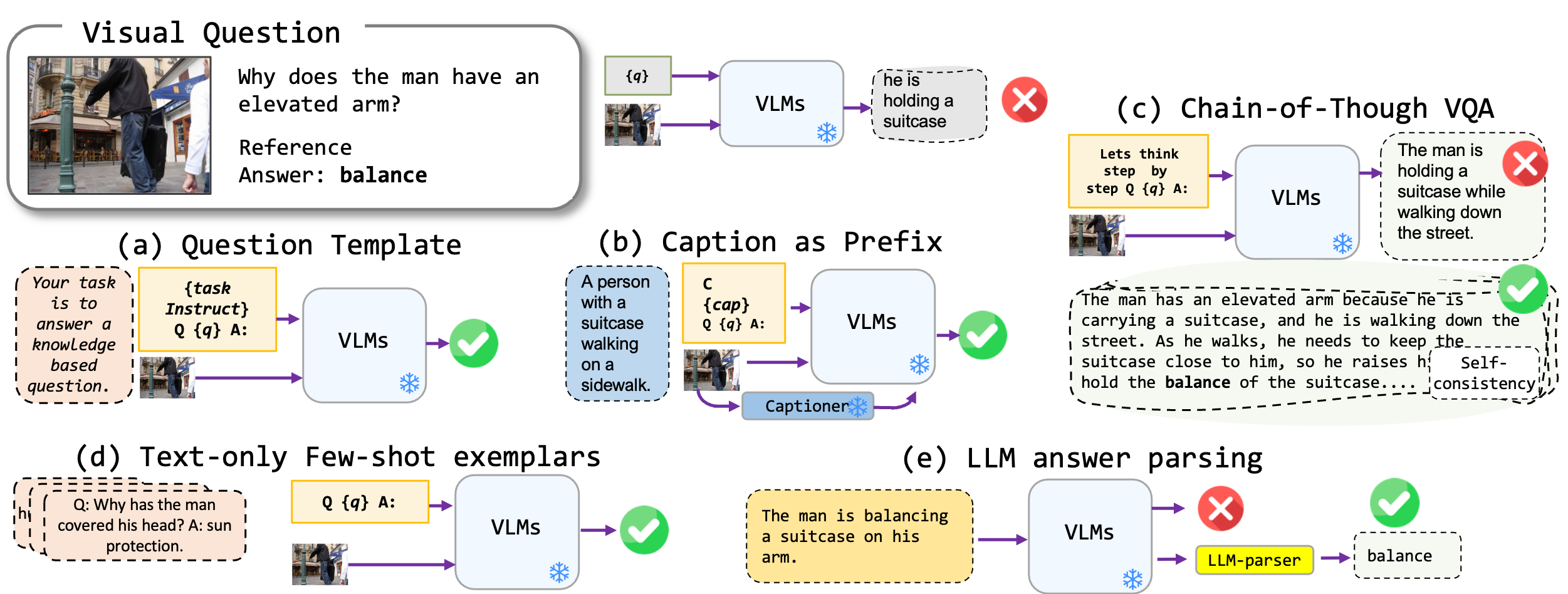

نستكشف تقنيات المطالبة الخالية من الضبط المطبقة على نماذج لغة الرؤية ، وتحديداً على أحدث طراز BLIP2 و KOSMOS2 و OPENFLAMINO و LLAVA متعدد الوسائط. نركز بشكل أساسي على نهج المطالبة التالية:

تُظهر نماذج لغة الرؤية الحالية (VLMS) بالفعل أداءً جيدًا جيدًا. تؤدي تقنيات المطالبة الخاصة بنا (وخاصة التسمية التوضيحية في قليلة الطلقة VQA) إلى زيادة كبيرة في الأداء عبر المعايير. ومع ذلك ، على الرغم من أن النماذج التي تم ضبطها على التعليمات تُظهر قدرات التفكير القوية ، فقد وجدت اختباراتنا قدرات التفكير هذه ، وخاصة سلسلة الفكرة ، لتكون ناقصة في المعايير المتنوعة. نأمل أن يلهم عملنا الأبحاث المستقبلية في هذا الاتجاه.

نحن ندعم تنسيقات VQA التالية:

| شكل | وصف | مثال |

|---|---|---|

| قياسي VQA | تنسيق مهمة VQA القياسي. | سؤال : "ما هو النشاط الأساسي للناس في المشهد؟" الجواب : "الرقص" |

| التسمية التوضيحية VQA | يبدأ بتسمية توضيحية تم إنشاؤها بواسطة النموذج ، ثم تنسيق VQA القياسي. | السياق : مجموعة من الناس في الملابس التقليدية ترقص حول نار. سؤال : "ما هو النشاط الأساسي للناس في المشهد؟" الجواب : "الرقص" |

| سلسلة الفكر VQA | ينفذ تنسيق سلسلة الفكر. | سؤال : "ما هو النشاط الأساسي للأشخاص في المشهد؟ دعنا نفكر خطوة بخطوة." الإجابة : "أولاً ، بالنظر إلى وجود نار ، فإن هذا غالبًا ما يدل على تجمع أو احتفال. بعد ذلك ، فإن رؤية الناس في الملابس التقليدية تعني حدثًا ثقافيًا. دمج هذه الملاحظات ، يرقص النشاط الأساسي حول النيران." |

لدينا قائمة من القوالب السريعة التي يمكن استخدامها بتنسيقات VQA مختلفة. يرجى التحقق من prompts/templates/{dataset_name} .

قم بتنزيل الملفات وإلغاء ضغطها في dataset/ المجلد لمجموعات بيانات VQA. بالنسبة إلى WinOground ، استخدم مكتبة datasets Hugging Face.

| OK-VQA | AOK-VQA | GQA | ربح | Vqav2 | |

|---|---|---|---|---|---|

| مصدر | أليناي | أليناي | ستانفورد | الوجه المعانقة | VQA |

لتشغيل VQA القياسي ، استخدم الأمر التالي:

python3 main.py --dataset_name okvqa

--model_name blip2_t5_flant5xxl

--vqa_format standard_vqa

--prompt_name prefix_your_task_knowledge_qa_short_answer

لتشغيل التسمية التوضيحية VQA ، استخدم الأمر التالي:

python3 main.py --dataset_name okvqa

--model_name blip2_t5_flant5xxl

--vqa_format caption_vqa

--prompt_name prefix_your_task_knowledge_qa_short_answer,prefix_promptcap

لتشغيل سلسلة VQA الفكر ، استخدم الأمر التالي:

python3 main.py --dataset_name okvqa

--model_name blip2_t5_flant5xxl

--vqa_format cot_vqa

--prompt_name prefix_think_step_by_step_rationale

يرجى تحضير dataset_zoo/nearest_neighbor.py examplar وتشغيل الأمر التالي:

python3 main.py

--dataset_name okvqa

--model_name blip2_t5_flant5xxl

--vqa_format standard_vqa

--prompt_name prefix_your_task_knowledge_qa_short_answer

--vicuna_ans_parser --few_shot

بالنظر إلى قيود مقاييس دقة VQA في سياق توليد الإجابات المفتوحة ، فإننا نقدم البرامج النصية للأداة المساعدة في evals/vicuna_llm_evals.py . باستخدام Vicuna LLM ، أنشأت عمليات البرامج النصية هذه الإجابات للتوافق مع الاستجابات المرجعية وتقييمها لاحقًا بناءً على مقياس VQA التقليدي.

python3 main.py

--dataset_name okvqa

--model_name blip2_t5_flant5xxl

--vqa_format standard_vqa

--prompt_name prefix_your_task_knowledge_qa_short_answer

--vicuna_ans_parser

نقوم بالإبلاغ عن خط الأساس وأفضل نتائج الإعداد. يرجى التحقق من الورقة لمزيد من النتائج.

| blip2 flan-t5 | BLIP2 OPT | Kosmos2 | OpenFlamingo | llava | |

|---|---|---|---|---|---|

| خط الأساس | 50.13 | 42.7 | 40.33 | 18.29 | 44.84 |

| أفضل | 50.55 | 46.29 | 43.09 | 42.48 | 46.86 |

| blip2 flan-t5 | BLIP2 OPT | Kosmos2 | OpenFlamingo | llava | |

|---|---|---|---|---|---|

| خط الأساس | 51.20 | 45.57 | 40.85 | 17.27 | 52.69 |

| أفضل | 54.98 | 49.39 | 43.60 | 44.13 | 52.32 |

| blip2 flan-t5 | BLIP2 OPT | Kosmos2 | OpenFlamingo | llava | |

|---|---|---|---|---|---|

| خط الأساس | 44.46 | 38.46 | 37.33 | 26.37 | 38.40 |

| أفضل | 47.01 | 41.99 | 40.13 | 41.00 | 42.65 |

| blip2 flan-t5 | BLIP2 OPT | Kosmos2 | OpenFlamingo | llava | |

|---|---|---|---|---|---|

| خط الأساس | 66.66 | 54.53 | 53.52 | 35.41 | 56.2 |

| أفضل | 71.37 | 62.81 | 57.33 | 58.0 | 65.32 |

يرجى إرسال بريد إلكتروني إلى rabiul.awal [at] mila [dot] quebec لأي أسئلة. يمكنك أيضًا فتح مشكلة أو طلب سحب لإضافة المزيد من تقنيات المطالبة أو نماذج جديدة متعددة الوسائط باللغة.

إذا وجدت هذا الرمز مفيدًا ، فيرجى الاستشهاد بالورقة:

@article{awal2023investigating,

title={Investigating Prompting Techniques for Zero-and Few-Shot Visual Question Answering},

author={Awal, Rabiul and Zhang, Le and Agrawal, Aishwarya},

journal={arXiv preprint arXiv:2306.09996},

year={2023}

}

يتم بناء قاعدة كود على أعلى مستودعات المحولات ، Lavis ، Llava و Fastchat. نشكر المؤلفين على عملهم المذهل.