還在為大模型處理長文本“龜速”而抓狂?別急!清華大學祭出“王炸”技術——APB 序列並行推理框架,直接給大模型裝上“渦輪增壓”引擎!實測顯示,這項黑科技在處理超長文本時,速度竟比肩Flash Attention 快10倍!沒錯,你沒聽錯,是10倍!

要知道,隨著ChatGPT 等大模型的爆火,AI 們“閱讀”能力也水漲船高,動輒處理十幾萬字的長文不在話下。然而,面對海量信息,傳統大模型的“大腦”卻有點卡殼—— Transformer 架構雖強,但其核心的注意力機制就像一個“超級掃描儀”,文本越長,掃描範圍呈指數級膨脹,速度自然就慢了下來。

為了解決這個“卡脖子”難題,清華大學的科學家們聯合多家研究機構和科技巨頭,另闢蹊徑,推出了APB 框架。這套框架的核心奧秘在於“ 序列並行+稀疏注意力”的巧妙結合。

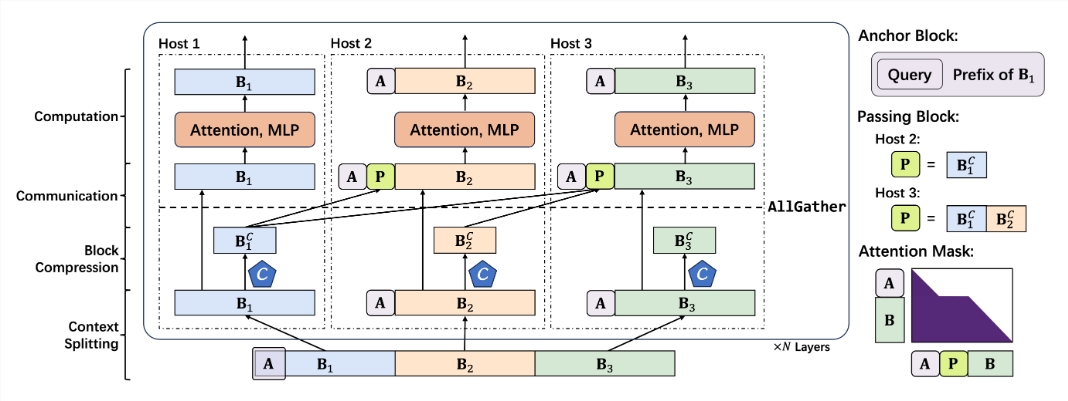

簡單來說,APB 框架就像一個高效的“協同作戰”團隊。它將長文本“肢解”成小塊,分配給多個GPU “隊員”並行處理。更絕的是,APB 還給每個“隊員” 配備了“ 局部KV 緩存壓縮” 和“ 精簡通信” 技能,讓它們在處理各自任務的同時,還能高效共享關鍵信息,協同解決長文本中的複雜語義依賴問題。

更令人驚喜的是,APB 框架並非以犧牲性能為代價換取速度。相反,在128K 超長文本測試中,APB 不僅速度狂飆,性能更是超越傳統Flash Attention!甚至連英偉達力推的Star Attention 也被APB 斬落馬下,速度提升1.6倍,堪稱“全能ACE”。

這項突破性技術,最直接的應用就是大幅縮短大模型處理長文本請求的首token 響應時間。這意味著,未來搭載APB 框架的大模型,在面對用戶“洋洋灑灑” 的長篇指令時,能夠瞬間理解,秒速響應,徹底告別“加載中…”的漫長等待。

那麼,APB 框架究竟是如何做到如此“逆天”的提速效果呢?

原來,APB 框架深諳長文本處理的“痛點”—— 計算量。傳統注意力機制的計算量與文本長度的平方成正比,長文本就是計算的“黑洞”。 為了突破這個瓶頸,APB 框架祭出兩大“神招”:

第一招:提升並行度,讓“眾人拾柴火焰高”

APB 框架充分利用分佈式計算的優勢,將計算任務分散到多個GPU 上,就像“多人協同” 一樣,效率自然倍增。尤其是在序列並行方面,APB 框架展現出極強的擴展性,不受模型結構限制,文本再長也能輕鬆應對。

第二招:減少無效計算,讓“好鋼用在刀刃上”

APB 框架引入稀疏注意力機制,並非“眉毛鬍子一把抓”,而是“選擇性” 計算注意力。它就像一位“火眼金睛” 的專家,只關注文本中的關鍵信息,忽略無關緊要的部分,從而大幅減少計算量。

然而, “並行” 和“稀疏” 這兩招看似簡單,實則“暗藏玄機”。 如何在序列並行框架下,實現高效的稀疏注意力計算?這才是APB 框架真正的“硬核” 所在。

要知道,在序列並行環境中,每個GPU 只掌握部分文本信息,想要實現“全局感知” 的稀疏注意力,就如同“盲人摸象”,難度可想而知。此前的Star Attention 和APE 等方法,要么犧牲性能,要么適用場景受限,都未能完美解決這個問題。

而APB 框架則巧妙地避開了“大規模通信” 這個“坑”,另闢蹊徑,構建了一套面向序列並行場景的低通信稀疏注意力機制。 這套機制的核心組件包括:

更小巧的Anchor block (錨點塊): Anchor block 就像一個“導航儀”,引導注意力機制聚焦關鍵信息。 APB 框架創新性地縮小了Anchor block 的尺寸,使其更輕巧靈活,降低了計算開銷。

獨創Passing block (傳遞塊): Passing block 是APB 框架的“靈魂” 組件,它巧妙地解決了長距離語義依賴難題。通過將前序GPU 處理的關鍵信息“壓縮打包”,傳遞給後續GPU,讓每個“隊員” 都能“縱覽全局”,理解長文本的“上下文” 語境。

查詢感知的上下文壓縮: APB 框架還引入了“查詢感知” 機制,讓上下文壓縮器能夠“理解問題”,更精準地篩选和保留與查詢相關的關鍵信息,進一步提升效率和準確性。

基於以上“獨門絕技”,APB 框架構建了一套行雲流水的推理流程:

上下文分割: 將長文本均勻分配給各個GPU,並在開頭拼接Anchor block, “埋入” 查詢問題。

上下文壓縮: 利用Locret 引入的保留頭,對KV 緩存進行“智能壓縮”。

高效通信: 通過AllGather 算子,將壓縮後的KV 緩存“傳遞” 給後續GPU,構建Passing block。

極速計算: 使用特製的Flash Attention Kernel,配合優化的注意力掩碼,進行高效計算。 Passing block 在計算完成後“功成身退”,不參與後續計算。

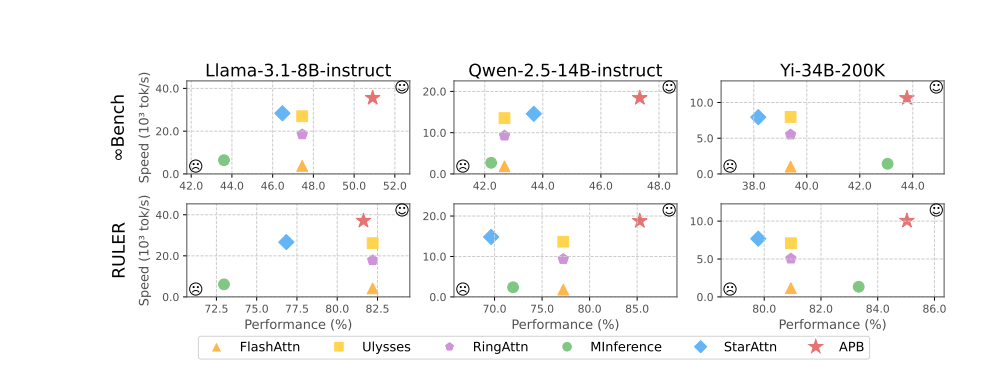

實驗結果雄辯地證明了APB 框架的卓越性能。在Llama-3.1-8B-instruct, Qwen-2.5-14B-instruct 以及Yi-34B-200K 等多個模型和InfiniteBench、RULER 等多個benchmark 上的測試中,APB 框架均力壓群雄,在性能和速度之間取得了最佳平衡。

尤其值得一提的是,隨著文本長度的增加,APB 框架的速度優勢愈發明顯,真正實現了“越長越快” 的奇效。 這背後的奧秘在於,APB 框架的計算量遠低於其他方法,且差距隨著文本長度增加而擴大。

更深入的預填充時間拆解分析顯示,序列並行技術本身就能顯著縮減注意力和FFN (前饋神經網絡)的計算時間。而APB 框架的稀疏注意力機制,則進一步將注意力計算時間壓縮到極致。 與Star Attention 相比,APB 框架巧妙地利用Passing block 傳遞遠距離語義依賴,大幅縮小了Anchor block 的尺寸,有效降低了FFN 的額外開銷,實現了“魚與熊掌兼得” 的完美效果。

更令人振奮的是,APB 框架展現出卓越的兼容性,能夠靈活適應不同的分佈式環境和模型規模,在各種“嚴苛” 條件下都能保持“穩如磐石” 的高性能和高效率。

可以預見,隨著APB 框架的問世,大模型長文本推理的“瓶頸” 將被徹底打破,AI 應用的想像空間也將被無限拓展。 未來,無論是智能客服、金融分析,還是科研探索、內容創作,我們都將迎來一個“更快、更強、更智能” 的AI 新時代!

項目地址:https://github.com/thunlp/APB

論文地址:https://arxiv.org/pdf/2502.12085