Ainda enlouquecendo com a "velocidade" de processar textos longos em grandes modelos? Não se preocupe! A Universidade de Tsinghua lançou a estrutura de raciocínio paralela da tecnologia "King Bomb", e equipou diretamente o motor "turbo" para os grandes modelos! Os testes reais mostram que, ao processar um texto ultra longo, essa tecnologia preta é na verdade 10 vezes mais rápida que a atenção do flash! É isso mesmo, você ouviu certo, é 10 vezes!

Você deve saber que, com a popularidade de grandes modelos, como o ChatGPT, a habilidade de "leitura" da IA também aumentou, e não há problema em processar artigos longos que valem dezenas de milhares de palavras. No entanto, diante de informações maciças, o "cérebro" dos grandes modelos tradicionais está um pouco preso - embora a arquitetura do transformador seja forte, seu principal mecanismo de atenção é como um "super scanner". Quanto mais tempo o texto, a expansão exponencial da faixa de varredura e a velocidade mais lenta.

Para resolver esse problema de "gargalo", cientistas da Universidade de Tsinghua uniram as mãos a muitas instituições de pesquisa e gigantes da tecnologia para encontrar uma abordagem diferente e lançaram uma estrutura da APB. O mistério central dessa estrutura está na combinação inteligente de "Sequência paralela + atenção escassa".

Simplificando, a estrutura da APB é como uma equipe de "cooperação" eficiente. Ele "desmembra" um texto longo em pedaços pequenos e o aloca para vários "membros da equipe" de GPUs para processá -lo em paralelo. O que é ainda mais incrível é que o APB também equipa cada "membro da equipe" com as habilidades "de compactação local de cache KV" e "comunicação simplificada", permitindo que eles compartilhem com eficiência informações importantes enquanto lidam com suas respectivas tarefas e resolvem conjuntamente dependências semânticas complexas em textos longos.

O que é ainda mais surpreendente é que a estrutura da APB não negocia velocidade à custa do desempenho. Pelo contrário, no teste de texto ultra-longo de 128K, a APB não apenas teve sua velocidade, mas seu desempenho superou a atenção tradicional do flash! Até a atenção da estrela, que Nvidia promoveu fortemente, foi derrubada pela APB, com um aumento de velocidade de 1,6 vezes, tornando-o um "ás todo".

A aplicação mais direta dessa tecnologia inovadora é reduzir significativamente o primeiro tempo de resposta do token de grandes modelos para processar solicitações de texto longo. Isso significa que, ao enfrentar as longas instruções da "spread" dos usuários pela estrutura do APB no futuro, o grande modelo equipado com a estrutura do APB pode entender instantaneamente, responder em segundos e se despedir completamente da longa espera de "carregamento ...".

Então, como a estrutura do APB atinge um efeito de aceleração "não-the-the-nature"?

Acontece que a estrutura do APB está bem ciente dos "pontos problemáticos" do processamento de texto longo - quantidade de cálculo. A quantidade de cálculo do mecanismo de atenção tradicional é proporcional ao quadrado do comprimento do texto e o texto longo é o "buraco negro" do cálculo. Para romper esse gargalo, a estrutura da APB lançou dois "Moves Magic":

O primeiro passo: melhore o paralelismo e faça "o fogo está alto para que todos pegem fogo"

A estrutura da APB aproveita ao máximo a computação distribuída para distribuir tarefas de computação em várias GPUs, assim como "colaboração multi-player", com eficiência natural. Especialmente em termos de paralelismo da sequência, a estrutura do APB mostra escalabilidade extremamente forte e não é limitada pela estrutura do modelo e pode facilmente lidar com o texto, não importa quanto tempo ele seja.

O segundo truque: reduza os cálculos inválidos e deixe "o bom aço ser usado na lâmina"

A estrutura do APB introduz um mecanismo de atenção escasso, que não é "pegue as sobrancelhas e as barbas de uma vez", mas "seletivamente" para calcular a atenção. É como um especialista com "olhos de fogo" que se concentra apenas nas principais informações do texto e ignora partes irrelevantes, reduzindo bastante a quantidade de cálculos.

No entanto, os dois truques de "paralelo" e "escasso" parecem simples, mas na verdade eles "escondem mistérios". Como obter um cálculo de atenção esparsa eficiente na estrutura paralela da sequência? Este é o verdadeiro "núcleo duro" da estrutura do APB.

Você deve saber que em um ambiente paralelo de sequência, cada GPU possui apenas parte das informações de texto. Se você deseja alcançar a "percepção global", é como "um homem cego tocando um elefante", e a dificuldade pode ser imaginada. Métodos anteriores, como Atenção de Estrelas e APE, sacrificaram o desempenho ou foram limitados em cenários aplicáveis, que não resolveram perfeitamente esse problema.

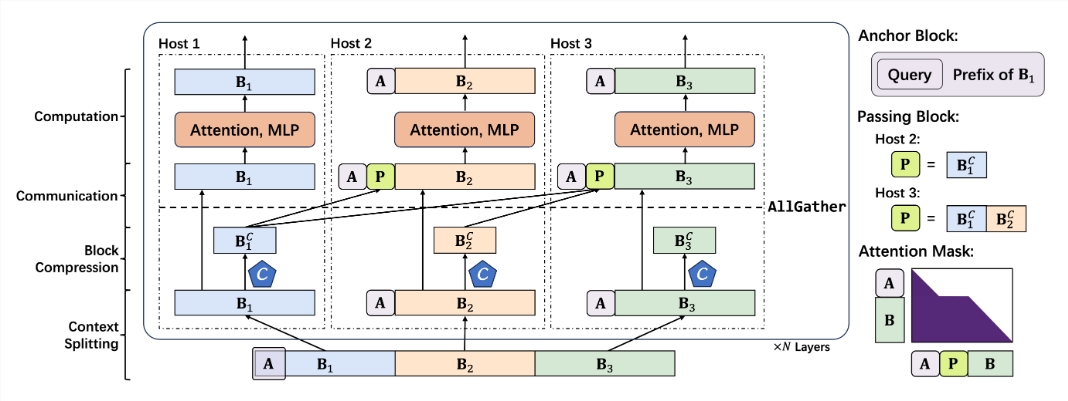

A estrutura do APB evita inteligentemente o "poço" da "comunicação em larga escala" e adota uma abordagem diferente para construir um mecanismo de atenção escasso de baixa comunicação para cenários paralelos de sequência. Os componentes principais deste mecanismo incluem:

Bloco de âncora menor: o bloco de âncora é como um "navegador" que orienta o mecanismo de atenção para se concentrar nas principais informações. A estrutura do APB reduz inovador o tamanho do bloco de ancoragem, tornando -o mais leve e mais flexível e reduz a sobrecarga da computação.

Bloco de passagem original: o bloco de passagem é o componente "Soul" da estrutura do APB, que resolve inteligentemente o problema da dependência semântica de longa distância. Ao "compactar e embalar" as principais informações processadas pela GPU preâmbulo e passando -as para a GPU subsequente, cada "membro da equipe" pode ver a situação geral e entender o contexto "contexto" do texto longo.

Compressão de contexto com reconhecimento de consulta: a estrutura do APB também apresenta um mecanismo de "consulta consciente", permitindo que o compressor de contexto "compreenda o problema", filtre e retenha informações importantes relacionadas à consulta com mais precisão e melhore ainda mais a eficiência e a precisão.

Com base nas "habilidades exclusivas" acima, a estrutura da APB construiu um processo de raciocínio suave e razoável:

Segmentação de contexto: distribua o texto longo uniformemente para cada GPU e emenda o bloco de ancoragem no início para "enterrar" o problema.

Compressão de contexto: use o cabeçalho de retenção introduzido pela Locret para executar "compactação inteligente" do cache KV.

Comunicação eficiente: através do operador Allgather, o cache KV compactado é "passado" para a GPU subsequente para construir um bloco de passagem.

Cálculo rápido: use um kernel de atenção flash especialmente feito e execute cálculos eficientes com uma máscara de atenção otimizada. Passando o "Retirescue" do bloco após a conclusão do cálculo e não participa dos cálculos subsequentes.

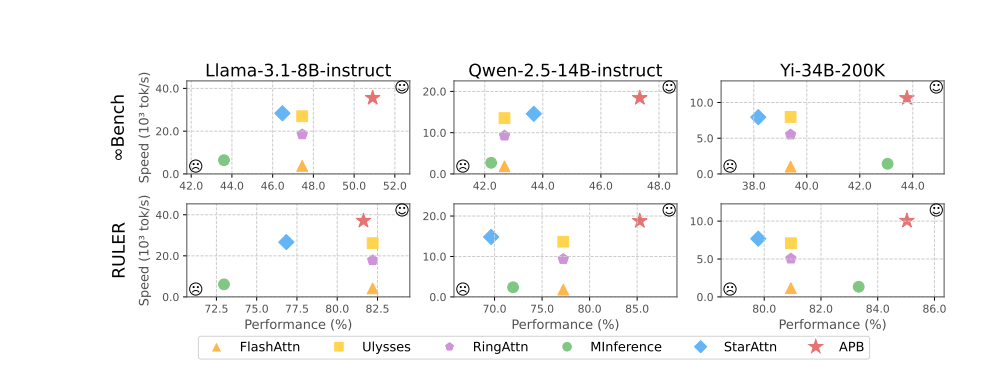

Os resultados experimentais demonstram eloquentemente o excelente desempenho da estrutura do APB. Em testes como o LLAMA-3.1-8B-INSTRUTA, QWEN-2.5-14B-INSTRUTA, YI-34B-200K e vários benchmarks como InfiniteBench e governante, a estrutura da APB ultrapassou a multidão, alcançando o melhor equilíbrio entre desempenho e velocidade.

Vale a pena mencionar particularmente que, à medida que o comprimento do texto aumenta, a vantagem de velocidade das estruturas da APB se torna cada vez mais óbvia e realmente percebe o efeito milagroso de "ficar mais rápido e rápido". O mistério por trás disso é que a estrutura do APB é muito menos computacional do que outros métodos, e a lacuna aumenta à medida que o comprimento do texto aumenta.

Análise mais aprofundada do tempo preenchido de pré-preenchimento mostra que a própria tecnologia do paralelismo da sequência pode reduzir significativamente o tempo de computação da atenção e o FFN (Rede Neural Feedforward). O mecanismo de atenção escasso da estrutura do APB comprime ainda mais o tempo de cálculo de atenção ao extremo. Comparado com a atenção das estrelas, a estrutura do APB usa inteligentemente o bloco de passagem para passar dependências semânticas de longa distância, reduzindo bastante o tamanho do bloco de ancoragem, reduzindo efetivamente a sobrecarga adicional da FFN e alcançando o efeito perfeito de "peixes e pata de urso".

O que é ainda mais emocionante é que a estrutura do APB demonstra excelente compatibilidade, pode se adaptar flexivelmente a diferentes ambientes e escalas de modelos distribuídos e pode manter alto desempenho e alta eficiência "tão estáveis quanto uma rocha" sob várias condições "difíceis".

Pode ser previsto que, com o advento da estrutura do APB, o "gargalo" do raciocínio de texto longo em larga escala será completamente quebrado, e o espaço de imaginação das aplicações de IA será infinitamente expandido. No futuro, seja atendimento ao cliente inteligente, análise financeira, pesquisa e exploração científica e criação de conteúdo, inauguraremos uma nova era de IA que é "mais rápida, mais forte e mais inteligente"!

Endereço do projeto: https://github.com/thunlp/apb

Endereço em papel: https://arxiv.org/pdf/2502.12085