Все еще сходите с ума от «скорости» обработки длинных текстов в больших моделях? Не волнуйся! Университет Цингхуа запустил технологию «Королевская бомба» - параллельная структура рассуждений «Кинга бомбы» и непосредственно оснащена двигателем «турбонаддув» для больших моделей! Фактические тесты показывают, что при обработке сверхпрочного текста эта черная технология на самом деле в 10 раз быстрее, чем вспышка! Правильно, вы слышали это правильно, это 10 раз!

Вы должны знать, что благодаря популярности крупных моделей, таких как CHATGPT, способность «чтение» ИИ также увеличилась, и не может быть проблемой обрабатывать длинные статьи на десятки тысяч слов. Тем не менее, перед лицом массивной информации, «мозг» традиционных больших моделей немного застрял - хотя архитектура трансформатора сильна, его основной механизм внимания похож на «супер -сканер». Чем дольше текст, экспоненциальное расширение диапазона сканирования и тем меньше скорость.

Чтобы решить эту проблему «узкого места», ученые из Университета Цинхуа объединились со многими исследовательскими институтами и технологическими гигантами, чтобы найти другой подход и запустить структуру APB. Основная загадка этой структуры заключается в умной комбинации «параллельности последовательности + редкого внимания».

Проще говоря, структура APB похожа на эффективную команду «сотрудничества». Он «загрязняет» длинный текст на мелкие кусочки и выделяет его на несколько графических процессоров «членов команды», чтобы обработать его параллельно. Что еще более удивительнее, так это то, что APB также освоивает каждого «члена команды» с «локальным сжатием кэша KV и навыками« упрощенного общения », позволяя им эффективно обмениваться ключевой информацией, выполняя при этом свои задачи и совместно решать сложные семантические зависимости в длинных текстах.

Что еще более удивительно, так это то, что структура APB не торгует скоростью за счет производительности. Наоборот, в сверхточном текстовом тесте 128K APB не только взлетела скорость, но и ее производительность превзошла традиционное внимание вспышки! Даже звездное внимание, которое, как сильно продвигало Nvidia, было сбито APB, с увеличением скорости 1,6 раза, что делает его «всесторонним тузом».

Наиболее прямое применение этой прорывной технологии состоит в том, чтобы значительно сократить время отклика первого токена крупных моделей для обработки длинных текстовых запросов. Это означает, что при столкновении с длинными инструкциями «разбросана» пользователей в будущем большая модель, оснащенная структурой APB, может мгновенно понять, реагировать за считанные секунды и полностью прощаться с долгом ожиданием «загрузки ...».

Итак, как структура APB достигает такого «не народного» ускорения?

Оказывается, что структура APB хорошо осведомлена о «болевых точках» длинной текстовой обработки - расчеты. Количество расчета традиционного механизма внимания пропорциональна квадрату длины текста, а длинное текст - «черная дыра» расчета. Чтобы прорваться через это узкое место, Framework APB выпустила два «волшебных движения»:

Первый шаг: улучшить параллелизм и сделать «Огонь высоким для всех, чтобы забрать огонь»

APB Framework в полной мере использует распределенные вычисления для распределения вычислительных задач по нескольким графическим процессорам, как «многопользовательское сотрудничество», с естественной эффективностью. Особенно с точки зрения параллелизма последовательностей, структура APB показывает чрезвычайно сильную масштабируемость и не ограничивается структурой модели и может легко справиться с текстом, независимо от того, как долго это происходит.

Второй трюк: уменьшить недопустимые расчеты и пусть «Хорошая сталь будет использована на лезвии»

Структура APB вводит редкий механизм внимания, который не является «захватом бровей и бороды одновременно», а «селективно», чтобы рассчитать внимание. Это похоже на эксперт с «огненными глазами», который фокусируется только на ключевой информации в тексте и игнорирует нерелевантные части, что значительно сокращает количество расчетов.

Тем не менее, две хитрости «параллельных» и «редких» кажутся простыми, но на самом деле они «скрывают загадки». Как добиться эффективного расчета редкого внимания в соответствии с параллельной структурой последовательности? Это настоящее «твердое ядро» фреймворка APB.

Вы должны знать, что в параллельной среде последовательности каждый графический процессор имеет только часть текстовой информации. Если вы хотите достичь «глобального восприятия», это похоже на «слепого, касающегося слона», и можно представить трудность. Предыдущие методы, такие как Star Hite и Ape, либо принесли в жертву производительность, либо были ограничены в применимых сценариях, которые не смогли полностью решить эту проблему.

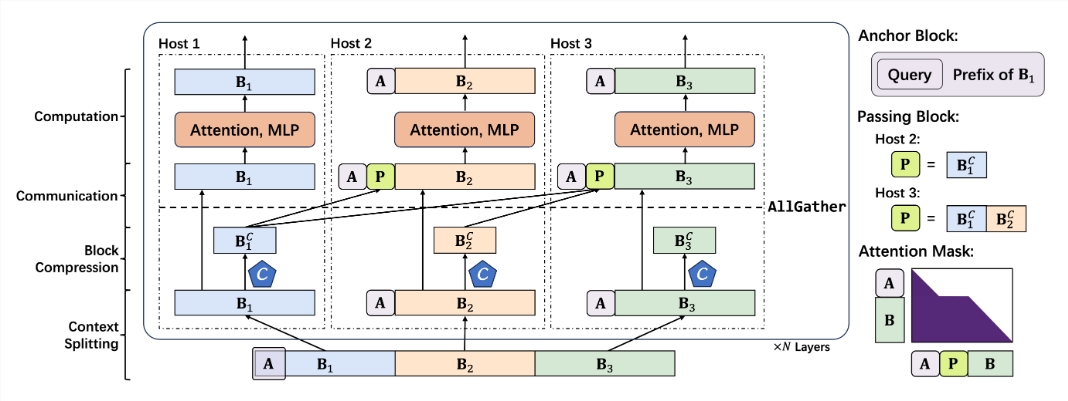

Структура APB умно избегает «ямы» «крупномасштабной связи» и использует другой подход для создания низкооберитещего механизма внимания для параллельных сценариев последовательностей. Основные компоненты этого механизма включают:

Меньший якорный блок: якорный блок похож на «навигатор», который направляет механизм внимания сосредоточиться на ключевой информации. Структура APB инновационно уменьшает размер якорного блока, что делает его легче и гибким и уменьшает вычислительные накладные расходы.

Оригинальный проходной блок: прохождение блока-это компонент «души» структуры APB, который ловко решает проблему семантической зависимости на расстоянии. «Сжатие и упаковку» ключевая информация, обработанная в Preamble GPU, и передавая ее в последующий графический процессор, каждый «член команды» может «просматривать общую ситуацию» и понять контекст «контекста» длинного текста.

Сжатие контекста с запросом: структура APB также вводит механизм «адаптации запросов», позволяя контекстному компрессору «понять проблему», фильтровать и сохранить ключевую информацию, связанную с запросом более точно, и еще больше повысить эффективность и точность.

Основываясь на вышеупомянутых «уникальных навыках», Framework APB создал плавный и разумный процесс рассуждения:

Сегментация контекста: распределить длинный текст равномерно по каждому графическому процессору, и в начале блока сплайсинга в начале «похоронить» запрашивать проблему.

Сжатие контекста: используйте заголовок удержания, введенный Locret, чтобы выполнить «умное сжатие» кеша KV.

Эффективная связь: через оператора Allgather сжатый кэш KV «передается» в последующий графический процессор для создания проходного блока.

Ускоренный расчет: используйте специально сделанное ядро флэш -внимания и выполните эффективные расчеты с оптимизированной маской внимания. Передача блок «пенессуа» после завершения расчета и не участвует в последующих расчетах.

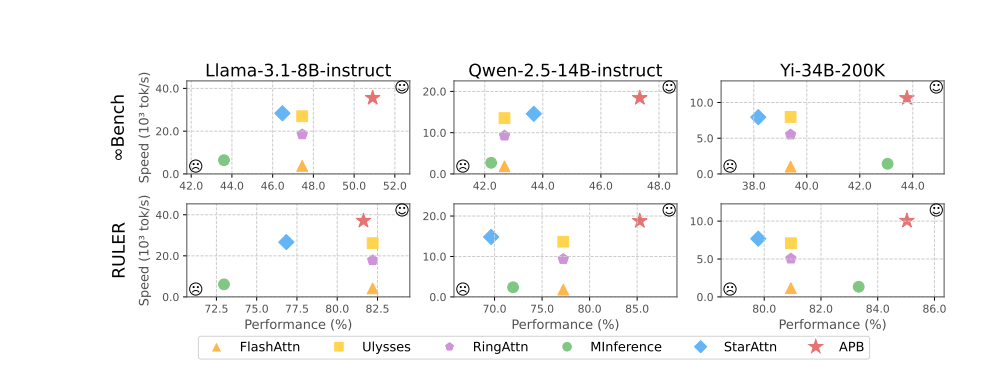

Экспериментальные результаты красноречиво демонстрируют превосходную производительность платформы APB. В таких тестах, как Llama-3.1-8b-Instruct, QWEN-2,5-14B-Instruct, YI-34B-200K и множественные эталоны, такие как InfiniteBench и Ruler, рамки APB превзошли толпу, достигнув наилучшего баланса между производительностью и скоростью.

Особенно стоит упомянуть, что по мере увеличения длины текста преимущество скорости APB -карт становится все более и более очевидным, и это действительно осознает чудесный эффект «становятся быстрее и быстрее». Тайна, стоящая за этим, заключается в том, что структура APB гораздо менее вычислительно, чем другие методы, а разрыв расширяется по мере увеличения длины текста.

Более глубокий анализ разрыва до заполнения предварительного заполнения показывает, что сама технология параллелизма последовательностей может значительно сократить время вычисления внимания и FFN (нейронная сеть с прямой связью). Редкий механизм внимания структуры APB еще больше сжимает время расчета внимания до крайности. По сравнению с звездным вниманием, фреймворк APB умно использует проходящий блок для прохождения семантических зависимостей на большие расстояния, значительно уменьшая размер якорного блока, эффективно уменьшая дополнительные накладные расходы FFN и достигнув совершенного эффекта «как рыбы, так и лапы медведя».

Что еще более захватывающе, так это то, что структура APB демонстрирует превосходную совместимость, может гибко адаптироваться к различным распределенным средам и масштабам моделей и может поддерживать высокую производительность и высокую эффективность «столь же стабильной, как порода» в различных «жестких» условиях.

Можно предвидеть, что с появлением фреймворка APB, «узкое место» крупномасштабных длинных текстовых рассуждений будет полностью сломано, а пространство воображения применений ИИ будет бесконечно расширено. В будущем, будь то интеллектуальное обслуживание клиентов, финансовый анализ, научные исследования и исследования, а также создание контента, мы будем открывать новую эру искусственного интеллекта, которая «быстрее, сильнее и умнее»!

Адрес проекта: https://github.com/thunlp/apb

Бумажный адрес: https://arxiv.org/pdf/2502.12085