De plus en plus fou de la "vitesse" du traitement des textes longs dans les grands modèles? Ne t'inquiète pas! L'université de Tsinghua a lancé la technologie "King Bomb" - le cadre de raisonnement parallèle de la séquence APB et a directement équipé le moteur "turbocompressé" aux grands modèles! Les tests réels montrent que lors du traitement du texte ultra-long, cette technologie noire est en fait 10 fois plus rapide que l'attention du flash! C'est vrai, vous l'avez bien entendu, c'est 10 fois!

Vous devez savoir qu'avec la popularité de grands modèles tels que Chatgpt, la capacité de "lecture" de l'IA a également augmenté, et ce n'est pas un problème de traiter de longs articles d'une valeur de dizaines de milliers de mots. Cependant, face à des informations massives, le "cerveau" des grands modèles traditionnels est un peu coincé - bien que l'architecture du transformateur soit forte, son mécanisme d'attention central est comme un "super scanner". Plus le texte est long, plus l'expansion exponentielle de la plage de balayage et plus la vitesse.

Afin de résoudre ce problème de "goulot d'étranglement", les scientifiques de l'Université de Tsinghua se sont associés à de nombreuses institutions de recherche et géants de la technologie pour trouver une approche différente et lancer un cadre APB. Le mystère central de ce cadre réside dans la combinaison intelligente de "Séquence parallèle + attention clairsemée".

Autrement dit, le cadre APB est comme une équipe efficace de "coopération". Il "démarre" le texte long en petits morceaux et l'attribue à plusieurs GPU "membres de l'équipe" pour le traiter en parallèle. Ce qui est encore plus étonnant, c'est que l'APB équipe également chaque "membre de l'équipe" de "compression locale de cache KV" et de "communication simplifiée", leur permettant de partager efficacement des informations clés tout en gérant leurs tâches respectives et en résolvant conjointement les dépendances sémantiques complexes dans des textes longs.

Ce qui est encore plus surprenant, c'est que le cadre APB n'échange pas la vitesse au détriment des performances. Au contraire, dans le test de texte ultra-long 128k, APB a non seulement fait grimper sa vitesse, mais ses performances ont dépassé l'attention traditionnelle du flash! Même l'attention des étoiles, que Nvidia a fortement favorisée, a été renversée par APB, avec une augmentation de vitesse de 1,6 fois, ce qui en fait un "Ace polyvalent".

L'application la plus directe de cette technologie révolutionnaire est de raccourcir considérablement le premier temps de réponse à jeton des grands modèles pour le traitement de longues demandes de texte. Cela signifie que face aux longues instructions de la "propagation" des utilisateurs par le cadre APB à l'avenir, le grand modèle équipé du cadre APB peut comprendre instantanément, répondre en secondes et dire complètement adieu à la longue attente du "chargement ...".

Alors, comment le framework APB réalise-t-il un effet aussi "non nature" accéléré?

Il s'avère que le cadre APB est bien conscient des "points de douleur" du long traitement du texte - montant de calcul. La quantité de calcul du mécanisme d'attention traditionnel est proportionnelle au carré de la longueur du texte, et le texte long est le "trou noir" du calcul. Afin de percer ce goulot d'étranglement, le cadre APB a lancé deux "Magic Moves":

Le premier mouvement: améliorez le parallélisme et faites que "le feu est élevé pour que tout le monde prenne le feu"

Le cadre APB tire pleinement parti de l'informatique distribuée pour distribuer des tâches informatiques sur plusieurs GPU, tout comme "collaboration multi-joueurs", avec une efficacité naturelle. Surtout en termes de parallélisme de séquence, le cadre APB montre une évolutivité extrêmement forte et n'est pas limitée par la structure du modèle, et peut facilement faire face au texte quelle que soit sa durée.

La deuxième astuce: réduire les calculs non valides et laisser "un bon acier être utilisé sur la lame"

Le cadre APB présente un mécanisme d'attention clairsemé, qui n'est pas "saisir les sourcils et les barbes à la fois", mais "sélectivement" pour calculer l'attention. C'est comme un expert aux «yeux de feu» qui se concentre uniquement sur les informations clés du texte et ignore les parties non pertinentes, réduisant ainsi considérablement la quantité de calculs.

Cependant, les deux astuces de "parallèle" et "clairsemées" semblent simples, mais en fait, ils "cachent des mystères". Comment réaliser un calcul efficace de l'attention clairsemée dans le cadre parallèle de la séquence? Il s'agit du véritable "noyau dur" du cadre APB.

Vous devez savoir que dans un environnement parallèle de séquence, chaque GPU n'a fait qu'une partie des informations texte. Si vous voulez réaliser une "perception mondiale", c'est comme "un aveugle touchant un éléphant", et la difficulté peut être imaginée. Des méthodes précédentes telles que l'attention des étoiles et les APE ont sacrifié les performances ou étaient limitées dans des scénarios applicables, qui n'ont pas résolu parfaitement ce problème.

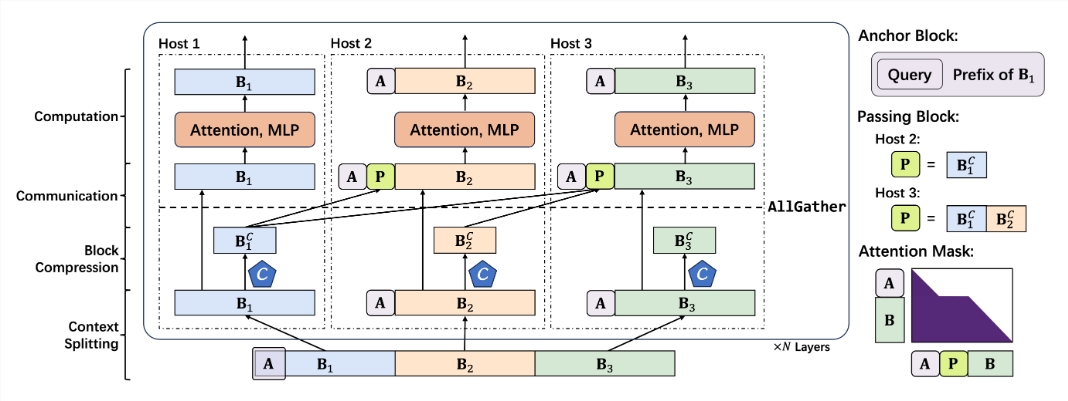

Le cadre APB évite intelligemment la "fosse" de "communication à grande échelle" et adopte une approche différente pour construire un mécanisme d'attention clairsemé à faible communication pour les scénarios parallèles de séquence. Les composants principaux de ce mécanisme comprennent:

Bloc d'ancrage plus petit: le bloc d'ancrage est comme un "navigateur" qui guide le mécanisme d'attention pour se concentrer sur les informations clés. Le cadre APB réduit la taille du bloc d'ancrage, ce qui le rend plus léger et plus flexible et réduit les frais généraux de calcul.

Bloc de passage original: Block Passing est le composant "Soul" du cadre APB, qui résout intelligemment le problème de la dépendance sémantique longue distance. En «compressant et en emballage» les informations clés traitées par le GPU de préambule et en la faisant passer au GPU suivant, chaque «membre de l'équipe» peut «voir la situation globale» et comprendre le contexte «contexte» du texte long.

Compression contextuelle de la requête: Le cadre APB introduit également un mécanisme "Away" de la requête ", permettant au compresseur de contexte de" comprendre le problème ", de filtrer et de conserver les informations clés liées à la requête plus précisément et d'améliorer encore l'efficacité et la précision.

Sur la base des "compétences uniques" ci-dessus, le cadre APB a construit un processus de raisonnement fluide et raisonnable:

Segmentation de contexte: distribuez un texte long uniformément à chaque GPU et épissez le bloc d'ancrage au début pour "enterrer" interroger le problème.

Compression de contexte: utilisez l'en-tête de rétention introduit par LOCRET pour effectuer la "compression intelligente" du cache KV.

Communication efficace: grâce à l'opérateur AllGather, le cache KV comprimé est "transmis" au GPU suivant pour construire un bloc de passage.

Calcul rapide: utilisez un noyau d'attention flash spécialement conçu et effectuez des calculs efficaces avec un masque d'attention optimisé. Bloc de passage "retraité" une fois le calcul terminé et ne participe pas aux calculs ultérieurs.

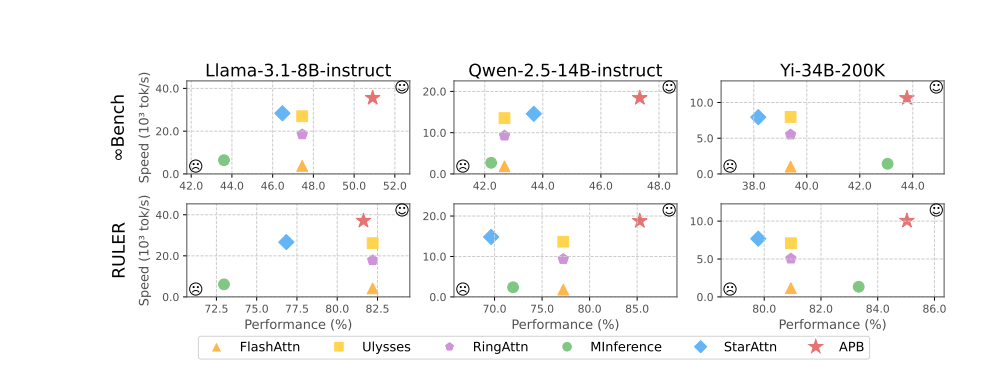

Les résultats expérimentaux démontrent avec éloquence l'excellente performance du cadre APB. Dans des tests tels que LLAMA-3.1-8B-Istruct, QWEN-2.5-14B-INSTRUCT, YI-34B-200K et plusieurs repères tels que InfiniteBench et le souverain, le cadre APB a dépassé la foule, atteignant le meilleur équilibre entre la performance et la vitesse.

Il convient de mentionner que lorsque la longueur du texte augmente, l'avantage de vitesse des cadres APB devient de plus en plus évident, et il réalise vraiment l'effet miraculeux de "devenir plus rapide et plus rapide". Le mystère derrière cela est que le cadre APB est beaucoup moins calculaire que les autres méthodes, et l'écart s'élargit à mesure que la longueur du texte augmente.

Une analyse de détresse de temps de pré-remplissage plus approfondie montre que la technologie de parallélisme de séquence elle-même peut réduire considérablement le temps de calcul de l'attention et le FFN (réseau neuronal à action directe). Le mécanisme d'attention clairsemé du cadre APB comprime davantage le temps de calcul de l'attention à l'extrême. Par rapport à l'attention des étoiles, le cadre APB utilise intelligemment le bloc de passage pour passer les dépendances sémantiques à longue distance, réduisant considérablement la taille du bloc d'ancrage, réduisant efficacement les frais généraux supplémentaires de FFN et réalisant l'effet parfait de "à la fois de la patte de poisson et d'ours".

Ce qui est encore plus excitant, c'est que le cadre APB démontre une excellente compatibilité, peut s'adapter de manière flexible à différents environnements distribués et à des échelles de modèle, et peut maintenir des performances élevées et une grande efficacité "aussi stables qu'un rocher" dans diverses conditions "dures".

On peut prévoir qu'avec l'avènement du cadre APB, le "goulot d'étranglement" du raisonnement de texte à grande échelle sera complètement brisé et l'espace d'imagination des applications d'IA sera infiniment élargi. À l'avenir, qu'il s'agisse d'un service client intelligent, d'une analyse financière, de la recherche et de l'exploration scientifiques et de la création de contenu, nous inaugurerons une nouvelle ère de l'IA qui est "plus rapide, plus forte et plus intelligente"!

Adresse du projet: https://github.com/thunlp/APB

Adresse papier: https://arxiv.org/pdf/2502.12085