大きなモデルで長いテキストを処理する「速度」にまだ夢中になっていますか?心配しないで! Tsinghua Universityは、「King Bomb」テクノロジー - APBシーケンス並列推論フレームワークを開始し、「ターボチャージャー付き」エンジンを大きなモデルに直接装備しました!実際のテストでは、超長テキストを処理する場合、この黒いテクノロジーは実際にはフラッシュの注意の10倍高速であることが示されています。そうです、あなたはそれを正しく聞いた、それは10回だ!

ChatGptなどの大きなモデルの人気があるため、AIの「読書」能力も増加しており、数万語の価値がある長い記事を処理することは問題ではないことを知っておく必要があります。しかし、大規模な情報に直面して、伝統的な大きなモデルの「脳」は少し立ち往生しています - 変圧器アーキテクチャは強力ですが、そのコアの注意メカニズムは「スーパースキャナー」のようなものです。テキストが長く、スキャン範囲の指数拡張、速度が遅くなります。

この「ボトルネック」の問題を解決するために、Tsinghua Universityの科学者は、多くの研究機関や技術の巨人と協力して別のアプローチを見つけ、APBフレームワークを開始しました。このフレームワークの核となる謎は、「シーケンスパラレル +スパースの注意」の巧妙な組み合わせにあります。

簡単に言えば、APBフレームワークは効率的な「協力」チームのようなものです。長いテキストを小さなテキストに「解体」し、複数のGPU「チームメンバー」に割り当てて並行して処理します。さらに驚くべきことは、APBに各「チームメンバー」に「ローカルKVキャッシュ圧縮」と「単純化されたコミュニケーション」スキルを装備し、それぞれのタスクを処理しながら重要な情報を効率的に共有し、長いテキストで複雑なセマンティック依存関係を共同で解決できることです。

さらに驚くべきことは、APBフレームワークがパフォーマンスを犠牲にして速度を取引していないことです。それどころか、128Kの超長いテキストテストでは、APBが速度を上昇させただけでなく、そのパフォーマンスは従来のフラッシュの注意を上回りました! Nvidiaが強く促進した星の注意でさえ、APBによってノックダウンされ、速度が1.6倍増加し、「オールラウンドエース」になりました。

この画期的なテクノロジーの最も直接的な適用は、長いテキストリクエストを処理するための大規模モデルの最初のトークン応答時間を大幅に短縮することです。これは、将来のAPBフレームワークによってユーザーの「スプレッド」の長い指示に直面している場合、APBフレームワークを備えた大きなモデルは、即座に理解し、数秒で応答し、「ロード...」の長い待機に完全に別れを告げることができることを意味します。

それでは、APBフレームワークはこのような「非自然」のスピードアップ効果をどのように達成しますか?

APBフレームワークは、長いテキスト処理の「問題点」 - 計算額を十分に認識していることがわかります。従来の注意メカニズムの計算量は、テキストの長さの平方に比例し、長いテキストは計算の「ブラックホール」です。このボトルネックを突破するために、APBフレームワークは2つの「魔法の動き」を開始しました。

最初の動き:並列性を改善し、「誰もが火を拾うために火が高い」とする

APBフレームワークは、分散コンピューティングを最大限に活用して、「マルチプレイヤーコラボレーション」のように、自然な効率を備えた複数のGPUにコンピューティングタスクを分散しています。特にシーケンスの並列性の観点から、APBフレームワークは非常に強いスケーラビリティを示し、モデル構造に限定されず、どれだけ長くてもテキストに簡単に対処できます。

2番目のトリック:無効な計算を削減し、「ブレードで良好な鋼を使用する」とします

APBフレームワークは、「一度に眉やひげをつかむ」のではなく、注意を計算するために「選択的に」であるまばらな注意メカニズムを導入します。それは、テキストの主要な情報のみに焦点を当て、無関係な部分を無視する「ファイアアイズ」を持つ専門家のようなものであり、したがって計算の量を大幅に削減します。

ただし、「パラレル」と「スパース」の2つのトリックは単純に見えますが、実際には「ミステリーを隠す」。シーケンス並列フレームワークの下で効率的なスパース注意計算を達成する方法は?これは、APBフレームワークの本当の「ハードコア」です。

シーケンスの並列環境では、各GPUにはテキスト情報の一部しかないことを知っておく必要があります。 「グローバルな認識」を達成したい場合、それは「象に触れる盲人」のようで、困難を想像することができます。スターの注意やAPEなどの以前の方法は、パフォーマンスを犠牲にしたか、適用可能なシナリオで制限されていたため、この問題を完全に解決できませんでした。

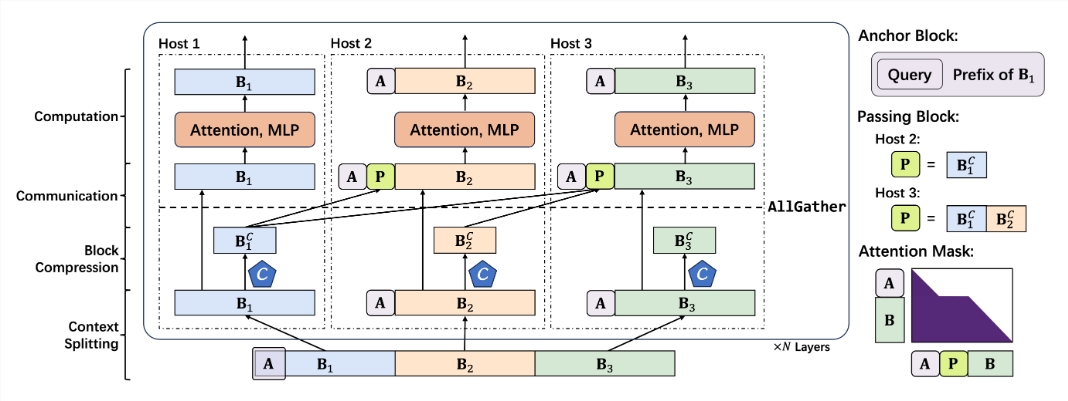

APBフレームワークは、「大規模な通信」の「ピット」を巧みに回避し、シーケンスの並列シナリオの低コミュニケーションスパース注意メカニズムを構築するために異なるアプローチを取ります。このメカニズムのコアコンポーネントには次のものがあります。

より小さなアンカーブロック:アンカーブロックは、主要な情報に焦点を合わせて注意メカニズムを導く「ナビゲーター」のようなものです。 APBフレームワークは、アンカーブロックのサイズを革新的に削減し、より軽く、より柔軟になり、オーバーヘッドをコンピューティングします。

元の通過ブロック:通過ブロックは、APBフレームワークの「ソウル」コンポーネントであり、長距離セマンティック依存の問題を巧みに解決します。 Preamble GPUによって処理され、それをその後のGPUに渡す重要な情報を「圧縮およびパッケージ化」することにより、各「チームメンバー」は「全体的な状況を表示」し、長いテキストの「コンテキスト」コンテキストを理解することができます。

クエリアウェアコンテキスト圧縮:APBフレームワークは、「クエリ認識」メカニズムを導入し、コンテキストコンプレッサーが「問題を理解」し、クエリに関連する重要な情報をより正確にフィルタリングおよび保持し、効率と精度をさらに向上させることができます。

上記の「ユニークなスキル」に基づいて、APBフレームワークはスムーズで合理的な推論プロセスを構築しました。

コンテキストセグメンテーション:各GPUに長いテキストを均等に配布し、最初にスプライスアンカーブロックを「埋める」ために問題を「埋める」ために分配します。

コンテキスト圧縮:Locretによって導入された保持ヘッダーを使用して、KVキャッシュの「スマート圧縮」を実行します。

効率的な通信:Allgatherオペレーターを通じて、圧縮されたKVキャッシュは後続のGPUに「渡され」、通過ブロックを構築します。

迅速な計算:特別に作られたフラッシュ注意カーネルを使用し、最適化された注意マスクを使用して効率的な計算を実行します。計算が完了した後、ブロック「RetireScue」を通過し、その後の計算に参加しません。

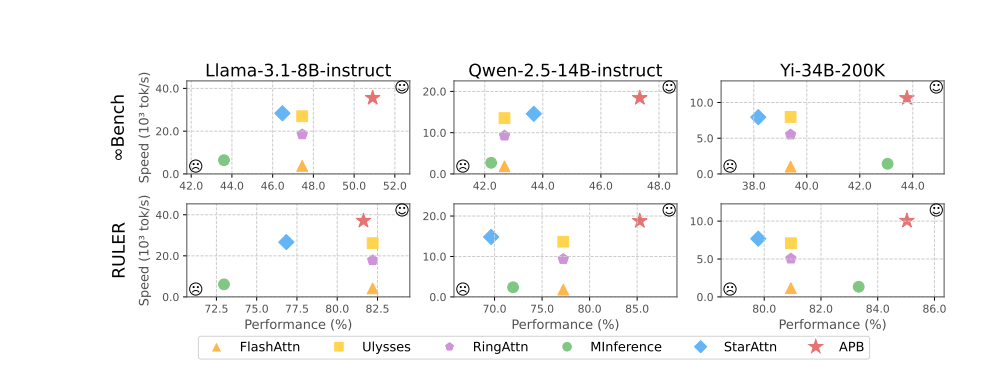

実験結果は、APBフレームワークの優れたパフォーマンスを雄弁に示しています。 llama-3.1-8b-instruct、qwen-2.5-14b-instruct、yi-34b-200k、InfinitebenchやRulerなどの複数のベンチマークなどのテストでは、APBフレームワークが群衆を上回り、パフォーマンスと速度の間の最高のバランスを達成しました。

テキストの長さが増加するにつれて、APBフレームワークの速度の利点がますます明白になり、「より速く、より速くなる」という奇跡的な効果を本当に実現することに特に言及する価値があります。この背後にある謎は、APBフレームワークが他の方法よりもはるかに計算が少なく、テキストの長さが増加するにつれてギャップが広がることです。

より詳細な事前充填タイム分解分析により、シーケンス並列性技術自体が注意の計算時間とFFN(Feedforward Neural Network)を大幅に短縮できることが示されています。 APBフレームワークのまばらな注意メカニズムは、注意計算時間を極端にさらに圧縮します。 STARの注意と比較して、APBフレームワークは、パスブロックを巧みに使用して長距離セマンティック依存関係を通過し、アンカーブロックのサイズを大幅に縮小し、FFNの追加オーバーヘッドを効果的に削減し、「魚と熊の足」の完全な効果を達成します。

さらにエキサイティングなのは、APBフレームワークが優れた互換性を示し、さまざまな分散環境やモデルスケールに柔軟に適応し、「さまざまな「硬い」条件下で「岩」のように安定した高性能と高効率を維持できることです。

APBフレームワークの出現により、大規模な長いテキスト推論の「ボトルネック」が完全に壊れ、AIアプリケーションの想像力が無限に拡大されることが予見される可能性があります。将来的には、インテリジェントな顧客サービス、財務分析、科学的研究と探求、コンテンツの作成であろうと、「より速く、強く、より賢い」AIの新しい時代を案内します!

プロジェクトアドレス:https://github.com/thunlp/apb

紙の住所:https://arxiv.org/pdf/2502.12085