¿Todavía te vuelves loco por la "velocidad" de procesar textos largos en grandes modelos? ¡No te preocupes! La Universidad de Tsinghua ha lanzado la tecnología "King Bomb": el marco de razonamiento paralelo de secuencia APB, y equipado directamente el motor "turboalimentado" a los grandes modelos. ¡Las pruebas reales muestran que al procesar texto ultra largo, esta tecnología negra es en realidad 10 veces más rápida que la atención flash! Así es, lo escuchaste bien, ¡es 10 veces!

Debe saber que con la popularidad de grandes modelos como ChatGPT, la capacidad de "lectura" de AI también ha aumentado, y no es un problema procesar artículos largos por valor de decenas de miles de palabras. Sin embargo, frente a la información masiva, el "cerebro" de los modelos grandes tradicionales es un poco atascado, aunque la arquitectura del transformador es fuerte, su mecanismo de atención central es como un "súper escáner". Cuanto más largo sea el texto, la expansión exponencial del rango de escaneo y la velocidad más lenta.

Para resolver este problema de "cuello de botella", los científicos de la Universidad de Tsinghua se han unido a muchas instituciones de investigación y gigantes de la tecnología para encontrar un enfoque diferente y lanzar un marco APB. El misterio central de este marco se encuentra en la inteligente combinación de "secuencia paralela + atención escasa".

En pocas palabras, el marco APB es como un equipo eficiente de "cooperación". "Dismunda" el texto largo en piezas pequeñas y lo asigna a múltiples "miembros del equipo" de GPU para procesarlo en paralelo. Lo que es aún más sorprendente es que APB también equipa a cada "miembro del equipo" con "compresión de caché de KV local" y habilidades de "comunicación simplificada", lo que les permite compartir eficientemente información clave mientras maneja sus respectivas tareas y resolver conjuntamente dependencias semánticas complejas en textos largos.

Lo que es aún más sorprendente es que el marco APB no cambia la velocidad a expensas del rendimiento. Por el contrario, en la prueba de texto ultra largo de 128k, APB no solo tuvo su velocidad, sino que su rendimiento superó la atención de flash tradicional. Incluso la atención de la estrella, que Nvidia promovió fuertemente, fue derribada por APB, con un aumento de velocidad de 1,6 veces, lo que lo convierte en un "as completo".

La aplicación más directa de esta tecnología innovadora es acortar significativamente el primer tiempo de respuesta token de grandes modelos para procesar solicitudes de texto largas. Esto significa que al enfrentar las largas instrucciones de la "propagación" de los usuarios por el marco APB en el futuro, el gran modelo equipado con el marco APB puede comprender instantáneamente, responder en segundos y despedirse por completo a la larga espera de "carga ...".

Entonces, ¿cómo logra el marco APB un efecto de aceleración de este "no natural"?

Resulta que el marco APB es muy consciente de los "puntos débiles" del procesamiento de texto largo: la cantidad de cálculo. La cantidad de cálculo del mecanismo de atención tradicional es proporcional al cuadrado de la longitud del texto, y el texto largo es el "agujero negro" del cálculo. Para romper este cuello de botella, el marco APB ha lanzado dos "movimientos mágicos":

El primer movimiento: mejorar el paralelismo y hacer que "el fuego sea alto para que todos recojan el fuego"

El marco APB aprovecha al máximo la computación distribuida para distribuir tareas informáticas en múltiples GPU, al igual que la "colaboración de múltiples jugadores", con eficiencia natural. Especialmente en términos de paralelismo de secuencia, el marco APB muestra una escalabilidad extremadamente fuerte, y no está limitado por la estructura del modelo, y puede hacer frente fácilmente al texto sin importar cuánto tiempo sea.

El segundo truco: reducir los cálculos no válidos y dejar que se use "buen acero en la cuchilla"

El marco APB introduce un mecanismo de atención escasa, que no es "agarrar las cejas y las barbas a la vez", sino "selectivamente" para calcular la atención. Es como un experto con "Fire Eyes" que se centra solo en la información clave en el texto e ignora las partes irrelevantes, lo que reduce en gran medida la cantidad de cálculos.

Sin embargo, los dos trucos de "paralelo" y "escaso" parecen simples, pero de hecho "esconden misterios". ¿Cómo lograr un cálculo eficiente de atención escasa bajo el marco paralelo de secuencia? Este es el verdadero "núcleo duro" del marco APB.

Debe saber que en un entorno paralelo de secuencia, cada GPU solo tiene parte de la información del texto. Si desea lograr la "percepción global", es como "un ciego que toca un elefante", y se puede imaginar la dificultad. Métodos anteriores, como la atención de la estrella y el ape, ya sea el rendimiento sacrificado o fueron limitados en escenarios aplicables, lo que no pudo resolver perfectamente este problema.

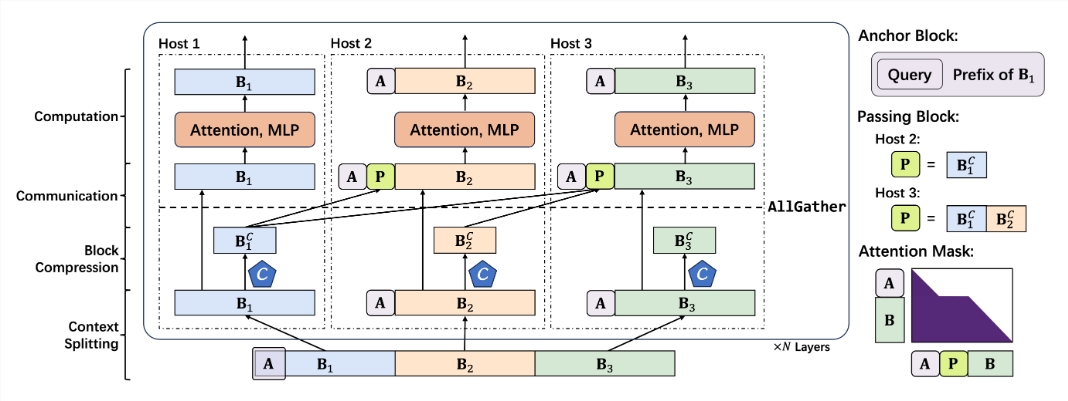

El marco APB evita hábilmente el "pozo" de la "comunicación a gran escala" y adopta un enfoque diferente para construir un mecanismo de atención escasa de baja comunicación para escenarios paralelos de secuencia. Los componentes centrales de este mecanismo incluyen:

Bloque de anclaje más pequeño: el bloque de anclaje es como un "navegador" que guía el mecanismo de atención para centrarse en la información clave. El marco de APB reduce innovativamente el tamaño del bloque de anclaje, lo que lo hace más ligero y más flexible y reduce la sobrecarga de la computación.

Bloque de pase original: el bloque de pase es el componente "Soul" del marco APB, que resuelve hábilmente el problema de la dependencia semántica de larga distancia. Al "comprimir y empacar" la información clave procesada por la GPU de preámbulo y pasarla a la GPU posterior, cada "miembro del equipo" puede "ver la situación general" y comprender el "contexto" del texto largo.

Compresión de contexto de consulta: el marco APB también introduce un mecanismo de "consulta", lo que permite que el compresor de contexto "comprenda el problema", filtre y retenga la información clave relacionada con la consulta con mayor precisión, y mejorar aún más la eficiencia y la precisión.

Basado en las "habilidades únicas" anteriores, el marco APB ha creado un proceso de razonamiento suave y razonable:

Segmentación de contexto: distribuya un texto largo de manera uniforme a cada GPU, y el bloque de anclaje de empalme al principio para "enterrar" la consulta del problema.

Compresión de contexto: use el encabezado de retención introducido por Locret para realizar una "compresión inteligente" del caché KV.

Comunicación eficiente: a través del operador AllGather, el caché KV comprimido se "pasa" a la GPU posterior para construir un bloque de pase.

Cálculo rápido: use un núcleo de atención de flash especialmente hecho y realice cálculos eficientes con una máscara de atención optimizada. El bloqueo de la "jubilación" de bloqueo después de que se complete el cálculo y no participa en los cálculos posteriores.

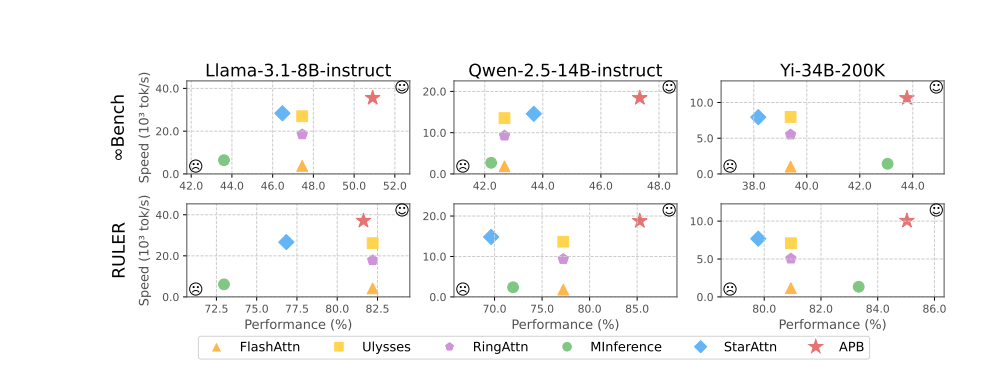

Los resultados experimentales demuestran elocuentemente el excelente rendimiento del marco APB. En pruebas como Llama-3.1-8B-Instructo, QWen-2.5-14b-Instructo, YI-34B-200K y múltiples puntos de referencia, como InfiniBench y Ruler, el marco APB superó a la multitud, logrando el mejor equilibrio entre el rendimiento y la velocidad.

Vale la pena mencionar que a medida que aumenta la longitud del texto, la ventaja de velocidad de los marcos APB se vuelve cada vez más obvio, y realmente se da cuenta del efecto milagroso de "ser más rápido y más rápido". El misterio detrás de esto es que el marco APB es mucho menos computacional que otros métodos, y la brecha se amplía a medida que aumenta la longitud del texto.

El análisis de desmontaje de tiempo previo a profundidad más detallado muestra que la tecnología de paralelismo de secuencia en sí misma puede reducir significativamente el tiempo de cálculo de atención y FFN (red neuronal de Feedforward). El escaso mecanismo de atención del marco APB comprime aún más el tiempo de cálculo de atención al extremo. En comparación con la atención de la estrella, el marco APB utiliza inteligentemente el bloque de pase para pasar dependencias semánticas a larga distancia, reduciendo en gran medida el tamaño del bloque de anclaje, reduciendo efectivamente la sobrecarga adicional de FFN y logrando el efecto perfecto de "peces y pata de oso".

Lo que es aún más emocionante es que el marco APB demuestra una excelente compatibilidad, puede adaptarse de manera flexible a diferentes entornos distribuidos y escalas de modelos, y puede mantener un alto rendimiento y una alta eficiencia "tan estable como una roca" en varias condiciones "duras".

Se puede prever que con el advenimiento del marco APB, el "cuello de botella" del razonamiento de texto largo a gran escala se rompa por completo, y el espacio de imaginación de las aplicaciones de IA se expandirá infinitamente. En el futuro, ya sea servicio al cliente inteligente, análisis financiero, investigación y exploración científica y creación de contenido, ¡marcaremos el comienzo de una nueva era de IA que es "más rápida, más fuerte e inteligente"!

Dirección del proyecto: https://github.com/thunlp/apb

Dirección en papel: https://arxiv.org/pdf/2502.12085