Immer noch verrückt nach der "Geschwindigkeit" der Verarbeitung langer Texte in großen Modellen? Mach dir keine Sorge! Die Tsinghua University hat die "King Bomb" -Technologie - APB Sequence Parallele Argumenting Framework gestartet und den "Turbogeladen" -Motor direkt zu den großen Modellen ausgestattet! Tatsächliche Tests zeigen, dass diese schwarze Technologie bei der Verarbeitung ultra langer Text tatsächlich zehnmal schneller als Flash-Aufmerksamkeit ist! Das stimmt, du hast es richtig gehört, es ist 10 Mal!

Sie sollten wissen, dass mit der Popularität großer Modelle wie ChatGPT auch AIs "Lesen" zugenommen hat, und es ist kein Problem, lange Artikel im Wert von Zehntausenden von Wörtern zu verarbeiten. Angesichts der massiven Informationen ist das "Gehirn" traditioneller großer Modelle ein wenig festgefahren - obwohl die Transformatorarchitektur stark ist, ist sein Kernmechanismus wie ein "Superscanner". Je länger der Text, die exponentielle Ausdehnung des Scanbereichs und desto langsamer die Geschwindigkeit.

Um dieses "Engpass" -Problem zu lösen, haben sich Wissenschaftler der Tsinghua University mit vielen Forschungsinstitutionen und Technologiegiganten angeschlossen, um einen anderen Ansatz zu finden, und haben einen APB -Framework auf den Markt gebracht. Das Kerngeheimnis dieses Rahmens liegt in der cleveren Kombination von "Sequenz parallel + spärliche Aufmerksamkeit".

Einfach ausgedrückt ist das APB -Framework wie ein effizientes "Kooperations" -Team. Es "zerlegt" lange Text in kleine Stücke und verteilt ihn mehreren GPUs "Teammitgliedern", um ihn parallel zu verarbeiten. Noch erstaunlicher ist, dass APB auch jedes "Teammitglied" mit "lokalen KV -Cache -Komprimierung" und "vereinfachten Kommunikationsfähigkeiten" ausstirgt, sodass sie wichtige Informationen effizient austauschen können, während sie ihre jeweiligen Aufgaben erledigen und komplexe semantische Abhängigkeiten in langen Texten gemeinsam lösen.

Noch überraschender ist, dass das APB -Framework nicht auf Kosten der Leistung handelt. Im Gegenteil, im ultra-langen Texttest von 128K war APB nicht nur seine Geschwindigkeit steigen, sondern seine Leistung übertraf die traditionelle Flash-Aufmerksamkeit! Sogar die Aufmerksamkeit der Stern, die Nvidia stark gefördert hat, wurde von APB mit einer Geschwindigkeit von 1,6-mal niedergeschlagen, was es zu einem "Allround-Ass" machte.

Die direkteste Anwendung dieser Durchbruchstechnologie besteht darin, die erste Token -Reaktionszeit großer Modelle für die Verarbeitung langer Textanfragen erheblich zu verkürzen. Dies bedeutet, dass das große Modell, das mit dem APB -Framework ausgestattet ist, bei der langen Anweisungen der "Verbreitung" der Benutzer durch das APB -Framework sofort verstehen, in Sekundenschnelle reagieren und sich vollständig von der langen Wartezeit von "Laden ..." verabschieden.

Wie erreicht das APB-Framework einen solchen "nicht der Natur" beschleunigten Effekt?

Es stellt sich heraus, dass sich das APB -Framework der "Schmerzpunkte" der langen Textverarbeitung - Berechnungsbetrag - bewusst ist. Die Berechnung des traditionellen Aufmerksamkeitsmechanismus ist proportional zum Quadrat der Textlänge, und langer Text ist das "schwarze Loch" der Berechnung. Um diesen Engpass zu durchbrechen, hat das APB -Framework zwei "magische Bewegungen" auf den Markt gebracht:

Der erste Schritt: Verbesserung der Parallelität und machen Sie "Das Feuer ist für alle hoch, um Feuer zu holen".

Das APB-Framework nutzt das verteilte Computing voll aus, um Computeraufgaben über mehrere GPUs wie "Multi-Player Collaboration" mit natürlicher Effizienz zu verteilen. Insbesondere in Bezug auf die Sequenzparallelität zeigt das APB -Framework eine äußerst starke Skalierbarkeit und ist durch die Modellstruktur nicht begrenzt und kann leicht mit dem Text fertig werden, egal wie lange er dauert.

Der zweite Trick: Reduzieren Sie ungültige Berechnungen und lassen Sie "Gutstahl für die Klinge verwendet".

Das APB -Framework führt einen spärlichen Aufmerksamkeitsmechanismus ein, der nicht "die Augenbrauen und Bärte gleichzeitig greifen", sondern "selektiv", um die Aufmerksamkeit zu berechnen. Es ist wie ein Experte mit "Feueraugen", der sich nur auf Schlüsselinformationen im Text konzentriert und irrelevante Teile ignoriert und so die Anzahl der Berechnungen erheblich verringert.

Die beiden Tricks von "parallel" und "spärlich" scheinen jedoch einfach zu sein, aber tatsächlich "verbergen sie Geheimnisse". Wie kann man im Rahmen des sequenz parallelen Frameworks eine effiziente Aufmerksamkeitsberechnung erreichen? Dies ist der wahre "harte Kern" des APB -Frameworks.

Sie sollten wissen, dass jede GPU in einer sequenz parallele Umgebung nur einen Teil der Textinformationen hat. Wenn Sie "globale Wahrnehmung" erreichen möchten, ist es wie "ein Blinder, der einen Elefanten berührt", und die Schwierigkeit kann sich vorstellen. Frühere Methoden wie die Aufmerksamkeit von Stern und APE opferten entweder die Leistung oder waren in anwendbaren Szenarien begrenzt, die dieses Problem nicht perfekt lösen konnten.

Der APB-Framework vermeidet geschickt die "Grube" der "groß angelegten Kommunikation" und verfolgt einen anderen Ansatz, um einen spärlichen Aufmerksamkeitsmechanismus mit niedriger Unterricht für sequenzparallele Szenarien aufzubauen. Zu den Kernkomponenten dieses Mechanismus gehören:

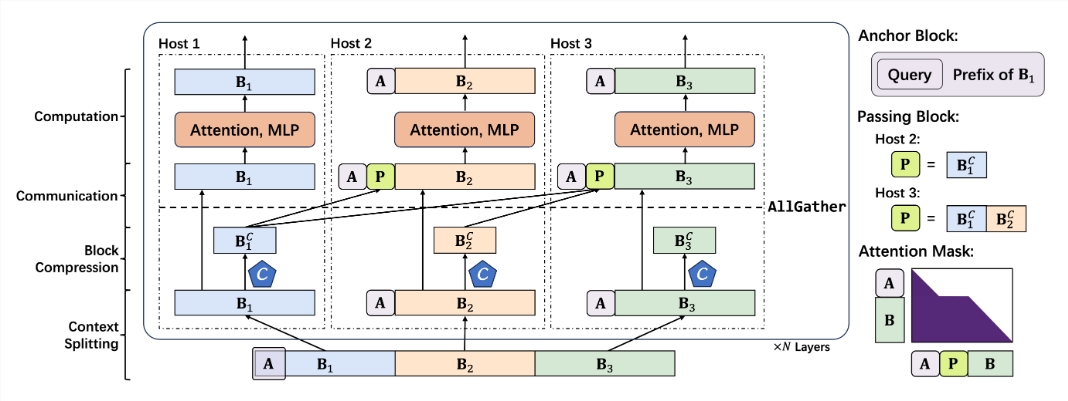

Kleiner Ankerblock: Ankerblock ist wie ein "Navigator", der den Aufmerksamkeitsmechanismus leitet, um sich auf wichtige Informationen zu konzentrieren. Das APB -Framework reduziert innovativ die Größe des Ankerblocks, wodurch er leichter und flexibler und das Rechenaufwand reduziert wird.

Original Passion Block: Passing Block ist die "Seele" -Komponente des APB-Frameworks, die das Problem der semantischen Abhängigkeit von Fernstöcken geschickt löst. Durch "Komprimieren und Verpacken" der wichtigsten Informationen, die von der Preamble -GPU verarbeitet und an die nachfolgende GPU weitergegeben werden, kann jedes "Teammitglied" die Gesamtsituation "anzeigen" und den "Kontext" -Kontext des langen Textes verstehen.

Abfragebeständige Kontextkomprimierung: Das APB-Framework führt auch einen "Abfrage-bewussten" -Mechanismus ein, der es dem Kontextkompressor ermöglicht, "das Problem zu verstehen", die wichtigsten Informationen im Zusammenhang mit der Abfrage genauer zu filtern und beizubehalten und die Effizienz und Genauigkeit weiter zu verbessern.

Basierend auf den obigen "einzigartigen Fähigkeiten" hat das APB -Framework einen reibungslosen und angemessenen Argumentationsprozess aufgebaut:

Kontextsegmentierung: Verbreiten Sie den langen Text gleichmäßig auf jede GPU und Spleißankerblock am Anfang, um das Problem zu "begraben".

Kontextkomprimierung: Verwenden Sie den von LOCRET eingeführten Retention -Header, um "Smart Compression" des KV -Cache durchzuführen.

Effiziente Kommunikation: Durch den Allgather -Bediener wird der komprimierte KV -Cache an die nachfolgende GPU "übergeben", um einen vorbeifahrenden Block zu erstellen.

Schnelle Berechnung: Verwenden Sie einen speziell hergestellten Flash -Aufmerksamkeitskern und führen Sie effiziente Berechnungen mit einer optimierten Aufmerksamkeitsmaske durch. Das Übergebenen von Block "Retirescue" nach Abschluss der Berechnung und beteiligt sich nicht an nachfolgenden Berechnungen.

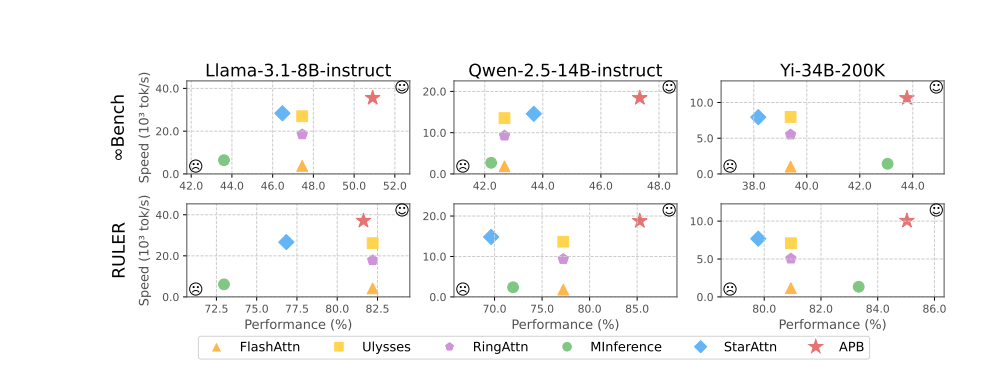

Die experimentellen Ergebnisse zeigen eloquent die hervorragende Leistung des APB -Frameworks. In Tests wie LLAMA-3.1-8B-Instruct, Qwen-2.5-14B-Instruct, Yi-34B-200K und mehreren Benchmarks wie Infinitebench und Lineal übertraf das APB-Framework die Menge und erreichte das beste Gleichgewicht zwischen Leistung und Geschwindigkeit.

Es ist besonders erwähnenswert, dass mit zunehmender Textlänge der Geschwindigkeitsvorteil von APB -Frameworks immer offensichtlicher wird und der wundersame Effekt "immer schneller werden" erkennt. Das Geheimnis dahinter ist, dass das APB -Framework viel weniger rechnerisch ist als andere Methoden, und die Lücke erweitert sich mit zunehmender Textlänge.

Eine detailliertere Treardown-Analyse vor dem Abfüllen zeigt, dass die Sequenzparallelitätstechnologie selbst die Berechnungszeit von Aufmerksamkeit und FFN (Feedforward Neural Network) erheblich verkürzen kann. Der spärliche Aufmerksamkeitsmechanismus des APB -Frameworks komprimiert die Aufmerksamkeitsberechnungserhalt bis zum Extrem. Im Vergleich zur Aufmerksamkeit der Sterns nutzt das APB-Gerüst geschickt den bestehenden Block, um die semantischen Abhängigkeiten von Fernunterlagen zu verabschieden, wodurch die Größe des Ankerblocks stark reduziert wird, wodurch der zusätzliche Overhead von FFN effektiv reduziert wird und die perfekte Wirkung von "sowohl Fisch- als auch Bärenpfote" erreicht.

Noch aufregender ist, dass das APB -Framework eine hervorragende Kompatibilität zeigt, sich flexibel an verschiedene verteilte Umgebungen und Modellskalen anpassen kann und eine hohe Leistung und hohe Effizienz "unter verschiedenen" harten "Bedingungen so stabil wie ein Gestein" aufrechterhalten kann.

Es kann vorausgesehen werden, dass mit dem Aufkommen des APB-Frameworks der "Engpass" des groß angelegten langen Textes vollständig gebrochen sein wird und der Vorstellungsraum der AI-Anwendungen unendlich erweitert wird. In Zukunft, ob es sich um einen intelligenten Kundendienst, die Finanzanalyse, die wissenschaftliche Forschung und Erkundung sowie die Erstellung von Inhalten handelt, werden wir eine neue Ära der KI einleiten, die "schneller, stärker und intelligenter" ist!

Projektadresse: https://github.com/thunlp/apb

Papieradresse: https://arxiv.org/pdf/2502.12085