Masih tergila -gila dengan "kecepatan" memproses teks panjang dalam model besar? Jangan khawatir! Tsinghua University telah meluncurkan Teknologi "King Bomb" - Rangka Penetapan Paralel Paralel APB, dan secara langsung melengkapi mesin "turbocharged" dengan model besar! Tes aktual menunjukkan bahwa ketika memproses teks ultra-panjang, teknologi hitam ini sebenarnya 10 kali lebih cepat daripada perhatian flash! Benar, Anda mendengarnya dengan benar, 10 kali!

Anda harus tahu bahwa dengan popularitas model besar seperti chatgpt, kemampuan "membaca" AI juga meningkat, dan tidak masalah untuk memproses artikel panjang yang bernilai puluhan ribu kata. Namun, dalam menghadapi informasi besar -besaran, "otak" model besar tradisional agak macet - meskipun arsitektur transformator kuat, mekanisme perhatian intinya seperti "pemindai super". Semakin lama teks, perluasan eksponensial dari rentang pemindaian, dan semakin lambat kecepatannya.

Untuk mengatasi masalah "hambatan" ini, para ilmuwan dari Universitas Tsinghua telah bergandengan tangan dengan banyak lembaga penelitian dan raksasa teknologi untuk menemukan pendekatan yang berbeda dan meluncurkan kerangka kerja APB. Misteri inti dari kerangka kerja ini terletak pada kombinasi cerdas dari "urutan paralel + perhatian jarang".

Sederhananya, kerangka kerja APB seperti tim "kerja sama" yang efisien. Ini "mengingkari" teks panjang menjadi potongan -potongan kecil dan mengalokasikannya ke beberapa "anggota tim" GPU untuk memprosesnya secara paralel. Yang lebih menakjubkan adalah bahwa APB juga melengkapi setiap "anggota tim" dengan "kompresi cache KV lokal" dan keterampilan "komunikasi yang disederhanakan", memungkinkan mereka untuk berbagi informasi kunci secara efisien sambil menangani tugas masing -masing dan secara bersama -sama memecahkan ketergantungan semantik yang kompleks dalam teks panjang.

Yang lebih mengejutkan adalah bahwa kerangka kerja APB tidak menukar kecepatan dengan mengorbankan kinerja. Sebaliknya, dalam uji teks ultra-panjang 128k, APB tidak hanya memiliki kecepatan melonjak, tetapi kinerjanya melampaui perhatian flash tradisional! Bahkan perhatian bintang, yang dipromosikan Nvidia dengan kuat, dirobohkan oleh APB, dengan peningkatan kecepatan 1,6 kali, menjadikannya "ace serba".

Aplikasi paling langsung dari teknologi terobosan ini adalah secara signifikan mempersingkat waktu respons token pertama dari model besar untuk memproses permintaan teks panjang. Ini berarti bahwa ketika menghadapi instruksi panjang dari "penyebaran" pengguna oleh kerangka kerja APB di masa depan, model besar yang dilengkapi dengan kerangka APB dapat secara instan memahami, merespons dalam hitungan detik, dan sepenuhnya mengucapkan selamat tinggal lama untuk menunggu lama "memuat ...".

Jadi, bagaimana kerangka kerja APB mencapai efek percepatan "non-alam" seperti itu?

Ternyata kerangka APB sangat menyadari "titik nyeri" dari pemrosesan teks panjang - jumlah perhitungan. Jumlah perhitungan mekanisme perhatian tradisional sebanding dengan kuadrat panjang teks, dan teks panjang adalah "lubang hitam" perhitungan. Untuk menerobos kemacetan ini, kerangka APB telah meluncurkan dua "gerakan ajaib":

Langkah pertama: Meningkatkan paralelisme dan membuat "api sangat tinggi bagi semua orang untuk mengambil api"

Kerangka APB memanfaatkan sepenuhnya komputasi terdistribusi untuk mendistribusikan tugas komputasi di berbagai GPU, seperti "kolaborasi multi-pemain", dengan efisiensi alami. Terutama dalam hal paralelisme urutan, kerangka kerja APB menunjukkan skalabilitas yang sangat kuat, dan tidak dibatasi oleh struktur model, dan dapat dengan mudah mengatasi teks tidak peduli berapa lama itu.

Trik kedua: Kurangi perhitungan yang tidak valid dan biarkan "baja yang baik digunakan pada bilah"

Kerangka APB memperkenalkan mekanisme perhatian yang jarang, yang tidak "ambil alis dan janggut sekaligus", tetapi "secara selektif" untuk menghitung perhatian. Ini seperti ahli dengan "mata api" yang hanya berfokus pada informasi utama dalam teks dan mengabaikan bagian yang tidak relevan, sehingga sangat mengurangi jumlah perhitungan.

Namun, dua trik "paralel" dan "jarang" tampak sederhana, tetapi sebenarnya mereka "menyembunyikan misteri". Bagaimana cara mencapai perhitungan perhatian jarang yang efisien di bawah kerangka paralel urutan? Ini adalah "inti keras" yang sebenarnya dari kerangka kerja APB.

Anda harus tahu bahwa dalam lingkungan paralel urutan, setiap GPU hanya memiliki bagian dari informasi teks. Jika Anda ingin mencapai "persepsi global", itu seperti "orang buta yang menyentuh gajah", dan kesulitannya dapat dibayangkan. Metode sebelumnya seperti perhatian bintang dan kera baik berkorban kinerja atau terbatas dalam skenario yang berlaku, yang gagal menyelesaikan masalah ini dengan sempurna.

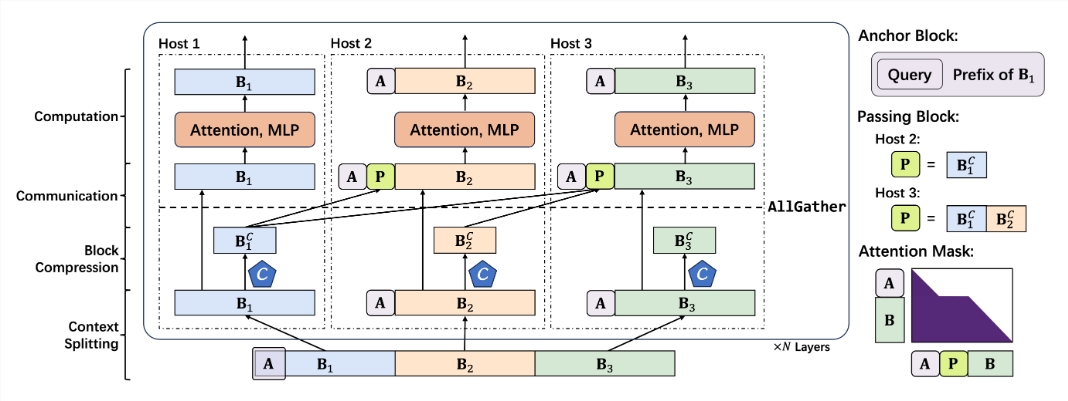

Kerangka APB secara cerdik menghindari "lubang" dari "komunikasi skala besar" dan mengambil pendekatan yang berbeda untuk membangun mekanisme perhatian jarang komunikasi rendah untuk skenario paralel urutan. Komponen inti dari mekanisme ini meliputi:

Blok jangkar yang lebih kecil: Blok jangkar seperti "navigator" yang memandu mekanisme perhatian untuk fokus pada informasi utama. Kerangka APB secara inovatif mengurangi ukuran blok jangkar, membuatnya lebih ringan dan lebih fleksibel dan mengurangi komputasi overhead.

Blok passing asli: Blok yang lewat adalah komponen "jiwa" dari kerangka kerja APB, yang secara cerdik memecahkan masalah ketergantungan semantik jarak jauh. Dengan "mengompresi dan mengemas" informasi utama yang diproses oleh GPU pembukaan dan meneruskannya ke GPU berikutnya, masing -masing "anggota tim" dapat "melihat situasi keseluruhan" dan memahami konteks "konteks" teks panjang.

Kompresi konteks yang sadar query: Kerangka kerja APB juga memperkenalkan mekanisme "query-sware", yang memungkinkan kompresor konteks untuk "memahami masalah", memfilter dan menyimpan informasi kunci yang terkait dengan kueri lebih akurat, dan lebih lanjut meningkatkan efisiensi dan akurasi.

Berdasarkan "keterampilan unik" di atas, kerangka kerja APB telah membangun proses penalaran yang mulus dan masuk akal:

Segmentasi Konteks: Mendistribusikan teks panjang secara merata ke setiap GPU, dan sambungan blok jangkar di awal untuk "mengubur" permintaan masalah.

Kompresi Konteks: Gunakan header retensi yang diperkenalkan oleh Locret untuk melakukan "kompresi pintar" dari cache KV.

Komunikasi yang efisien: Melalui operator AllGather, cache KV terkompresi "diteruskan" ke GPU berikutnya untuk membangun blok yang lewat.

Perhitungan cepat: Gunakan kernel perhatian flash yang dibuat khusus, dan lakukan perhitungan yang efisien dengan masker perhatian yang dioptimalkan. Blok lewat "pensiunan" setelah perhitungan selesai dan tidak berpartisipasi dalam perhitungan selanjutnya.

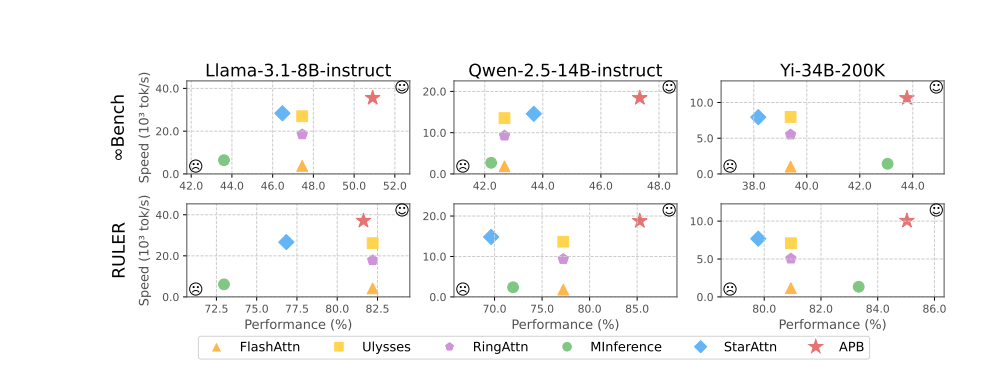

Hasil eksperimen dengan fasih menunjukkan kinerja yang sangat baik dari kerangka APB. Dalam tes seperti LLAMA-3.1-8B-instruct, Qwen-2.5-14b-instruct, Yi-34b-200k dan beberapa tolok ukur seperti Infinitebench dan penguasa, kerangka kerja APB melampaui kerumunan, mencapai keseimbangan terbaik antara kinerja dan kecepatan.

Perlu disebutkan bahwa ketika panjang teks meningkat, keuntungan kecepatan kerangka kerja APB menjadi semakin jelas, dan itu benar -benar menyadari efek ajaib dari "menjadi lebih cepat dan lebih cepat". Misteri di balik ini adalah bahwa kerangka APB jauh lebih sedikit komputasi daripada metode lain, dan celah melebar ketika panjang teks meningkat.

Analisis robekan waktu pra-pengisian yang lebih mendalam menunjukkan bahwa teknologi paralelisme sekuens itu sendiri dapat secara signifikan mengurangi waktu perhitungan perhatian dan FFN (jaringan saraf feedforward). Mekanisme perhatian yang jarang dari kerangka kerja APB semakin menekan waktu perhitungan perhatian ke ekstrem. Dibandingkan dengan perhatian bintang, kerangka kerja APB secara cerdik menggunakan blok yang lewat untuk melewati dependensi semantik jarak jauh, sangat mengurangi ukuran blok jangkar, secara efektif mengurangi overhead tambahan FFN, dan mencapai efek sempurna dari "Fish dan Bear's Paw".

Yang lebih menarik adalah bahwa kerangka kerja APB menunjukkan kompatibilitas yang sangat baik, dapat secara fleksibel beradaptasi dengan lingkungan terdistribusi yang berbeda dan skala model, dan dapat mempertahankan kinerja tinggi dan efisiensi tinggi "sama stabilnya dengan batuan" di bawah berbagai kondisi "keras".

Dapat diramalkan bahwa dengan munculnya kerangka kerja APB, "kemacetan" penalaran teks panjang skala besar akan benar-benar rusak, dan ruang imajinasi aplikasi AI akan diperluas secara tak terbatas. Di masa depan, apakah itu layanan pelanggan yang cerdas, analisis keuangan, penelitian ilmiah dan eksplorasi, dan pembuatan konten, kami akan mengantarkan era baru AI yang "lebih cepat, lebih kuat, dan lebih pintar"!

Alamat Proyek: https://github.com/thunlp/apb

Alamat kertas: https://arxiv.org/pdf/2502.12085