在人工智能領域,一項顛覆性的技術正在悄然興起。近日,Inception Labs 宣布推出Mercury 系列擴散大型語言模型(dLLMs),這是一種新一代的語言模型,旨在快速、高效地生成高質量文本。與傳統的自回歸大型語言模型相比,Mercury 在生成速度上提高了多達10倍,能夠在NVIDIA H100顯卡上實現超過每秒1000個標記的速度,這一速度在以往僅依靠定制芯片才能實現。

Mercury 系列的首款產品Mercury Coder,已在公共測試中亮相。該模型專注於代碼生成,展現了出色的性能,並且在多個編程基準測試中超越了許多現有的速度優化模型,如GPT-4o Mini 和Claude3.5Haiku,同時在速度上也快了近10倍。根據開發者反饋,Mercury 的代碼完成效果更受歡迎,在C opilot Arena 的測試中,Mercury Coder Mini 在性能上名列前茅,並且是最快的模型之一。

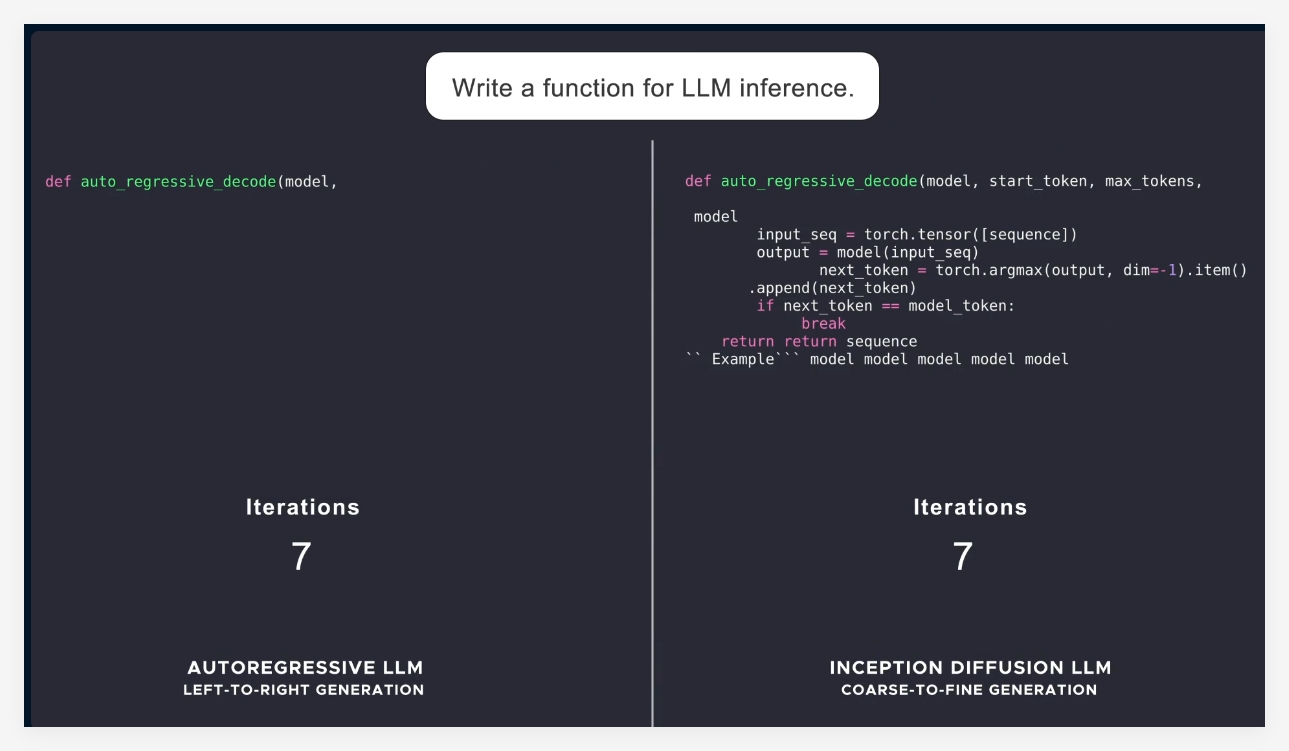

當前的語言模型大多采用自回歸方式,即從左到右逐個生成標記,導致生成過程不可避免地是順序的,延遲和計算成本較高。而Mercury 則採用“粗到細” 的生成方式,從純噪聲開始,經過幾次“去噪” 步驟,逐步精細化輸出。這使得Mercury 模型能夠在生成時進行多標記的並行處理,從而實現更好的推理和結構化響應能力。

隨著Mercury 系列的推出,Inception Labs 展示了擴散模型在文本和代碼生成領域的巨大潛力。接下來,公司還計劃推出適用於聊天應用的語言模型,進一步拓展擴散語言模型的應用場景。這些新型模型將具備更強的智能代理能力,能夠進行複雜的規劃和長時間的生成。同時,它們的高效性使得在資源受限的設備上也能運行良好,例如智能手機和筆記本電腦。

總的來看,Mercury 的推出標誌著人工智能技術的一次重要進步,不僅在速度和效率上大幅提升,也為行業提供了更高質量的解決方案。

官方介紹:https://www.inceptionlabs.ai/news

在線體驗:https://chat.inceptionlabs.ai/

劃重點:

Mercury 系列擴散大型語言模型(dLLMs)推出,生成速度提高至每秒1000個標記。

Mercury Coder 專注於代碼生成,在基準測試中超越眾多現有模型,表現優異。

擴散模型的創新方式使得文本生成更加高效、精準,為智能代理應用提供新的可能性。