Auf dem Gebiet der künstlichen Intelligenz entsteht eine disruptive Technologie. Kürzlich kündigte Inception Labs die Einführung der Mercury-Serie von Diffusion großer Sprachmodellen (DLLMS) an, einer neuen Generation von Sprachmodellen, die schnell und effizient qualitativ hochwertiger Text erzeugen sollen. Im Vergleich zum traditionellen autoregressiven Großsprachmodell hat Mercury die Geschwindigkeit der Erzeugung um bis zu 10 Mal erhöht, was mehr als 1.000 Markierungen pro Sekunde auf NVIDIA H100 -Grafikkarten ermöglicht, eine Geschwindigkeit, die zuvor nur durch benutzerdefinierte Chips erreicht wurde.

Mercury Coder, das erste Produkt in der Mercury -Reihe, wurde in öffentlichen Tests vorgestellt. Das Modell konzentriert sich auf die Codegenerierung, zeigt eine hervorragende Leistung und übertrifft viele vorhandene Geschwindigkeitsoptimierungsmodelle in mehreren Programmierbenchmarks, wie z. Laut dem Entwickler -Feedback ist Mercurys Code -Abschluss beliebter. Im Test der C opilot Arena zählt der Mercury -Coder Mini zu den Top -Leistungen und ist eines der schnellsten Modelle.

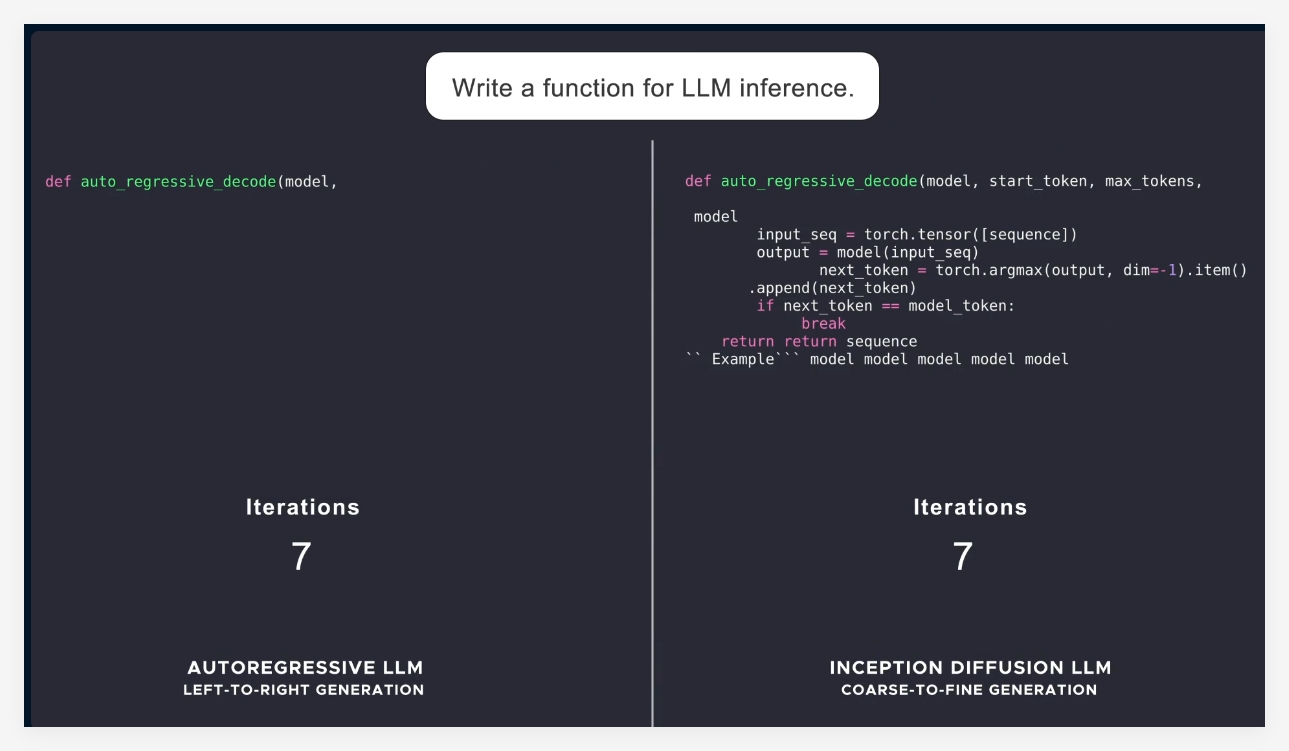

Die meisten aktuellen Sprachmodelle nehmen Autoregression an, dh Tags von links nach rechts und führt dazu, dass der Erzeugungsprozess unweigerlich sequentiell ist und mit hohen Latenz- und Berechnungskosten. Mercury verwendet eine "grobe bis feine" Generierungsmethode, beginnend mit reinem Rauschen, und verfeinert die Ausgabe nach mehreren "demoising" -Erschritten allmählich. Auf diese Weise können Quecksilbermodelle parallel zu mehreren Tags bei der Generation verarbeitet werden, um eine bessere Inferenz und eine strukturierte Reaktionsfähigkeit zu ermöglichen.

Mit dem Start der Mercury -Serie demonstriert Inception Labs das große Potenzial von Diffusionsmodellen in den Feldern der Text- und Codegenerierung. Als nächstes plant das Unternehmen auch, ein Sprachmodell zu starten, das für Chat -Anwendungen geeignet ist, um die Anwendungsszenarien des Diffusionsprachmodells weiter zu erweitern. Diese neuen Modelle werden stärker intelligente Proxy-Funktionen haben, die zu komplexer Planung und langfristiger Generation in der Lage sind. Gleichzeitig funktioniert es bei ihrer Effizienz gut auf ressourcenbezogenen Geräten wie Smartphones und Laptops.

Insgesamt ist der Start von Mercury einen wichtigen Fortschritt in der Technologie für künstliche Intelligenz und verbessert nicht nur die Geschwindigkeit und Effizienz, sondern bietet auch Lösungen für höhere Qualität für die Branche.

Offizielle Einführung: https://www.inceptionlabs.ai/news

Online -Erfahrung: https://chat.inceptionlabs.ai/

Schlüsselpunkte:

Die Mercury -Serie von Diffusion großsprachigen Modellen (DLLMs) wird gestartet, wobei die Geschwindigkeiten der Erzeugung auf 1.000 Markierungen pro Sekunde erhöht werden.

Mercury Codierer konzentriert sich auf die Codegenerierung und übertrifft viele vorhandene Modelle im Benchmarking und funktioniert gut.

Die innovativen Möglichkeiten der Diffusionsmodelle machen die Textgenerierung effizienter und genauerer und bieten neue Möglichkeiten für intelligente Proxy -Anwendungen.