En el campo de la inteligencia artificial, una tecnología disruptiva está emergiendo silenciosamente. Recientemente, Inception Labs anunció el lanzamiento de la serie Mercury de modelos de lenguaje de difusión (DLLMS), una nueva generación de modelos de lenguaje diseñados para generar texto de alta calidad de manera rápida y eficiente. En comparación con el modelo de lenguaje grande autorregresivo tradicional, el mercurio ha aumentado la velocidad de generación hasta 10 veces, lo que permite más de 1,000 marcadores por segundo en tarjetas gráficas NVIDIA H100, una velocidad que previamente se logró solo con chips personalizados.

Mercury Coder, el primer producto de la serie Mercury, ha sido presentado en pruebas públicas. El modelo se centra en la generación de código, demuestra un excelente rendimiento y supera muchos modelos de optimización de velocidad existentes en múltiples puntos de referencia de programación, como el GPT-4O Mini y Claude3.5haiku, mientras que también es casi 10 veces más rápido en velocidad. Según la retroalimentación del desarrollador, la finalización del código de Mercury es más popular. En la prueba de C Opilot Arena, el Mercury Coder Mini se ubica entre el rendimiento superior y es uno de los modelos más rápidos.

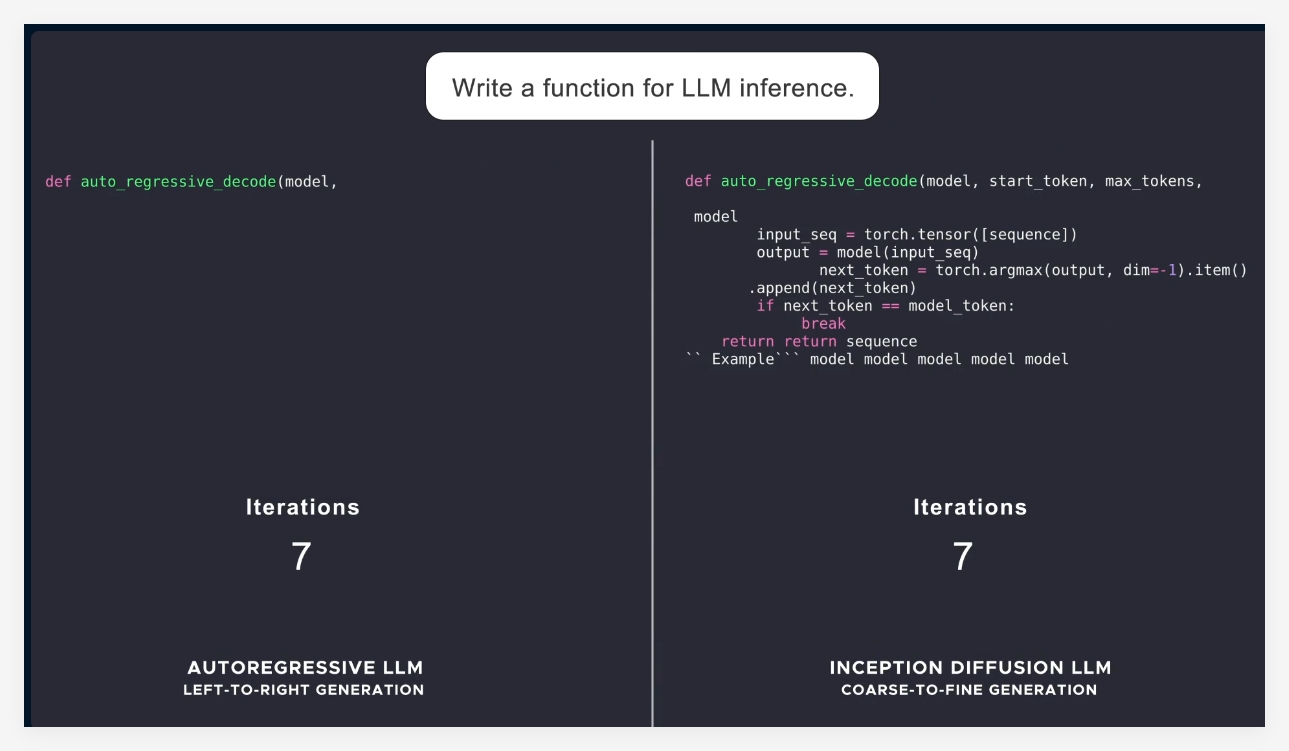

La mayoría de los modelos de idiomas actuales adoptan la autorregresión, es decir, generan etiquetas una por una de izquierda a derecha, lo que resulta en que el proceso de generación sea inevitablemente secuencial, con altos costos de latencia y cálculo. Mercury utiliza un método de generación "grueso a fino", comenzando desde el ruido puro, y refina gradualmente la salida después de varios pasos de "cenovación". Esto permite que los modelos de mercurio se procesen en paralelo con múltiples etiquetas en la generación, lo que permite una mejor inferencia y capacidad de respuesta estructurada.

Con el lanzamiento de la serie Mercury, Inception Labs demuestra el gran potencial de los modelos de difusión en los campos de texto y generación de códigos. A continuación, la compañía también planea lanzar un modelo de idioma adecuado para aplicaciones de chat para expandir aún más los escenarios de aplicación del modelo de lenguaje de difusión. Estos nuevos modelos tendrán capacidades proxy inteligentes más fuertes, capaces de planificación compleja y generación a largo plazo. Al mismo tiempo, su eficiencia hace que funcione bien en dispositivos con recursos limitados, como teléfonos inteligentes y computadoras portátiles.

En general, el lanzamiento de Mercurio marca un avance importante en la tecnología de inteligencia artificial, no solo mejora en gran medida la velocidad y la eficiencia, sino que también proporciona soluciones de mayor calidad a la industria.

Introducción oficial: https://www.inceptionlabs.ai/news

Experiencia en línea: https://chat.inceptionlabs.ai/

Puntos clave:

Se lanzan la serie de Mercurio de modelos de lenguaje grande de difusión (DLLMS), con velocidades de generación aumentadas a 1,000 marcadores por segundo.

Mercury Coder se centra en la generación de códigos y supera a muchos modelos existentes en la evaluación comparativa y funciona bien.

Las formas innovadoras de modelos de difusión hacen que la generación de texto sea más eficiente y precisa, proporcionando nuevas posibilidades para aplicaciones de proxy inteligentes.