Dans le domaine de l'intelligence artificielle, une technologie perturbatrice émerge tranquillement. Récemment, Inception Labs a annoncé le lancement de la série Mercury de modèles de langage de grande diffusion (DLLMS), une nouvelle génération de modèles linguistiques conçus pour générer du texte de haute qualité rapidement et efficacement. Par rapport au modèle traditionnel de grande langue autorégressif, Mercure a augmenté la vitesse de production jusqu'à 10 fois, permettant plus de 1 000 marqueurs par seconde sur les cartes graphiques NVIDIA H100, une vitesse qui était précédemment réalisée uniquement par des puces personnalisées.

Mercury Coder, le premier produit de la série Mercury, a été dévoilé dans les tests publics. Le modèle se concentre sur la génération de code, démontre d'excellentes performances et dépasse de nombreux modèles d'optimisation de vitesse existants dans plusieurs repères de programmation, tels que le GPT-4O Mini et Claude3.5 HAIKU, tout en étant presque plus rapide en vitesse. Selon les commentaires du développeur, l'achèvement du code de Mercury est plus populaire. Dans le test de C Opilot Arena, le Mercury Coder Mini se classe parmi le haut de la performance et est l'un des modèles les plus rapides.

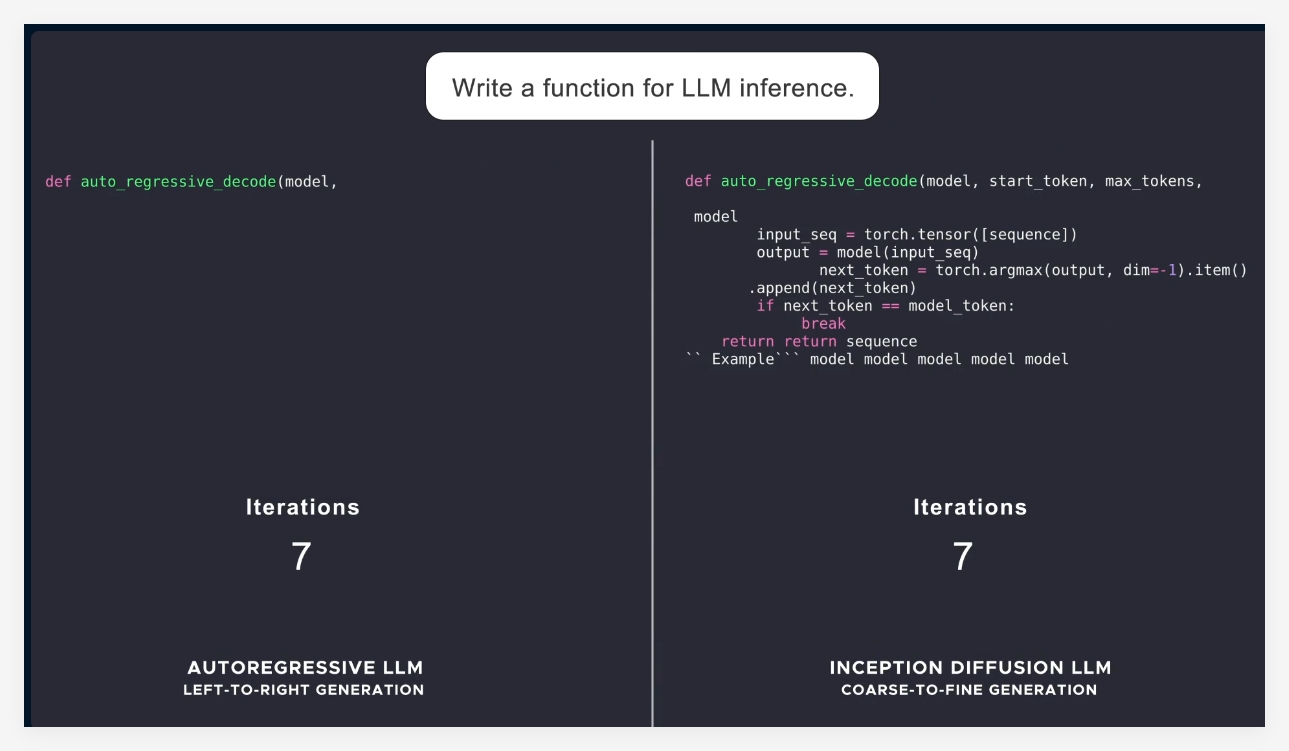

La plupart des modèles de langage actuels adoptent l'autorégression, c'est-à-dire générer des balises un par un de gauche à droite, ce qui entraîne le processus de génération inévitablement séquentiel, avec des coûts de latence et de calcul élevés. Mercury utilise une méthode de génération "grossière à amende", à partir du bruit pur, et affine progressivement la sortie après plusieurs étapes de "déniisation". Cela permet de traiter les modèles de mercure en parallèle avec plusieurs balises à la génération, permettant une meilleure inférence et une réactivité structurée.

Avec le lancement de la série Mercury, Inception Labs démontre le grand potentiel des modèles de diffusion dans les champs de la génération de texte et de code. Ensuite, la société prévoit également de lancer un modèle linguistique adapté aux applications de chat afin d'étendre davantage les scénarios d'application du modèle de langage de diffusion. Ces nouveaux modèles auront des capacités de proxy intelligents plus solides, capables d'une planification complexe et d'une génération à long terme. Dans le même temps, leur efficacité le fait bien fonctionner sur les appareils liés aux ressources, tels que les smartphones et les ordinateurs portables.

Dans l'ensemble, le lancement de Mercury marque une avancée importante dans la technologie de l'intelligence artificielle, non seulement améliorant considérablement la vitesse et l'efficacité, mais offrant également des solutions de meilleure qualité à l'industrie.

Introduction officielle: https://www.inceptionLabs.ai/news

Expérience en ligne: https://chat.inceptionLabs.ai/

Points clés:

La série Mercury de modèles de diffusion en grande langue (DLLM) est lancée, les vitesses de production augmentées à 1 000 marqueurs par seconde.

Mercury Coder se concentre sur la génération de code et surpasse de nombreux modèles existants en analyse comparative et fonctionne bien.

Les modes de diffusion innovants rendent la génération de texte plus efficace et précise, offrant de nouvelles possibilités pour les applications proxy intelligentes.