2024年7月3日,上海人工智能实验室携手商汤科技,联合香港中文大学和复旦大学,共同发布了新一代大语言模型——书生·浦语2.5(InternLM2.5)。这一发布标志着中国在人工智能领域的技术创新迈出了重要一步,尤其是在大语言模型的研究与应用方面取得了显著进展。

InternLM2.5-7B模型已正式开源,其他规模的模型也将陆续向公众开放。上海人工智能实验室承诺将继续提供免费的商用授权,并通过高质量的开源模型支持全球社区的创新与发展。这一举措不仅降低了人工智能技术的应用门槛,也为全球开发者提供了更多的创新机会。

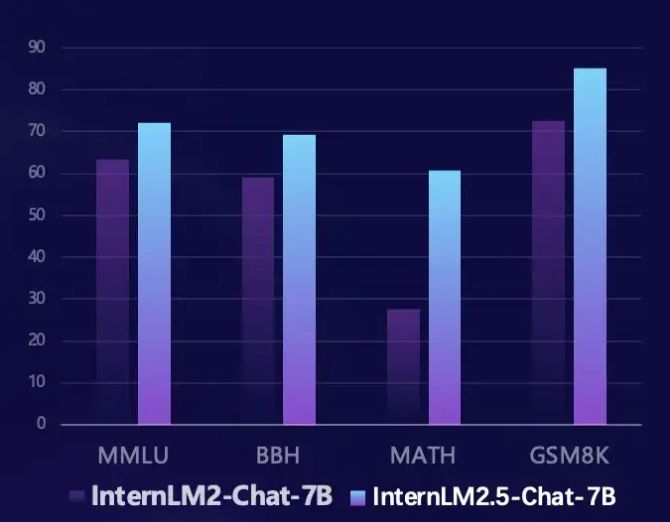

InternLM2.5在多个关键领域实现了显著提升。首先,其推理能力得到了显著增强,部分维度的表现甚至超越了Llama3-70B模型。特别是在数学评测集MATH上,InternLM2.5实现了100%的性能提升,准确率达到了60%,与GPT-4 Turbo 1106版本相当。这一突破性进展为复杂问题的解决提供了更为强大的工具。

其次,InternLM2.5支持高达1M tokens的上下文处理能力,能够处理约120万汉字的长文。通过增加上下文长度和合成数据,模型在长文档理解和智能体交互方面进行了优化,使其在处理复杂文本时更加得心应手。

此外,InternLM2.5还具备自主规划与工具调用的能力。它能够搜索和整合上百个网页的信息,并通过MindSearch多智能体框架模拟人的思维过程,有效整合网络信息。这一功能为信息检索和知识整合提供了全新的解决方案,极大地提升了模型的实用性和智能化水平。

开发者可以通过以下链接获取更多关于InternLM2.5的信息和资源:

Github链接: https://github.com/InternLM/InternLM

模型链接: https://www.modelscope.cn/models/Shanghai_AI_Laboratory/internlm2_5-7b-chat

书生·浦语主页: https://internlm.intern-ai.org.cn/