Em 3 de julho de 2024, o Laboratório de Inteligência Artificial de Xangai uniu as mãos à SenseTime, lançou em conjunto uma nova geração de um modelo de grande idioma - Scholar Puyu 2.5 (InternLm2.5). Este lançamento marca um passo importante na inovação tecnológica da China no campo da inteligência artificial, especialmente na pesquisa e aplicação de grandes modelos de linguagem.

O modelo InternLM2.5-7B foi oficialmente de código aberto e outros modelos de escala serão abertos ao público um após o outro. O Laboratório de Inteligência Artificial de Xangai promete continuar a fornecer licenciamento comercial gratuito e apoiar a inovação e o desenvolvimento de comunidades globais por meio de modelos de código aberto de alta qualidade. Esse movimento não apenas reduz o limiar de aplicação da tecnologia de inteligência artificial, mas também oferece oportunidades mais inovadoras para os desenvolvedores globais.

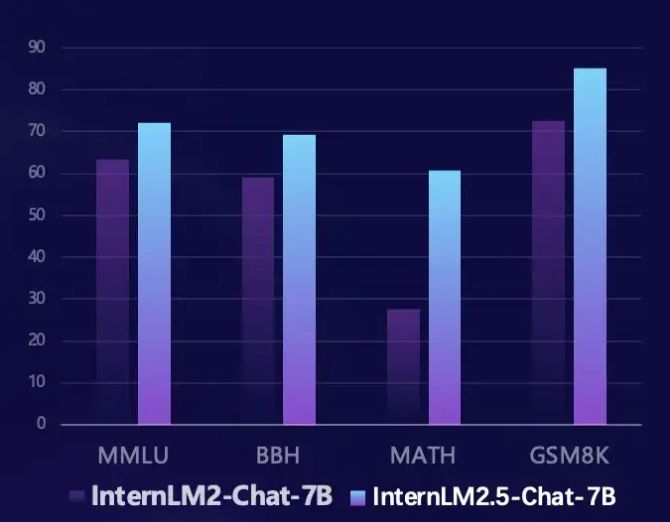

A InternLM2.5 alcançou melhorias significativas em várias áreas -chave. Primeiro, sua capacidade de inferência foi significativamente aprimorada e o desempenho de algumas dimensões supera o modelo LLAMA3-70B. Especialmente no conjunto de avaliação matemática, o InternLM2.5 alcança 100% de melhoria de desempenho e tem uma precisão de 60%, o que é comparável à versão GPT-4 Turbo 1106. Esse progresso inovador fornece uma ferramenta mais poderosa para resolver problemas complexos.

Em segundo lugar, a InternLM2.5 suporta recursos de processamento de contexto de até 1 milhão de tokens e podem processar artigos longos de cerca de 1,2 milhão de caracteres chineses. Ao aumentar o comprimento do contexto e os dados sintéticos, o modelo é otimizado para entender o entendimento e a interação de agentes longos, tornando -o mais útil ao lidar com um texto complexo.

Além disso, o InternLM2.5 também tem a capacidade de planejar e chamar a ferramenta de forma independente. Ele pode pesquisar e integrar informações de centenas de páginas da web e simular processos de pensamento humano através da estrutura multi-agente da MindSearch para integrar efetivamente informações de rede. Esta função fornece uma nova solução para recuperação de informações e integração de conhecimento, melhorando bastante a praticidade e a inteligência do modelo.

Os desenvolvedores podem obter mais informações e recursos sobre o InternLM2.5 através dos seguintes links:

Link do github: https://github.com/internlm/internlm

Link do modelo: https://www.modelscope.cn/models/shanghai_ai_laboratory/internlm2_5-7b-clat

Página inicial do Scholar Puyu: https://internmm.intern-ai.org.cn/