Am 3. Juli 2024 schloss sich das Shanghai Artificial Intelligence Laboratory mit Sensetime zusammen und veröffentlichte gemeinsam eine neue Generation von großsprachigen Modell - Scholar Puyu 2.5 (Internlm2.5). Diese Veröffentlichung ist ein wichtiger Schritt in der technologischen Innovation Chinas im Bereich der künstlichen Intelligenz, insbesondere in der Forschung und Anwendung von Großsprachenmodellen.

Das interne 22.5-7b-Modell wurde offiziell Open Source und andere Skalierungsmodelle werden nacheinander der Öffentlichkeit zugänglich gemacht. Das Shanghai-Labor für künstliche Intelligenz verspricht, weiterhin kostenlose kommerzielle Lizenzierung zu liefern und die Innovation und Entwicklung globaler Gemeinschaften durch hochwertige Open-Source-Modelle zu unterstützen. Dieser Schritt senkt nicht nur die Anwendungsschwelle der Technologie für künstliche Intelligenz, sondern bietet auch innovativere Möglichkeiten für globale Entwickler.

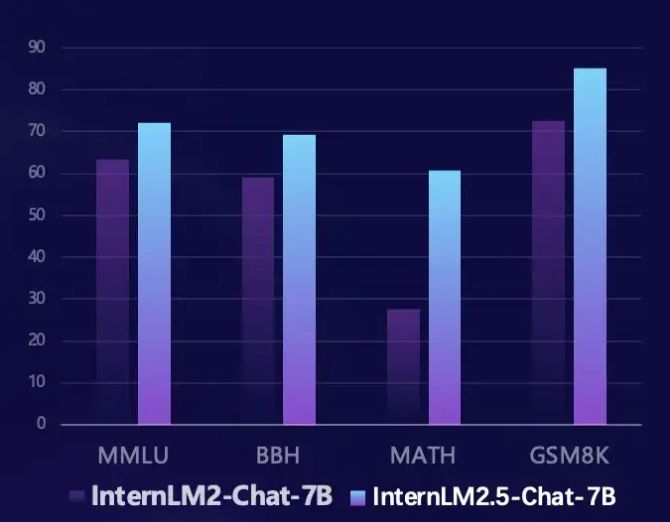

Internlm2.5 hat in mehreren Schlüsselbereichen erhebliche Verbesserungen erzielt. Erstens wurde seine Inferenzfähigkeit erheblich verbessert, und die Leistung einiger Dimensionen übertrifft sogar das LLAMA3-70B-Modell. Insbesondere bei der mathematischen Bewertungsmathematik erzielt Internlm2,5 eine 100% ige Leistungsverbesserung und hat eine Genauigkeit von 60%, die mit der Version der GPT-4 Turbo 1106 vergleichbar ist. Dieser Durchbruchsfortschritt bietet ein leistungsfähigeres Instrument zur Lösung komplexer Probleme.

Zweitens unterstützt Internlm2.5 die Kontextverarbeitungsfunktionen von bis zu 1 Mio. Token und kann lange Artikel von etwa 1,2 Millionen chinesischen Charakteren verarbeiten. Durch die Erhöhung der Kontextlänge und synthetischen Daten wird das Modell für ein langes Dokumentenverständnis und die Interaktion zwischen Dokumenten optimiert, wodurch es beim Umgang mit komplexem Text praktischer wird.

Darüber hinaus hat Internlm2.5 auch die Möglichkeit, unabhängig voneinander zu planen und Tool zu rufen. Es kann Informationen von Hunderten von Webseiten durchsuchen und integrieren und menschliches Denken durch MindSearch Multi-Agent-Framework simulieren, um Netzwerkinformationen effektiv zu integrieren. Diese Funktion bietet eine neue Lösung für das Abrufen von Informationen und die Integration von Wissen und verbessert die Praktikabilität und Intelligenz des Modells erheblich.

Entwickler können über die folgenden Links mehr Informationen und Ressourcen zu Internlm2.5 erhalten:

GitHub Link: https://github.com/internlm/internlm

Modelllink: https://www.modelscope.cn/models/shanghai_ai_laboratory/internlm2_5-7b-chat

Scholar Puyu Homepage: https://internlm.intern-ai.org.cn/