Le 3 juillet 2024, Shanghai Artificial Intelligence Laboratory s'est joint à Sensetime, a publié conjointement une nouvelle génération de modèle de grande langue - Scholar Puyu 2.5 (Interlm2.5). Cette version marque une étape importante dans l'innovation technologique chinoise dans le domaine de l'intelligence artificielle, en particulier dans la recherche et l'application de modèles de gros langues.

Le modèle Interlm2.5-7b a été officiellement open source et d'autres modèles d'échelle seront ouverts au public les uns après l'autre. Le Laboratoire de renseignement artificiel de Shanghai promet de continuer à fournir des licences commerciales gratuites et à soutenir l'innovation et le développement des communautés mondiales grâce à des modèles open source de haute qualité. Cette décision réduit non seulement le seuil d'application de la technologie de l'intelligence artificielle, mais offre également des opportunités plus innovantes aux développeurs mondiaux.

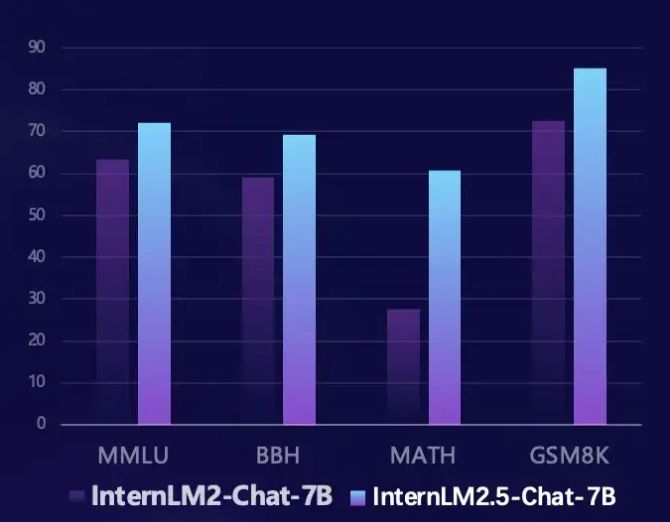

Interlm2.5 a réalisé des améliorations significatives dans plusieurs domaines clés. Premièrement, sa capacité d'inférence a été considérablement améliorée, et les performances de certaines dimensions dépassent même le modèle LLAMA3-70B. Surtout sur l'ensemble d'évaluation mathématique MATH, InterLM2.5 atteint une amélioration des performances à 100% et a une précision de 60%, ce qui est comparable à la version GPT-4 Turbo 1106. Cette progression révolutionnaire fournit un outil plus puissant pour résoudre des problèmes complexes.

Deuxièmement, Interlm2.5 prend en charge les capacités de traitement de contexte de jusqu'à 1 m de jetons et peut traiter de longs articles d'environ 1,2 million de caractères chinois. En augmentant la longueur du contexte et les données synthétiques, le modèle est optimisé pour une longue compréhension des documents et une interaction de l'agent, ce qui la rend plus pratique lorsqu'il s'agit d'un texte complexe.

De plus, Interlm2.5 a également la possibilité de planifier et d'appeler indépendamment l'outil. Il peut rechercher et intégrer des informations à partir de centaines de pages Web, et simuler les processus de pensée humaine via le cadre multi-agent de MindSearch pour intégrer efficacement les informations réseau. Cette fonction fournit une nouvelle solution pour la récupération de l'information et l'intégration des connaissances, améliorant considérablement le praticité et l'intelligence du modèle.

Les développeurs peuvent obtenir plus d'informations et de ressources sur Interlm2.5 via les liens suivants:

Lien github: https://github.com/internlm/internlm

Lien modèle: https://www.modelscope.cn/models/shanghai_ai_laboratory/internlm2_5-7b-chat

Page d'accueil de Scholar Puyu: https://internlm.intern-ai.org.cn/