El 3 de julio de 2024, el Laboratorio de Inteligencia Artificial de Shanghai se unió a Sensetime, lanzó conjuntamente una nueva generación de modelos de lenguaje grande - Scholar Puyu 2.5 (Internlm2.5). Este lanzamiento marca un paso importante en la innovación tecnológica de China en el campo de la inteligencia artificial, especialmente en la investigación y la aplicación de modelos de idiomas grandes.

El modelo Internlm2.5-7b ha sido oficialmente de código abierto, y otros modelos de escala se abrirán al público uno tras otro. El Laboratorio de Inteligencia Artificial de Shanghai promete continuar proporcionando licencias comerciales gratuitas y apoyar la innovación y el desarrollo de las comunidades globales a través de modelos de código abierto de alta calidad. Este movimiento no solo reduce el umbral de aplicación de la tecnología de inteligencia artificial, sino que también ofrece oportunidades más innovadoras para los desarrolladores globales.

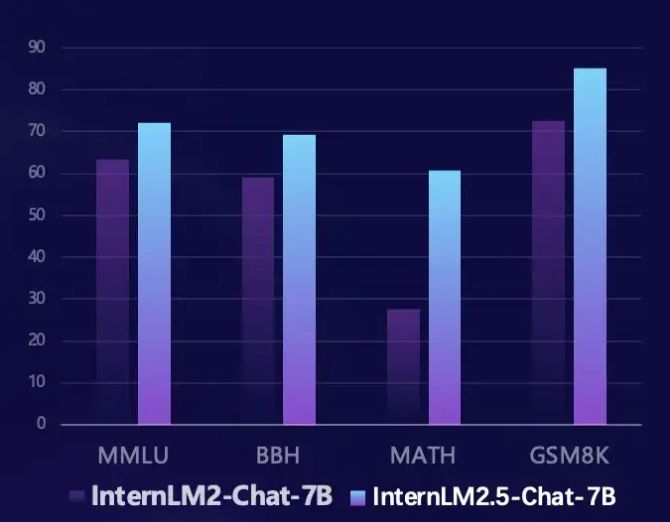

Internlm2.5 ha logrado mejoras significativas en varias áreas clave. Primero, su capacidad de inferencia se ha mejorado significativamente, y el rendimiento de algunas dimensiones incluso supera el modelo LLAMA3-70B. Especialmente en el conjunto de evaluación matemática Math, Internlm2.5 logra una mejora del rendimiento del 100% y tiene una precisión del 60%, que es comparable a la versión GPT-4 Turbo 1106. Este progreso innovador proporciona una herramienta más poderosa para resolver problemas complejos.

En segundo lugar, Internlm2.5 admite capacidades de procesamiento de contexto de hasta 1 millones de tokens y puede procesar artículos largos de aproximadamente 1,2 millones de caracteres chinos. Al aumentar la longitud del contexto y los datos sintéticos, el modelo está optimizado para una larga comprensión de documentos e interacción de agentes, lo que lo hace más útil cuando se trata de texto complejo.

Además, Internlm2.5 también tiene la capacidad de planificar y llamar de forma independiente. Puede buscar e integrar información de cientos de páginas web, y simular procesos de pensamiento humano a través del marco de múltiples agentes de MindSearch para integrar efectivamente la información de la red. Esta función proporciona una nueva solución para la recuperación de la información e integración del conocimiento, mejorando en gran medida la practicidad y la inteligencia del modelo.

Los desarrolladores pueden obtener más información y recursos sobre Internlm2.5 a través de los siguientes enlaces:

Enlace de Github: https://github.com/internlm/internlm

Enlace del modelo: https://www.modelscope.cn/models/shanghai_ai_laboratory/internlm2_5-7b-chat

Página de inicio del erudito Puyu: https://internlm.intern-ai.org.cn/