Downcodes小編獲悉,阿里雲重磅發布了全新升級的Qwen2.5-Turbo大語言模型,其上下文長度驚人地達到了100萬Token!這代表著什麼?這意味著它可以處理相當於10部《三體》小說、150小時語音或3萬行程式碼的資訊量!如此強大的處理能力,將徹底改變我們與大型語言模型互動的方式。

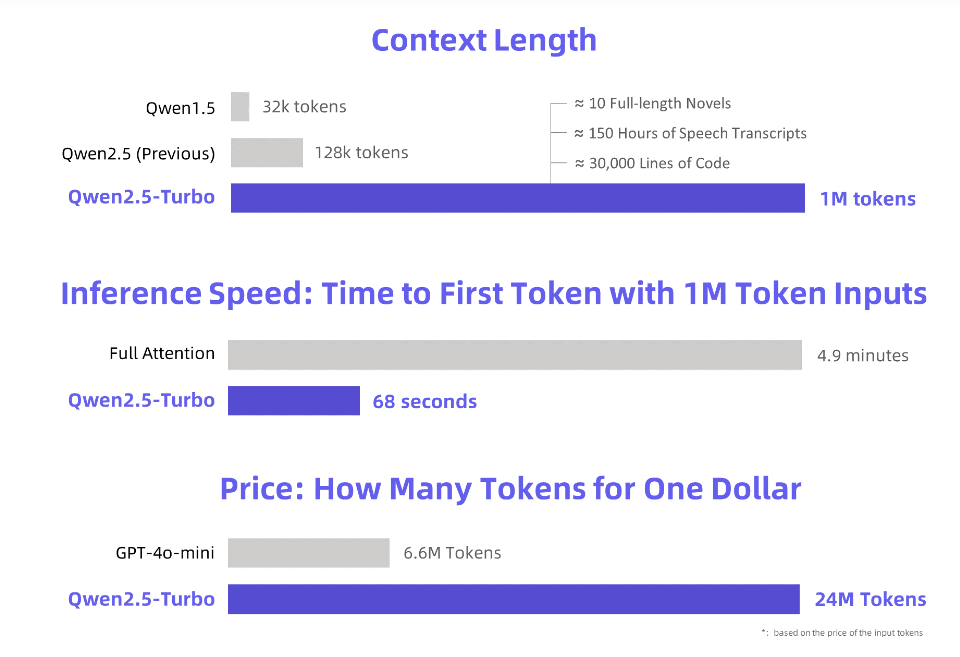

阿里雲重磅推出全新升級的Qwen2.5-Turbo大語言模型,其上下文長度突破至驚人的100萬Token。這相當於什麼概念?相當於10部《三體》,150小時的語音轉錄或3萬行代碼的容量!這回可真是「一口氣讀完十本小說」不是夢了!

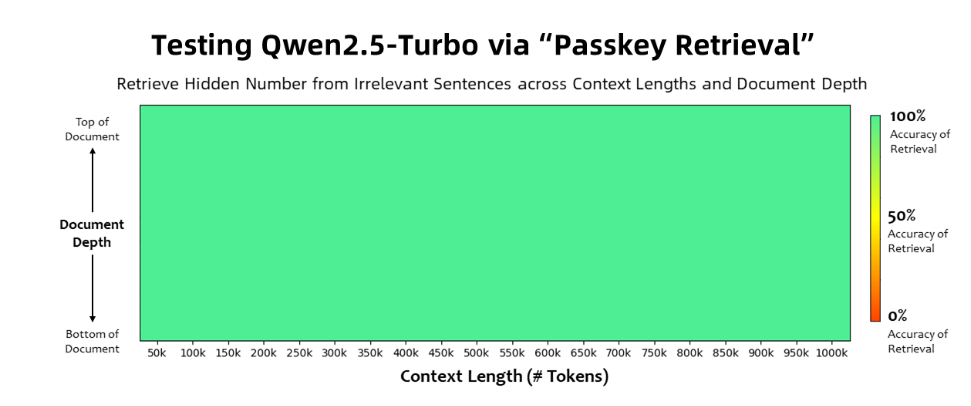

Qwen2.5-Turbo模型在Passkey Retrieval任務中實現了100%的準確率,並且在長文本理解能力方面超越了GPT-4等同類模型。該模型在RULER長文本基準測試中取得了93.1的高分,而GPT-4的得分僅為91.6,GLM4-9B-1M的得分則為89.9。

除了超長文本處理能力,Qwen2.5-Turbo也兼具短文處理的精準性,在短文本基準測試中,其表現表現與GPT-4o-mini和Qwen2.5-14B-Instruct模型相當。

透過採用稀疏注意力機制,Qwen2.5-Turbo模型將處理100萬Token的首次token時間從4.9分鐘縮短至68秒,實現了4.3倍的推理速度提升。

同時,處理100萬Token的費用僅0.3元人民幣,與GPT-4o-mini相比,在相同成本下可處理3.6倍的內容。

阿里雲為Qwen2.5-Turbo模型準備了一系列演示,展示了其在深度理解長篇小說、程式設計輔助和多篇論文閱讀等方面的應用。例如,用戶上傳了包含69萬Token的《三體》三部曲中文小說後,模型成功地用英文概括了每部小說的情節。

使用者可以透過阿里雲模型工作室的API服務、HuggingFace Demo或ModelScope Demo體驗Qwen2.5-Turbo模型的強大功能。

阿里雲表示,未來將繼續優化模型,提升其在長序列任務中的人類偏好對齊,並進一步優化推理效率,降低運算時間,並嘗試推出更大更強的長上下文模型。

官方介紹:https://qwenlm.github.io/blog/qwen2.5-turbo/

線上示範:https://huggingface.co/spaces/Qwen/Qwen2.5-Turbo-1M-Demo

API文件:https://help.aliyun.com/zh/model-studio/getting-started/first-api-call-to-qwen

Qwen2.5-Turbo的出現,標誌著大語言模型在長文本處理能力上取得了重大突破。其高效率、低成本的特點,將為各行各業帶來巨大的應用潛力。讓我們拭目以待,看看這個強大的模式未來會如何改變我們的世界!