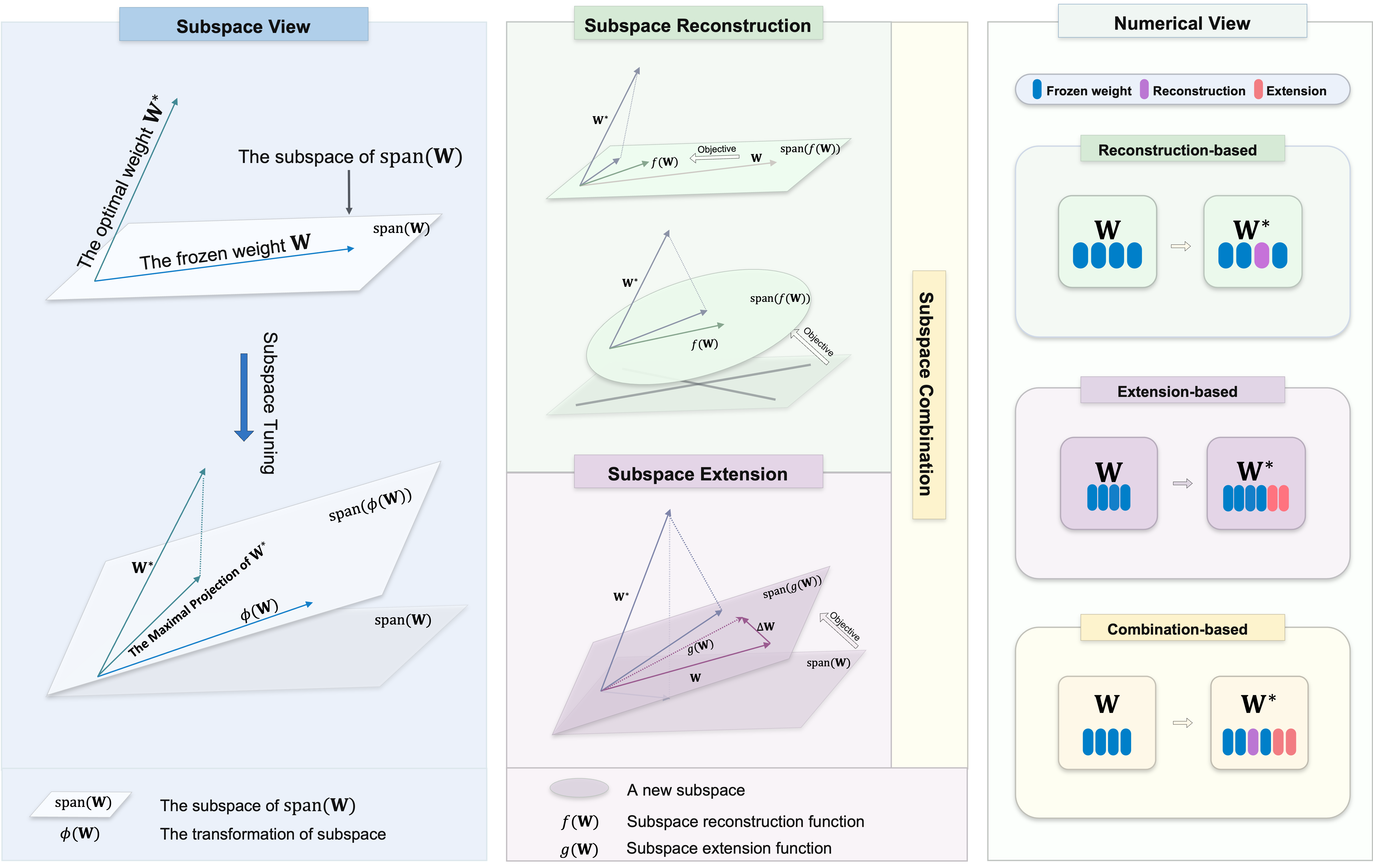

欢迎来到我们的存储库,该存储库包含用于参数效率微调(PEFT)的各种子空间调整方法。子空间调整对于将大型预训练模型调整为特定任务至关重要,对原始参数的变化很小。它努力确定最佳重量的最大投影

我们旨在为该领域的研究人员和从业人员提供全面的资源,并促进轻松整合您的项目。无论您是在这里寻找项目的资源还是为了贡献资源,我们都希望该存储库将是您研究旅程中有价值且令人振奋的一部分。

该存储库还包含我们从事的其他一些项目,这可能引导您在这里。

要在此存储库中使用算法,请克隆存储库并安装必要的依赖项。

克隆这个存储库:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-Tuning按照每个文件夹中的说明。

我们支持几个任务,包括:

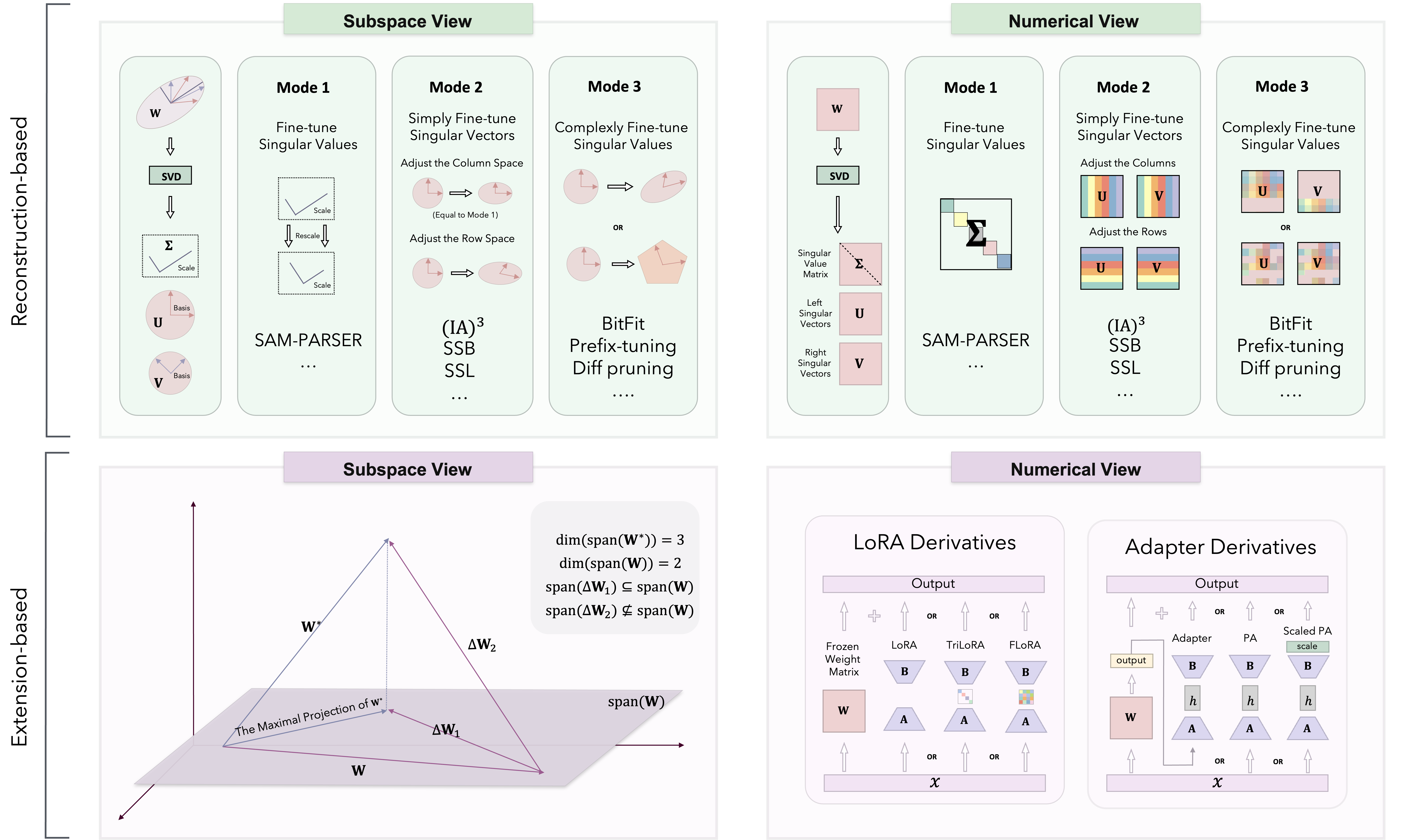

基于子空间调整理论,PEFT方法分为三类:基于重建,基于扩展和基于组合的方法。

我们主要在Loralib/中实施不同的方法。

| 类别 | 算法 | 代码 | 纸 |

|---|---|---|---|

| 重建 | Sam-Parser | 代码 | 2024 AAAI |

| IA3 | 代码 | 2022神经 | |

| SSB | 代码 | 2024 Arxiv | |

| SSL | 代码 | 2024 Arxiv | |

| BitFit | N/A。 | 2022 ACL | |

| 前缀调整 | 代码 | 2021 ACL | |

| 及时调整 | 代码 | 2021 EMNLP | |

| p-tuning | 代码 | 2022 ACL | |

| Pissa | 代码 | 2024 Arxiv | |

| 米洛拉 | 代码 | 2024 Arxiv | |

| 扩大 | 洛拉 | 代码 | 2022 ICLR |

| 阿达洛拉 | 代码 | 2023 ICLR | |

| 植物群 | 代码 | 2024 Arxiv | |

| Moslora | 代码 | 2024 Arxiv | |

| Trilora | 代码 | 2024 Arxiv | |

| 适配器(Houlsby) | N/A。 | 2019 ICML | |

| 适配器(pfeiffer) | N/A。 | 2021 ACL | |

| 平行适配器 | 代码 | 2022 ICLR | |

| 组合 | 多拉 | 代码 | 2024 ICML |

| SVDIFF | 代码 | 2023 ICCV | |

| 光谱适配器 | 代码 | 2024 Arxiv | |

| 洛拉 - 达什 | 代码 | 2024 Arxiv | |

| 不断添加更多算法和更新... | N/A。 | N/A。 |

我们还测试了在NLU和CR任务上的某些算法的性能。

我们欢迎对此存储库的贡献!无论您是修复错误,添加新功能还是改进文档,您的帮助都将受到赞赏。请遵循准则,以确保平稳的贡献过程。

感谢您对我们的PEFT代码存储库的关注。我们努力使这是您的项目和研究努力的宝贵资源。

我们的目标是促进一个协作环境,您和我们的研究人员都可以交流想法并进行合作。除了讨论与代码相关的问题外,我们鼓励您分享您对任何PEFT方法论的观点,并应对遇到的任何潜在挑战。我们欢迎讨论可能引发新的见解和创新。

此外,此代码存储库具有更私人的性质,其中包含我在实验中使用的任务和算法。如果您想实现任何算法或希望添加更多任务方案,请随时向我发送电子邮件。您也可以访问我的个人主页以获取更多详细信息。

如果您有任何疑问,建议或反馈,请随时通过[email protected]与我们联系。

如果您发现此存储库有用,请考虑给它一颗星并在您的工作中引用它:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}该存储库还包含我们其他项目的代码。如果您发现这些方法有用,请考虑给出一颗星星并引用它们的工作。

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}该存储库是根据Apache 2.0许可证获得许可的。有关更多详细信息,请参见许可证文件。