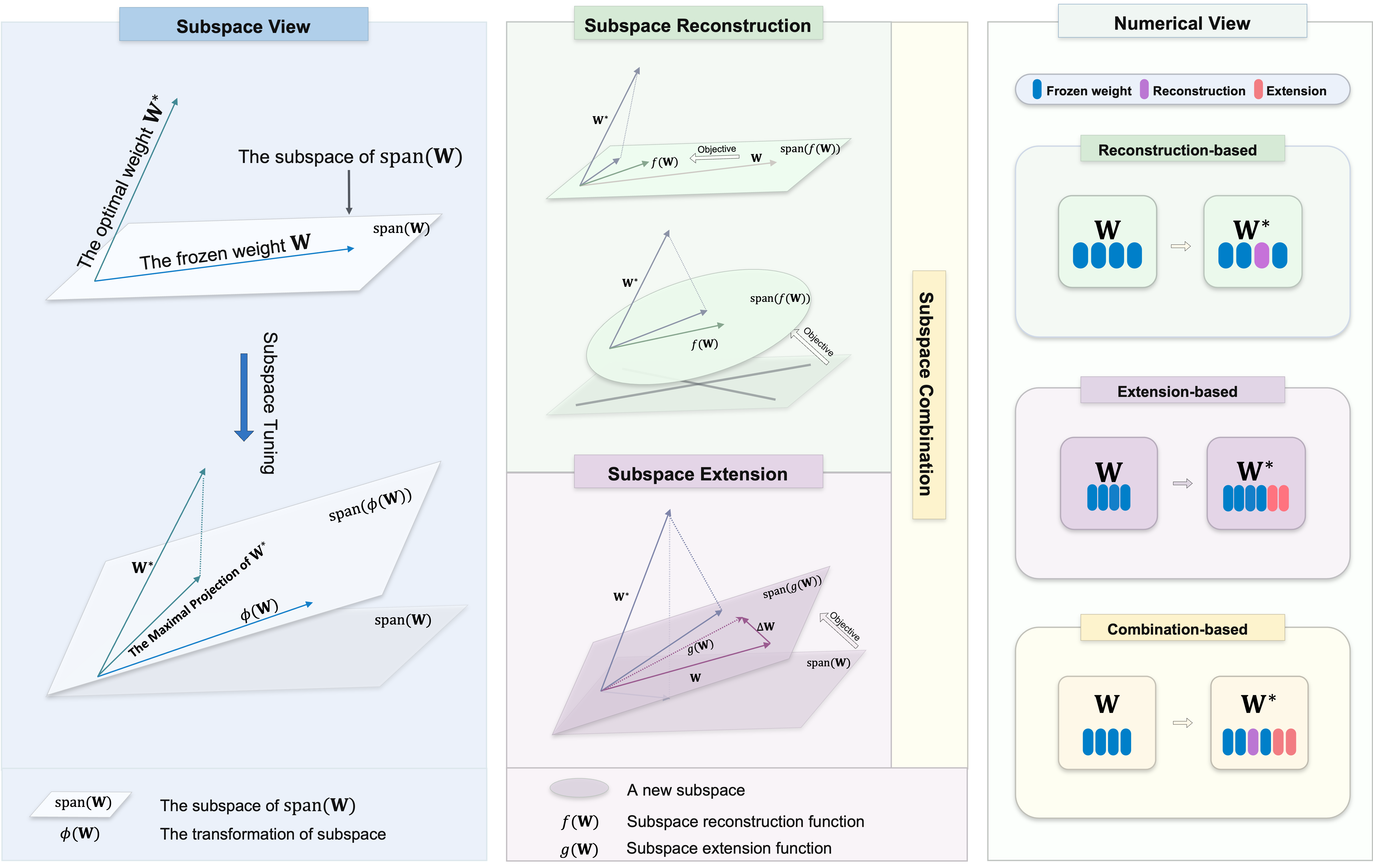

Bienvenido a nuestro repositorio, que contiene una colección diversa de métodos de ajuste de subespacio para el ajuste fino (PEFT) de los parámetros. El ajuste del subespacio es esencial para adaptar grandes modelos previamente capacitados a tareas específicas con cambios mínimos en los parámetros originales. Se esfuerza por identificar la proyección máxima del peso óptimo

Nuestro objetivo es proporcionar un recurso integral para los investigadores y profesionales en este campo, y facilitar la integración fácil en sus proyectos. Ya sea que esté aquí para encontrar recursos para sus proyectos o para contribuir, esperamos que este repositorio sea una parte valiosa e inspiradora de su viaje de investigación.

Este repositorio también contiene algunos de los otros proyectos en los que hemos trabajado, lo que podría haberlo llevado aquí.

Para usar los algoritmos en este repositorio, clone el repositorio e instale las dependencias necesarias.

Clon este repositorio:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-TuningSiga las instrucciones en cada carpeta.

Apoyamos varias tareas que incluyen:

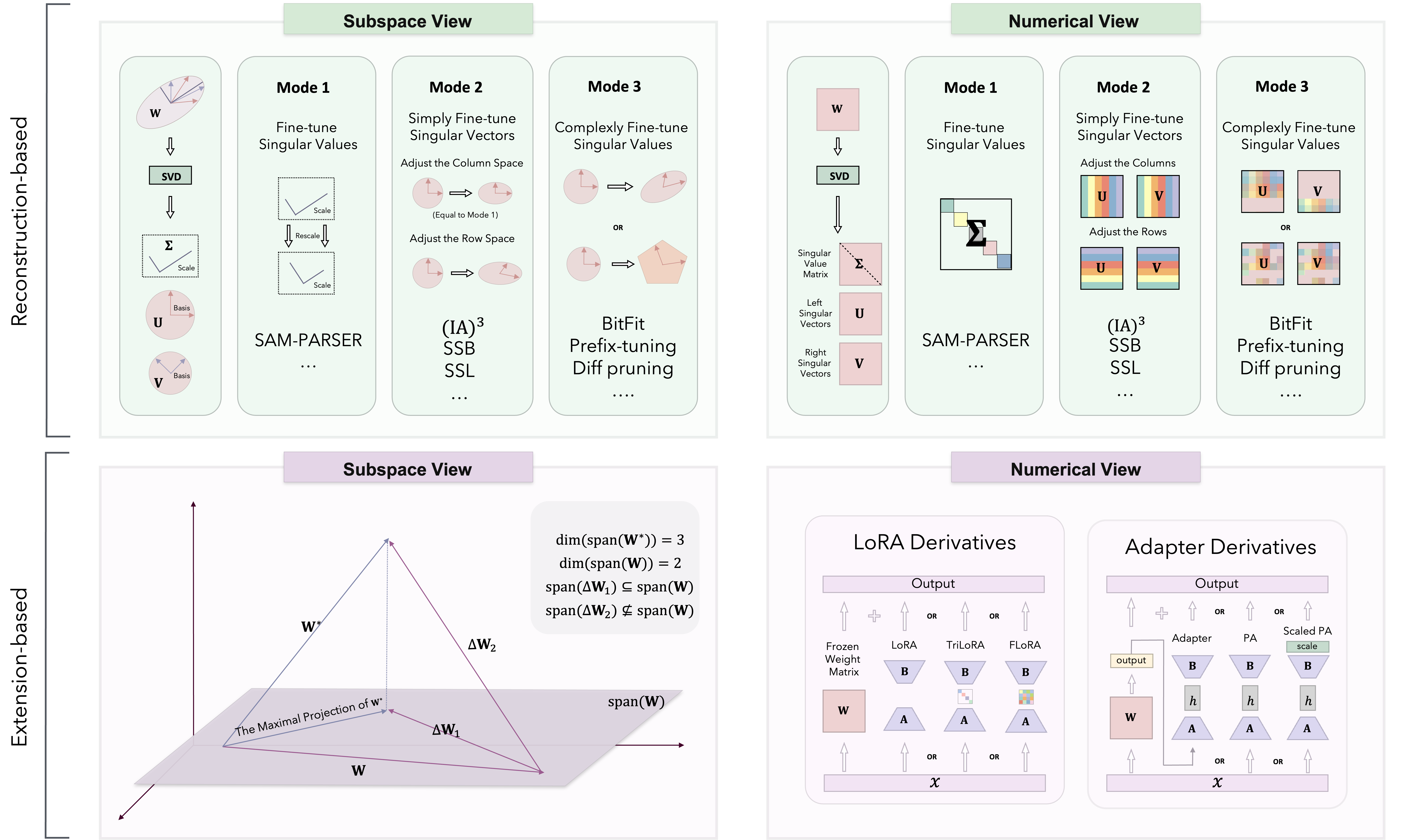

Basado en la teoría de sintonización del subespacio, los métodos PEFT se clasifican en tres categorías: basadas en reconstrucción, basadas en extensiones y basadas en combinación.

Implementamos diferentes métodos principalmente en Loralib/.

| Categoría | Algoritmo | Código | Papel |

|---|---|---|---|

| Reconstrucción | Sam-parter | Código | 2024 AAAI |

| IA3 | Código | 2022 neuripas | |

| SSB | Código | 2024 arxiv | |

| Ssl | Código | 2024 arxiv | |

| Bitfit | N / A | 2022 ACL | |

| Ajuste de prefijo | Código | 2021 ACL | |

| Aviso | Código | 2021 EMNLP | |

| Puning P | Código | 2022 ACL | |

| Pisno | Código | 2024 arxiv | |

| Milora | Código | 2024 arxiv | |

| Extensión | Lora | Código | 2022 ICLR |

| Adalora | Código | 2023 ICLR | |

| Flora | Código | 2024 arxiv | |

| Moslaza | Código | 2024 arxiv | |

| Trilora | Código | 2024 arxiv | |

| Adaptador (Houlsby) | N / A | ICML 2019 | |

| Adaptador (pfeiffer) | N / A | 2021 ACL | |

| Adaptador paralelo | Código | 2022 ICLR | |

| Combinación | Dora | Código | 2024 ICML |

| Svdiff | Código | 2023 ICCV | |

| Adaptador espectral | Código | 2024 arxiv | |

| Lora-dash | Código | 2024 arxiv | |

| Se agregan continuamente más algoritmos y actualizaciones ... | N / A | N / A |

También hemos probado el rendimiento de algunos algoritmos en las tareas NLU y CR.

¡Agradecemos las contribuciones a este repositorio! Ya sea que esté arreglando errores, agregando nuevas funciones o mejorando la documentación, se agradece su ayuda. Siga las pautas para garantizar un proceso de contribución sin problemas.

Gracias por su interés en nuestro repositorio de código PEFT. Nos esforzamos por hacer de este un recurso valioso para sus proyectos y esfuerzos de investigación.

Nuestro objetivo es fomentar un entorno colaborativo donde usted y nuestros investigadores puedan intercambiar ideas y cooperar. Más allá de discutir temas relacionados con el código, le recomendamos que comparta sus perspectivas sobre cualquier metodología de PEFF y aborde cualquier desafío potencial que encuentre. Agradecemos discusiones que pueden generar nuevas ideas e innovaciones.

Además, este repositorio de código es de naturaleza más privada, que contiene tareas y algoritmos que uso durante mis experimentos. Si tiene algún algoritmo que desea implementar o desee agregar más escenarios de tareas, no dude en enviarme un correo electrónico. También puede visitar mi página de inicio personal para obtener más detalles.

Si tiene alguna pregunta, sugerencia o comentarios, no dude en contactarnos en [email protected].

Si encuentra útil este repositorio, considere darle una estrella y citarla en su trabajo:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}Este repositorio también contiene el código para nuestros otros proyectos. Si encuentra útiles estos métodos, considere dar una estrella y citarlos en su trabajo.

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}Este repositorio tiene licencia bajo la licencia Apache 2.0. Consulte el archivo de licencia para obtener más detalles.