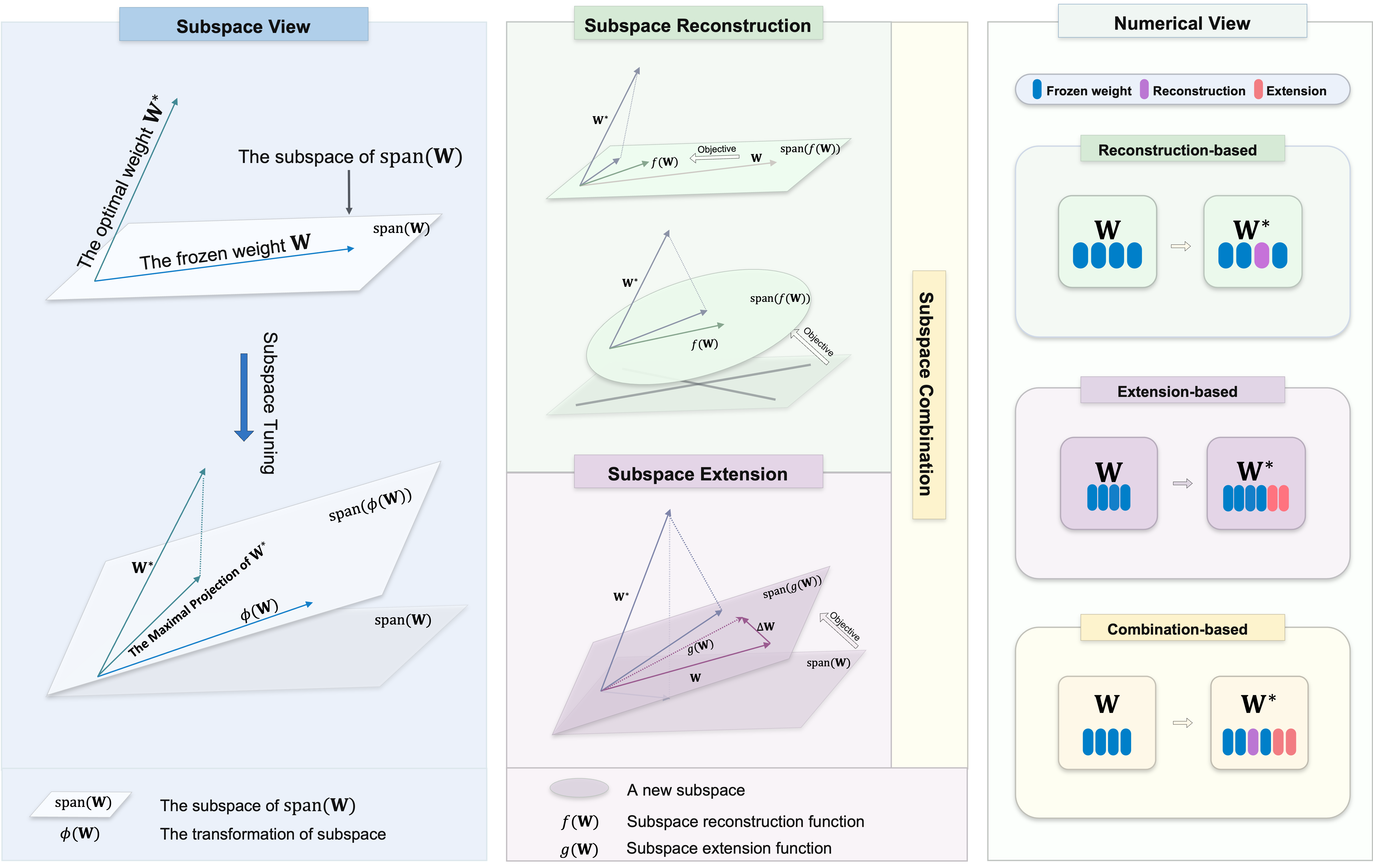

매개 변수 효율적인 미세 조정 (PEFT)을위한 다양한 서브 스페이스 튜닝 메소드 모음이 포함 된 저장소에 오신 것을 환영합니다. 서브 스페이스 튜닝은 원래 매개 변수를 최소화하는 대규모 미리 훈련 된 모델을 특정 작업에 적응시키는 데 필수적입니다. 그것은 최적의 무게의 최대 투영을 식별하기 위해 노력합니다.

우리는이 분야의 연구원과 실무자에게 포괄적 인 자원을 제공하고 프로젝트에 쉽게 통합 할 수 있도록하는 것을 목표로합니다. 프로젝트를위한 자원을 찾거나 기여하기 위해 여기에 있든,이 저장소가 연구 여정의 귀중하고 고무적인 부분이되기를 바랍니다.

이 저장소에는 또한 우리가 작업 한 다른 프로젝트 중 일부가 포함되어있어 여기로 이끌었을 수도 있습니다.

이 저장소에서 알고리즘을 사용하려면 저장소를 복제하고 필요한 종속성을 설치하십시오.

이 저장소를 복제하십시오.

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-Tuning각 폴더의 지침을 따르십시오.

우리는 다음을 포함한 여러 작업을 지원합니다.

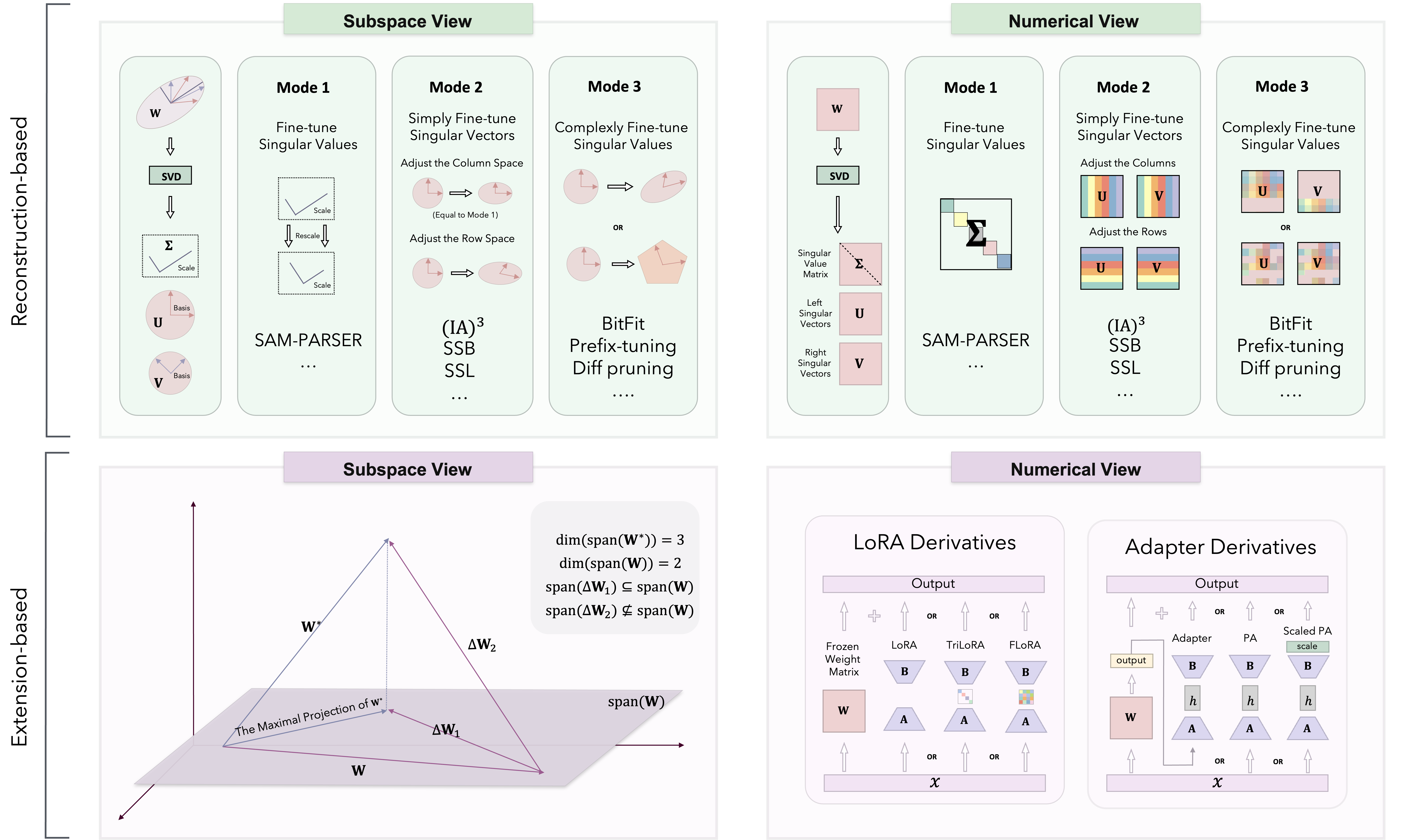

서브 스페이스 튜닝 이론을 기반으로 PEFT 방법은 재구성 기반, 확장 기반 및 조합 기반의 세 가지 범주로 분류됩니다.

우리는 주로 Loralib/에서 다른 방법을 구현합니다.

| 범주 | 연산 | 암호 | 종이 |

|---|---|---|---|

| 재건 | 샘 파서 | 암호 | 2024 AAAI |

| IA3 | 암호 | 2022 신경관 | |

| SSB | 암호 | 2024 Arxiv | |

| SSL | 암호 | 2024 Arxiv | |

| 비트 피트 | N/A | 2022 ACL | |

| 접두사 튜닝 | 암호 | 2021 ACL | |

| 프롬프트 조정 | 암호 | 2021 EMNLP | |

| p- 튜닝 | 암호 | 2022 ACL | |

| Pissa | 암호 | 2024 Arxiv | |

| 밀로라 | 암호 | 2024 Arxiv | |

| 확대 | 로라 | 암호 | 2022 ICLR |

| Adalora | 암호 | 2023 ICLR | |

| 플로라 | 암호 | 2024 Arxiv | |

| 모슬라 | 암호 | 2024 Arxiv | |

| 트릴 로라 | 암호 | 2024 Arxiv | |

| 어댑터 (Houlsby) | N/A | 2019 ICML | |

| 어댑터 (파이퍼) | N/A | 2021 ACL | |

| 병렬 어댑터 | 암호 | 2022 ICLR | |

| 콤비네이션 | 도라 | 암호 | 2024 ICML |

| svdiff | 암호 | 2023 ICCV | |

| 스펙트럼 어댑터 | 암호 | 2024 Arxiv | |

| Lora-Dash | 암호 | 2024 Arxiv | |

| 더 많은 알고리즘과 업데이트가 지속적으로 추가됩니다 ... | N/A | N/A |

또한 NLU 및 CR 작업에 대한 일부 알고리즘의 성능을 테스트했습니다.

우리는이 저장소에 대한 기여를 환영합니다! 버그를 고치거나 새로운 기능 추가 또는 문서 개선에 관계없이 도움을 주시면 도움이됩니다. 원활한 기여 과정을 보장하려면 가이드 라인을 따르십시오.

PEFT 코드 저장소에 관심을 가져 주셔서 감사합니다. 우리는 이것을 당신의 프로젝트와 연구 노력을위한 귀중한 자원으로 만들기 위해 노력합니다.

우리의 목표는 당신과 우리의 연구자들이 아이디어를 교환하고 협력 할 수있는 협업 환경을 조성하는 것입니다. 코드 관련 문제에 대해 논의하는 것 외에도 PEFT 방법론에 대한 관점을 공유하고 발생하는 잠재적 인 과제를 해결하는 것이 좋습니다. 새로운 통찰력과 혁신을 일으킬 수있는 토론을 환영합니다.

또한이 코드 저장소는 실험 중에 사용하는 작업 및 알고리즘을 포함하는보다 개인적인 특성입니다. 구현하고 싶은 알고리즘이 있거나 더 많은 작업 시나리오를 추가하려면 언제든지 이메일을 보내주십시오. 자세한 내용은 내 개인 홈페이지를 방문 할 수도 있습니다.

궁금한 점, 제안 또는 피드백이 있으시면 [email protected]으로 문의하십시오.

이 저장소가 유용하다고 생각되면 별을주고 작업에서 인용하는 것을 고려하십시오.

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}이 저장소에는 다른 프로젝트의 코드도 포함되어 있습니다. 이 방법이 유용하다고 생각되면 스타를 제공하고 작업에서 인용하는 것을 고려하십시오.

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}이 저장소는 Apache 2.0 라이센스에 따라 라이센스가 부여됩니다. 자세한 내용은 라이센스 파일을 참조하십시오.