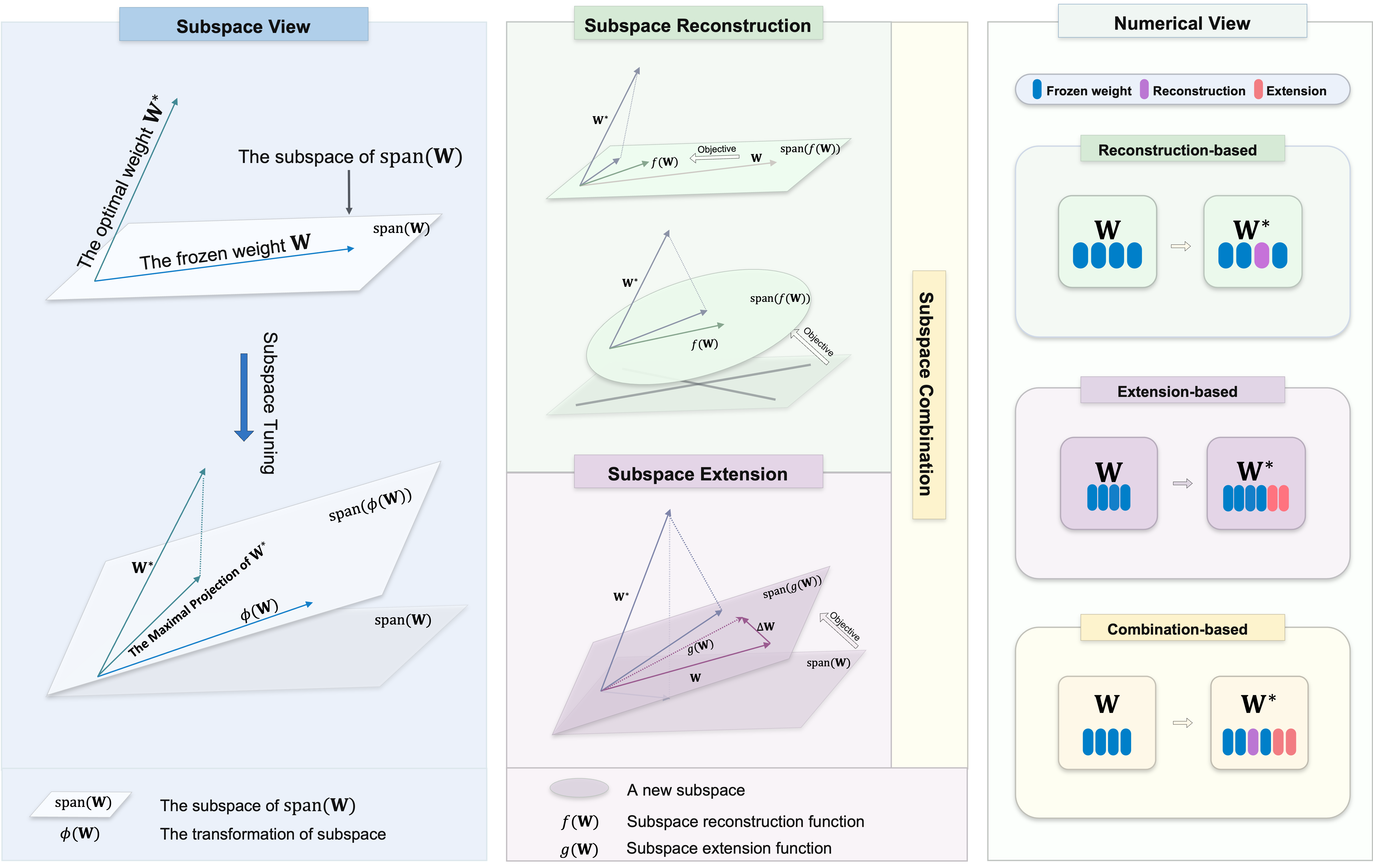

Bem-vindo ao nosso repositório, que contém uma coleção diversificada de métodos de ajuste de subespaço para ajuste fino com eficiência de parâmetro (PEFT). O ajuste do subespaço é essencial para adaptar grandes modelos pré-treinados a tarefas específicas com alterações mínimas nos parâmetros originais. Se esforça para identificar a projeção máxima do peso ideal

Nosso objetivo é fornecer um recurso abrangente para pesquisadores e profissionais nesse campo e facilitar fácil integração em seus projetos. Se você está aqui para encontrar recursos para seus projetos ou contribuir, esperamos que este repositório seja uma parte valiosa e inspiradora de sua jornada de pesquisa.

Esse repositório também contém alguns dos outros projetos em que trabalhamos, o que pode ter levado você aqui.

Para usar os algoritmos neste repositório, clone o repositório e instale as dependências necessárias.

Clone este repositório:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-TuningSiga as instruções em cada pasta.

Apoiamos várias tarefas, incluindo:

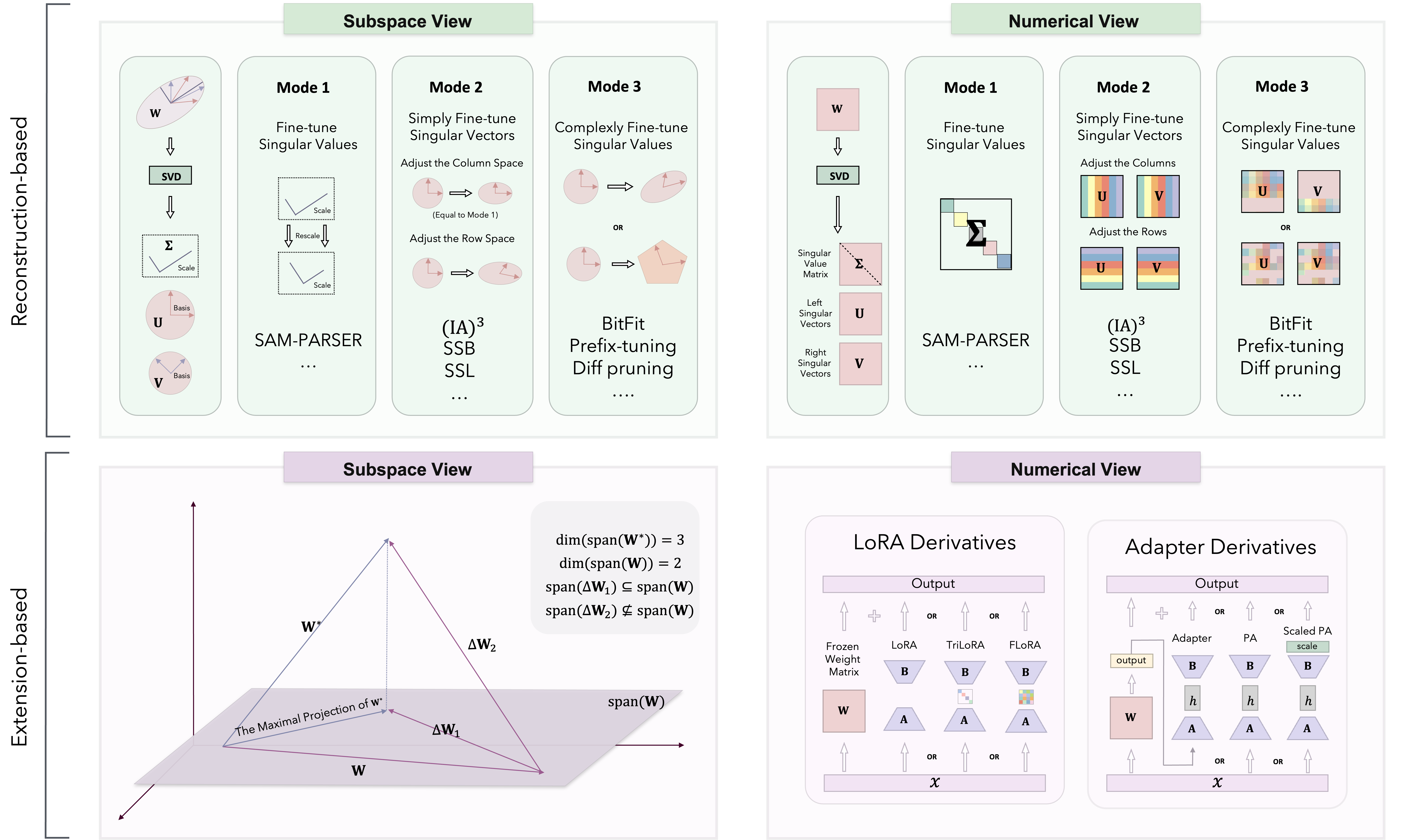

Com base na teoria da ajuste do subespaço, os métodos PEFT são classificados em três categorias: baseada em reconstrução, baseada em extensão e combinada.

Implementamos diferentes métodos principalmente no Loralib/.

| Categoria | Algoritmo | Código | Papel |

|---|---|---|---|

| Reconstrução | Sam-parser | Código | 2024 AAAI |

| IA3 | Código | 2022 Neurips | |

| SSB | Código | 2024 Arxiv | |

| Ssl | Código | 2024 Arxiv | |

| Bitfit | N / D | 2022 ACL | |

| Tuneamento de prefixos | Código | 2021 ACL | |

| Tuneamento imediato | Código | 2021 Emnlp | |

| Tuning p | Código | 2022 ACL | |

| Pissa | Código | 2024 Arxiv | |

| Milora | Código | 2024 Arxiv | |

| Extensão | Lora | Código | 2022 ICLR |

| Adalora | Código | 2023 ICLR | |

| Flora | Código | 2024 Arxiv | |

| Moslora | Código | 2024 Arxiv | |

| Trilora | Código | 2024 Arxiv | |

| Adaptador (Houlsby) | N / D | 2019 ICML | |

| Adaptador (Pfeiffer) | N / D | 2021 ACL | |

| Adaptador paralelo | Código | 2022 ICLR | |

| Combinação | Dora | Código | 2024 ICML |

| Svdiff | Código | 2023 ICCV | |

| Adaptador espectral | Código | 2024 Arxiv | |

| Lora-Dash | Código | 2024 Arxiv | |

| Mais algoritmos e atualizações são adicionados continuamente ... | N / D | N / D |

Também testamos o desempenho de alguns algoritmos nas tarefas da NLU e CR.

Congratulamo -nos com contribuições para este repositório! Esteja você corrigindo bugs, adicionando novos recursos ou melhorando a documentação, sua ajuda é apreciada. Siga as diretrizes para garantir um processo de contribuição suave.

Obrigado pelo seu interesse em nosso repositório de código PEFT. Nós nos esforçamos para tornar este um recurso valioso para seus projetos e esforços de pesquisa.

Nosso objetivo é promover um ambiente colaborativo, onde você e nossos pesquisadores podem trocar idéias e cooperar. Além de discutir questões relacionadas ao código, incentivamos você a compartilhar suas perspectivas sobre qualquer metodologia da PEFT e abordar quaisquer possíveis desafios que você encontrar. Congratulamo -nos com discussões que podem desencadear novas idéias e inovações.

Além disso, esse repositório de código é de natureza mais privada, contendo tarefas e algoritmos que eu uso durante meus experimentos. Se você tiver algum algoritmos que deseja implementar ou desejar adicionar mais cenários de tarefas, sinta -se à vontade para enviar e -mails para mim. Você também pode visitar minha página inicial pessoal para obter mais detalhes.

Se você tiver alguma dúvida, sugestão ou feedback, não hesite em entrar em contato conosco em [email protected].

Se você achar esse repositório útil, considere dar -lhe uma estrela e citá -lo em seu trabalho:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}Este repositório também contém o código para nossos outros projetos. Se você achar esses métodos úteis, considere dar uma estrela e citá -los em seu trabalho.

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}Este repositório é licenciado sob a licença Apache 2.0. Consulte o arquivo de licença para obter mais detalhes.