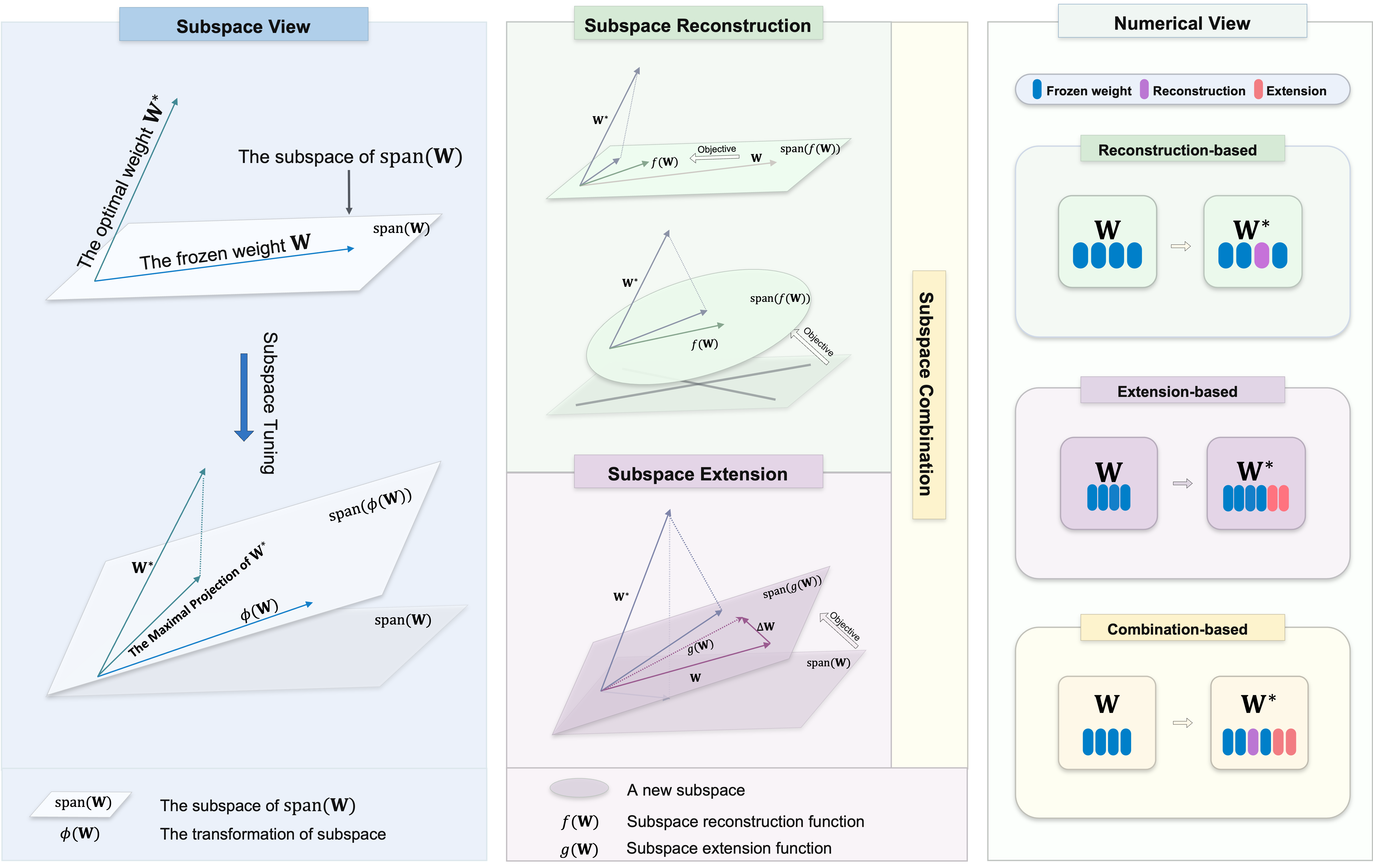

Willkommen in unserem Repository, das eine vielfältige Sammlung von Subspace-Tuning-Methoden für die parametereffiziente Feinabstimmung (PEFT) enthält. Die Subspace-Abstimmung ist für die Anpassung großer vorgebildeter Modelle an bestimmte Aufgaben mit minimalen Änderungen an den ursprünglichen Parametern unerlässlich. Es bemüht sich, die maximale Projektion des optimalen Gewichts zu identifizieren

Wir wollen Forschern und Praktikern in diesem Bereich eine umfassende Ressource zur Verfügung stellen und eine einfache Integration in Ihre Projekte ermöglichen. Egal, ob Sie hier sind, um Ressourcen für Ihre Projekte zu finden oder einen Beitrag zu leisten, wir hoffen, dass dieses Repository ein wertvoller und inspirierender Teil Ihrer Forschungsreise ist.

Dieses Repository enthält auch einige der anderen Projekte, an denen wir gearbeitet haben, die Sie hier möglicherweise geführt haben.

Um die Algorithmen in diesem Repository zu verwenden, klonen Sie das Repository und installieren Sie die erforderlichen Abhängigkeiten.

Klonen Sie dieses Repository:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-TuningBefolgen Sie die Anweisungen in jedem Ordner.

Wir unterstützen mehrere Aufgaben, darunter:

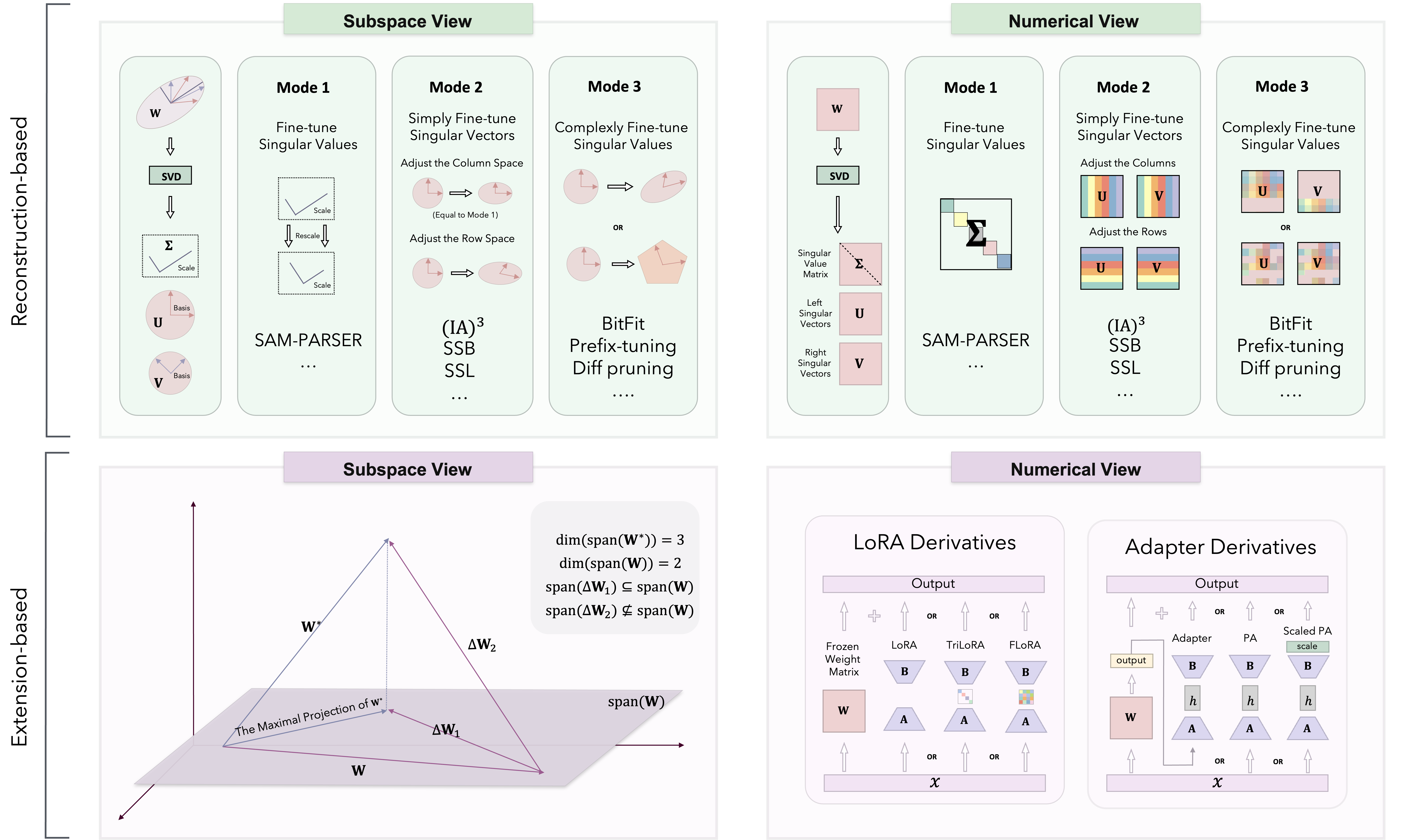

Basierend auf der Subspace-Tuning-Theorie werden PEFT-Methoden in drei Kategorien eingeteilt: rekonstruktionsbasierte, extensionsbasierte und kombinierte Basis.

Wir implementieren verschiedene Methoden hauptsächlich in Loralib/.

| Kategorie | Algorithmus | Code | Papier |

|---|---|---|---|

| Wiederaufbau | Sam-Parser | Code | 2024 AAAI |

| Ia3 | Code | 2022 Neurips | |

| SSB | Code | 2024 Arxiv | |

| SSL | Code | 2024 Arxiv | |

| Bitfit | N / A | 2022 ACL | |

| Präfixabstimmung | Code | 2021 ACL | |

| Eingabeaufbau | Code | 2021 emnlp | |

| P-Tuning | Code | 2022 ACL | |

| Pissa | Code | 2024 Arxiv | |

| Milora | Code | 2024 Arxiv | |

| Verlängerung | Lora | Code | 2022 ICLR |

| Adalora | Code | 2023 ICLR | |

| Flora | Code | 2024 Arxiv | |

| Moslora | Code | 2024 Arxiv | |

| Trilora | Code | 2024 Arxiv | |

| Adapter (Houlsby) | N / A | 2019 ICML | |

| Adapter (Pfeiffer) | N / A | 2021 ACL | |

| Paralleladapter | Code | 2022 ICLR | |

| Kombination | Dora | Code | 2024 ICML |

| Svdiff | Code | 2023 ICCV | |

| Spektraladapter | Code | 2024 Arxiv | |

| Lora-Dash | Code | 2024 Arxiv | |

| Weitere Algorithmen und Updates werden ständig hinzugefügt ... | N / A | N / A |

Wir haben auch die Leistung einiger Algorithmen für NLU- und CR -Aufgaben getestet.

Wir begrüßen Beiträge zu diesem Repository! Egal, ob Sie Fehler beheben, neue Funktionen hinzufügen oder die Dokumentation verbessern, Ihre Hilfe wird geschätzt. Bitte befolgen Sie die Richtlinien, um einen reibungslosen Beitragsprozess zu gewährleisten.

Vielen Dank für Ihr Interesse an unserem PEFT -Code -Repository. Wir bemühen uns, dies zu einer wertvollen Ressource für Ihre Projekte und Forschungsbemühungen zu machen.

Unser Ziel ist es, ein kollaboratives Umfeld zu fördern, in dem sowohl Sie als auch unsere Forscher Ideen austauschen und zusammenarbeiten können. Abgesehen von der Diskussion von Code-bezogenen Themen ermutigen wir Sie, Ihre Perspektiven für jede PEFT-Methodik zu teilen und potenzielle Herausforderungen zu bewältigen, denen Sie begegnen. Wir begrüßen Diskussionen, die neue Erkenntnisse und Innovationen wecken können.

Außerdem ist dieses Code -Repository privater und enthält Aufgaben und Algorithmen, die ich während meiner Experimente verwende. Wenn Sie Algorithmen haben, die Sie implementieren oder weitere Aufgabenszenarien hinzufügen möchten, senden Sie mir bitte eine E -Mail an mich. Sie können auch meine persönliche Homepage für weitere Details besuchen.

Wenn Sie Fragen, Vorschläge oder Feedback haben, können Sie uns bitte unter [email protected] kontaktieren.

Wenn Sie dieses Repository als nützlich finden, sollten Sie ihm einen Stern geben und in Ihrer Arbeit angeben:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}Dieses Repository enthält auch den Code für unsere anderen Projekte. Wenn Sie diese Methoden nützlich finden, erwägen Sie bitte einen Stern und zitieren Sie ihn in Ihrer Arbeit.

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}Dieses Repository ist unter der Apache 2.0 -Lizenz lizenziert. Weitere Informationen finden Sie in der Lizenzdatei.