ยินดีต้อนรับสู่ที่เก็บของของเราซึ่งมีคอลเลกชันที่หลากหลายของวิธีการปรับแต่ง subspace สำหรับการปรับแต่งพารามิเตอร์ที่มีประสิทธิภาพ (PEFT) การปรับจูน Subspace เป็นสิ่งจำเป็นสำหรับการปรับรุ่นที่ผ่านการฝึกอบรมล่วงหน้าขนาดใหญ่ให้เข้ากับงานเฉพาะที่มีการเปลี่ยนแปลงน้อยที่สุดกับพารามิเตอร์ดั้งเดิม มันพยายามที่จะระบุการคาดการณ์สูงสุดของน้ำหนักที่เหมาะสมที่สุด

เรามุ่งมั่นที่จะจัดหาทรัพยากรที่ครอบคลุมสำหรับนักวิจัยและผู้ปฏิบัติงานในสาขานี้และอำนวยความสะดวกในการรวมเข้ากับโครงการของคุณอย่างง่ายดาย ไม่ว่าคุณจะอยู่ที่นี่เพื่อค้นหาแหล่งข้อมูลสำหรับโครงการของคุณหรือมีส่วนร่วมเราหวังว่าที่เก็บนี้จะเป็นส่วนที่มีค่าและเป็นแรงบันดาลใจในการเดินทางวิจัยของคุณ

ที่เก็บนี้ยังมีโครงการอื่น ๆ ที่เราได้ทำซึ่งอาจนำคุณมาที่นี่

ในการใช้อัลกอริทึมในที่เก็บนี้ให้โคลนที่เก็บและติดตั้งการพึ่งพาที่จำเป็น

โคลนที่เก็บนี้:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-Tuningทำตามคำแนะนำในแต่ละโฟลเดอร์

เราสนับสนุนงานหลายอย่างรวมถึง:

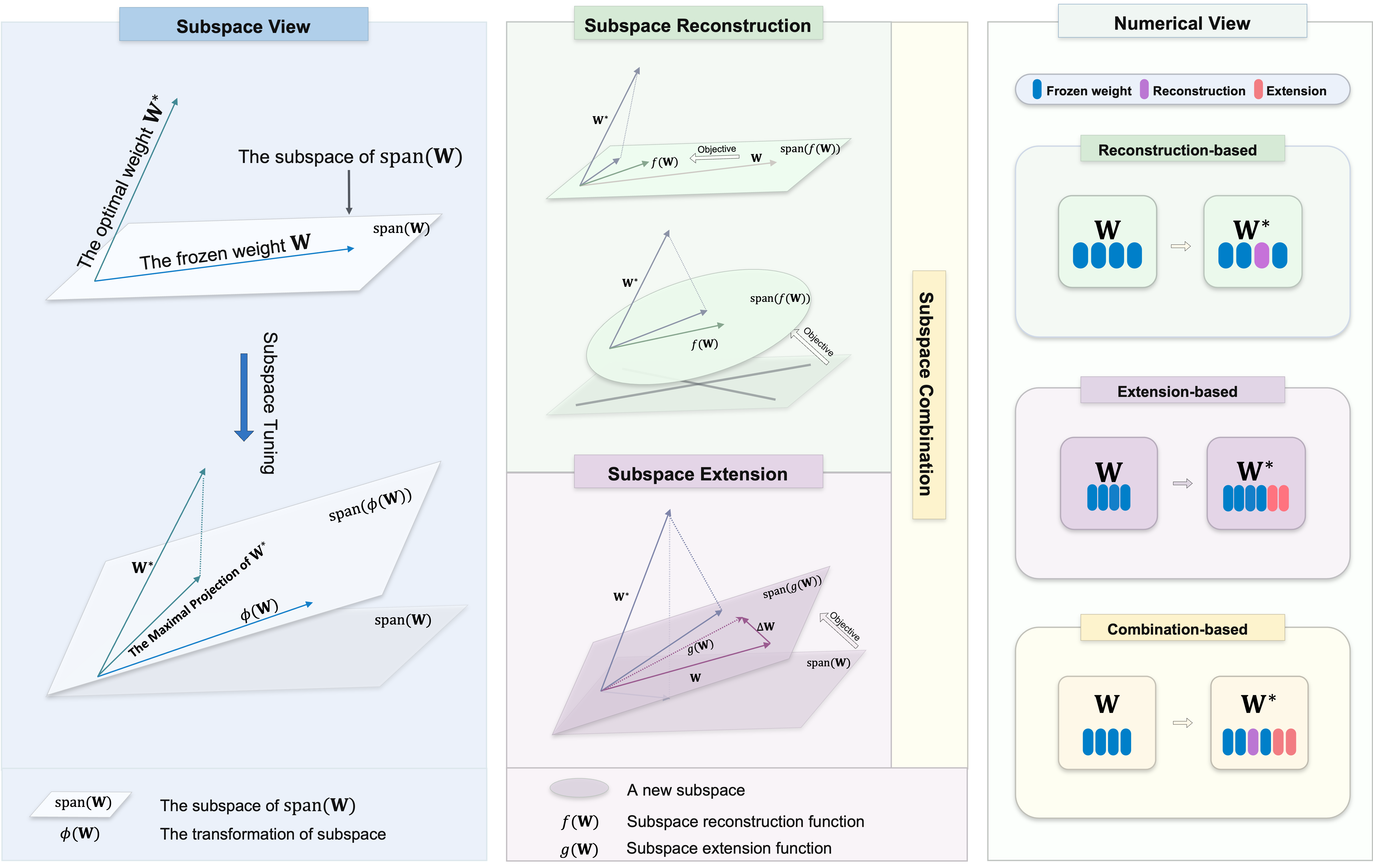

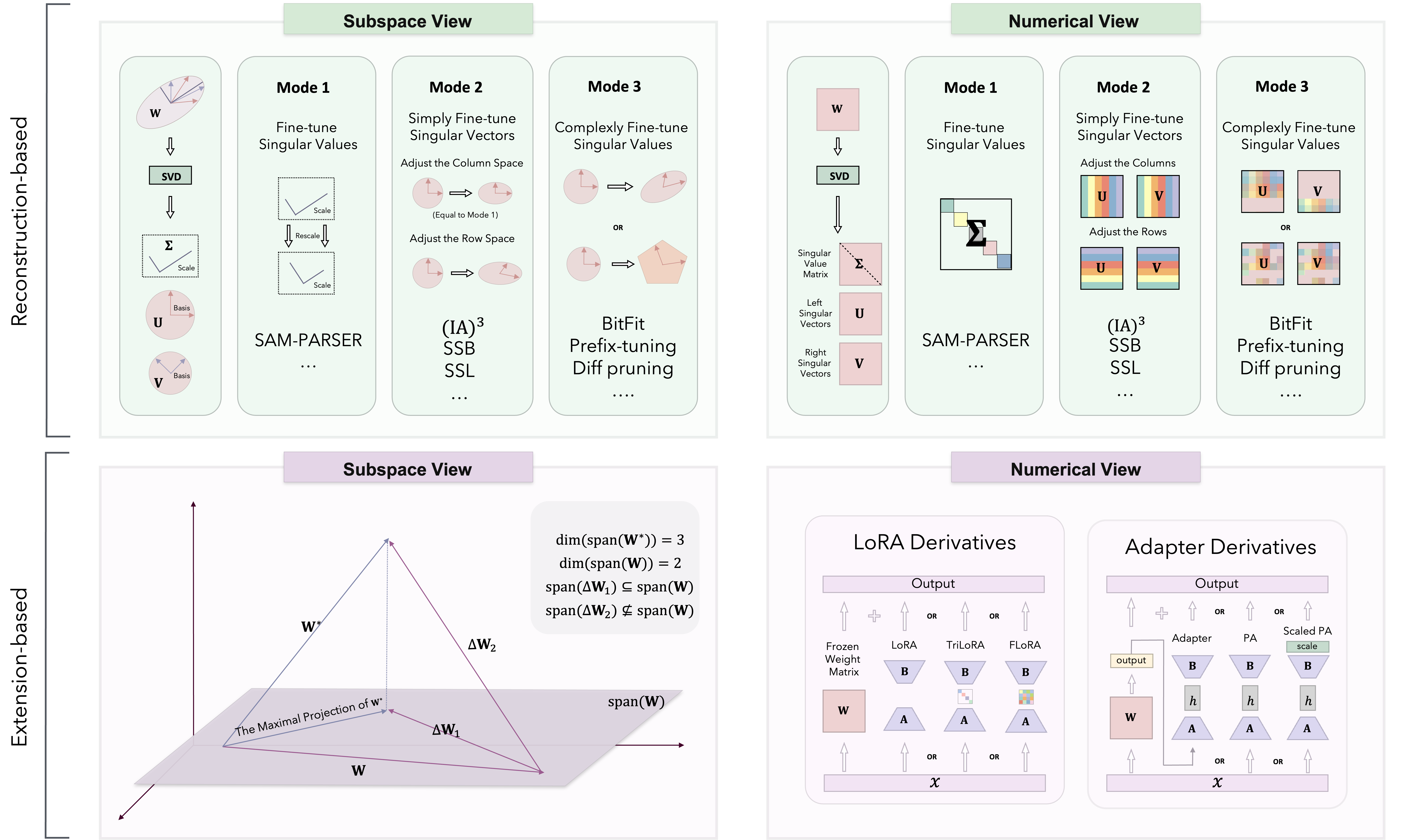

ตามทฤษฎีการปรับแต่ง subspace วิธีการ PEFT แบ่งออกเป็นสามประเภท: การสร้างใหม่ตามการขยายและการรวมกัน

เราใช้วิธีการที่แตกต่างกันเป็นหลักใน Loralib/

| หมวดหมู่ | อัลกอริทึม | รหัส | กระดาษ |

|---|---|---|---|

| การสร้างใหม่ | Sam-Parser | รหัส | 2024 AAAI |

| IA3 | รหัส | 2022 Neurips | |

| SSB | รหัส | 2024 arxiv | |

| SSL | รหัส | 2024 arxiv | |

| bitfit | N/A | 2022 ACL | |

| การปรับแต่งคำนำหน้า | รหัส | 2021 ACL | |

| การปรับแต่ง | รหัส | 2021 EMNLP | |

| การปรับแต่ง | รหัส | 2022 ACL | |

| พิสซ่า | รหัส | 2024 arxiv | |

| milora | รหัส | 2024 arxiv | |

| ส่วนขยาย | Lora | รหัส | 2022 ICLR |

| อาดิโรรา | รหัส | 2023 ICLR | |

| พืช | รหัส | 2024 arxiv | |

| โมเสก | รหัส | 2024 arxiv | |

| trilora | รหัส | 2024 arxiv | |

| อะแดปเตอร์ (Houlsby) | N/A | 2019 ICML | |

| อะแดปเตอร์ (pfeiffer) | N/A | 2021 ACL | |

| อะแดปเตอร์คู่ขนาน | รหัส | 2022 ICLR | |

| การผสมผสาน | ดอร่า | รหัส | 2024 ICML |

| svdiff | รหัส | 2023 ICCV | |

| อะแดปเตอร์สเปกตรัม | รหัส | 2024 arxiv | |

| Lora-Dash | รหัส | 2024 arxiv | |

| มีการเพิ่มอัลกอริทึมและการอัปเดตเพิ่มเติมอย่างต่อเนื่อง ... | N/A | N/A |

นอกจากนี้เรายังได้ทดสอบประสิทธิภาพของอัลกอริทึมบางอย่างในงาน NLU และ CR

เรายินดีต้อนรับการมีส่วนร่วมในที่เก็บนี้! ไม่ว่าคุณจะแก้ไขข้อบกพร่องเพิ่มคุณสมบัติใหม่หรือปรับปรุงเอกสารความช่วยเหลือของคุณจะได้รับการชื่นชม โปรดปฏิบัติตามแนวทางเพื่อให้แน่ใจว่ากระบวนการบริจาคที่ราบรื่น

ขอขอบคุณที่ให้ความสนใจกับที่เก็บรหัส PEFT ของเรา เรามุ่งมั่นที่จะทำให้นี่เป็นทรัพยากรที่มีค่าสำหรับโครงการและความพยายามในการวิจัยของคุณ

เป้าหมายของเราคือการส่งเสริมสภาพแวดล้อมการทำงานร่วมกันที่ทั้งคุณและนักวิจัยของเราสามารถแลกเปลี่ยนความคิดเห็นและร่วมมือกันได้ นอกเหนือจากการหารือเกี่ยวกับปัญหาที่เกี่ยวข้องกับรหัสแล้วเราขอแนะนำให้คุณแบ่งปันมุมมองของคุณเกี่ยวกับวิธีการ PEFT ใด ๆ และจัดการกับความท้าทายที่อาจเกิดขึ้นที่คุณพบ เรายินดีต้อนรับการอภิปรายที่อาจจุดประกายข้อมูลเชิงลึกและนวัตกรรมใหม่ ๆ

นอกจากนี้ที่เก็บรหัสนี้มีลักษณะส่วนตัวมากขึ้นซึ่งมีงานและอัลกอริทึมที่ฉันใช้ในระหว่างการทดลองของฉัน หากคุณมีอัลกอริทึมใด ๆ ที่คุณต้องการนำไปใช้หรือต้องการเพิ่มสถานการณ์งานเพิ่มเติมโปรดส่งอีเมลถึงฉัน คุณสามารถเยี่ยมชมหน้าแรกส่วนตัวของฉันสำหรับรายละเอียดเพิ่มเติม

หากคุณมีคำถามข้อเสนอแนะหรือข้อเสนอแนะใด ๆ โปรดติดต่อเราที่ [email protected]

หากคุณพบว่าพื้นที่เก็บข้อมูลนี้มีประโยชน์โปรดพิจารณาให้ดาวและอ้างถึงในงานของคุณ:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}ที่เก็บนี้ยังมีรหัสสำหรับโครงการอื่น ๆ ของเรา หากคุณพบว่าวิธีการเหล่านี้มีประโยชน์โปรดพิจารณาให้ดาวและอ้างถึงพวกเขาในงานของคุณ

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}ที่เก็บนี้ได้รับใบอนุญาตภายใต้ใบอนุญาต Apache 2.0 ดูไฟล์ใบอนุญาตสำหรับรายละเอียดเพิ่มเติม