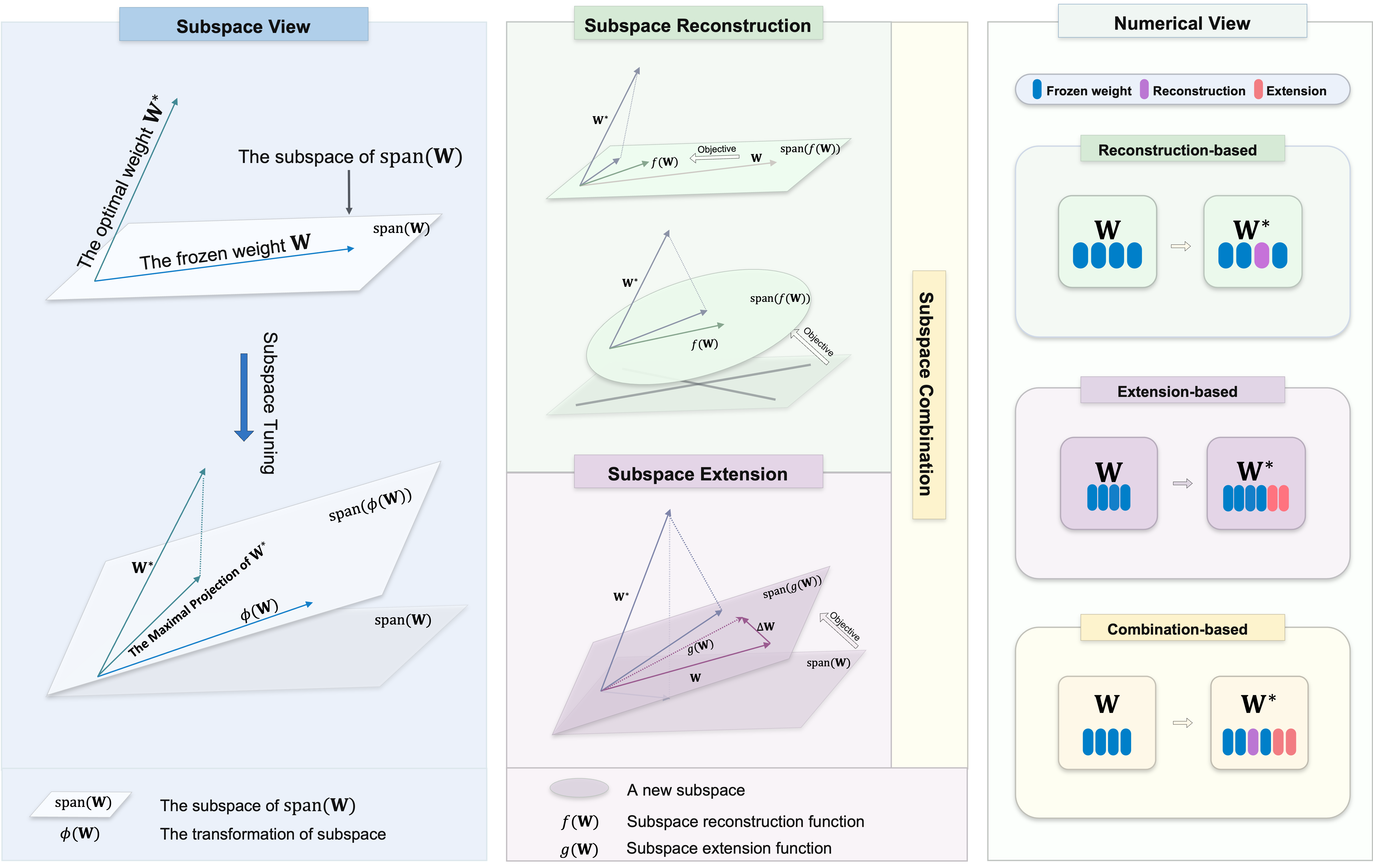

Selamat datang di repositori kami, yang berisi beragam kumpulan metode tuning subruang untuk fine-tuning parameter-efisien (PEFT). Tuning subruang sangat penting untuk mengadaptasi model pra-terlatih besar dengan tugas-tugas tertentu dengan perubahan minimal pada parameter asli. Itu berusaha untuk mengidentifikasi proyeksi maksimal dari berat optimal

Kami bertujuan untuk menyediakan sumber daya yang komprehensif bagi para peneliti dan praktisi di bidang ini, dan memfasilitasi integrasi yang mudah ke dalam proyek Anda. Apakah Anda di sini untuk menemukan sumber daya untuk proyek Anda atau berkontribusi, kami berharap repositori ini akan menjadi bagian yang berharga dan menginspirasi dari perjalanan penelitian Anda.

Repositori ini juga berisi beberapa proyek lain yang telah kami kerjakan, yang mungkin telah membawa Anda ke sini.

Untuk menggunakan algoritma dalam repositori ini, klon repositori dan instal dependensi yang diperlukan.

Klon Repositori ini:

git clone https://github.com/Chongjie-Si/Subspace-Tuning.git

cd Subspace-TuningIkuti instruksi di setiap folder.

Kami mendukung beberapa tugas termasuk:

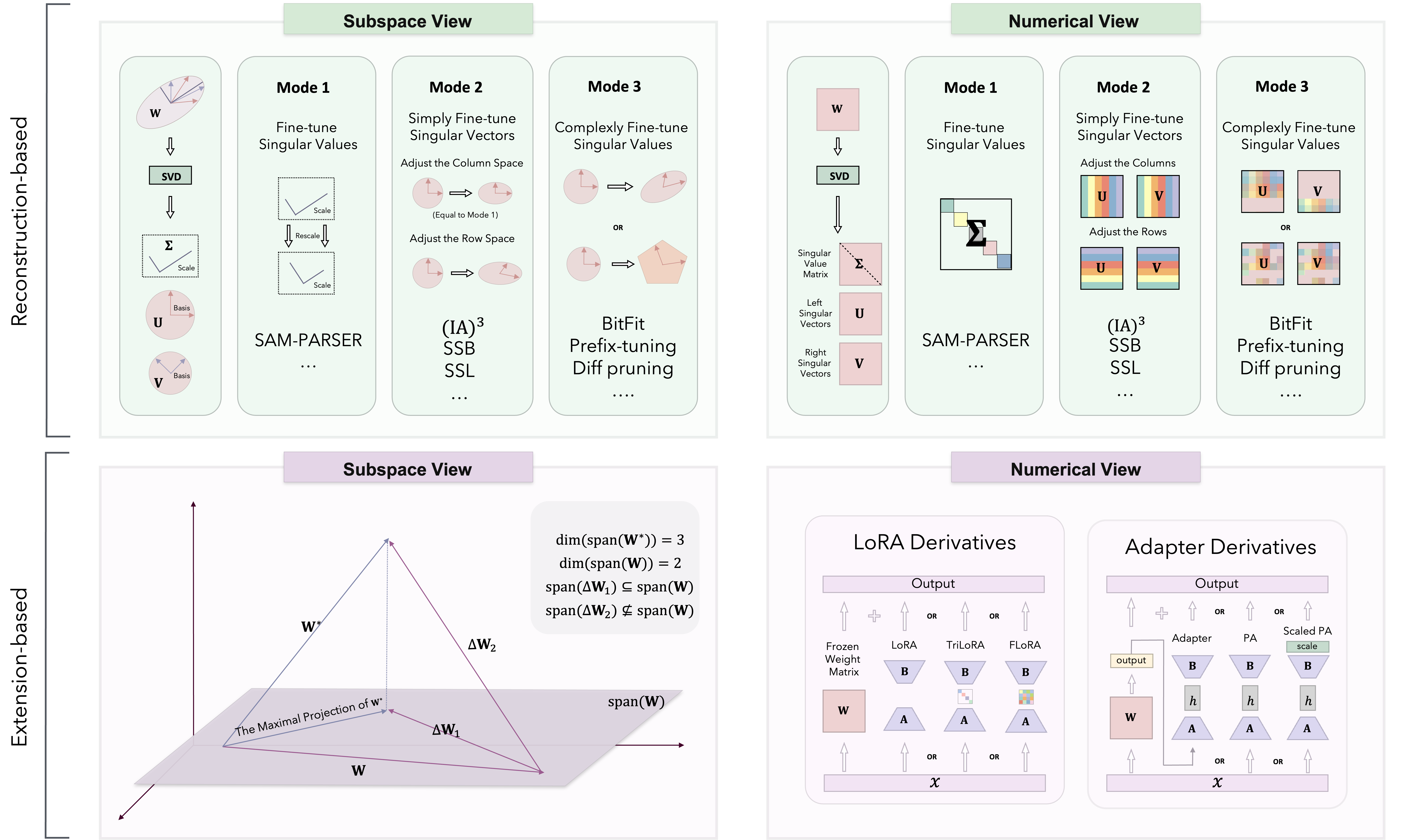

Berdasarkan teori tuning subruang, metode PEFT diklasifikasikan ke dalam tiga kategori: berbasis rekonstruksi, berbasis ekstensi dan berbasis kombinasi.

Kami mengimplementasikan berbagai metode terutama di Loralb/.

| Kategori | Algoritma | Kode | Kertas |

|---|---|---|---|

| Rekonstruksi | Sam-Parser | Kode | 2024 Aaai |

| Ia3 | Kode | 2022 Neurips | |

| SSB | Kode | 2024 Arxiv | |

| SSL | Kode | 2024 Arxiv | |

| Bitfit | N/a | 2022 ACL | |

| Awalan tuning | Kode | 2021 ACL | |

| Tuning cepat | Kode | 2021 EMNLP | |

| P-tuning | Kode | 2022 ACL | |

| Pissa | Kode | 2024 Arxiv | |

| Milora | Kode | 2024 Arxiv | |

| Perpanjangan | Lora | Kode | 2022 iclr |

| Adalora | Kode | 2023 iclr | |

| Flora | Kode | 2024 Arxiv | |

| Moslora | Kode | 2024 Arxiv | |

| Trilora | Kode | 2024 Arxiv | |

| Adaptor (Houlsby) | N/a | 2019 ICML | |

| Adaptor (pfeiffer) | N/a | 2021 ACL | |

| Adaptor paralel | Kode | 2022 iclr | |

| Kombinasi | Dora | Kode | 2024 ICML |

| Svdiff | Kode | 2023 ICCV | |

| Adaptor spektral | Kode | 2024 Arxiv | |

| Lora-dash | Kode | 2024 Arxiv | |

| Lebih banyak algoritma dan pembaruan ditambahkan secara terus -menerus ... | N/a | N/a |

Kami juga telah menguji kinerja beberapa algoritma pada tugas NLU dan CR.

Kami menyambut kontribusi untuk repositori ini! Apakah Anda memperbaiki bug, menambahkan fitur baru, atau meningkatkan dokumentasi, bantuan Anda dihargai. Harap ikuti pedoman untuk memastikan proses kontribusi yang lancar.

Terima kasih atas minat Anda pada repositori kode PEFT kami. Kami berusaha untuk menjadikan ini sumber yang berharga untuk proyek Anda dan usaha penelitian.

Tujuan kami adalah untuk menumbuhkan lingkungan kolaboratif di mana Anda dan peneliti kami dapat bertukar ide dan bekerja sama. Selain membahas masalah terkait kode, kami mendorong Anda untuk membagikan perspektif Anda tentang metodologi PEFT dan mengatasi setiap tantangan potensial yang Anda temui. Kami menyambut diskusi yang dapat memicu wawasan dan inovasi baru.

Selain itu, repositori kode ini bersifat lebih pribadi, berisi tugas dan algoritma yang saya gunakan selama percobaan saya. Jika Anda memiliki algoritma yang ingin Anda terapkan atau ingin menambahkan lebih banyak skenario tugas, jangan ragu untuk mengirim email kepada saya. Anda juga dapat mengunjungi beranda pribadi saya untuk lebih jelasnya.

Jika Anda memiliki pertanyaan, saran, atau umpan balik, jangan ragu untuk menghubungi kami di [email protected].

Jika Anda menemukan repositori ini bermanfaat, harap pertimbangkan untuk memberikannya bintang dan mengutipnya dalam pekerjaan Anda:

@article { si2024see ,

title = { See Further for Parameter Efficient Fine-tuning by Standing on the Shoulders of Decomposition } ,

author = { Si, Chongjie and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2407.05417 } ,

year = { 2024 }

}Repositori ini juga berisi kode untuk proyek kami yang lain. Jika Anda menemukan metode ini bermanfaat, harap pertimbangkan untuk memberikan bintang dan mengutipnya dalam pekerjaan Anda.

@article { si2024flora ,

title = { FLoRA: Low-Rank Core Space for N-dimension } ,

author = { Si, Chongjie* and Wang, Xuehui* and Yang, Xue and Xu, Zhengqin and Li, Qingyun and Dai, Jifeng and Qiao, Yu and Yang, Xiaokang and Shen, Wei } ,

journal = { arXiv preprint arXiv:2405.14739 } ,

year = { 2024 }

} @article { si2024unleashing ,

title = { Unleashing the Power of Task-Specific Directions in Parameter Efficient Fine-tuning } ,

author = { Si, Chongjie* and Shi, Zhiyi* and Zhang, Shifan and Yang, Xiaokang and Pfister, Hanspeter and Shen, Wei } ,

journal = { arXiv preprint arXiv:2409.01035 } ,

year = { 2024 }

}Repositori ini dilisensikan di bawah lisensi Apache 2.0. Lihat file lisensi untuk lebih jelasnya.