RAG based Intelligent Conversational AI Agent for Knowledge Extraction Using LangChain Gemini LLM

1.0.0

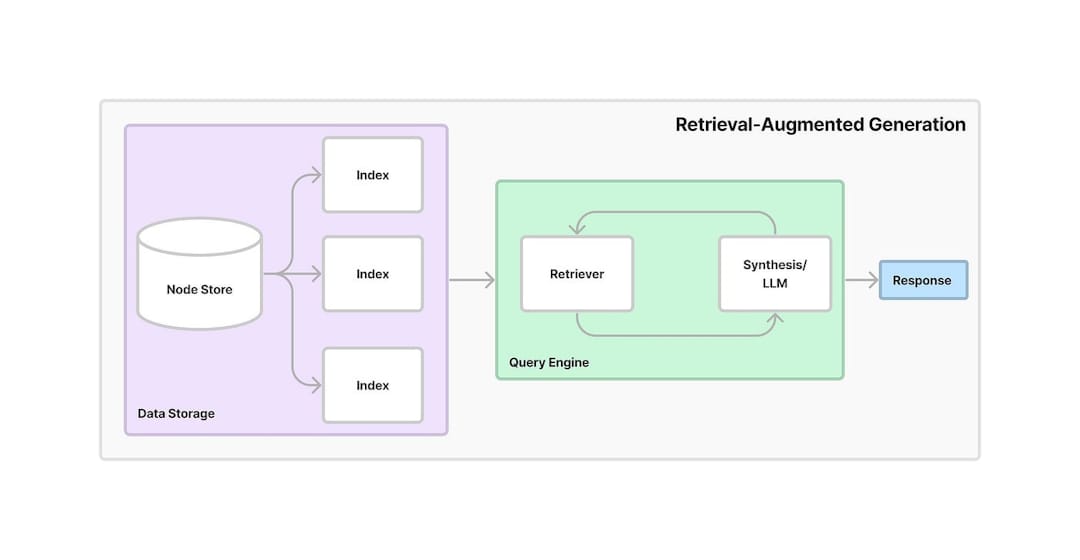

检索增强生成(RAG)是将信息检索与生成AI结合的框架。它允许模型从外部来源或数据库中检索相关信息,并使用该数据来生成更准确和上下文相关的响应。通过利用检索和发电,抹布提高了AI模型的准确性和可靠性,尤其是在提供最新信息或处理复杂问题时。

该项目提供了一个基于AI的对话助手,该助手利用检索功能的生成(RAG)从PDF文档中提取知识。该系统结合了文本嵌入,矢量搜索和LLM,以提供用户问题的答案。以下是应用程序运作方式的详细分步工作流程:

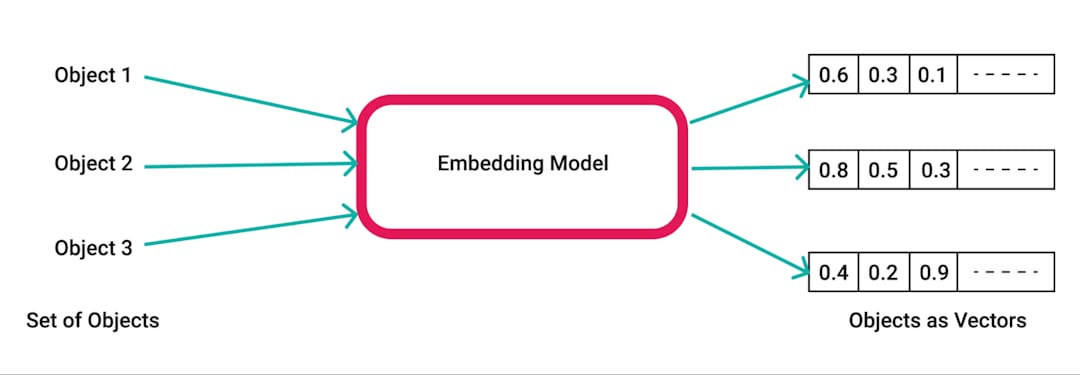

pdfplumber (用于从PDF提取文本的Python库)提取文本。pdfplumber库从上传的PDF提取原始文本。分析文档的每个页面,并准备结果文本以进行进一步处理。RecursiveCharacterTextSplitter分为较小的块。这样可以确保内容可用于嵌入和检索,通常具有500个字符的大小和50个字符的重叠。SpacyEmbeddings转换为数值嵌入。这些嵌入代表了块的语义含义,从而实现了有效的搜索。

Chroma库创建矢量数据库,该库存储在该库中。矢量数据库允许基于用户查询快速有效地检索相关信息。LangChain建立了ConversationalRetrievalChain RetRevalchain,将存储在Chroma中的嵌入与对话记忆缓冲区相结合以跟踪聊天历史记录和上下文。ChatGoogleGenerativeAI (Google的Gemini LLM),以基于从矢量商店检索到的文本块对用户问题产生相关和智能的回答。

有效的知识检索:通过利用抹布的力量,该系统将检索和生成结合起来,根据上传的PDF文档的内容准确回答特定问题。

可扩展性和灵活性:使用文本块和嵌入,该应用程序可以处理大型文档,同时确保快速,精确的信息检索。

会话AI :对话历史记录使系统更具交互性,因为它可以跟踪以前的问题和答案,从而在长时间的对话中保持上下文。

现代人工智能工具的集成:该项目展示了Chroma (例如Chroma用于矢量存储, LangChain进行对话管理)和Google的Gemini LLM的使用,用于生成类似人类的答案。