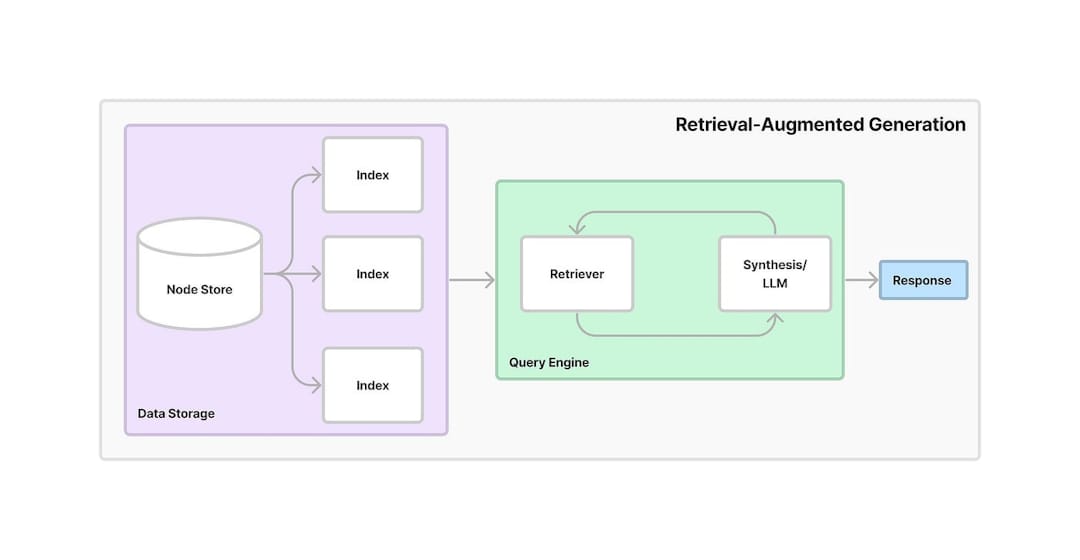

RELIEVAL-AUGmented-Generation (LAG) ist ein Rahmen, das das Abrufen von Informationsabläufen mit generativer KI kombiniert. Es ermöglicht Modellen, relevante Informationen aus externen Quellen oder Datenbanken abzurufen und diese Daten zu verwenden, um genauere und kontextbezogene Antworten zu generieren. Durch die Nutzung von Abruf und Generation verbessert Rag die Genauigkeit und Zuverlässigkeit von KI-Modellen, insbesondere bei der Bereitstellung aktueller Informationen oder der Bearbeitung komplexer Fragen.

Dieses Projekt bietet einen AI-basierten Konversationsassistenten, der die Abruf Generation (RAG) nutzt, um Wissen aus PDF-Dokumenten zu extrahieren. Das System kombiniert Texteinbettungen, Vektorsuche und LLM, um Antworten auf Benutzerfragen zu geben. Unten finden Sie einen detaillierten Schritt-für-Schritt-Workflow über die Funktionsweise der Anwendung:

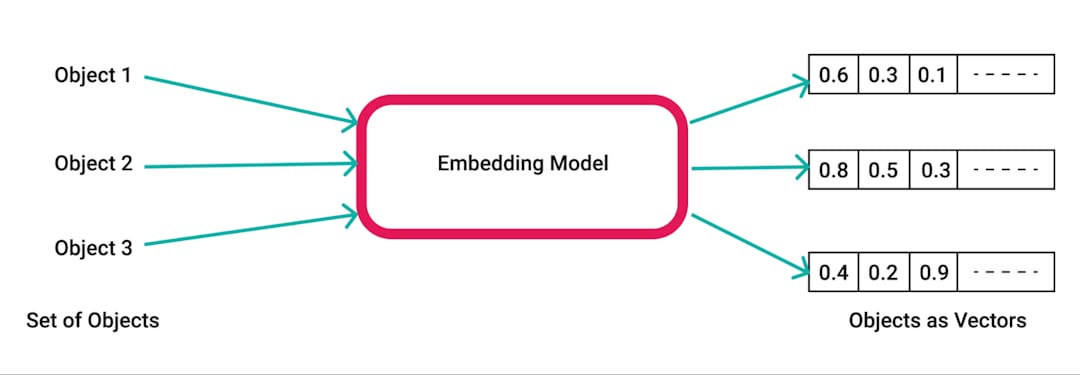

pdfplumber zu extrahieren, einer Python -Bibliothek zum Extrahieren von Text aus PDFs.pdfplumber -Bibliothek, um Rohtext aus dem hochgeladenen PDF zu extrahieren. Jede Seite des Dokuments ist analysiert und der resultierende Text wird für die weitere Verarbeitung erstellt.RecursiveCharacterTextSplitter in kleinere Stücke aufgeteilt. Dies stellt sicher, dass der Inhalt für Einbettungen und Abrufen überschaubar ist, typischerweise mit einer Stücke von 500 Zeichen und einer Überlappung von 50 Zeichen.SpacyEmbeddings in numerische Einbettungen umgewandelt. Diese Einbettungen repräsentieren die semantische Bedeutung der Stücke und ermöglichen eine effiziente Suche.

Chroma -Bibliothek erstellt, in der die Einbettungen gespeichert werden. Die Vektordatenbank ermöglicht das schnelle und effiziente Abrufen relevanter Informationen basierend auf Benutzeranfragen.ConversationalRetrievalChain wird mit LangChain etabliert und kombiniert die in Chroma gespeicherten Einbettungsdings mit einem Gesprächspuffer, um den Chat -Historie und -kontext zu verfolgen.ChatGoogleGenerativeAI (Google Gemini LLM), um relevante und intelligente Antworten auf die Fragen des Benutzers zu generieren, basierend auf den abgerufenen Textbrocken aus dem Vektorspeicher.

Effizientes Wissensabruf : Durch die Nutzung der Kraft des Lags kombiniert das System Abruf und Generation, um spezifische Fragen genau auf der Grundlage des Inhalts hochgeladener PDF -Dokumente zu beantworten.

Skalierbarkeit und Flexibilität : Mit Text -Chunking und Einbettungen kann die App große Dokumente verarbeiten und gleichzeitig ein schnelles und präzises Informationsabruf sicherstellen.

Konversations -KI : Das Gesprächsgeschichte wird das System interaktiver, da es frühere Fragen und Antworten im Auge behält und den Kontext über lange Gespräche aufrechterhält.

Integration moderner KI-Tools : Dieses Projekt zeigt die Verwendung fortschrittlicher Tools wie Chroma für Vektorspeicher, LangChain für das Konversationsmanagement und Gemini LLM von Google zur Generierung menschlicher Antworten.